En estadística , el coeficiente de determinación , denotado por R2 o r2 y pronunciado "R cuadrado", es la proporción de la variación en la variable dependiente que es predecible a partir de la ( s) variable(s) independiente(s).

Es una estadística utilizada en el contexto de modelos estadísticos cuyo propósito principal es la predicción de resultados futuros o la prueba de hipótesis , sobre la base de otra información relacionada. Proporciona una medida de qué tan bien los resultados observados son replicados por el modelo, en función de la proporción de variación total de los resultados explicados por el modelo. [1] [2] [3]

Existen varias definiciones de R 2 que sólo a veces son equivalentes. Una clase de tales casos incluye la regresión lineal simple donde se utiliza r 2 en lugar de R 2 . Cuando sólo se incluye una intersección , entonces r 2 es simplemente el cuadrado del coeficiente de correlación de muestra (es decir, r ) entre los resultados observados y los valores predictores observados. [4] Si se incluyen regresores adicionales , R 2 es el cuadrado del coeficiente de correlación múltiple . En ambos casos, el coeficiente de determinación normalmente varía de 0 a 1.

Existen casos en los que R 2 puede producir valores negativos. Esto puede ocurrir cuando las predicciones que se comparan con los resultados correspondientes no se han derivado de un procedimiento de ajuste de modelos que utilice esos datos. Incluso si se ha utilizado un procedimiento de ajuste de modelos, R 2 puede seguir siendo negativo, por ejemplo, cuando se realiza una regresión lineal sin incluir una intersección [5] o cuando se utiliza una función no lineal para ajustar los datos [6] . En los casos en los que surgen valores negativos, la media de los datos proporciona un mejor ajuste a los resultados que los valores de la función ajustada, según este criterio particular.

El coeficiente de determinación puede ser más intuitivamente informativo que MAE , MAPE , MSE y RMSE en la evaluación del análisis de regresión , ya que el primero se puede expresar como un porcentaje, mientras que las medidas del último tienen rangos arbitrarios. También demostró ser más robusto para ajustes deficientes en comparación con SMAPE en los conjuntos de datos de prueba del artículo. [7]

Al evaluar la bondad de ajuste de los valores simulados ( Y pred ) versus los medidos ( Y obs ), no es apropiado basarlo en el R 2 de la regresión lineal (es decir, Y obs = m · Y pred + b). [ cita requerida ] El R 2 cuantifica el grado de cualquier correlación lineal entre Y obs e Y pred , mientras que para la evaluación de bondad de ajuste solo se debe tomar en consideración una correlación lineal específica: Y obs = 1 · Y pred + 0 (es decir, la línea 1:1). [8] [9]

Un conjunto de datos tiene n valores marcados y 1 , ..., y n (conocidos colectivamente como y i o como un vector y = [ y 1 , ..., y n ] T ), cada uno asociado con un valor ajustado (o modelado, o predicho) f 1 , ..., f n (conocido como f i , o a veces ŷ i , como un vector f ).

Defina los residuos como e i = y i − f i (formando un vector e ).

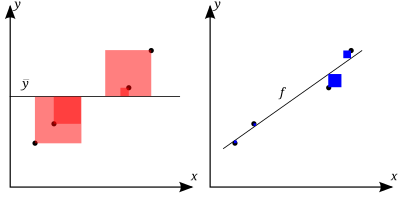

Si es la media de los datos observados: entonces la variabilidad del conjunto de datos se puede medir con dos fórmulas de suma de cuadrados :

La definición más general del coeficiente de determinación es

En el mejor de los casos, los valores modelados coinciden exactamente con los valores observados, lo que da como resultado y R 2 = 1. Un modelo de referencia, que siempre predice y , tendrá R 2 = 0 .

En una forma general, se puede ver que R 2 está relacionado con la fracción de varianza no explicada (FVU), ya que el segundo término compara la varianza no explicada (varianza de los errores del modelo) con la varianza total (de los datos):

Un valor mayor de R 2 implica un modelo de regresión más exitoso. [4] : 463 Supongamos que R 2 = 0,49 . Esto implica que se ha tenido en cuenta el 49% de la variabilidad de la variable dependiente en el conjunto de datos, y el 51% restante de la variabilidad aún no se ha tenido en cuenta. Para los modelos de regresión, la suma de cuadrados de la regresión, también llamada suma de cuadrados explicada , se define como

En algunos casos, como en la regresión lineal simple , la suma total de cuadrados es igual a la suma de las otras dos sumas de cuadrados definidas anteriormente:

Consulte Particiones en el modelo MCO general para obtener una derivación de este resultado para un caso en el que se cumple la relación. Cuando esta relación se cumple, la definición anterior de R 2 es equivalente a

donde n es el número de observaciones (casos) sobre las variables.

En esta forma, R 2 se expresa como la relación entre la varianza explicada (varianza de las predicciones del modelo, que es SS reg / n ) y la varianza total (varianza muestral de la variable dependiente, que es SS tot / n ).

Esta partición de la suma de cuadrados se cumple, por ejemplo, cuando los valores del modelo ƒ i se han obtenido mediante regresión lineal . Una condición suficiente más suave se lee como sigue: El modelo tiene la forma

donde q i son valores arbitrarios que pueden o no depender de i o de otros parámetros libres (la opción común q i = x i es sólo un caso especial), y las estimaciones de los coeficientes y se obtienen minimizando la suma residual de los cuadrados.

Este conjunto de condiciones es importante y tiene varias implicaciones para las propiedades de los residuos ajustados y los valores modelados. En particular, en estas condiciones:

En la regresión múltiple de mínimos cuadrados lineal (con intersección y pendiente ajustadas), R 2 es igual al cuadrado del coeficiente de correlación de Pearson entre los valores de datos observados y modelados (predichos) de la variable dependiente.

En una regresión lineal de mínimos cuadrados con un solo explicador (con intersección y pendiente ajustadas), esto también es igual al cuadrado del coeficiente de correlación de Pearson entre la variable dependiente y la variable explicativa .

No debe confundirse con el coeficiente de correlación entre dos variables explicativas , definido como

donde la covarianza entre dos estimaciones de coeficientes, así como sus desviaciones estándar , se obtienen de la matriz de covarianza de las estimaciones de coeficientes, .

En condiciones de modelado más generales, donde los valores predichos pueden generarse a partir de un modelo diferente de la regresión lineal de mínimos cuadrados, un valor R 2 puede calcularse como el cuadrado del coeficiente de correlación entre los valores de datos originales y modelados . En este caso, el valor no es directamente una medida de cuán buenos son los valores modelados, sino más bien una medida de cuán bueno puede construirse un predictor a partir de los valores modelados (mediante la creación de un predictor revisado de la forma α + βƒ i ). [ cita requerida ] Según Everitt, [10] este uso es específicamente la definición del término "coeficiente de determinación": el cuadrado de la correlación entre dos variables (generales).

R 2 es una medida de la bondad de ajuste de un modelo. [11] En regresión, el coeficiente de determinación R 2 es una medida estadística de qué tan bien las predicciones de regresión se aproximan a los puntos de datos reales. Un R 2 de 1 indica que las predicciones de regresión se ajustan perfectamente a los datos.

Los valores de R 2 fuera del rango de 0 a 1 se producen cuando el modelo se ajusta a los datos peor que el peor predictor de mínimos cuadrados posible (equivalente a un hiperplano horizontal a una altura igual a la media de los datos observados). Esto ocurre cuando se eligió un modelo incorrecto o se aplicaron restricciones sin sentido por error. Si se utiliza la ecuación 1 de Kvålseth [12] (esta es la ecuación que se utiliza con más frecuencia), R 2 puede ser menor que cero. Si se utiliza la ecuación 2 de Kvålseth, R 2 puede ser mayor que uno.

En todos los casos en los que se utiliza R 2 , los predictores se calculan mediante regresión de mínimos cuadrados ordinarios: es decir, minimizando SS res . En este caso, R 2 aumenta a medida que aumenta el número de variables en el modelo ( R 2 es monótonamente creciente con el número de variables incluidas, nunca disminuirá). Esto ilustra un inconveniente de un posible uso de R 2 , donde uno podría seguir añadiendo variables ( regresión del fregadero de la cocina ) para aumentar el valor de R 2 . Por ejemplo, si uno está tratando de predecir las ventas de un modelo de automóvil a partir del consumo de gasolina, el precio y la potencia del motor del automóvil, puede incluir factores probablemente irrelevantes como la primera letra del nombre del modelo o la altura del ingeniero principal que diseña el automóvil porque R 2 nunca disminuirá a medida que se agregan variables y probablemente experimentará un aumento debido solo al azar.

Esto nos lleva al enfoque alternativo de observar el R2 ajustado. La explicación de esta estadística es casi la misma que la del R2 , pero penaliza la estadística ya que se incluyen variables adicionales en el modelo. Para casos distintos del ajuste por mínimos cuadrados ordinarios, la estadística R2 se puede calcular como se indicó anteriormente y aún puede ser una medida útil. Si el ajuste se realiza por mínimos cuadrados ponderados o mínimos cuadrados generalizados , se pueden calcular versiones alternativas de R2 adecuadas para esos marcos estadísticos, mientras que el R2 "bruto" puede seguir siendo útil si se interpreta más fácilmente. Los valores de R2 se pueden calcular para cualquier tipo de modelo predictivo, que no necesita tener una base estadística.

Considérese un modelo lineal con más de una variable explicativa , de la forma

donde, para el i ésimo caso, es la variable de respuesta, son p regresores y es un término de error medio cero. Las cantidades son coeficientes desconocidos, cuyos valores se estiman por mínimos cuadrados . El coeficiente de determinación R 2 es una medida del ajuste global del modelo. Específicamente, R 2 es un elemento de [0, 1] y representa la proporción de variabilidad en Y i que puede atribuirse a alguna combinación lineal de los regresores ( variables explicativas ) en X . [13]

R 2 se interpreta a menudo como la proporción de variación de respuesta "explicada" por los regresores en el modelo. Por lo tanto, R 2 = 1 indica que el modelo ajustado explica toda la variabilidad en , mientras que R 2 = 0 indica que no hay una relación "lineal" (para la regresión lineal, esto significa que el modelo lineal es una línea constante (pendiente = 0, intersección = ) entre la variable de respuesta y los regresores). Un valor interior como R 2 = 0,7 puede interpretarse de la siguiente manera: "El setenta por ciento de la varianza en la variable de respuesta puede explicarse por las variables explicativas. El treinta por ciento restante puede atribuirse a variables desconocidas, latentes o variabilidad inherente".

Una advertencia que se aplica a R 2 , al igual que a otras descripciones estadísticas de correlación y asociación, es que " la correlación no implica causalidad ". En otras palabras, si bien las correlaciones a veces pueden proporcionar pistas valiosas para descubrir relaciones causales entre variables, una correlación estimada distinta de cero entre dos variables no es, por sí sola, evidencia de que cambiar el valor de una variable daría como resultado cambios en los valores de otras variables. Por ejemplo, la práctica de llevar cerillas (o un encendedor) está correlacionada con la incidencia de cáncer de pulmón, pero llevar cerillas no causa cáncer (en el sentido estándar de "causa").

En el caso de un solo regresor, ajustado por mínimos cuadrados, R 2 es el cuadrado del coeficiente de correlación producto-momento de Pearson que relaciona el regresor y la variable de respuesta. De manera más general, R 2 es el cuadrado de la correlación entre el predictor construido y la variable de respuesta. Con más de un regresor, el R 2 puede denominarse coeficiente de determinación múltiple .

En la regresión de mínimos cuadrados que utiliza datos típicos, R 2 aumenta al menos débilmente con un aumento en el número de regresores en el modelo. Debido a que los aumentos en el número de regresores aumentan el valor de R 2 , R 2 por sí solo no puede usarse como una comparación significativa de modelos con números muy diferentes de variables independientes. Para una comparación significativa entre dos modelos, se puede realizar una prueba F en la suma residual de cuadrados [ cita requerida ] , similar a las pruebas F en la causalidad de Granger , aunque esto no siempre es apropiado [ se necesita más explicación ] . Como recordatorio de esto, algunos autores denotan R 2 por R q 2 , donde q es el número de columnas en X (el número de explicadores incluyendo la constante).

Para demostrar esta propiedad, primero recordemos que el objetivo de la regresión lineal de mínimos cuadrados es

donde X i es un vector fila de valores de variables explicativas para el caso i y b es un vector columna de coeficientes de los respectivos elementos de X i .

El valor óptimo del objetivo es débilmente menor a medida que se añaden más variables explicativas y, por lo tanto, se añaden columnas adicionales de (la matriz de datos explicativos cuya fila i es Xi ) , por el hecho de que una minimización menos restringida conduce a un coste óptimo que es débilmente menor que una minimización más restringida. Dada la conclusión anterior y observando que depende solo de y , la propiedad no decreciente de R 2 se desprende directamente de la definición anterior.

La razón intuitiva por la que el uso de una variable explicativa adicional no puede reducir el R 2 es la siguiente: minimizar es equivalente a maximizar el R 2 . Cuando se incluye la variable adicional, los datos siempre tienen la opción de darle un coeficiente estimado de cero, dejando los valores predichos y el R 2 sin cambios. La única forma en que el problema de optimización dará un coeficiente distinto de cero es si al hacerlo se mejora el R 2 .

Lo anterior ofrece una explicación analítica de la inflación de R 2 . A continuación, se muestra un ejemplo basado en el método de mínimos cuadrados ordinarios desde una perspectiva geométrica. [14]

Consideremos primero un caso sencillo:

Esta ecuación describe el modelo de regresión de mínimos cuadrados ordinarios con un regresor. La predicción se muestra como el vector rojo en la figura de la derecha. Geométricamente, es la proyección del valor verdadero sobre un espacio del modelo en (sin intersección). El residuo se muestra como la línea roja.

Esta ecuación corresponde al modelo de regresión de mínimos cuadrados ordinarios con dos regresores. La predicción se muestra como el vector azul en la figura de la derecha. Geométricamente, es la proyección del valor verdadero sobre un espacio de modelo más grande en (sin intersección). Cabe destacar que los valores de y no son los mismos que en la ecuación para un espacio de modelo más pequeño siempre que y no sean vectores cero. Por lo tanto, se espera que las ecuaciones produzcan predicciones diferentes (es decir, se espera que el vector azul sea diferente del vector rojo). El criterio de regresión de mínimos cuadrados garantiza que se minimice el residuo. En la figura, la línea azul que representa el residuo es ortogonal al espacio de modelo en , lo que da la distancia mínima desde el espacio.

El espacio del modelo más pequeño es un subespacio del más grande y, por lo tanto, se garantiza que el residuo del modelo más pequeño será mayor. Comparando las líneas roja y azul en la figura, la línea azul es ortogonal al espacio y cualquier otra línea sería mayor que la azul. Teniendo en cuenta el cálculo para R 2 , un valor menor de conducirá a un valor mayor de R 2 , lo que significa que agregar regresores dará como resultado una inflación de R 2 .

R 2 no indica si:

El uso de un R 2 ajustado (una notación común es , pronunciado "R barra al cuadrado"; otra es o ) es un intento de explicar el fenómeno del aumento automático del R 2 cuando se añaden variables explicativas adicionales al modelo. Hay muchas formas diferentes de realizar el ajuste. [15] La más utilizada, hasta el punto de que normalmente se la denomina simplemente R 2 ajustado , es la corrección propuesta por Mordecai Ezekiel . [15] [16] [17] El R 2 ajustado se define como

donde df res son los grados de libertad de la estimación de la varianza poblacional alrededor del modelo, y df tot son los grados de libertad de la estimación de la varianza poblacional alrededor de la media. df res se da en términos del tamaño de la muestra n y el número de variables p en el modelo, df res = n − p − 1 . df tot se da de la misma manera, pero con p siendo la unidad para la media, es decir, df tot = n − 1 .

Insertando los grados de libertad y utilizando la definición de R 2 , se puede reescribir como:

donde p es el número total de variables explicativas en el modelo (excluyendo la intersección) y n es el tamaño de la muestra.

El R 2 ajustado puede ser negativo y su valor siempre será menor o igual que el de R 2 . A diferencia de R 2 , el R 2 ajustado aumenta solo cuando el aumento de R 2 (debido a la inclusión de una nueva variable explicativa) es mayor que el que se esperaría ver por casualidad. Si se introduce un conjunto de variables explicativas con una jerarquía de importancia predeterminada en una regresión una a la vez, y se calcula el R 2 ajustado cada vez, el nivel en el que el R 2 ajustado alcanza un máximo y luego disminuye, sería la regresión con la combinación ideal de tener el mejor ajuste sin términos excesivos o innecesarios.

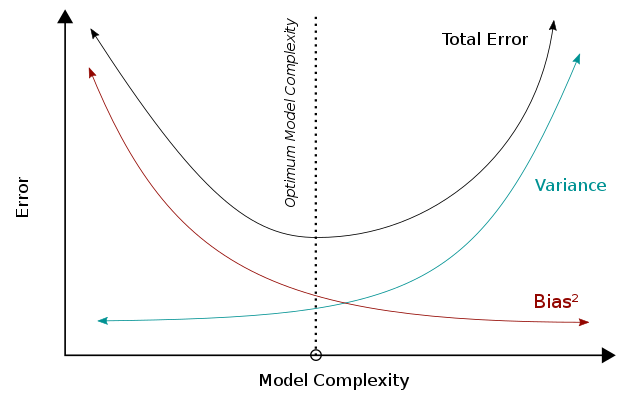

El R 2 ajustado se puede interpretar como una instancia del equilibrio entre sesgo y varianza . Cuando consideramos el desempeño de un modelo, un error menor representa un mejor desempeño. Cuando el modelo se vuelve más complejo, la varianza aumentará mientras que el cuadrado del sesgo disminuirá, y estas dos métricas se suman para formar el error total. Combinando estas dos tendencias, el equilibrio entre sesgo y varianza describe una relación entre el desempeño del modelo y su complejidad, que se muestra como una curva en forma de U a la derecha. Para el R 2 ajustado específicamente, la complejidad del modelo (es decir, el número de parámetros) afecta al R 2 y al término / frac y, por lo tanto, captura sus atributos en el desempeño general del modelo.

R 2 se puede interpretar como la varianza del modelo, que está influenciada por la complejidad del modelo. Un R 2 alto indica un error de sesgo menor porque el modelo puede explicar mejor el cambio de Y con predictores. Por esta razón, hacemos menos suposiciones (erróneas), y esto resulta en un error de sesgo menor. Mientras tanto, para dar cabida a menos suposiciones, el modelo tiende a ser más complejo. Con base en el equilibrio entre sesgo y varianza, una mayor complejidad conducirá a una disminución del sesgo y un mejor rendimiento (por debajo de la línea óptima). En R 2 , el término ( 1 − R 2 ) será menor con una alta complejidad y dará como resultado un R 2 mayor , lo que indica consistentemente un mejor rendimiento.

Por otro lado, el término/frac término se ve afectado de manera inversa por la complejidad del modelo. El término/frac término aumentará al agregar regresores (es decir, aumentará la complejidad del modelo) y conducirá a un peor desempeño. Según el equilibrio entre sesgo y varianza, una mayor complejidad del modelo (más allá de la línea óptima) conduce a un aumento de errores y a un peor desempeño.

Teniendo en cuenta el cálculo de R 2 , más parámetros aumentarán el R 2 y conducirán a un aumento en R 2 . Sin embargo, agregar más parámetros aumentará el término/frac y, por lo tanto, disminuirá R 2 . Estas dos tendencias construyen una relación en forma de U inversa entre la complejidad del modelo y R 2 , que es consistente con la tendencia en forma de U de la complejidad del modelo versus el rendimiento general. A diferencia de R 2 , que siempre aumentará cuando aumenta la complejidad del modelo, R 2 aumentará solo cuando el sesgo eliminado por el regresor agregado sea mayor que la varianza introducida simultáneamente. El uso de R 2 en lugar de R 2 podría evitar el sobreajuste.

Siguiendo la misma lógica, el R 2 ajustado puede interpretarse como un estimador menos sesgado del R 2 de la población , mientras que el R 2 de la muestra observada es una estimación positivamente sesgada del valor de la población. [18] El R 2 ajustado es más apropiado cuando se evalúa el ajuste del modelo (la varianza en la variable dependiente explicada por las variables independientes) y al comparar modelos alternativos en la etapa de selección de características de la construcción del modelo. [18]

El principio detrás de la estadística R 2 ajustada se puede ver reescribiendo el R 2 ordinario como

donde y son las varianzas muestrales de los residuos estimados y de la variable dependiente respectivamente, que pueden considerarse estimaciones sesgadas de las varianzas poblacionales de los errores y de la variable dependiente. Estas estimaciones se reemplazan por versiones estadísticamente no sesgadas : y .

A pesar de utilizar estimadores insesgados para las varianzas poblacionales del error y la variable dependiente, el R 2 ajustado no es un estimador insesgado del R 2 poblacional , [18] lo que resulta de utilizar las varianzas poblacionales de los errores y la variable dependiente en lugar de estimarlas. Ingram Olkin y John W. Pratt derivaron el estimador insesgado de varianza mínima para el R 2 poblacional , [19] que se conoce como estimador de Olkin-Pratt. Las comparaciones de diferentes enfoques para ajustar el R 2 concluyeron que en la mayoría de las situaciones se debería preferir una versión aproximada del estimador de Olkin-Pratt [18] o el estimador exacto de Olkin-Pratt [20] sobre el R 2 ajustado (Ezequiel) .

El coeficiente de determinación parcial se puede definir como la proporción de variación que no se puede explicar en un modelo reducido, pero que se puede explicar mediante los predictores especificados en un modelo más completo. [21] [22] [23] Este coeficiente se utiliza para proporcionar información sobre si uno o más predictores adicionales pueden ser útiles en un modelo de regresión más completamente especificado.

El cálculo del R 2 parcial es relativamente sencillo después de estimar dos modelos y generar las tablas ANOVA para ellos. El cálculo del R 2 parcial es

que es análogo al coeficiente de determinación habitual:

Como se explicó anteriormente, las heurísticas de selección de modelos, como el criterio R 2 ajustado y la prueba F, examinan si el R 2 total aumenta lo suficiente para determinar si se debe agregar un nuevo regresor al modelo. Si se agrega un regresor al modelo que está altamente correlacionado con otros regresores que ya se han incluido, entonces el R 2 total apenas aumentará, incluso si el nuevo regresor es relevante. Como resultado, las heurísticas mencionadas anteriormente ignorarán los regresores relevantes cuando las correlaciones cruzadas sean altas. [24]

Alternativamente, se puede descomponer una versión generalizada de R 2 para cuantificar la relevancia de desviarse de una hipótesis. [24] Como muestra Hoornweg (2018), varios estimadores de contracción , como la regresión lineal bayesiana , la regresión de cresta y el lazo (adaptativo) , hacen uso de esta descomposición de R 2 cuando reducen gradualmente los parámetros de las soluciones MCO sin restricciones hacia los valores hipotéticos. Definamos primero el modelo de regresión lineal como

Se supone que la matriz X está estandarizada con puntuaciones Z y que el vector columna está centrado para tener una media de cero. Supongamos que el vector columna hace referencia a los parámetros de regresión hipotéticos y que el vector columna denota los parámetros estimados. Podemos entonces definir

Un R 2 del 75 % significa que la precisión en la muestra mejora en un 75 % si se utilizan las soluciones b optimizadas para los datos en lugar de los valores hipotéticos. En el caso especial de que se trate de un vector de ceros, obtenemos nuevamente el R 2 tradicional .

El efecto individual sobre R 2 de desviarse de una hipótesis se puede calcular con ('R-outer'). Esta matriz de tiempos está dada por

donde . Los elementos diagonales de suman exactamente R 2 . Si los regresores no están correlacionados y es un vector de ceros, entonces el elemento diagonal de simplemente corresponde al valor r 2 entre y . Cuando los regresores y están correlacionados, podría aumentar a costa de una disminución en . Como resultado, los elementos diagonales de pueden ser menores que 0 y, en casos más excepcionales, mayores que 1. Para lidiar con tales incertidumbres, varios estimadores de contracción toman implícitamente un promedio ponderado de los elementos diagonales de para cuantificar la relevancia de desviarse de un valor hipotético. [24] Haga clic en el lazo para ver un ejemplo.

En el caso de la regresión logística , generalmente ajustada por máxima verosimilitud , existen varias opciones de pseudo- R 2 .

Una es la R 2 generalizada propuesta originalmente por Cox y Snell, [25] e independientemente por Magee: [26]

donde es la probabilidad del modelo con solo la intersección, es la probabilidad del modelo estimado (es decir, el modelo con un conjunto dado de estimaciones de parámetros) y n es el tamaño de la muestra. Se puede reescribir fácilmente como:

donde D es la estadística de prueba de la prueba de razón de verosimilitud .

Nico Nagelkerke señaló que tenía las siguientes propiedades: [27] [22]

Sin embargo, en el caso de un modelo logístico, donde no puede ser mayor que 1, R 2 está entre 0 y : por lo tanto, Nagelkerke sugirió la posibilidad de definir un R 2 escalado como R 2 / R 2 máx . [22]

Ocasionalmente, se utiliza la norma de los residuos para indicar la bondad del ajuste. Este término se calcula como la raíz cuadrada de la suma de los cuadrados de los residuos :

Tanto R 2 como la norma de los residuos tienen sus méritos relativos. Para el análisis de mínimos cuadrados, R 2 varía entre 0 y 1, donde los números más grandes indican mejores ajustes y 1 representa un ajuste perfecto. La norma de los residuos varía de 0 a infinito, donde los números más pequeños indican mejores ajustes y cero indica un ajuste perfecto. Una ventaja y desventaja de R 2 es que el término actúa para normalizar el valor. Si todos los valores y i se multiplican por una constante, la norma de los residuos también cambiará por esa constante, pero R 2 permanecerá igual. Como ejemplo básico, para el ajuste de mínimos cuadrados lineal al conjunto de datos:

R 2 = 0,998 y la norma de los residuos = 0,302. Si todos los valores de y se multiplican por 1000 (por ejemplo, en un cambio de prefijo del SI ), entonces R 2 permanece igual, pero la norma de los residuos = 302.

Otro indicador de ajuste de un solo parámetro es el RMSE de los residuos, o la desviación estándar de los residuos. Este tendría un valor de 0,135 para el ejemplo anterior, dado que el ajuste fue lineal con una intersección no forzada. [28]

La creación del coeficiente de determinación se ha atribuido al genetista Sewall Wright y se publicó por primera vez en 1921. [29]