El análisis de varianza ( ANOVA ) es una colección de modelos estadísticos y sus procedimientos de estimación asociados (como la "variación" entre grupos) que se utilizan para analizar las diferencias entre medias. El ANOVA fue desarrollado por el estadístico Ronald Fisher . El ANOVA se basa en la ley de varianza total , donde la varianza observada en una variable particular se divide en componentes atribuibles a diferentes fuentes de variación. En su forma más simple, el ANOVA proporciona una prueba estadística de si dos o más medias de población son iguales y, por lo tanto, generaliza la prueba t más allá de dos medias. En otras palabras, el ANOVA se utiliza para probar la diferencia entre dos o más medias.

Aunque el análisis de varianza alcanzó su fructificación en el siglo XX, los antecedentes se remontan a siglos atrás según Stigler . [1] Estos incluyen pruebas de hipótesis, la partición de sumas de cuadrados, técnicas experimentales y el modelo aditivo. Laplace estaba realizando pruebas de hipótesis en la década de 1770. [2] Alrededor de 1800, Laplace y Gauss desarrollaron el método de mínimos cuadrados para combinar observaciones, que mejoró los métodos utilizados entonces en astronomía y geodesia . También inició muchos estudios sobre las contribuciones a las sumas de cuadrados. Laplace sabía cómo estimar una varianza a partir de una suma residual (en lugar de una total) de cuadrados. [3] En 1827, Laplace estaba utilizando métodos de mínimos cuadrados para abordar problemas de ANOVA relacionados con las mediciones de mareas atmosféricas. [4] Antes de 1800, los astrónomos habían aislado errores de observación resultantes de los tiempos de reacción (la " ecuación personal ") y habían desarrollado métodos para reducir los errores. [5] Los métodos experimentales utilizados en el estudio de la ecuación personal fueron aceptados posteriormente por el campo emergente de la psicología [6], que desarrolló métodos experimentales fuertes (factoriales completos) a los que pronto se añadieron la aleatorización y el cegamiento. [7] Una elocuente explicación no matemática del modelo de efectos aditivos estaba disponible en 1885. [8]

Ronald Fisher introdujo el término varianza y propuso su análisis formal en un artículo de 1918 sobre genética de poblaciones teórica, The Correlation Between Relatives on the Supposition of Mendelian Inheritance . [9] Su primera aplicación del análisis de varianza al análisis de datos se publicó en 1921, Studies in Crop Variation I. [ 10] Este dividió la variación de una serie temporal en componentes que representan causas anuales y deterioro lento. El siguiente artículo de Fisher, Studies in Crop Variation II , escrito con Winifred Mackenzie y publicado en 1923, estudió la variación en el rendimiento en parcelas sembradas con diferentes variedades y sometidas a diferentes tratamientos de fertilizantes. [11] El análisis de varianza se hizo ampliamente conocido después de ser incluido en el libro de Fisher de 1925 Statistical Methods for Research Workers .

Varios investigadores desarrollaron modelos de aleatorización. El primero fue publicado en polaco por Jerzy Neyman en 1923. [12]

El análisis de varianza se puede utilizar para describir relaciones complejas entre variables. Una exposición canina es un ejemplo. Una exposición canina no es un muestreo aleatorio de la raza: normalmente se limita a perros adultos, de raza pura y ejemplares. Es probable que un histograma de pesos de perros de una exposición sea bastante complicado, como la distribución amarillo-naranja que se muestra en las ilustraciones. Supongamos que quisiéramos predecir el peso de un perro en función de un determinado conjunto de características de cada perro. Una forma de hacerlo es explicar la distribución de pesos dividiendo la población de perros en grupos en función de esas características. Una agrupación exitosa dividirá a los perros de tal manera que (a) cada grupo tenga una varianza baja de pesos de perros (lo que significa que el grupo es relativamente homogéneo) y (b) la media de cada grupo sea distinta (si dos grupos tienen la misma media, entonces no es razonable concluir que los grupos están, de hecho, separados de alguna manera significativa).

En las ilustraciones de la derecha, los grupos se identifican como X 1 , X 2 , etc. En la primera ilustración, los perros se dividen según el producto (interacción) de dos agrupaciones binarias: jóvenes vs viejos, y de pelo corto vs. de pelo largo (p. ej., el grupo 1 es jóvenes, perros de pelo corto, el grupo 2 es jóvenes, perros de pelo largo, etc.). Dado que las distribuciones del peso de los perros dentro de cada uno de los grupos (mostrados en azul) tienen una varianza relativamente grande, y dado que las medias son muy similares entre los grupos, agrupar a los perros por estas características no produce una forma efectiva de explicar la variación en los pesos de los perros: saber en qué grupo está un perro no nos permite predecir su peso mucho mejor que simplemente saber que el perro está en una exposición canina. Por lo tanto, esta agrupación no explica la variación en la distribución general (amarillo-naranja).

Probablemente , un intento de explicar la distribución del peso agrupando a los perros como razas de mascotas y razas de trabajo y razas menos atléticas y razas más atléticas sería algo más exitoso (ajuste aceptable). Es probable que los perros de exhibición más pesados sean razas grandes, fuertes y de trabajo, mientras que las razas que se tienen como mascotas tienden a ser más pequeñas y, por lo tanto, más livianas. Como se muestra en la segunda ilustración, las distribuciones tienen varianzas que son considerablemente menores que en el primer caso, y las medias son más distinguibles. Sin embargo, la superposición significativa de las distribuciones, por ejemplo, significa que no podemos distinguir X 1 y X 2 de manera confiable. Agrupar a los perros según el lanzamiento de una moneda podría producir distribuciones que parezcan similares.

Es probable que un intento de explicar el peso por raza produzca un ajuste muy bueno. Todos los chihuahuas son livianos y todos los san bernardo son pesados. La diferencia de peso entre setters y pointers no justifica razas separadas. El análisis de varianza proporciona las herramientas formales para justificar estos juicios intuitivos. Un uso común del método es el análisis de datos experimentales o el desarrollo de modelos. El método tiene algunas ventajas sobre la correlación: no todos los datos deben ser numéricos y uno de los resultados del método es un juicio sobre la confianza en una relación explicativa.

Hay tres clases de modelos utilizados en el análisis de varianza, que se describen aquí.

El modelo de efectos fijos (clase I) del análisis de varianza se aplica a situaciones en las que el experimentador aplica uno o más tratamientos a los sujetos del experimento para ver si cambian los valores de la variable de respuesta . Esto permite al experimentador estimar los rangos de valores de la variable de respuesta que generaría el tratamiento en la población en su conjunto.

El modelo de efectos aleatorios (clase II) se utiliza cuando los tratamientos no son fijos. Esto ocurre cuando los distintos niveles de los factores se toman de una muestra de una población más grande. Debido a que los niveles en sí mismos son variables aleatorias , algunas suposiciones y el método de contraste de los tratamientos (una generalización multivariable de diferencias simples) difieren del modelo de efectos fijos. [13]

Un modelo de efectos mixtos (clase III) contiene factores experimentales de tipos de efectos fijos y aleatorios, con interpretaciones y análisis apropiadamente diferentes para los dos tipos.

Los departamentos de una universidad o de un colegio podrían realizar experimentos didácticos para encontrar un buen libro de texto introductorio, y cada texto se consideraría un tratamiento. El modelo de efectos fijos compararía una lista de textos candidatos. El modelo de efectos aleatorios determinaría si existen diferencias importantes entre una lista de textos seleccionados al azar. El modelo de efectos mixtos compararía los textos actuales (fijos) con alternativas seleccionadas al azar.

Definir los efectos fijos y aleatorios ha resultado difícil, ya que existen múltiples definiciones que compiten entre sí. [14]

El análisis de varianza se ha estudiado desde varios enfoques, el más común de los cuales utiliza un modelo lineal que relaciona la respuesta con los tratamientos y los bloques. Cabe señalar que el modelo es lineal en los parámetros, pero puede ser no lineal en los distintos niveles de los factores. La interpretación es sencilla cuando los datos están equilibrados entre los factores, pero se necesita una comprensión mucho más profunda en el caso de datos no equilibrados.

El análisis de varianza se puede presentar en términos de un modelo lineal , que hace las siguientes suposiciones sobre la distribución de probabilidad de las respuestas: [15] [16] [17] [18]

Los supuestos separados del modelo del libro de texto implican que los errores se distribuyen de manera independiente, idéntica y normal para los modelos de efectos fijos, es decir, que los errores ( ) son independientes y

En un experimento controlado aleatorio , los tratamientos se asignan aleatoriamente a las unidades experimentales, siguiendo el protocolo experimental. Esta aleatorización es objetiva y se declara antes de que se lleve a cabo el experimento. La asignación aleatoria objetiva se utiliza para probar la significancia de la hipótesis nula , siguiendo las ideas de CS Peirce y Ronald Fisher . Este análisis basado en el diseño fue discutido y desarrollado por Francis J. Anscombe en la Estación Experimental Rothamsted y por Oscar Kempthorne en la Universidad Estatal de Iowa . [19] Kempthorne y sus estudiantes hacen una suposición de aditividad del tratamiento unitario , que se analiza en los libros de Kempthorne y David R. Cox . [20] [21]

En su forma más simple, el supuesto de aditividad de tratamiento unitario [nb 1] establece que la respuesta observada de la unidad experimental al recibir el tratamiento se puede escribir como la suma de la respuesta de la unidad y el efecto del tratamiento , es decir [22] [23] [24] El supuesto de aditividad de tratamiento unitario implica que, para cada tratamiento , el tratamiento tiene exactamente el mismo efecto en cada unidad experimental.

Según Cox y Kempthorne, la suposición de aditividad de los tratamientos unitarios no suele poder refutar directamente. Sin embargo, muchas consecuencias de la aditividad de los tratamientos unitarios sí pueden refutar. En un experimento aleatorio, la suposición de aditividad de los tratamientos unitarios implica que la varianza es constante para todos los tratamientos. Por lo tanto, por contraposición , una condición necesaria para la aditividad de los tratamientos unitarios es que la varianza sea constante.

El uso de la aditividad y la aleatorización del tratamiento unitario es similar a la inferencia basada en el diseño que es estándar en el muestreo de encuestas de población finita .

Kempthorne utiliza la distribución aleatoria y el supuesto de aditividad del tratamiento unitario para producir un modelo lineal derivado , muy similar al modelo del libro de texto discutido anteriormente. [25] Las estadísticas de prueba de este modelo lineal derivado se aproximan estrechamente a las estadísticas de prueba de un modelo lineal normal apropiado, de acuerdo con teoremas de aproximación y estudios de simulación. [26] Sin embargo, existen diferencias. Por ejemplo, el análisis basado en la aleatorización da como resultado una correlación pequeña pero (estrictamente) negativa entre las observaciones. [27] [28] En el análisis basado en la aleatorización, no hay suposición de una distribución normal y ciertamente ninguna suposición de independencia . Por el contrario, ¡ las observaciones son dependientes !

El análisis basado en la aleatorización tiene la desventaja de que su exposición implica un álgebra tediosa y una gran cantidad de tiempo. Dado que el análisis basado en la aleatorización es complicado y se aproxima mucho al enfoque que utiliza un modelo lineal normal, la mayoría de los profesores enfatizan el enfoque del modelo lineal normal. Pocos estadísticos se oponen al análisis basado en modelos de experimentos aleatorios balanceados.

Sin embargo, cuando se aplica a datos de experimentos no aleatorios o estudios observacionales , el análisis basado en modelos carece de la garantía de la aleatorización. [29] Para los datos observacionales, la derivación de intervalos de confianza debe utilizar modelos subjetivos , como enfatizaron Ronald Fisher y sus seguidores. En la práctica, las estimaciones de los efectos del tratamiento a partir de estudios observacionales generalmente son inconsistentes. En la práctica, los "modelos estadísticos" y los datos observacionales son útiles para sugerir hipótesis que el público debería tratar con mucha cautela. [30]

El análisis ANOVA basado en el modelo normal supone la independencia, normalidad y homogeneidad de las varianzas de los residuos. El análisis basado en la aleatorización supone únicamente la homogeneidad de las varianzas de los residuos (como consecuencia de la aditividad de los tratamientos unitarios) y utiliza el procedimiento de aleatorización del experimento. Ambos análisis requieren homocedasticidad , como supuesto para el análisis del modelo normal y como consecuencia de la aleatorización y la aditividad para el análisis basado en la aleatorización.

Sin embargo, se han llevado a cabo con éxito estudios de procesos que cambian las varianzas en lugar de las medias (llamados efectos de dispersión) utilizando ANOVA. [31] No hay supuestos necesarios para ANOVA en su total generalidad, pero la prueba F utilizada para probar hipótesis de ANOVA tiene supuestos y limitaciones prácticas que son de continuo interés.

Los problemas que no satisfacen los supuestos del ANOVA a menudo se pueden transformar para satisfacer los supuestos. La propiedad de aditividad de tratamiento unitario no es invariante bajo un "cambio de escala", por lo que los estadísticos a menudo utilizan transformaciones para lograr la aditividad de tratamiento unitario. Si se espera que la variable de respuesta siga una familia paramétrica de distribuciones de probabilidad, entonces el estadístico puede especificar (en el protocolo para el experimento o estudio observacional) que las respuestas se transformen para estabilizar la varianza. [32] Además, un estadístico puede especificar que se apliquen transformaciones logarítmicas a las respuestas que se cree que siguen un modelo multiplicativo. [23] [33] Según el teorema de la ecuación funcional de Cauchy , el logaritmo es la única transformación continua que transforma la multiplicación real en suma. [ cita requerida ]

El ANOVA se utiliza en el análisis de experimentos comparativos, aquellos en los que solo interesa la diferencia en los resultados. La significancia estadística del experimento se determina mediante una relación de dos varianzas. Esta relación es independiente de varias posibles alteraciones de las observaciones experimentales: Agregar una constante a todas las observaciones no altera la significancia. Multiplicar todas las observaciones por una constante no altera la significancia. Por lo tanto, el resultado de significancia estadística del ANOVA es independiente del sesgo constante y los errores de escala, así como de las unidades utilizadas para expresar las observaciones. En la era del cálculo mecánico, era común restar una constante de todas las observaciones (cuando era equivalente a eliminar los dígitos iniciales) para simplificar la entrada de datos. [34] [35] Este es un ejemplo de codificación de datos .

Los cálculos de ANOVA pueden caracterizarse como el cálculo de una cantidad de medias y varianzas, la división de dos varianzas y la comparación de la relación con un valor manual para determinar la significación estadística. Calcular el efecto de un tratamiento es, entonces, trivial: "el efecto de cualquier tratamiento se estima tomando la diferencia entre la media de las observaciones que reciben el tratamiento y la media general". [36]

El ANOVA utiliza la terminología estandarizada tradicional. La ecuación de definición de la varianza de la muestra es , donde el divisor se denomina grados de libertad (DF), la suma se denomina suma de cuadrados (SS), el resultado se denomina cuadrado medio (MS) y los términos al cuadrado son desviaciones de la media de la muestra. El ANOVA estima 3 varianzas de la muestra: una varianza total basada en todas las desviaciones de las observaciones con respecto a la media general, una varianza de error basada en todas las desviaciones de las observaciones con respecto a sus medias de tratamiento apropiadas y una varianza de tratamiento. La varianza de tratamiento se basa en las desviaciones de las medias de tratamiento con respecto a la media general, y el resultado se multiplica por el número de observaciones en cada tratamiento para dar cuenta de la diferencia entre la varianza de las observaciones y la varianza de las medias.

La técnica fundamental es la partición de la suma total de cuadrados SS en componentes relacionados con los efectos utilizados en el modelo. Por ejemplo, el modelo para un ANOVA simplificado con un tipo de tratamiento en diferentes niveles.

El número de grados de libertad DF se puede dividir de manera similar: uno de estos componentes (el del error) especifica una distribución de chi-cuadrado que describe la suma de cuadrados asociada, mientras que lo mismo es válido para los "tratamientos" si no hay efecto del tratamiento.

La prueba F se utiliza para comparar los factores de la desviación total. Por ejemplo, en un ANOVA unidireccional o de un solo factor, la significación estadística se prueba comparando la estadística de la prueba F

donde MS es el cuadrado medio, es el número de tratamientos y es el número total de casos

a la distribución F, donde los grados de libertad del numerador y los grados de libertad del denominador son iguales. El uso de la distribución F es un candidato natural porque la estadística de prueba es la relación de dos sumas de cuadrados escaladas, cada una de las cuales sigue una distribución de chi-cuadrado escalada .

El valor esperado de F es (donde es el tamaño de la muestra del tratamiento), que es 1 para que no haya efecto del tratamiento. A medida que los valores de F aumentan por encima de 1, la evidencia es cada vez más inconsistente con la hipótesis nula. Dos métodos experimentales aparentes para aumentar F son aumentar el tamaño de la muestra y reducir la varianza del error mediante controles experimentales estrictos.

Hay dos métodos para concluir la prueba de hipótesis ANOVA, y ambos producen el mismo resultado:

Se sabe que la prueba F de ANOVA es casi óptima en el sentido de minimizar los errores de falsos negativos para una tasa fija de errores de falsos positivos (es decir, maximizar la potencia para un nivel de significancia fijo). Por ejemplo, para probar la hipótesis de que varios tratamientos médicos tienen exactamente el mismo efecto, los valores p de la prueba F se aproximan mucho a los valores p de la prueba de permutación : la aproximación es particularmente cercana cuando el diseño está equilibrado. [26] [37] Tales pruebas de permutación caracterizan las pruebas con máxima potencia contra todas las hipótesis alternativas , como observó Rosenbaum . [nb 2] La prueba F de ANOVA (de la hipótesis nula de que todos los tratamientos tienen exactamente el mismo efecto) se recomienda como una prueba práctica, debido a su robustez contra muchas distribuciones alternativas. [38] [nb 3]

El ANOVA consta de partes separables; la partición de las fuentes de varianza y la prueba de hipótesis se pueden utilizar de forma individual. El ANOVA se utiliza para apoyar otras herramientas estadísticas. La regresión se utiliza primero para ajustar modelos más complejos a los datos, luego se utiliza el ANOVA para comparar modelos con el objetivo de seleccionar modelos más simples que describan adecuadamente los datos. "Estos modelos podrían ajustarse sin ninguna referencia al ANOVA, pero las herramientas del ANOVA podrían utilizarse entonces para dar algún sentido a los modelos ajustados y para probar hipótesis sobre lotes de coeficientes". [39] "Pensamos en el análisis de varianza como una forma de entender y estructurar modelos multinivel, no como una alternativa a la regresión sino como una herramienta para resumir inferencias complejas de alta dimensión..." [39]

El experimento más simple adecuado para el análisis ANOVA es el experimento completamente aleatorizado con un solo factor. Los experimentos más complejos con un solo factor implican restricciones en la aleatorización e incluyen bloques completamente aleatorizados y cuadrados latinos (y variantes: cuadrados grecolatinos , etc.). Los experimentos más complejos comparten muchas de las complejidades de los experimentos con múltiples factores.

Existen algunas alternativas al análisis de varianza unidireccional convencional, por ejemplo: la prueba F heteroscedástica de Welch, la prueba F heteroscedástica de Welch con medias recortadas y varianzas winsorizadas, la prueba de Brown-Forsythe, la prueba de Alexander-Govern, la prueba de segundo orden de James y la prueba de Kruskal-Wallis, disponibles en onewaytests R

Es útil representar cada punto de datos en la siguiente forma, llamada modelo estadístico: donde

Es decir, imaginamos un modelo aditivo que dice que cada punto de datos se puede representar sumando tres cantidades: la media real, promediada sobre todos los niveles de factores que se investigan, más un componente incremental asociado con la columna particular (nivel de factor), más un componente final asociado con todo lo demás que afecta ese valor de datos específico.

El ANOVA se generaliza al estudio de los efectos de múltiples factores. Cuando el experimento incluye observaciones en todas las combinaciones de niveles de cada factor, se denomina factorial . Los experimentos factoriales son más eficientes que una serie de experimentos de un solo factor y la eficiencia aumenta a medida que aumenta el número de factores. [40] En consecuencia, los diseños factoriales se utilizan ampliamente.

El uso de ANOVA para estudiar los efectos de múltiples factores tiene una complicación. En un ANOVA de 3 vías con factores x, y y z, el modelo ANOVA incluye términos para los efectos principales (x, y, z) y términos para interacciones (xy, xz, yz, xyz). Todos los términos requieren pruebas de hipótesis. La proliferación de términos de interacción aumenta el riesgo de que alguna prueba de hipótesis produzca un falso positivo por casualidad. Afortunadamente, la experiencia dice que las interacciones de alto orden son raras. [41] [ verificación necesaria ] La capacidad de detectar interacciones es una ventaja importante del ANOVA de múltiples factores. Probar un factor a la vez oculta las interacciones, pero produce resultados experimentales aparentemente inconsistentes. [40]

Se recomienda tener cuidado al encontrar interacciones; primero pruebe los términos de interacción y amplíe el análisis más allá del ANOVA si se encuentran interacciones. Los textos varían en sus recomendaciones con respecto a la continuación del procedimiento ANOVA después de encontrar una interacción. Las interacciones complican la interpretación de los datos experimentales. Ni los cálculos de significancia ni los efectos estimados del tratamiento pueden tomarse al pie de la letra. "Una interacción significativa a menudo enmascarará la significancia de los efectos principales". [42] Se recomiendan métodos gráficos para mejorar la comprensión. La regresión suele ser útil. Una discusión extensa de las interacciones está disponible en Cox (1958). [43] Algunas interacciones pueden eliminarse (mediante transformaciones) mientras que otras no.

Se utilizan diversas técnicas con ANOVA de múltiples factores para reducir los gastos. Una técnica utilizada en los diseños factoriales es minimizar la replicación (posiblemente ninguna replicación con el apoyo de trucos analíticos ) y combinar grupos cuando se descubre que los efectos son estadísticamente (o prácticamente) insignificantes. Un experimento con muchos factores insignificantes puede colapsar en uno con unos pocos factores respaldados por muchas réplicas. [44]

Se requiere un cierto análisis para respaldar el diseño del experimento, mientras que otro análisis se realiza después de que se determina formalmente que los cambios en los factores producen cambios estadísticamente significativos en las respuestas. Debido a que la experimentación es iterativa, los resultados de un experimento modifican los planes para los experimentos siguientes.

En el diseño de un experimento, se planifica el número de unidades experimentales para satisfacer los objetivos del experimento. La experimentación suele ser secuencial.

Los primeros experimentos suelen estar diseñados para proporcionar estimaciones sin sesgo de media de los efectos del tratamiento y del error experimental. Los experimentos posteriores suelen estar diseñados para probar una hipótesis de que un efecto del tratamiento tiene una magnitud importante; en este caso, el número de unidades experimentales se elige de modo que el experimento se ajuste al presupuesto y tenga la potencia adecuada, entre otros objetivos.

En psicología, por lo general, se exige que se informe sobre el análisis del tamaño de la muestra. "Proporcione información sobre el tamaño de la muestra y el proceso que llevó a las decisiones sobre el tamaño de la muestra". [45] El análisis, que se escribe en el protocolo experimental antes de que se realice el experimento, se examina en las solicitudes de subvención y en las juntas de revisión administrativa.

Además del análisis de potencia, existen métodos menos formales para seleccionar el número de unidades experimentales. Entre ellos se encuentran los métodos gráficos basados en limitar la probabilidad de errores falsos negativos, los métodos gráficos basados en un aumento esperado de la variación (por encima de los residuos) y los métodos basados en alcanzar un intervalo de confianza deseado. [46]

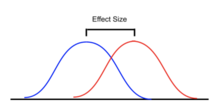

El análisis de potencia se aplica a menudo en el contexto de ANOVA para evaluar la probabilidad de rechazar con éxito la hipótesis nula si asumimos un determinado diseño de ANOVA, tamaño del efecto en la población, tamaño de la muestra y nivel de significación. El análisis de potencia puede ayudar en el diseño del estudio al determinar qué tamaño de muestra sería necesario para tener una probabilidad razonable de rechazar la hipótesis nula cuando la hipótesis alternativa es verdadera. [47] [48] [49] [50]

Se han propuesto varias medidas estandarizadas del efecto para que el ANOVA resuma la fuerza de la asociación entre un predictor o predictores y la variable dependiente o la diferencia estandarizada general del modelo completo. Las estimaciones estandarizadas del tamaño del efecto facilitan la comparación de los hallazgos entre estudios y disciplinas. Sin embargo, si bien los tamaños estandarizados del efecto se utilizan comúnmente en gran parte de la literatura profesional, una medida no estandarizada del tamaño del efecto que tenga unidades inmediatamente "significativas" puede ser preferible para fines de presentación de informes. [51]

En ocasiones se realizan pruebas para determinar si los supuestos del ANOVA parecen violarse. Los residuos se examinan o analizan para confirmar la homocedasticidad y la normalidad bruta. [52] Los residuos deben tener la apariencia de ruido (distribución normal de media cero) cuando se grafican como una función de cualquier cosa, incluidos el tiempo y los valores de los datos modelados. Las tendencias insinúan interacciones entre factores o entre observaciones.

Un efecto estadísticamente significativo en el ANOVA suele ir seguido de pruebas adicionales. Esto se puede hacer para evaluar qué grupos son diferentes de otros grupos o para probar otras hipótesis específicas. Las pruebas de seguimiento suelen distinguirse en términos de si son "planificadas" ( a priori ) o "post hoc ". Las pruebas planificadas se determinan antes de analizar los datos, y las pruebas post hoc se conciben solo después de analizar los datos (aunque el término "post hoc" se utiliza de forma inconsistente).

Las pruebas de seguimiento pueden ser comparaciones "simples" por pares de medias de grupos individuales o pueden ser comparaciones "compuestas" (por ejemplo, comparar la agrupación de medias de los grupos A, B y C con la media del grupo D). Las comparaciones también pueden considerar pruebas de tendencia, como relaciones lineales y cuadráticas, cuando la variable independiente implica niveles ordenados. A menudo, las pruebas de seguimiento incorporan un método de ajuste para el problema de comparaciones múltiples .

Las pruebas de seguimiento para identificar qué grupos, variables o factores específicos tienen medias estadísticamente diferentes incluyen la prueba de rango de Tukey y la nueva prueba de rango múltiple de Duncan . A su vez, estas pruebas suelen ir seguidas de una metodología de visualización compacta de letras (CLD) para que el resultado de las pruebas mencionadas sea más transparente para una audiencia no especializada en estadística.

Existen varios tipos de ANOVA. Muchos estadísticos basan el ANOVA en el diseño del experimento [53] , especialmente en el protocolo que especifica la asignación aleatoria de tratamientos a los sujetos; la descripción del protocolo del mecanismo de asignación debe incluir una especificación de la estructura de los tratamientos y de cualquier bloqueo . También es común aplicar el ANOVA a datos observacionales utilizando un modelo estadístico apropiado [54] .

Algunos diseños populares utilizan los siguientes tipos de ANOVA:

Los experimentos balanceados (aquellos con un tamaño de muestra igual para cada tratamiento) son relativamente fáciles de interpretar; los experimentos no balanceados ofrecen más complejidad. Para el ANOVA de un solo factor (unidireccional), el ajuste para los datos no balanceados es fácil, pero el análisis no balanceado carece tanto de robustez como de potencia. [57] Para diseños más complejos, la falta de balance conduce a más complicaciones. "La propiedad de ortogonalidad de los efectos principales y las interacciones presente en los datos balanceados no se traslada al caso no balanceado. Esto significa que las técnicas habituales de análisis de varianza no se aplican. En consecuencia, el análisis de los factoriales no balanceados es mucho más difícil que el de los diseños balanceados". [58] En el caso general, "El análisis de varianza también se puede aplicar a los datos no balanceados, pero entonces las sumas de cuadrados, los cuadrados medios y los cocientes F dependerán del orden en que se consideren las fuentes de variación". [39]

El ANOVA es (en parte) una prueba de significación estadística. La Asociación Estadounidense de Psicología (y muchas otras organizaciones) sostienen que no basta con informar simplemente sobre la significación estadística y que es preferible informar sobre límites de confianza. [51]

Se considera que el ANOVA es un caso especial de regresión lineal [59] [60] que a su vez es un caso especial del modelo lineal general . [61] Todos consideran que las observaciones son la suma de un modelo (ajuste) y un residuo (error) a minimizar.

La prueba de Kruskal-Wallis y la prueba de Friedman son pruebas no paramétricas que no se basan en un supuesto de normalidad. [62] [63]

A continuación aclaramos la conexión entre el ANOVA multidireccional y la regresión lineal.

Reordenar linealmente los datos de modo que la observación -ésima esté asociada con una respuesta y factores donde denota los diferentes factores y es el número total de factores. En ANOVA de una vía y en ANOVA de dos vías . Además, suponemos que el factor -ésimo tiene niveles, es decir . Ahora, podemos codificar en caliente los factores en el vector dimensional .

La función de codificación one-hot se define de modo que la entrada -ésima de es El vector es la concatenación de todos los vectores anteriores para todos los . Por lo tanto, . Para obtener un ANOVA de interacción de vías completamente general, también debemos concatenar cada término de interacción adicional en el vector y luego agregar un término de intersección. Sea ese vector .

Con esta notación en su lugar, ahora tenemos la conexión exacta con la regresión lineal. Simplemente hacemos una regresión de la respuesta contra el vector . Sin embargo, existe una preocupación sobre la identificabilidad . Para superar estos problemas, suponemos que la suma de los parámetros dentro de cada conjunto de interacciones es igual a cero. A partir de aquí, se pueden utilizar estadísticas F u otros métodos para determinar la relevancia de los factores individuales.

Podemos considerar el ejemplo de interacción bidireccional donde asumimos que el primer factor tiene 2 niveles y el segundo factor tiene 3 niveles.

Define si y si , es decir, es la codificación one-hot del primer factor y es la codificación one-hot del segundo factor.

Con esto, donde el último término es un término de intersección. Para un ejemplo más concreto supongamos que Entonces,

{{cite book}}: Mantenimiento de CS1: falta la ubicación del editor ( enlace )