El ajuste de distribución de probabilidad o simplemente ajuste de distribución es el ajuste de una distribución de probabilidad a una serie de datos relativos a la medición repetida de un fenómeno variable. El objetivo del ajuste de distribución es predecir la probabilidad o pronosticar la frecuencia de ocurrencia de la magnitud del fenómeno en un intervalo determinado.

Existen muchas distribuciones de probabilidad (véase la lista de distribuciones de probabilidad ) de las cuales algunas pueden ajustarse mejor que otras a la frecuencia observada de los datos, dependiendo de las características del fenómeno y de la distribución. Se supone que la distribución que ofrece un ajuste más preciso conduce a buenas predicciones. Por lo tanto, al ajustar una distribución, es necesario seleccionar una distribución que se adapte bien a los datos.

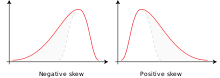

La selección de la distribución apropiada depende de la presencia o ausencia de simetría del conjunto de datos con respecto a la tendencia central .

Distribuciones simétricas

Cuando los datos se distribuyen simétricamente alrededor de la media mientras que la frecuencia de ocurrencia de los datos más alejados de la media disminuye, se puede seleccionar, por ejemplo, la distribución normal , la distribución logística o la distribución t de Student . Las dos primeras son muy similares, mientras que la última, con un grado de libertad, tiene "colas más pesadas", lo que significa que los valores más alejados de la media ocurren con relativa mayor frecuencia (es decir, la curtosis es mayor). La distribución de Cauchy también es simétrica.

Distribuciones sesgadas hacia la derecha

Cuando los valores más grandes tienden a estar más alejados de la media que los valores más pequeños, se tiene una distribución sesgada hacia la derecha (es decir, hay sesgo positivo ), se puede seleccionar, por ejemplo, la distribución log-normal (es decir, los valores logarítmicos de los datos se distribuyen normalmente ), la distribución log-logística (es decir, los valores logarítmicos de los datos siguen una distribución logística ), la distribución de Gumbel , la distribución exponencial , la distribución de Pareto , la distribución de Weibull , la distribución de Burr o la distribución de Fréchet . Las últimas cuatro distribuciones están acotadas a la izquierda.

Distribuciones sesgadas hacia la izquierda

Cuando los valores más pequeños tienden a estar más alejados de la media que los valores más grandes, se tiene una distribución sesgada hacia la izquierda (es decir, hay sesgo negativo), se puede seleccionar, por ejemplo, la distribución normal cuadrada (es decir, la distribución normal aplicada al cuadrado de los valores de los datos), [1] la distribución Gumbel invertida (reflejada), [1] la distribución Dagum (distribución Burr reflejada) o la distribución Gompertz , que está limitada a la izquierda.

Existen las siguientes técnicas de ajuste de distribución: [2]

Es habitual transformar los datos de forma logarítmica para ajustar las distribuciones simétricas (como la normal y la logística ) a los datos que obedecen a una distribución que está sesgada positivamente (es decir, sesgada hacia la derecha, con media > moda y con una cola derecha que es más larga que la cola izquierda), consulte la distribución lognormal y la distribución loglogística . Se puede lograr un efecto similar tomando la raíz cuadrada de los datos.

Para ajustar una distribución simétrica a datos que obedecen a una distribución sesgada negativamente (es decir, sesgada hacia la izquierda, con media < moda y con una cola derecha más corta que la cola izquierda), se podrían usar los valores al cuadrado de los datos para lograr el ajuste.

En términos más generales, se pueden elevar los datos a una potencia p para ajustar distribuciones simétricas a datos que obedecen a una distribución de cualquier asimetría, donde p < 1 cuando la asimetría es positiva y p > 1 cuando la asimetría es negativa. El valor óptimo de p se encuentra mediante un método numérico . El método numérico puede consistir en suponer un rango de valores p , luego aplicar el procedimiento de ajuste de distribución repetidamente para todos los valores p supuestos y, finalmente, seleccionar el valor de p para el cual la suma de los cuadrados de las desviaciones de las probabilidades calculadas a partir de las frecuencias medidas ( chi cuadrado ) es mínima, como se hace en CumFreq .

La generalización mejora la flexibilidad de las distribuciones de probabilidad y aumenta su aplicabilidad en el ajuste de distribuciones. [6]

La versatilidad de la generalización permite, por ejemplo, ajustar conjuntos de datos distribuidos de manera aproximadamente normal a un gran número de distribuciones de probabilidad diferentes, [7] mientras que las distribuciones sesgadas negativamente se pueden ajustar a distribuciones de Gumbel cuadradas normales y reflejadas. [8]

Las distribuciones sesgadas pueden invertirse (o reflejarse) sustituyendo en la expresión matemática la función de distribución acumulativa (F) por su complemento: F'=1-F, obteniéndose la función de distribución complementaria (también llamada función de supervivencia ) que da una imagen especular. De esta manera, una distribución sesgada a la derecha se transforma en una distribución sesgada a la izquierda y viceversa.

La técnica de inversión de asimetría aumenta el número de distribuciones de probabilidad disponibles para el ajuste de distribuciones y amplía las oportunidades de ajuste de distribuciones.

Algunas distribuciones de probabilidad, como la exponencial , no admiten valores de datos negativos ( X ). Sin embargo, cuando hay datos negativos, dichas distribuciones aún se pueden usar reemplazando X por Y = X - Xm , donde Xm es el valor mínimo de X . Este reemplazo representa un desplazamiento de la distribución de probabilidad en dirección positiva, es decir, hacia la derecha, porque Xm es negativo. Después de completar el ajuste de la distribución de Y , los valores de X correspondientes se encuentran a partir de X = Y + Xm , que representa un desplazamiento hacia atrás de la distribución en dirección negativa, es decir, hacia la izquierda.

La técnica de desplazamiento de la distribución aumenta la posibilidad de encontrar una distribución de probabilidad que se ajuste correctamente.

Existe la opción de utilizar dos distribuciones de probabilidad diferentes, una para el rango inferior de datos y otra para el superior, como por ejemplo la distribución de Laplace . Los rangos están separados por un punto de quiebre. El uso de tales distribuciones de probabilidad compuestas (discontinuas) puede ser oportuno cuando los datos del fenómeno estudiado se obtuvieron bajo dos conjuntos de condiciones diferentes. [6]

Las predicciones de ocurrencia basadas en distribuciones de probabilidad ajustadas están sujetas a incertidumbre , que surge de las siguientes condiciones:

Una estimación de la incertidumbre en el primer y segundo caso se puede obtener con la distribución de probabilidad binomial utilizando, por ejemplo, la probabilidad de excedencia Pe (es decir, la posibilidad de que el evento X sea mayor que un valor de referencia Xr de X ) y la probabilidad de no excedencia Pn (es decir, la posibilidad de que el evento X sea menor o igual que el valor de referencia Xr , esto también se llama probabilidad acumulada ). En este caso solo hay dos posibilidades: o hay excedencia o no hay excedencia. Esta dualidad es la razón por la que se aplica la distribución binomial.

Con la distribución binomial se puede obtener un intervalo de predicción . Dicho intervalo también estima el riesgo de falla, es decir, la probabilidad de que el evento predicho permanezca fuera del intervalo de confianza. El análisis de confianza o riesgo puede incluir el período de retorno T=1/Pe como se hace en hidrología .

Se puede utilizar un enfoque bayesiano para ajustar un modelo que tenga una distribución previa para el parámetro . Cuando se tienen muestras extraídas independientemente de la distribución subyacente, se puede derivar la denominada distribución posterior . Esta distribución posterior se puede utilizar para actualizar la función de masa de probabilidad para una nueva muestra dadas las observaciones , se obtiene

.

También se puede determinar la varianza de la función de masa de probabilidad recién obtenida. La varianza de una función de masa de probabilidad bayesiana se puede definir como

.

Esta expresión para la varianza se puede simplificar sustancialmente (suponiendo que las muestras se extraen de forma independiente). Definiendo la "función de masa de probabilidad propia" como

,

se obtiene para la varianza [12]

.

La expresión de varianza implica un ajuste adicional que incluye la muestra de interés.

Al clasificar la bondad de ajuste de varias distribuciones, uno puede tener una idea de qué distribución es aceptable y cuál no.

A partir de la función de distribución acumulativa (CDF) se puede derivar un histograma y la función de densidad de probabilidad (PDF).