En los sitios web que permiten a los usuarios crear contenido, la moderación de contenido es el proceso de detectar contribuciones que son irrelevantes, obscenas, ilegales, dañinas o insultantes, en contraste con las contribuciones útiles o informativas, con frecuencia para censurar o suprimir puntos de vista opuestos. El propósito de la moderación de contenido es eliminar o aplicar una etiqueta de advertencia al contenido problemático o permitir que los usuarios bloqueen y filtren el contenido ellos mismos. [1]

Varios tipos de sitios de Internet permiten contenido generado por el usuario, como publicaciones, comentarios, videos, incluidos foros de Internet , blogs y sitios de noticias que funcionan con scripts como phpBB , una Wiki o PHP-Nuke , etc. Dependiendo del contenido del sitio y la audiencia a la que se dirige, los administradores del sitio decidirán qué tipos de comentarios de los usuarios son apropiados y luego delegarán la responsabilidad de filtrar los comentarios a moderadores menores . La mayoría de las veces, intentarán eliminar el troleo , el spam o el insulto , aunque esto varía ampliamente de un sitio a otro.

Las principales plataformas utilizan una combinación de herramientas algorítmicas, informes de usuarios y revisión humana. [1] Los sitios de redes sociales también pueden emplear moderadores de contenido para marcar o eliminar manualmente el contenido marcado por incitación al odio u otro contenido objetable. Otros problemas de contenido incluyen pornografía vengativa , contenido gráfico , material de abuso infantil y propaganda . [1] Algunos sitios web también deben hacer que su contenido sea apto para anuncios. [1]

En Estados Unidos, la moderación de contenidos está regida por la Sección 230 de la Ley de Decencia en las Comunicaciones , y varios casos relacionados con este tema han llegado a la Corte Suprema de Estados Unidos , como el actual Moody v. NetChoice, LLC .

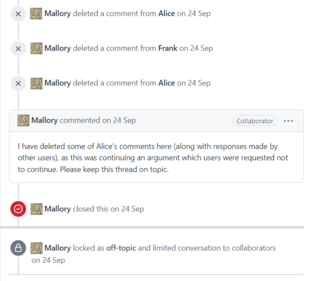

Este tipo de sistema de moderación, también conocido como moderación unilateral, se suele ver en los foros de Internet . Los administradores del sitio eligen a un grupo de personas (normalmente de forma permanente) para que actúen como delegados y hagan cumplir las normas de la comunidad en su nombre. A estos moderadores se les otorgan privilegios especiales para eliminar o editar las contribuciones de otros y/o excluir a personas en función de su dirección de correo electrónico o dirección IP , y generalmente intentan eliminar las contribuciones negativas en toda la comunidad. [2]

Moderación de contenido comercial es un término acuñado por Sarah T. Roberts para describir la práctica de "monitorear y examinar el contenido generado por el usuario (UGC) para plataformas de redes sociales de todo tipo, con el fin de garantizar que el contenido cumpla con las exigencias legales y regulatorias, las pautas del sitio/comunidad, los acuerdos de usuario y que se ajuste a las normas de gusto y aceptabilidad para ese sitio y su contexto cultural". [3]

Se estima que la industria de moderación de contenido tiene un valor de 9 mil millones de dólares. Si bien no se proporcionan cifras oficiales, se estima que hay 10 000 moderadores de contenido para TikTok , 15 000 para Facebook y 1500 para Twitter en 2022. [4]

La cadena de valor global de la moderación de contenidos incluye típicamente plataformas de redes sociales, grandes empresas multinacionales y proveedores de moderación de contenidos. Las plataformas de redes sociales (por ejemplo, Facebook, Google) tienen su sede principalmente en Estados Unidos, Europa y China. Las empresas multinacionales (por ejemplo, Accenture , Foiwe ) suelen tener su sede en el norte global o en la India, mientras que los proveedores de moderación de contenidos se encuentran principalmente en países del sur global, como la India y Filipinas. [5] : 79–81

Si bien en algún momento este trabajo pudo haber sido realizado por voluntarios dentro de la comunidad en línea, para los sitios web comerciales esto se logra en gran medida mediante la subcontratación de la tarea a empresas especializadas, a menudo en áreas de bajos salarios como India y Filipinas. La subcontratación de trabajos de moderación de contenido aumentó como resultado del auge de las redes sociales . Con el crecimiento abrumador de usuarios y UGC, las empresas necesitaban muchos más empleados para moderar el contenido. A fines de la década de 1980 y principios de la de 1990, las empresas de tecnología comenzaron a subcontratar trabajos a países extranjeros que tenían una fuerza laboral capacitada pero estaban dispuestos a trabajar por poco dinero. [6]

Los empleados trabajan viendo, evaluando y eliminando contenido perturbador. [7] Wired informó en 2014 que pueden sufrir daños psicológicos [8] [9] [10] [2] [11] En 2017, The Guardian informó que puede surgir un trauma secundario , con síntomas similares al TEPT . [12] Algunas grandes empresas como Facebook ofrecen apoyo psicológico [12] y confían cada vez más en el uso de inteligencia artificial para clasificar el contenido más gráfico e inapropiado, pero los críticos afirman que es insuficiente. [13] En 2019, NPR lo calificó de riesgo laboral. [14] Los acuerdos de confidencialidad son la norma cuando se contratan moderadores de contenido. Esto hace que los moderadores sean más reacios a hablar sobre las condiciones de trabajo u organizarse. [4]

Los riesgos psicológicos, incluidos el estrés y el trastorno de estrés postraumático , combinados con la precariedad de la gestión algorítmica y los bajos salarios hacen que la moderación de contenidos sea extremadamente difícil. [15] : 123 La cantidad de tareas completadas, por ejemplo, etiquetar contenido como violación de derechos de autor, eliminar una publicación que contiene un discurso de odio o revisar contenido gráfico, se cuantifican para garantizar el rendimiento y la calidad . [4]

En febrero de 2019, un informe de investigación de The Verge describió las malas condiciones de trabajo en la oficina de Cognizant en Phoenix, Arizona . [16] Los empleados de Cognizant encargados de la moderación de contenido para Facebook desarrollaron problemas de salud mental , incluido el trastorno de estrés postraumático , como resultado de la exposición a violencia gráfica , discurso de odio y teorías de conspiración en los videos que se les indicó que evaluaran. [16] [17] Los moderadores de la oficina de Phoenix informaron sobre el abuso de drogas , abuso de alcohol y relaciones sexuales en el lugar de trabajo, y temían represalias de los trabajadores despedidos que amenazaran con hacerles daño. [16] [18] En respuesta, un representante de Cognizant declaró que la empresa examinaría los problemas en el informe. [16]

The Verge publicó una investigación de seguimiento de la oficina de Cognizant en Tampa, Florida , en junio de 2019. [19] [20] Los empleados de la sede de Tampa describieron condiciones de trabajo que eran peores que las condiciones en la oficina de Phoenix. [19] [21] [22]

Los moderadores debían firmar acuerdos de confidencialidad con Cognizant para obtener el trabajo, aunque tres ex trabajadores rompieron los acuerdos para proporcionar información a The Verge . [19] [23] En la oficina de Tampa, los trabajadores informaron sobre recursos de salud mental inadecuados. [19] [24] Como resultado de la exposición a videos que mostraban violencia gráfica, abuso animal y abuso sexual infantil , algunos empleados desarrollaron trauma psicológico y trastorno de estrés postraumático. [19] [25] En respuesta a la cobertura negativa relacionada con sus contratos de moderación de contenido, un director de Facebook indicó que Facebook está en proceso de desarrollar un "equipo de resiliencia global" que ayudaría a sus contratistas. [19]

Facebook había aumentado el número de moderadores de contenido de 4.500 a 7.500 en 2017 debido a requisitos legales y otras controversias . En Alemania, Facebook era responsable de eliminar el discurso de odio dentro de las 24 horas posteriores a su publicación. [26] A fines de 2018, Facebook creó una junta de supervisión o un "Tribunal Supremo" interno para decidir qué contenido permanece y qué contenido se elimina. [14]

Según Frances Haugen , el número de empleados de Facebook responsables de la moderación de contenidos era mucho menor en 2021. [27]

La red social Twitter tiene una política de suspensión . Entre agosto de 2015 y diciembre de 2017, suspendió más de 1,2 millones de cuentas por contenido terrorista para reducir el número de seguidores y la cantidad de contenido asociado con el Estado Islámico. [28] Tras la adquisición de Twitter por parte de Elon Musk en octubre de 2022, las normas de contenido se han debilitado en toda la plataforma en un intento de priorizar la libertad de expresión. [29] Sin embargo, los efectos de esta campaña han sido cuestionados. [30] [31]

La moderación de usuarios permite a cualquier usuario moderar las contribuciones de cualquier otro usuario. Actualmente, miles de millones de personas toman decisiones sobre qué compartir, reenviar o dar visibilidad a diario. [32] En un sitio grande con una población activa suficientemente grande, esto suele funcionar bien, ya que una cantidad relativamente pequeña de alborotadores son excluidos por los votos del resto de la comunidad.

La moderación de usuarios también se puede caracterizar por la moderación reactiva. Este tipo de moderación depende de que los usuarios de una plataforma o sitio denuncien contenido que sea inapropiado y que infrinja los estándares de la comunidad . En este proceso, cuando los usuarios se enfrentan a una imagen o un video que consideran inadecuado, pueden hacer clic en el botón de denuncia. La queja se presenta y se pone en cola para que los moderadores la revisen. [33]

150 moderadores de contenido, contratados por Meta , ByteDance y OpenAI, se reunieron en Nairobi, Kenia, para lanzar la primera Unión Africana de Moderadores de Contenido el 1 de mayo de 2023. Esta unión se lanzó 4 años después de que Daniel Motaung fuera despedido y sufriera represalias por organizar un sindicato en Sama , que tiene contrato con Facebook. [34]