En teoría de redes , el análisis de enlaces es una técnica de análisis de datos que se utiliza para evaluar las relaciones (Tap link [ aclaración necesaria ] ) entre nodos. Se pueden identificar relaciones entre varios tipos de nodos (100k [ aclaración necesaria ] ), incluidas organizaciones , personas y transacciones . El análisis de enlaces se ha utilizado para la investigación de actividades delictivas ( fraude , contraterrorismo e inteligencia ), análisis de seguridad informática , optimización de motores de búsqueda , investigación de mercado , investigación médica y arte.

El descubrimiento de conocimiento es un proceso iterativo e interactivo que se utiliza para identificar , analizar y visualizar patrones en los datos. [1] El análisis de redes, el análisis de vínculos y el análisis de redes sociales son métodos de descubrimiento de conocimiento, cada uno de ellos un subconjunto correspondiente del método anterior. La mayoría de los métodos de descubrimiento de conocimiento siguen estos pasos (en el nivel más alto): [2]

La recopilación y el procesamiento de datos requieren acceso a los datos y conllevan varios problemas inherentes, como la sobrecarga de información y los errores en los datos. Una vez recopilados los datos, será necesario transformarlos a un formato que pueda ser utilizado de manera eficaz tanto por analizadores humanos como informáticos. Se pueden crear herramientas de visualización manuales o generadas por computadora a partir de los datos, incluidos los gráficos de red. Existen varios algoritmos para ayudar con el análisis de datos: el algoritmo de Dijkstra , la búsqueda en amplitud y la búsqueda en profundidad .

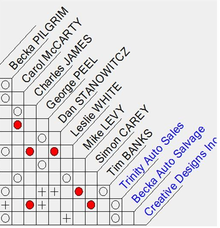

El análisis de vínculos se centra en el análisis de las relaciones entre nodos mediante métodos de visualización ( gráficos de red , matrices de asociación). A continuación se muestra un ejemplo de las relaciones que se pueden representar en un mapa para las investigaciones de delitos: [3]

El análisis de enlaces se utiliza para tres propósitos principales: [4]

Klerks clasificó las herramientas de análisis de enlaces en tres generaciones. [5] La primera generación se introdujo en 1975 como el diagrama de Anacpapa de Harper y Harris. [6] Este método requiere que un experto en el dominio revise los archivos de datos, identifique las asociaciones mediante la construcción de una matriz de asociación, cree un diagrama de enlaces para su visualización y, por último, analice el diagrama de red para identificar patrones de interés. Este método requiere un amplio conocimiento del dominio y consume mucho tiempo cuando se revisan grandes cantidades de datos.

Además de la matriz de asociación, la matriz de actividades se puede utilizar para producir información procesable, que tiene valor práctico y utilidad para la aplicación de la ley. La matriz de actividades, como el término podría implicar, se centra en las acciones y actividades de las personas con respecto a las ubicaciones, mientras que la matriz de asociación se centra en las relaciones entre personas, organizaciones y/o propiedades. La distinción entre estos dos tipos de matrices, aunque menor, es no obstante significativa en términos del resultado del análisis realizado o presentado. [7] [8] [9] [10]

Las herramientas de segunda generación consisten en herramientas de análisis automático basadas en gráficos, como IBM i2 Analyst's Notebook, Netmap, ClueMaker y Watson. Estas herramientas ofrecen la posibilidad de automatizar la construcción y las actualizaciones del gráfico de vínculos una vez que se crea manualmente una matriz de asociación; sin embargo, el análisis de los gráficos y diagramas resultantes aún requiere un experto con amplios conocimientos del dominio.

La tercera generación de herramientas de análisis de enlaces como DataWalk permite la visualización automática de vínculos entre elementos de un conjunto de datos, que luego pueden servir como lienzo para una mayor exploración o actualizaciones manuales.

Con las grandes cantidades de datos e información que se almacenan electrónicamente, los usuarios se enfrentan a múltiples fuentes de información no relacionadas disponibles para el análisis. Se requieren técnicas de análisis de datos para hacer un uso eficaz y eficiente de los datos. Palshikar clasifica las técnicas de análisis de datos en dos categorías: ( modelos estadísticos , análisis de series temporales , agrupamiento y clasificación , algoritmos de coincidencia para detectar anomalías) y técnicas de inteligencia artificial (IA) (minería de datos, sistemas expertos , reconocimiento de patrones , técnicas de aprendizaje automático , redes neuronales ). [14]

Bolton & Hand definen el análisis de datos estadísticos como métodos supervisados o no supervisados. [15] Los métodos de aprendizaje supervisado requieren que se definan reglas dentro del sistema para establecer qué es un comportamiento esperado o inesperado. Los métodos de aprendizaje no supervisado revisan los datos en comparación con la norma y detectan valores estadísticos atípicos. Los métodos de aprendizaje supervisado están limitados en los escenarios que pueden manejar, ya que este método requiere que se establezcan reglas de entrenamiento basadas en patrones previos. Los métodos de aprendizaje no supervisado pueden proporcionar la detección de problemas más amplios, sin embargo, pueden resultar en una mayor proporción de falsos positivos si la norma de comportamiento no está bien establecida o entendida.

Los datos en sí mismos tienen problemas inherentes, entre ellos la integridad (o falta de ella) y los cambios continuos. Los datos pueden contener "errores de omisión y comisión debido a una recopilación o un manejo defectuosos, y cuando las entidades intentan activamente engañar y/o ocultar sus acciones". [4] Sparrow [16] destaca la incompletitud (inevitabilidad de la falta de datos o vínculos), los límites difusos (subjetividad a la hora de decidir qué incluir) y los cambios dinámicos (reconocimiento de que los datos cambian constantemente) como los tres problemas principales del análisis de datos. [3]

Una vez que los datos se transforman en un formato utilizable, pueden surgir problemas de textura abierta y de referencias cruzadas. Waismann definió la textura abierta como la inevitable incertidumbre en el significado cuando se utilizan términos empíricos en diferentes contextos. [17] La incertidumbre en el significado de los términos presenta problemas cuando se intenta buscar y hacer referencias cruzadas de datos de múltiples fuentes. [18]

El método principal para resolver problemas de análisis de datos es confiar en el conocimiento del dominio por parte de un experto. Este es un método de análisis de enlaces que requiere mucho tiempo y es muy costoso y tiene sus propios problemas inherentes. McGrath et al. concluyen que el diseño y la presentación de un diagrama de red tienen un impacto significativo en las "percepciones del usuario sobre la existencia de grupos en redes". [19] Incluso el uso de expertos en el dominio puede dar lugar a conclusiones diferentes, ya que el análisis puede ser subjetivo.

Las técnicas de análisis de enlaces se han utilizado principalmente con fines judiciales, ya que es mucho más fácil revisar datos históricos en busca de patrones que intentar predecir acciones futuras.

Krebs demostró el uso de una matriz de asociación y un diagrama de vínculos de la red terrorista asociada con los 19 secuestradores responsables de los ataques del 11 de septiembre al mapear detalles disponibles públicamente que se hicieron públicos después de los ataques. [3] Incluso con las ventajas de la retrospectiva y la información disponible públicamente sobre personas, lugares y transacciones, está claro que faltan datos.

Por otra parte, Picarelli argumentó que el uso de técnicas de análisis de vínculos podría haberse utilizado para identificar y potencialmente prevenir actividades ilícitas dentro de la red Aum Shinrikyo . [20] "Debemos tener cuidado con la 'culpa por asociación'. Estar vinculado a un terrorista no prueba la culpabilidad, pero sí invita a la investigación". [3] Equilibrar los conceptos legales de causa probable , derecho a la privacidad y libertad de asociación se vuelve un desafío cuando se revisan datos potencialmente sensibles con el objetivo de prevenir un delito o una actividad ilegal que aún no ha ocurrido.

Hay cuatro categorías de soluciones de análisis de enlaces propuestas: [21]

Las herramientas basadas en heurísticas utilizan reglas de decisión que se extraen del conocimiento experto mediante datos estructurados. Las herramientas basadas en plantillas emplean el procesamiento del lenguaje natural (PLN) para extraer detalles de datos no estructurados que se corresponden con plantillas predefinidas. Los enfoques basados en similitudes utilizan una puntuación ponderada para comparar atributos e identificar posibles vínculos. Los enfoques estadísticos identifican posibles vínculos basándose en estadísticas léxicas.

JJ Xu y H. Chen proponen un marco para el análisis y visualización automatizados de redes llamado CrimeNet Explorer. [22] Este marco incluye los siguientes elementos:

{{cite web}}: |last=tiene nombre genérico ( ayuda )