En la teoría de la decisión estadística , cuando nos enfrentamos al problema de estimar un parámetro determinista (vector) a partir de observaciones, un estimador (regla de estimación) se denomina minimax si su riesgo máximo es mínimo entre todos los estimadores de . En cierto sentido, esto significa que es un estimador que funciona mejor en el peor caso posible permitido en el problema.

Considere el problema de estimar un parámetro determinista (no bayesiano ) a partir de datos ruidosos o corruptos relacionados a través de la distribución de probabilidad condicional . Nuestro objetivo es encontrar un estimador "bueno" para estimar el parámetro , que minimice una función de riesgo dada . Aquí la función de riesgo (técnicamente un Funcional u Operador ya que es una función de una función, NO una composición de funciones) es la expectativa de alguna función de pérdida con respecto a . Un ejemplo popular para una función de pérdida [1] es la pérdida de error al cuadrado , y la función de riesgo para esta pérdida es el error cuadrático medio (MSE).

Lamentablemente, en general, el riesgo no se puede minimizar, ya que depende del parámetro desconocido en sí (si supiéramos cuál es el valor real de , no necesitaríamos estimarlo). Por lo tanto, se requieren criterios adicionales para encontrar un estimador óptimo en algún sentido. Uno de esos criterios es el criterio minimax.

Definición : Un estimador se denomina minimax con respecto a una función de riesgo si logra el riesgo máximo más pequeño entre todos los estimadores, lo que significa que satisface

Lógicamente, un estimador es minimax cuando es el mejor en el peor caso. Siguiendo esta lógica, un estimador minimax debería ser un estimador de Bayes con respecto a una distribución previa menos favorable de . Para demostrar esta noción, denotemos el riesgo promedio del estimador de Bayes con respecto a una distribución previa como

Definición: Una distribución previa se denomina menos favorable si para cualquier otra distribución el riesgo promedio satisface .

Teorema 1: Si entonces:

Corolario: si un estimador bayesiano tiene riesgo constante, es minimax. Nótese que esta no es una condición necesaria.

Ejemplo 1: Moneda injusta [2] [3] : Consideremos el problema de estimar la tasa de "éxito" de una variable binomial , . Esto puede verse como estimar la tasa a la que una moneda injusta cae en "cara" o "cruz". En este caso, el estimador de Bayes con respecto a una distribución previa Beta , es

con riesgo bayesiano constante

y, según el Corolario, es minimax.

Definición: Una secuencia de distribuciones previas se denomina menos favorable si para cualquier otra distribución ,

Teorema 2: Si existe una secuencia de valores anteriores y un estimador tal que , entonces :

Tenga en cuenta que aquí no se garantiza la unicidad. Por ejemplo, el estimador ML del ejemplo anterior puede obtenerse como el límite de los estimadores de Bayes con respecto a una distribución previa uniforme , con un apoyo creciente, y también con respecto a una distribución previa normal de media cero con una varianza creciente. Por lo tanto, ni el estimador ML resultante es un minimax único ni la distribución previa menos favorable es única.

Ejemplo 2: Considere el problema de estimar la media de un vector aleatorio gaussiano dimensional , . El estimador de máxima verosimilitud (ML) para en este caso es simplemente , y su riesgo es

El riesgo es constante, pero el estimador ML en realidad no es un estimador de Bayes, por lo que el Corolario del Teorema 1 no se aplica. Sin embargo, el estimador ML es el límite de los estimadores de Bayes con respecto a la secuencia anterior y, por lo tanto, de hecho minimax según el Teorema 2. No obstante, la minimaxidad no siempre implica admisibilidad . De hecho, en este ejemplo, se sabe que el estimador ML es inadmisible (no admisible) siempre que . El famoso estimador de James-Stein domina al ML siempre que . Aunque ambos estimadores tienen el mismo riesgo cuando , y ambos son minimax, el estimador de James-Stein tiene un riesgo menor para cualquier finito . Este hecho se ilustra en la siguiente figura.

En general, es difícil, y a menudo incluso imposible, determinar el estimador minimax. No obstante, en muchos casos se ha determinado un estimador minimax.

Ejemplo 3: Media normal acotada: Al estimar la media de un vector normal , donde se sabe que . Se sabe que el estimador de Bayes con respecto a una distribución previa uniforme en el borde de la esfera acotada es minimax siempre que . La expresión analítica para este estimador es

donde , es la función de Bessel modificada del primer tipo de orden n .

La dificultad de determinar el estimador minimax exacto ha motivado el estudio de estimadores de minimax asintóticos: un estimador se llama minimax asintótico (o aproximado) si

Para muchos problemas de estimación, especialmente en el contexto de la estimación no paramétrica, se han establecido varios estimadores minimax aproximados. El diseño del estimador minimax aproximado está íntimamente relacionado con la geometría, como el número de entropía métrica, de .

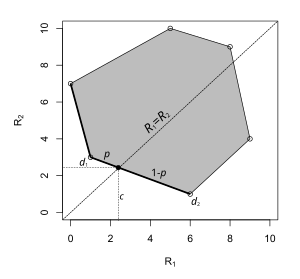

A veces, un estimador minimax puede adoptar la forma de una regla de decisión aleatoria . A la izquierda se muestra un ejemplo. El espacio de parámetros tiene solo dos elementos y cada punto del gráfico corresponde al riesgo de una regla de decisión: la coordenada x es el riesgo cuando el parámetro es y la coordenada y es el riesgo cuando el parámetro es . En este problema de decisión, el estimador minimax se encuentra en un segmento de línea que conecta dos estimadores deterministas. Elegir con probabilidad y con probabilidad minimiza el riesgo supremo.

La optimización robusta es un enfoque para resolver problemas de optimización bajo incertidumbre en el conocimiento de los parámetros subyacentes. [4] [5] Por ejemplo, la estimación bayesiana MMSE de un parámetro requiere el conocimiento de la función de correlación del parámetro. Si el conocimiento de esta función de correlación no está perfectamente disponible, un enfoque popular de optimización robusta minimax [6] es definir un conjunto que caracteriza la incertidumbre sobre la función de correlación y luego buscar una optimización minimax sobre el conjunto de incertidumbre y el estimador respectivamente. Se pueden buscar optimizaciones minimax similares para hacer que los estimadores sean robustos a ciertos parámetros conocidos de forma imprecisa. Por ejemplo, un estudio reciente que trata sobre tales técnicas en el área de procesamiento de señales se puede encontrar en. [7]

En R. Fandom Noubiap y W. Seidel (2001) se ha desarrollado un algoritmo para calcular una regla de decisión Gamma-minimax, cuando Gamma viene dada por un número finito de condiciones de momento generalizadas. Dicha regla de decisión minimiza el máximo de las integrales de la función de riesgo con respecto a todas las distribuciones en Gamma. Las reglas de decisión Gamma-minimax son de interés en los estudios de robustez en las estadísticas bayesianas.