Un rastreador web , a veces llamado araña o robot araña y a menudo abreviado como rastreador , es un robot de Internet que navega sistemáticamente por la World Wide Web y que generalmente es operado por motores de búsqueda con el propósito de indexar la Web ( arañas web ). [1]

Los motores de búsqueda web y otros sitios web utilizan software de rastreo web para actualizar su contenido web o los índices del contenido web de otros sitios. Los rastreadores web copian páginas para que un motor de búsqueda las procese, y este indexa las páginas descargadas para que los usuarios puedan buscar de forma más eficiente.

Los rastreadores consumen recursos de los sistemas visitados y, a menudo, visitan los sitios sin que se les solicite. Cuando se accede a grandes conjuntos de páginas, surgen problemas de programación, carga y "cortesía". Existen mecanismos para que los sitios públicos que no desean ser rastreados se lo hagan saber al agente de rastreo. Por ejemplo, incluir un robots.txtarchivo puede solicitar a los bots que indexen solo partes de un sitio web o nada en absoluto.

La cantidad de páginas de Internet es extremadamente grande; ni siquiera los rastreadores más grandes logran realizar un índice completo. Por este motivo, los motores de búsqueda tuvieron dificultades para ofrecer resultados de búsqueda relevantes en los primeros años de la World Wide Web, antes del año 2000. Hoy, los resultados relevantes se ofrecen casi instantáneamente.

Los rastreadores pueden validar hipervínculos y código HTML . También se pueden utilizar para extraer datos de la web y para la programación basada en datos .

Un rastreador web también se conoce como araña , [2] hormiga , indexador automático , [3] o (en el contexto del software FOAF ) rastreador web . [4 ]

Un rastreador web comienza con una lista de URL para visitar. Esas primeras URL se denominan semillas . A medida que el rastreador visita estas URL, al comunicarse con los servidores web que responden a esas URL, identifica todos los hipervínculos en las páginas web recuperadas y los agrega a la lista de URL para visitar, llamada frontera de rastreo . Las URL de la frontera se visitan de forma recursiva de acuerdo con un conjunto de políticas. Si el rastreador está realizando el archivado de sitios web (o archivado web ), copia y guarda la información a medida que avanza. Los archivos generalmente se almacenan de tal manera que se puedan ver, leer y navegar como si estuvieran en la web en vivo, pero se conservan como "instantáneas". [5]

El archivo se conoce como repositorio y está diseñado para almacenar y administrar la colección de páginas web . El repositorio solo almacena páginas HTML y estas páginas se almacenan como archivos distintos. Un repositorio es similar a cualquier otro sistema que almacena datos, como una base de datos moderna. La única diferencia es que un repositorio no necesita toda la funcionalidad que ofrece un sistema de base de datos. El repositorio almacena la versión más reciente de la página web recuperada por el rastreador. [ cita requerida ]

El gran volumen implica que el rastreador solo puede descargar una cantidad limitada de páginas web en un tiempo determinado, por lo que necesita priorizar sus descargas. La alta tasa de cambio puede implicar que las páginas ya se hayan actualizado o incluso eliminado.

La cantidad de URL posibles que genera el software del lado del servidor también ha dificultado que los rastreadores web eviten recuperar contenido duplicado . Existen infinitas combinaciones de parámetros HTTP GET (basados en URL), de las cuales solo una pequeña selección realmente devolverá contenido único. Por ejemplo, una simple galería de fotos en línea puede ofrecer tres opciones a los usuarios, según se especifique a través de parámetros HTTP GET en la URL. Si existen cuatro formas de ordenar las imágenes, tres opciones de tamaño de miniatura , dos formatos de archivo y una opción para deshabilitar el contenido proporcionado por el usuario, entonces se puede acceder al mismo conjunto de contenido con 48 URL diferentes, todas las cuales pueden estar vinculadas en el sitio. Esta combinación matemática crea un problema para los rastreadores, ya que deben clasificar infinitas combinaciones de cambios de script relativamente menores para recuperar contenido único.

Como señalaron Edwards et al. , "Dado que el ancho de banda para realizar rastreos no es infinito ni gratuito, resulta esencial rastrear la Web no solo de manera escalable, sino también eficiente, si se desea mantener algún nivel razonable de calidad o frescura". [6] Un rastreador debe elegir cuidadosamente en cada paso qué páginas visitar a continuación.

El comportamiento de un rastreador web es el resultado de una combinación de políticas: [7]

Dado el tamaño actual de la Web, incluso los grandes motores de búsqueda cubren sólo una parte de la parte disponible públicamente. Un estudio de 2009 mostró que incluso los motores de búsqueda a gran escala indexan no más del 40-70% de la Web indexable; [8] un estudio previo de Steve Lawrence y Lee Giles mostró que ningún motor de búsqueda indexó más del 16% de la Web en 1999. [9] Como un rastreador siempre descarga sólo una fracción de las páginas Web , es muy deseable que la fracción descargada contenga las páginas más relevantes y no sólo una muestra aleatoria de la Web.

Esto requiere una métrica de importancia para priorizar las páginas Web. La importancia de una página es función de su calidad intrínseca , de su popularidad en términos de enlaces o visitas, e incluso de su URL (este último es el caso de los buscadores verticales restringidos a un único dominio de nivel superior , o de los buscadores restringidos a un sitio Web fijo). Diseñar una buena política de selección tiene una dificultad añadida: debe trabajar con información parcial, ya que durante el rastreo no se conoce el conjunto completo de páginas Web.

Junghoo Cho et al. realizaron el primer estudio sobre políticas para la programación de rastreo. Su conjunto de datos fue un rastreo de 180.000 páginas del stanford.edudominio, en el que se realizó una simulación de rastreo con diferentes estrategias. [10] Las métricas de ordenación probadas fueron la amplitud , el recuento de backlinks y los cálculos parciales de PageRank . Una de las conclusiones fue que si el rastreador quiere descargar páginas con un PageRank alto al principio del proceso de rastreo, entonces la estrategia de PageRank parcial es la mejor, seguida de la amplitud y el recuento de backlinks. Sin embargo, estos resultados son solo para un único dominio. Cho también escribió su tesis doctoral en Stanford sobre rastreo web. [11]

Najork y Wiener realizaron un rastreo real de 328 millones de páginas, utilizando el ordenamiento en amplitud. [12] Descubrieron que un rastreo en amplitud captura páginas con un Pagerank alto al principio del rastreo (pero no compararon esta estrategia con otras estrategias). La explicación que dan los autores para este resultado es que "las páginas más importantes tienen muchos enlaces a ellas desde numerosos hosts, y esos enlaces se encontrarán al principio, independientemente de en qué host o página se origine el rastreo".

Abiteboul diseñó una estrategia de rastreo basada en un algoritmo llamado OPIC (On-line Page Importance Computation). [13] En OPIC, a cada página se le asigna una suma inicial de "dinero" que se distribuye equitativamente entre las páginas a las que apunta. Es similar a un cálculo de PageRank, pero es más rápido y se realiza en un solo paso. Un rastreador impulsado por OPIC descarga primero las páginas en la frontera de rastreo con mayores cantidades de "dinero". Los experimentos se llevaron a cabo en un gráfico sintético de 100.000 páginas con una distribución de ley de potencia de enlaces entrantes. Sin embargo, no se realizó ninguna comparación con otras estrategias ni experimentos en la Web real.

Boldi et al. utilizaron una simulación en subconjuntos de la Web de 40 millones de páginas del .itdominio y 100 millones de páginas del rastreo de WebBase, probando la estrategia de amplitud frente a la de profundidad, ordenación aleatoria y omnisciencia. La comparación se basó en la precisión con la que el PageRank calculado en un rastreo parcial se aproxima al valor real del PageRank. Algunas visitas que acumulan PageRank muy rápidamente (sobre todo, la visita de amplitud y la omnisciente) proporcionan aproximaciones progresivas muy deficientes. [14] [15]

Baeza-Yates et al. utilizaron la simulación en dos subconjuntos de la Web de 3 millones de páginas del dominio .gry , probando varias estrategias de rastreo. [16] Demostraron que tanto la estrategia OPIC como una estrategia que utiliza la longitud de las colas por sitio son mejores que el rastreo en amplitud , y que también es muy efectivo utilizar un rastreo anterior, cuando está disponible, para guiar el actual..cl

Daneshpajouh et al. diseñaron un algoritmo basado en la comunidad para descubrir buenas semillas. [17] Su método rastrea páginas web con alto PageRank de diferentes comunidades en menos iteraciones en comparación con el rastreo a partir de semillas aleatorias. Se puede extraer una buena semilla de un gráfico web rastreado previamente utilizando este nuevo método. Con estas semillas, un nuevo rastreo puede ser muy efectivo.

Es posible que un rastreador solo desee buscar páginas HTML y evitar todos los demás tipos MIME . Para solicitar solo recursos HTML, un rastreador puede realizar una solicitud HEAD HTTP para determinar el tipo MIME de un recurso web antes de solicitar el recurso completo con una solicitud GET. Para evitar realizar numerosas solicitudes HEAD, un rastreador puede examinar la URL y solo solicitar un recurso si la URL termina con ciertos caracteres como .html, .htm, .asp, .aspx, .php, .jsp, .jspx o una barra. Esta estrategia puede provocar que se omitan involuntariamente numerosos recursos web HTML.

Algunos rastreadores también pueden evitar solicitar recursos que tengan un "?" (se generan dinámicamente) para evitar trampas de arañas que pueden hacer que el rastreador descargue una cantidad infinita de URL de un sitio web. Esta estrategia no es confiable si el sitio utiliza la reescritura de URL para simplificarlas.

Los rastreadores suelen realizar algún tipo de normalización de URL para evitar rastrear el mismo recurso más de una vez. El término normalización de URL , también llamado canonización de URL , se refiere al proceso de modificar y estandarizar una URL de manera consistente. Existen varios tipos de normalización que se pueden realizar, incluida la conversión de URL a minúsculas, la eliminación de los segmentos "." y ".." y la adición de barras diagonales finales al componente de ruta no vacío. [18]

Algunos rastreadores intentan descargar o cargar tantos recursos como sea posible de un sitio web en particular. Por eso, se introdujo un rastreador de ruta ascendente que ascendería a cada ruta en cada URL que pretenda rastrear. [19] Por ejemplo, cuando se le da una URL de semilla de http://llama.org/hamster/monkey/page.html, intentará rastrear /hamster/monkey/, /hamster/ y /. Cothey descubrió que un rastreador de ruta ascendente era muy eficaz para encontrar recursos aislados o recursos para los que no se habría encontrado ningún enlace entrante en un rastreo normal.

La importancia de una página para un rastreador también se puede expresar como una función de la similitud de una página con una consulta dada. Los rastreadores web que intentan descargar páginas que son similares entre sí se denominan rastreadores enfocados o rastreadores temáticos . Los conceptos de rastreo temático y enfocado fueron introducidos por primera vez por Filippo Menczer [20] [21] y por Soumen Chakrabarti et al. [22] .

El principal problema del rastreo enfocado es que, en el contexto de un rastreador web, nos gustaría poder predecir la similitud del texto de una página dada con la consulta antes de descargar la página. Un posible predictor es el texto de anclaje de los enlaces; este fue el enfoque adoptado por Pinkerton [23] en el primer rastreador web de los primeros días de la Web. Diligenti et al. [24] proponen utilizar el contenido completo de las páginas ya visitadas para inferir la similitud entre la consulta principal y las páginas que aún no se han visitado. El rendimiento de un rastreo enfocado depende principalmente de la riqueza de los enlaces en el tema específico que se está buscando, y un rastreo enfocado generalmente se basa en un motor de búsqueda web general para proporcionar puntos de partida.

Un ejemplo de los rastreadores enfocados son los rastreadores académicos, que rastrean documentos académicos de libre acceso relacionados, como citeseerxbot , que es el rastreador del motor de búsqueda CiteSeer X. Otros motores de búsqueda académicos son Google Scholar y Microsoft Academic Search , etc. Debido a que la mayoría de los artículos académicos se publican en formatos PDF , este tipo de rastreador está particularmente interesado en rastrear archivos PDF, PostScript , Microsoft Word, incluidos sus formatos comprimidos . Debido a esto, los rastreadores generales de código abierto, como Heritrix , deben personalizarse para filtrar otros tipos MIME , o se utiliza un middleware para extraer estos documentos e importarlos a la base de datos y repositorio de rastreo enfocados. [25] Identificar si estos documentos son académicos o no es un desafío y puede agregar una sobrecarga significativa al proceso de rastreo, por lo que esto se realiza como un proceso de rastreo posterior utilizando aprendizaje automático o algoritmos de expresión regular . Estos documentos académicos generalmente se obtienen de las páginas de inicio de facultades y estudiantes o de la página de publicación de institutos de investigación. Dado que los documentos académicos representan solo una pequeña fracción de todas las páginas web, una buena selección de fuentes es importante para aumentar la eficiencia de estos rastreadores web. [26] Otros rastreadores académicos pueden descargar archivos de texto sin formato y HTML que contienen metadatos de documentos académicos, como títulos, artículos y resúmenes. Esto aumenta la cantidad total de artículos, pero es posible que una fracción significativa no proporcione descargas gratuitas en formato PDF.

Otro tipo de rastreadores enfocados es el rastreador enfocado semántico, que hace uso de ontologías de dominio para representar mapas temáticos y vincular páginas web con conceptos ontológicos relevantes para fines de selección y categorización. [27] Además, las ontologías se pueden actualizar automáticamente en el proceso de rastreo. Dong et al. [28] presentó un rastreador basado en aprendizaje de ontologías que utiliza una máquina de vectores de soporte para actualizar el contenido de conceptos ontológicos al rastrear páginas web.

La Web tiene una naturaleza muy dinámica y rastrear una fracción de ella puede llevar semanas o meses. Para cuando un rastreador web haya terminado su rastreo, pueden haber ocurrido muchos eventos, incluidas creaciones, actualizaciones y eliminaciones.

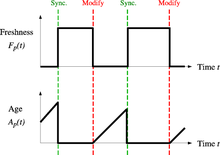

Desde el punto de vista del motor de búsqueda, existe un costo asociado a no detectar un evento y, por lo tanto, tener una copia desactualizada de un recurso. Las funciones de costo más utilizadas son la frescura y la antigüedad. [29]

Frescura : es una medida binaria que indica si la copia local es exacta o no. La frescura de una página p en el repositorio en el momento t se define como:

Antigüedad : es una medida que indica qué tan desactualizada está la copia local. La antigüedad de una página p en el repositorio, en el momento t, se define como:

Coffman et al. trabajaron con una definición del objetivo de un rastreador web que es equivalente a la frescura, pero utilizan una redacción diferente: proponen que un rastreador debe minimizar la fracción de tiempo que las páginas permanecen obsoletas. También observaron que el problema del rastreo web se puede modelar como un sistema de sondeo de múltiples colas y un solo servidor, en el que el rastreador web es el servidor y los sitios web son las colas. Las modificaciones de página son la llegada de los clientes y los tiempos de cambio son el intervalo entre los accesos a la página de un solo sitio web. Según este modelo, el tiempo de espera medio de un cliente en el sistema de sondeo es equivalente a la edad promedio del rastreador web. [30]

El objetivo del rastreador es mantener la frescura promedio de las páginas de su colección lo más alta posible, o mantener la antigüedad promedio de las páginas lo más baja posible. Estos objetivos no son equivalentes: en el primer caso, el rastreador solo se preocupa por cuántas páginas están desactualizadas, mientras que en el segundo caso, el rastreador se preocupa por la antigüedad de las copias locales de las páginas.

Cho y García-Molina estudiaron dos políticas simples de revisión: [31]

En ambos casos, el orden de rastreo repetido de páginas se puede realizar en un orden aleatorio o fijo.

Cho y García-Molina demostraron el sorprendente resultado de que, en términos de frescura promedio, la política uniforme supera a la política proporcional tanto en una simulación de rastreo de la Web como en un rastreo de la Web real. Intuitivamente, el razonamiento es que, como los rastreadores web tienen un límite en la cantidad de páginas que pueden rastrear en un período de tiempo determinado, (1) asignarán demasiados rastreos nuevos a páginas que cambian rápidamente a expensas de páginas que se actualizan con menor frecuencia, y (2) la frescura de las páginas que cambian rápidamente dura un período más corto que la de las páginas que cambian con menor frecuencia. En otras palabras, una política proporcional asigna más recursos al rastreo de páginas que se actualizan con frecuencia, pero experimenta menos tiempo de frescura general de ellas.

Para mejorar la frescura, el rastreador debe penalizar los elementos que cambian con demasiada frecuencia. [32] La política óptima de revisitas no es ni la política uniforme ni la política proporcional. El método óptimo para mantener alta la frescura promedio incluye ignorar las páginas que cambian con demasiada frecuencia, y el óptimo para mantener baja la edad promedio es usar frecuencias de acceso que aumenten monótonamente (y sublinealmente) con la tasa de cambio de cada página. En ambos casos, lo óptimo está más cerca de la política uniforme que de la política proporcional: como Coffman et al. señalan, "para minimizar el tiempo de obsolescencia esperado, los accesos a cualquier página en particular deben mantenerse tan espaciados uniformemente como sea posible". [30] Las fórmulas explícitas para la política de revisitas no son alcanzables en general, pero se obtienen numéricamente, ya que dependen de la distribución de los cambios de página. Cho y García-Molina muestran que la distribución exponencial es una buena opción para describir los cambios de página, [32] mientras que Ipeirotis et al. muestran cómo usar herramientas estadísticas para descubrir parámetros que afectan a esta distribución. [33] Las políticas de revisita consideradas aquí consideran todas las páginas como homogéneas en términos de calidad ("todas las páginas de la Web valen lo mismo"), algo que no es un escenario realista, por lo que se debería incluir más información sobre la calidad de la página Web para lograr una mejor política de rastreo.

Los rastreadores pueden recuperar datos mucho más rápido y con mayor profundidad que los buscadores humanos, por lo que pueden tener un impacto devastador en el rendimiento de un sitio. Si un solo rastreador realiza varias solicitudes por segundo o descarga archivos grandes, un servidor puede tener dificultades para responder a las solicitudes de varios rastreadores.

Como señaló Koster, el uso de rastreadores web es útil para diversas tareas, pero tiene un precio para la comunidad en general. [34] Los costos de usar rastreadores web incluyen:

Una solución parcial a estos problemas es el protocolo de exclusión de robots , también conocido como protocolo robots.txt, que es un estándar para que los administradores indiquen a qué partes de sus servidores web no deben acceder los rastreadores. [35] Este estándar no incluye una sugerencia para el intervalo de visitas al mismo servidor, aunque este intervalo es la forma más efectiva de evitar la sobrecarga del servidor. Recientemente, los motores de búsqueda comerciales como Google , Ask Jeeves , MSN y Yahoo! Search pueden usar un parámetro adicional "Crawl-delay:" en el archivo robots.txt para indicar el número de segundos de retraso entre solicitudes.

El primer intervalo propuesto entre cargas de páginas sucesivas fue de 60 segundos. [36] Sin embargo, si se descargaran páginas a este ritmo desde un sitio web con más de 100.000 páginas a través de una conexión perfecta con latencia cero y ancho de banda infinito, se necesitarían más de dos meses para descargar solo ese sitio web completo; además, solo se utilizaría una fracción de los recursos de ese servidor web.

Cho utiliza 10 segundos como intervalo de acceso, [31] y el rastreador WIRE utiliza 15 segundos como valor predeterminado. [37] El rastreador MercatorWeb sigue una política de cortesía adaptativa: si tomó t segundos descargar un documento de un servidor determinado, el rastreador espera 10 t segundos antes de descargar la página siguiente. [38] Dill et al. utilizan 1 segundo. [39]

Para quienes utilizan rastreadores web con fines de investigación, se necesita un análisis costo-beneficio más detallado y se deben tener en cuenta consideraciones éticas al decidir dónde rastrear y con qué velocidad hacerlo. [40]

La evidencia anecdótica de los registros de acceso muestra que los intervalos de acceso de los rastreadores conocidos varían entre 20 segundos y 3-4 minutos. Vale la pena notar que incluso cuando se es muy educado y se toman todas las precauciones para evitar sobrecargar los servidores web, se reciben algunas quejas de los administradores de servidores web. Sergey Brin y Larry Page señalaron en 1998 que "... ejecutar un rastreador que se conecta a más de medio millón de servidores... genera una cantidad considerable de correos electrónicos y llamadas telefónicas. Debido a la gran cantidad de personas que se conectan a Internet, siempre hay quienes no saben qué es un rastreador, porque es el primero que ven". [41]

Un rastreador paralelo es un rastreador que ejecuta varios procesos en paralelo. El objetivo es maximizar la velocidad de descarga mientras se minimiza la sobrecarga de la paralelización y evitar descargas repetidas de la misma página. Para evitar descargar la misma página más de una vez, el sistema de rastreo requiere una política para asignar las nuevas URL descubiertas durante el proceso de rastreo, ya que dos procesos de rastreo diferentes pueden encontrar la misma URL.

Un rastreador no solo debe tener una buena estrategia de rastreo, como se señaló en las secciones anteriores, sino que también debe tener una arquitectura altamente optimizada.

Shkapenyuk y Suel señalaron que: [42]

Si bien es bastante fácil construir un rastreador lento que descargue unas pocas páginas por segundo durante un corto período de tiempo, construir un sistema de alto rendimiento que pueda descargar cientos de millones de páginas durante varias semanas presenta una serie de desafíos en el diseño del sistema, la eficiencia de E/S y de la red, y la robustez y la capacidad de administración.

Los rastreadores web son una parte central de los motores de búsqueda y los detalles sobre sus algoritmos y arquitectura se mantienen como secretos comerciales. Cuando se publican los diseños de los rastreadores, a menudo hay una falta importante de detalles que impide que otros reproduzcan el trabajo. También están surgiendo preocupaciones sobre el " spam de los motores de búsqueda ", que impide que los principales motores de búsqueda publiquen sus algoritmos de clasificación.

Si bien la mayoría de los propietarios de sitios web desean que sus páginas estén indexadas lo más ampliamente posible para tener una fuerte presencia en los motores de búsqueda , el rastreo web también puede tener consecuencias no deseadas y provocar una vulneración o violación de datos si un motor de búsqueda indexa recursos que no deberían estar disponibles públicamente o páginas que revelan versiones de software potencialmente vulnerables.

Además de las recomendaciones de seguridad de aplicaciones web estándar , los propietarios de sitios web pueden reducir su exposición a ataques oportunistas permitiendo que los motores de búsqueda indexen únicamente las partes públicas de sus sitios web (con robots.txt ) y bloqueándolos explícitamente para que no indexen las partes transaccionales (páginas de inicio de sesión, páginas privadas, etc.).

Los rastreadores web suelen identificarse ante un servidor web mediante el campo User-agent de una solicitud HTTP . Los administradores de sitios web suelen examinar el registro de sus servidores web y utilizan el campo User-agent para determinar qué rastreadores han visitado el servidor web y con qué frecuencia. El campo User-agent puede incluir una URL en la que el administrador del sitio web puede encontrar más información sobre el rastreador. Examinar el registro del servidor web es una tarea tediosa y, por lo tanto, algunos administradores utilizan herramientas para identificar, rastrear y verificar los rastreadores web. Es poco probable que los robots de spam y otros rastreadores web maliciosos coloquen información de identificación en el campo User-agent, o pueden enmascarar su identidad como un navegador u otro rastreador conocido.

Los administradores de sitios web prefieren que los rastreadores web se identifiquen para poder contactar al propietario si es necesario. En algunos casos, los rastreadores pueden quedar atrapados accidentalmente en una trampa de rastreo o pueden estar sobrecargando un servidor web con solicitudes y el propietario necesita detener el rastreador. La identificación también es útil para los administradores que están interesados en saber cuándo pueden esperar que un motor de búsqueda en particular indexe sus páginas web .

Una gran cantidad de páginas web se encuentran en la web profunda o invisible . [43] Por lo general, solo se puede acceder a estas páginas enviando consultas a una base de datos, y los rastreadores regulares no pueden encontrarlas si no hay enlaces que apunten a ellas. El protocolo Sitemaps de Google y el mod oai [44] tienen como objetivo permitir el descubrimiento de estos recursos de la web profunda .

El rastreo profundo de la web también multiplica la cantidad de enlaces web que se deben rastrear. Algunos rastreadores solo toman algunas de las URL en <a href="URL">formato. En algunos casos, como el de Googlebot , el rastreo web se realiza en todo el texto incluido en el contenido de hipertexto, las etiquetas o el texto.

Se pueden adoptar enfoques estratégicos para identificar el contenido de la Deep Web. Con una técnica llamada screen scraping , se puede personalizar un software especializado para consultar de forma automática y repetida un formulario web determinado con la intención de agregar los datos resultantes. Este software se puede utilizar para abarcar varios formularios web en varios sitios web. Los datos extraídos de los resultados del envío de un formulario web se pueden tomar y aplicar como entrada a otro formulario web, estableciendo así una continuidad en la Deep Web de una manera que no es posible con los rastreadores web tradicionales. [45]

Las páginas creadas con AJAX son algunas de las que causan problemas a los rastreadores web. Google ha propuesto un formato de llamadas AJAX que su robot puede reconocer e indexar. [46]

Hay una serie de productos de "rastreadores/extractores web visuales" disponibles en la web que rastrean páginas y estructuran datos en columnas y filas según los requisitos de los usuarios. Una de las principales diferencias entre un rastreador clásico y uno visual es el nivel de habilidad de programación necesario para configurar un rastreador. La última generación de "rastreadores visuales" elimina la mayor parte de la habilidad de programación necesaria para poder programar e iniciar un rastreo para extraer datos web.

El método de rastreo visual se basa en que el usuario "enseñe" una parte de la tecnología del rastreador, que luego sigue patrones en fuentes de datos semiestructurados. El método dominante para enseñar a un rastreador visual es resaltar datos en un navegador y entrenar columnas y filas. Si bien la tecnología no es nueva, por ejemplo, fue la base de Needlebase, que fue comprada por Google (como parte de una adquisición más grande de ITA Labs [47] ), existe un crecimiento continuo y una inversión en esta área por parte de inversores y usuarios finales. [ cita requerida ]

A continuación se incluye una lista de arquitecturas de rastreadores publicadas para rastreadores de propósito general (excluidos los rastreadores web específicos), con una breve descripción que incluye los nombres dados a los diferentes componentes y las características destacadas:

Los siguientes rastreadores web están disponibles por un precio:

{{cite book}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: Requiere citar revista |journal=( ayuda ){{cite journal}}: Requiere citar revista |journal=( ayuda )