Un sensor de imagen o generador de imágenes es un sensor que detecta y transmite información utilizada para formar una imagen . Lo hace convirtiendo la atenuación variable de las ondas de luz (cuando pasan a través de los objetos o se reflejan en ellos ) en señales , pequeñas ráfagas de corriente que transmiten la información. Las ondas pueden ser luz u otra radiación electromagnética . Los sensores de imagen se utilizan en dispositivos de imágenes electrónicas de tipo analógico y digital , que incluyen cámaras digitales , módulos de cámara , teléfonos con cámara , dispositivos de ratón óptico , [1] [2] [3] equipos de imágenes médicas , equipos de visión nocturna como dispositivos de imágenes térmicas , radares , sonares y otros. A medida que la tecnología cambia , las imágenes electrónicas y digitales tienden a reemplazar las imágenes químicas y analógicas.

Los dos tipos principales de sensores electrónicos de imagen son el dispositivo acoplado por carga (CCD) y el sensor de píxeles activos ( sensor CMOS ). Tanto los sensores CCD como los CMOS se basan en tecnología de semiconductores de óxido metálico (MOS), con CCD basados en condensadores MOS y sensores CMOS basados en amplificadores MOSFET (transistor de efecto de campo MOS) . Los sensores analógicos para radiación invisible tienden a involucrar tubos de vacío de varios tipos, mientras que los sensores digitales incluyen detectores de panel plano .

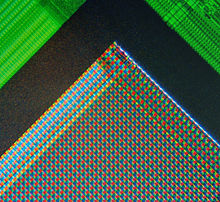

Los dos tipos principales de sensores de imagen digital son el dispositivo acoplado por carga (CCD) y el sensor de píxeles activos (sensor CMOS), fabricados en tecnologías complementarias MOS (CMOS) o MOS de tipo N ( NMOS o Live MOS ). Tanto los sensores CCD como los CMOS se basan en la tecnología MOS , [4] siendo los condensadores MOS los componentes básicos de un CCD, [5] y los amplificadores MOSFET los componentes básicos de un sensor CMOS. [6] [7]

Las cámaras integradas en productos de consumo pequeños suelen utilizar sensores CMOS, que suelen ser más baratos y consumir menos energía en dispositivos alimentados por batería que los CCD. [8] Los sensores CCD se utilizan para cámaras de vídeo de alta calidad para retransmisiones, y los sensores CMOS predominan en la fotografía fija y los bienes de consumo, donde el coste total es una preocupación importante. Ambos tipos de sensores realizan la misma tarea de capturar la luz y convertirla en señales eléctricas.

Cada celda de un sensor de imagen CCD es un dispositivo analógico. Cuando la luz llega al chip, se retiene como una pequeña carga eléctrica en cada fotosensor . Las cargas en la línea de píxeles más cercana a los (uno o más) amplificadores de salida se amplifican y se emiten, luego cada línea de píxeles desplaza sus cargas una línea más cerca de los amplificadores, llenando la línea vacía más cercana a los amplificadores. Este proceso se repite hasta que todas las líneas de píxeles hayan tenido su carga amplificada y emitida. [9]

Un sensor de imagen CMOS tiene un amplificador para cada píxel en comparación con los pocos amplificadores de un CCD. Esto da como resultado una menor área para la captura de fotones que un CCD, pero este problema se ha superado mediante el uso de microlentes delante de cada fotodiodo, que enfocan la luz en el fotodiodo que, de lo contrario, habría llegado al amplificador y no se habría detectado. [9] Algunos sensores de imagen CMOS también utilizan iluminación posterior para aumentar la cantidad de fotones que llegan al fotodiodo. [10] Los sensores CMOS pueden implementarse potencialmente con menos componentes, utilizar menos energía y/o proporcionar una lectura más rápida que los sensores CCD. [11] También son menos vulnerables a las descargas de electricidad estática.

Otro diseño, una arquitectura híbrida CCD/CMOS (vendida bajo el nombre de " sCMOS ") consiste en circuitos integrados de lectura CMOS (ROIC) que están unidos por una unión por impacto a un sustrato de imágenes CCD, una tecnología que fue desarrollada para matrices de observación infrarrojas y ha sido adaptada a la tecnología de detectores basados en silicio. [12] Otro enfoque es utilizar las dimensiones muy finas disponibles en la tecnología CMOS moderna para implementar una estructura similar a CCD completamente en tecnología CMOS: tales estructuras se pueden lograr separando las puertas de polisilicio individuales por un espacio muy pequeño; aunque todavía es un producto de investigación, los sensores híbridos pueden aprovechar potencialmente los beneficios de los generadores de imágenes CCD y CMOS. [13]

Existen muchos parámetros que se pueden utilizar para evaluar el rendimiento de un sensor de imagen, incluidos el rango dinámico , la relación señal-ruido y la sensibilidad a la poca luz. En el caso de sensores de tipos comparables, la relación señal-ruido y el rango dinámico mejoran a medida que aumenta el tamaño . Esto se debe a que en un tiempo de integración (exposición) determinado, más fotones inciden en el píxel con un área más grande.

El tiempo de exposición de los sensores de imagen generalmente se controla mediante un obturador mecánico convencional , como en las cámaras de película, o mediante un obturador electrónico . El obturador electrónico puede ser "global", en cuyo caso la acumulación de fotoelectrones de toda el área del sensor de imagen comienza y se detiene simultáneamente, o "rodante", en cuyo caso el intervalo de exposición de cada fila inmediatamente precede a la lectura de esa fila, en un proceso que "rueda" a lo largo del marco de la imagen (normalmente de arriba a abajo en formato horizontal). El obturador electrónico global es menos común, ya que requiere circuitos de "almacenamiento" para mantener la carga desde el final del intervalo de exposición hasta que llega el proceso de lectura, normalmente unos pocos milisegundos después. [14]

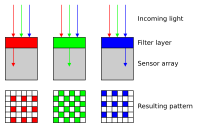

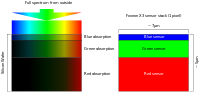

Existen varios tipos principales de sensores de imagen en color, que se diferencian por el tipo de mecanismo de separación de colores:

Se utilizan sensores especiales en diversas aplicaciones, como la creación de imágenes multiespectrales , videolaringoscopios , cámaras gamma , detectores de panel plano y otros conjuntos de sensores para rayos X , conjuntos de microbolómetros en termografía y otros conjuntos de alta sensibilidad para astronomía . [20]

Si bien, en general, las cámaras digitales utilizan un sensor plano, Sony diseñó un prototipo de sensor curvo en 2014 para reducir o eliminar la curvatura del campo de Petzval que se produce con un sensor plano. El uso de un sensor curvo permite un diámetro de lente más corto y más pequeño con elementos y componentes reducidos con mayor apertura y menor pérdida de luz en el borde de la foto. [21]

Los primeros sensores analógicos de luz visible fueron los tubos de las cámaras de vídeo . Datan de la década de 1930 y se desarrollaron varios tipos hasta la década de 1980. A principios de la década de 1990, fueron reemplazados por los modernos sensores de imagen CCD de estado sólido . [22]

La base de los sensores de imagen de estado sólido modernos es la tecnología MOS, [23] [24] que se origina a partir de la invención del MOSFET por Mohamed M. Atalla y Dawon Kahng en Bell Labs en 1959. [25] Investigaciones posteriores sobre la tecnología MOS condujeron al desarrollo de sensores de imagen de semiconductores de estado sólido , incluido el dispositivo acoplado a carga (CCD) y más tarde el sensor de píxeles activos ( sensor CMOS ). [23] [24]

El sensor de píxeles pasivos (PPS) fue el precursor del sensor de píxeles activos (APS). [7] Un PPS consta de píxeles pasivos que se leen sin amplificación , y cada píxel consta de un fotodiodo y un interruptor MOSFET . [26] Es un tipo de matriz de fotodiodos , con píxeles que contienen una unión pn , un condensador integrado y MOSFET como transistores de selección . G. Weckler propuso una matriz de fotodiodos en 1968. [6] Esta fue la base del PPS. [7] Estas primeras matrices de fotodiodos eran complejas y poco prácticas, y requerían que se fabricaran transistores de selección dentro de cada píxel, junto con circuitos multiplexores en chip . El ruido de las matrices de fotodiodos también era una limitación para el rendimiento, ya que la capacitancia del bus de lectura de fotodiodos daba como resultado un mayor nivel de ruido. El muestreo doble correlacionado (CDS) tampoco se podía utilizar con una matriz de fotodiodos sin memoria externa . [6] Sin embargo, en 1914 el Cónsul General Adjunto Carl R. Loop informó al Departamento de Estado en un Informe Consular sobre el sistema Televista de Archibald M. Low que "se afirma que el selenio en la pantalla de transmisión puede ser reemplazado por cualquier material diamagnético ". [27]

En junio de 2022, Samsung Electronics anunció que había creado un sensor de imagen de 200 millones de píxeles. El ISOCELL HP3 de 200 MP tiene píxeles de 0,56 micrómetros y Samsung informó que los sensores anteriores tenían píxeles de 0,64 micrómetros, una disminución del 12 % desde 2019. El nuevo sensor contiene 200 millones de píxeles en una lente de 1 x 1,4 pulgadas (25 x 36 mm). [28]

El dispositivo de carga acoplada (CCD) fue inventado por Willard S. Boyle y George E. Smith en Bell Labs en 1969. [29] Mientras investigaban la tecnología MOS, se dieron cuenta de que una carga eléctrica era la analogía de la burbuja magnética y que podía almacenarse en un pequeño condensador MOS . Como era bastante sencillo fabricar una serie de condensadores MOS en fila, les conectaron un voltaje adecuado para que la carga pudiera pasar de uno al siguiente. [23] El CCD es un circuito semiconductor que luego se utilizó en las primeras cámaras de video digitales para transmisión televisiva . [30]

Los primeros sensores CCD sufrían de un retardo de obturación . Esto se resolvió en gran medida con la invención del fotodiodo pinned (PPD). [7] Fue inventado por Nobukazu Teranishi , Hiromitsu Shiraki y Yasuo Ishihara en NEC en 1980. [7] [31] Era una estructura de fotodetector con bajo retardo, bajo ruido , alta eficiencia cuántica y baja corriente oscura . [7] En 1987, el PPD comenzó a incorporarse en la mayoría de los dispositivos CCD, convirtiéndose en un elemento fijo en las cámaras de vídeo electrónicas de consumo y luego en las cámaras fotográficas digitales . Desde entonces, el PPD se ha utilizado en casi todos los sensores CCD y luego en los sensores CMOS. [7]

El sensor de píxeles activos NMOS (APS) fue inventado por Olympus en Japón a mediados de la década de 1980. Esto fue posible gracias a los avances en la fabricación de dispositivos semiconductores MOS , con el escalado MOSFET alcanzando niveles de micrones más pequeños y luego submicrones . [6] [32] El primer APS NMOS fue fabricado por el equipo de Tsutomu Nakamura en Olympus en 1985. [33] El sensor de píxeles activos CMOS (sensor CMOS) fue mejorado posteriormente por un grupo de científicos del Laboratorio de Propulsión a Chorro de la NASA en 1993. [7] Para 2007, las ventas de sensores CMOS habían superado a los sensores CCD. [34] Para la década de 2010, los sensores CMOS desplazaron en gran medida a los sensores CCD en todas las aplicaciones nuevas.

La primera cámara digital comercial , la Cromemco Cyclops de 1975, utilizaba un sensor de imagen MOS de 32×32. Se trataba de un chip de memoria RAM dinámica ( DRAM ) MOS modificado . [35]

Los sensores de imagen MOS se utilizan ampliamente en la tecnología de ratones ópticos . El primer ratón óptico, inventado por Richard F. Lyon en Xerox en 1980, utilizaba un chip sensor de circuito integrado NMOS de 5 μm . [2] [1] Desde el primer ratón óptico comercial, el IntelliMouse presentado en 1999, la mayoría de los dispositivos de ratón óptico utilizan sensores CMOS. [36]

En febrero de 2018, los investigadores del Dartmouth College anunciaron una nueva tecnología de detección de imágenes que los investigadores denominan QIS (sensor de imagen cuántica). En lugar de píxeles, los chips QIS tienen lo que los investigadores denominan "puntos". Cada punto puede detectar una única partícula de luz, llamada fotón . [37]

{{cite news}}: |first=tiene nombre genérico ( ayuda )La Cyclops fue la primera cámara digital