Una prueba F es cualquier prueba estadística utilizada para comparar las varianzas de dos muestras o la relación de varianzas entre varias muestras. El estadístico de prueba , variable aleatoria F, se utiliza para determinar si los datos probados tienen una distribución F bajo la hipótesis nula verdadera y los supuestos habituales verdaderos sobre el término de error (ε). [1] Se utiliza con mayor frecuencia al comparar modelos estadísticos que se han ajustado a un conjunto de datos , para identificar el modelo que mejor se adapta a la población de la que se tomaron muestras de los datos. Las "pruebas F " exactas surgen principalmente cuando los modelos se han ajustado a los datos utilizando mínimos cuadrados . El nombre fue acuñado por George W. Snedecor , en honor a Ronald Fisher . Fisher desarrolló inicialmente la estadística como índice de varianza en la década de 1920. [2]

Ejemplos comunes del uso de pruebas F incluyen el estudio de los siguientes casos

La prueba F es sensible a la no normalidad . [3] [4] En el análisis de varianza (ANOVA), las pruebas alternativas incluyen la prueba de Levene , la prueba de Bartlett y la prueba de Brown-Forsythe . Sin embargo, cuando cualquiera de estas pruebas se realiza para probar el supuesto subyacente de homocedasticidad ( es decir, homogeneidad de la varianza), como paso preliminar para probar los efectos medios, hay un aumento en la tasa de error Tipo I del experimento . [5]

La mayoría de las pruebas F surgen al considerar una descomposición de la variabilidad en una colección de datos en términos de sumas de cuadrados . El estadístico de prueba en una prueba F es la relación de dos sumas de cuadrados escaladas que reflejan diferentes fuentes de variabilidad. Estas sumas de cuadrados se construyen de modo que el estadístico tienda a ser mayor cuando la hipótesis nula no es cierta. Para que la estadística siga la distribución F bajo la hipótesis nula, las sumas de los cuadrados deben ser estadísticamente independientes y cada una debe seguir una distribución χ² escalada . La última condición está garantizada si los valores de los datos son independientes y están distribuidos normalmente con una varianza común .

La fórmula para el estadístico de prueba ANOVA F unidireccional es

o

La "varianza explicada" o "variabilidad entre grupos" es

donde denota la media de la muestra en el i -ésimo grupo, es el número de observaciones en el i -ésimo grupo, denota la media general de los datos y denota el número de grupos.

La "varianza inexplicable" o "variabilidad dentro del grupo" es

donde es la j -ésima observación en el i -ésimo grupo y es el tamaño total de la muestra. Este estadístico F sigue la distribución F con grados de libertad y bajo la hipótesis nula. La estadística será grande si la variabilidad entre grupos es grande en relación con la variabilidad dentro del grupo, lo que es poco probable que suceda si las medias poblacionales de los grupos tienen todos el mismo valor.

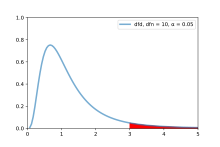

El resultado de la prueba F se puede determinar comparando el valor F calculado y el valor F crítico con un nivel de significancia específico (por ejemplo, 5%). La tabla F sirve como guía de referencia que contiene valores F críticos para la distribución del estadístico F bajo el supuesto de una hipótesis nula verdadera. Está diseñado para ayudar a determinar el umbral más allá del cual se espera que el estadístico F exceda un porcentaje controlado del tiempo (por ejemplo, 5%) cuando la hipótesis nula es precisa. Para ubicar el valor F crítico en la tabla F, es necesario utilizar los grados de libertad respectivos. Esto implica identificar la fila y columna apropiadas en la tabla F que corresponde al nivel de significancia que se está probando (por ejemplo, 5%). [6]

Cómo utilizar los valores F críticos:

Si el estadístico F < el valor F crítico

Si el estadístico F > el valor F crítico

Tenga en cuenta que cuando solo hay dos grupos para la prueba F ANOVA unidireccional , donde t es el estadístico de Student .

La prueba F en el análisis de varianza unidireccional ( ANOVA ) se utiliza para evaluar si los valores esperados de una variable cuantitativa dentro de varios grupos predefinidos difieren entre sí. Por ejemplo, supongamos que un ensayo médico compara cuatro tratamientos. La prueba ANOVA F se puede utilizar para evaluar si alguno de los tratamientos es, en promedio, superior o inferior a los demás frente a la hipótesis nula de que los cuatro tratamientos producen la misma respuesta media. Este es un ejemplo de prueba "ómnibus", lo que significa que se realiza una única prueba para detectar cualquiera de varias diferencias posibles. Alternativamente, podríamos realizar pruebas por pares entre los tratamientos (por ejemplo, en el ejemplo del ensayo médico con cuatro tratamientos podríamos realizar seis pruebas entre pares de tratamientos). La ventaja de la prueba ANOVA F es que no necesitamos especificar previamente qué tratamientos se compararán y no necesitamos realizar ajustes para realizar comparaciones múltiples . La desventaja de la prueba ANOVA F es que si rechazamos la hipótesis nula , no sabemos qué tratamientos se pueden decir que son significativamente diferentes de los demás, ni, si la prueba F se realiza en el nivel α, podemos afirmar que el par de tratamientos con la mayor diferencia de medias es significativamente diferente en el nivel α.

Considere dos modelos, 1 y 2, donde el modelo 1 está "anidado" dentro del modelo 2. El modelo 1 es el modelo restringido y el modelo 2 es el no restringido. Es decir, el modelo 1 tiene p 1 parámetros y el modelo 2 tiene p 2 parámetros, donde p 1 < p 2 , y para cualquier elección de parámetros en el modelo 1, se puede lograr la misma curva de regresión mediante alguna elección de los parámetros del modelo. 2.

Un contexto común a este respecto es el de decidir si un modelo se ajusta a los datos significativamente mejor que un modelo ingenuo, en el que el único término explicativo es el término del intercepto, de modo que todos los valores predichos para la variable dependiente se establezcan iguales a los de esa variable. muestra promedio. El modelo ingenuo es el modelo restringido, ya que los coeficientes de todas las posibles variables explicativas están restringidos a cero.

Otro contexto común es decidir si existe una ruptura estructural en los datos: aquí el modelo restringido usa todos los datos en una regresión, mientras que el modelo no restringido usa regresiones separadas para dos subconjuntos diferentes de datos. Este uso de la prueba F se conoce como prueba de Chow .

El modelo con más parámetros siempre podrá ajustar los datos al menos tan bien como el modelo con menos parámetros. Por lo tanto, normalmente el modelo 2 dará un mejor ajuste (es decir, menor error) a los datos que el modelo 1. Pero a menudo uno quiere determinar si el modelo 2 da un ajuste significativamente mejor a los datos. Una solución a este problema es utilizar una prueba F.

Si hay n puntos de datos para estimar los parámetros de ambos modelos, entonces se puede calcular el estadístico F , dado por

donde RSS i es la suma residual de cuadrados del modelo i . Si el modelo de regresión se calculó con ponderaciones, reemplace RSS i con χ 2 , la suma ponderada de los residuos al cuadrado. Bajo la hipótesis nula de que el modelo 2 no proporciona un ajuste significativamente mejor que el modelo 1, F tendrá una distribución F , con ( p 2 − p 1 , n − p 2 ) grados de libertad . La hipótesis nula se rechaza si la F calculada a partir de los datos es mayor que el valor crítico de la distribución F para alguna probabilidad deseada de falso rechazo (por ejemplo, 0,05). Dado que F es una función monótona del estadístico de razón de verosimilitud, la prueba F es una prueba de razón de verosimilitud .