En estadística y aprendizaje automático , el método Lasso ( operador de selección y contracción mínima absoluta ; también Lasso o LASSO ) es un método de análisis de regresión que realiza tanto la selección de variables como la regularización para mejorar la precisión de la predicción y la interpretabilidad del modelo estadístico resultante . El método Lasso supone que los coeficientes del modelo lineal son escasos, lo que significa que pocos de ellos son distintos de cero. Fue introducido originalmente en geofísica , [1] y luego por Robert Tibshirani , [2] quien acuñó el término.

Lasso se formuló originalmente para modelos de regresión lineal . Este caso simple revela una cantidad sustancial de información sobre el estimador. Esto incluye su relación con la regresión de cresta y la selección del mejor subconjunto y las conexiones entre las estimaciones de coeficientes de Lasso y el llamado umbral suave. También revela que (al igual que la regresión lineal estándar) las estimaciones de coeficientes no necesitan ser únicas si las covariables son colineales .

Aunque originalmente se definió para la regresión lineal, la regularización de Lasso se extiende fácilmente a otros modelos estadísticos, incluidos los modelos lineales generalizados , las ecuaciones de estimación generalizadas , los modelos de riesgos proporcionales y los estimadores M. [2] [3] La capacidad de Lasso para realizar la selección de subconjuntos depende de la forma de la restricción y tiene una variedad de interpretaciones, incluso en términos de geometría , estadísticas bayesianas y análisis convexo .

El LASSO está estrechamente relacionado con la eliminación de ruido mediante búsqueda de base .

El método Lasso se introdujo para mejorar la precisión de las predicciones y la interpretabilidad de los modelos de regresión. Selecciona un conjunto reducido de covariables conocidas para su uso en un modelo. [2] [1]

El método Lasso fue desarrollado independientemente en la literatura geofísica en 1986, basándose en trabajos previos que utilizaban la penalización tanto para el ajuste como para la penalización de los coeficientes. El estadístico Robert Tibshirani lo redescubrió y popularizó de forma independiente en 1996, basándose en el garrote no negativo de Breiman . [1] [4]

Antes de Lasso, el método más utilizado para elegir covariables era la selección por pasos . Ese enfoque solo mejora la precisión de la predicción en ciertos casos, como cuando solo unas pocas covariables tienen una relación sólida con el resultado. Sin embargo, en otros casos, puede aumentar el error de predicción.

En ese momento, la regresión de cresta era la técnica más popular para mejorar la precisión de la predicción. La regresión de cresta mejora el error de predicción al reducir la suma de los cuadrados de los coeficientes de regresión para que sea menor que un valor fijo con el fin de reducir el sobreajuste , pero no realiza la selección de covariables y, por lo tanto, no ayuda a que el modelo sea más interpretable.

Lasso logra ambos objetivos al forzar que la suma del valor absoluto de los coeficientes de regresión sea menor que un valor fijo, lo que fuerza a que ciertos coeficientes sean cero, lo que los excluye del impacto en la predicción. Esta idea es similar a la regresión de cresta, que también reduce el tamaño de los coeficientes; sin embargo, la regresión de cresta no establece los coeficientes en cero (y, por lo tanto, no realiza la selección de variables ).

Consideremos una muestra que consta de N casos, cada uno de los cuales consta de p covariables y un único resultado. Sea el resultado y el vector de covariables para el i- ésimo caso. Entonces, el objetivo de Lasso es resolver [2].

Aquí está el coeficiente constante, es el vector de coeficientes y es un parámetro libre preespecificado que determina el grado de regularización.

Dejando ser la matriz de covariables, de modo que y es la fila i de , la expresión se puede escribir de manera más compacta como donde es la norma estándar .

Al denotar la media escalar de los puntos de datos por y la media de las variables de respuesta por , la estimación resultante para es , de modo que y, por lo tanto, es estándar trabajar con variables que se han convertido en media cero. Además, las covariables suelen estar estandarizadas para que la solución no dependa de la escala de medición.

Puede ser útil reescribir en la llamada forma lagrangiana , donde la relación exacta entre y depende de los datos.

Ahora se pueden considerar algunas propiedades básicas del estimador Lasso.

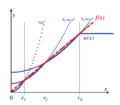

Suponiendo primero que las covariables son ortonormales de modo que , donde es el delta de Kronecker o, equivalentemente, , entonces utilizando métodos de subgradiente se puede demostrar que [2] se conoce como el operador de umbral suave , ya que traduce valores hacia cero (haciéndolos exactamente cero si son lo suficientemente pequeños) en lugar de establecer valores más pequeños en cero y dejar intactos los más grandes como lo haría el operador de umbral duro , a menudo denotado como .

En la regresión de cresta, el objetivo es minimizar

Usando la fórmula de regresión de cresta: , [5] se obtiene:

La regresión de cresta reduce todos los coeficientes por un factor uniforme y no establece ningún coeficiente en cero. [6]

También se puede comparar con la regresión con selección del mejor subconjunto , en la que el objetivo es minimizar donde es la " norma", que se define como si exactamente m componentes de z fueran distintos de cero. En este caso, se puede demostrar que donde es la llamada función de umbral duro y es una función indicadora (es 1 si su argumento es verdadero y 0 en caso contrario).

Por lo tanto, las estimaciones de Lasso comparten características de la regresión de cresta y de la regresión de selección del mejor subconjunto, ya que ambas reducen la magnitud de todos los coeficientes, como la regresión de cresta, y fijan algunos de ellos en cero, como en el caso de la selección del mejor subconjunto. Además, mientras que la regresión de cresta escala todos los coeficientes por un factor constante, Lasso, en cambio, traduce los coeficientes hacia cero por un valor constante y los fija en cero si lo alcanzan.

En un caso especial, dos covariables, digamos j y k , son idénticas para cada observación, de modo que , donde . Entonces, los valores de y que minimizan la función objetivo del lazo no están determinados de forma única. De hecho, si algunos en los que , entonces, si se reemplaza por y por , mientras se mantienen todos los demás fijos, se obtiene una nueva solución, por lo que la función objetivo del lazo tiene un continuo de minimizadores válidos. [7] Se han diseñado varias variantes del lazo, incluida la regularización de red elástica , para abordar esta deficiencia.

La regularización de lazo se puede extender a otras funciones objetivo, como aquellas para modelos lineales generalizados , ecuaciones de estimación generalizadas , modelos de riesgos proporcionales y estimadores M. [2] [3] Dada la función objetivo, la versión regularizada por lazo del estimador s es la solución a donde solo se penaliza mientras que es libre de tomar cualquier valor permitido, tal como no se penalizaba en el caso básico.

Lasso puede establecer coeficientes a cero, mientras que la regresión ridge, superficialmente similar, no puede. Esto se debe a la diferencia en la forma de sus límites de restricción. Tanto las regresión ridge como las regresión lasso pueden interpretarse como minimizando la misma función objetivo pero con respecto a diferentes restricciones: para lasso y para ridge. La figura muestra que la región de restricción definida por la norma es un cuadrado rotado de modo que sus esquinas se encuentren en los ejes (en general, un politopo cruzado ), mientras que la región definida por la norma es un círculo (en general, una n -esfera ), que es rotacionalmente invariante y, por lo tanto, no tiene esquinas. Como se ve en la figura, es probable que un objeto convexo que se encuentra tangente al límite, como la línea mostrada, encuentre una esquina (o un equivalente de dimensión superior) de un hipercubo, para el cual algunos componentes de son idénticamente cero, mientras que en el caso de una n -esfera, los puntos en el límite para los cuales algunos de los componentes de son cero no se distinguen de los otros y no es más probable que el objeto convexo entre en contacto con un punto en el cual algunos componentes de son cero que con uno para el cual ninguno de ellos lo es.

El lazo se puede reescalar para que sea fácil anticipar e influir en el grado de contracción asociado con un valor dado de . [8] Se supone que está estandarizado con puntuaciones z y que está centrado (media cero). Sea que represente los coeficientes de regresión hipotéticos y sea que haga referencia a las soluciones de mínimos cuadrados ordinarios optimizadas con datos. Luego podemos definir el lagrangiano como una compensación entre la precisión en la muestra de las soluciones optimizadas con datos y la simplicidad de ceñirse a los valores hipotéticos. [9] Esto da como resultado donde se especifica a continuación y el símbolo "prima" representa la transposición. La primera fracción representa la precisión relativa, la segunda fracción la simplicidad relativa y los equilibrios entre las dos.

Dado un solo regresor, la simplicidad relativa se puede definir especificando como , que es la cantidad máxima de desviación de cuando . Suponiendo que , la ruta de la solución se puede definir en términos de : Si , se utiliza la solución de mínimos cuadrados ordinarios (MCO). El valor hipotético de se selecciona si es mayor que . Además, si , entonces representa la influencia proporcional de . En otras palabras, mide en términos porcentuales la cantidad mínima de influencia del valor hipotético en relación con la solución MCO optimizada para datos.

Si se utiliza una -norma para penalizar las desviaciones de cero dado un solo regresor, la ruta de la solución viene dada por

Como , se mueve en la dirección del punto cuando está cerca de cero; pero a diferencia de , la influencia de disminuye en si aumenta (véase la figura). Dados múltiples regresores, el momento en que se activa un parámetro (es decir, se le permite desviarse de ) también está determinado por la contribución de un regresor a la precisión. Primero,

An de 75% significa que la precisión en la muestra mejora en un 75% si se utilizan las soluciones MCO sin restricciones en lugar de los valores hipotéticos. La contribución individual de desviarse de cada hipótesis se puede calcular con la matriz x

donde . Si cuando se calcula , entonces los elementos diagonales de suman . Los valores diagonales pueden ser menores que 0 o, con menor frecuencia, mayores que 1. Si los regresores no están correlacionados, entonces el elemento diagonal de simplemente corresponde al valor entre y .

Se puede obtener una versión reescalada del lazo adaptativo de estableciendo . [10] Si los regresores no están correlacionados, el momento en que se activa el parámetro está dado por el elemento diagonal de . Suponiendo por conveniencia que es un vector de ceros, Es decir, si los regresores no están correlacionados, nuevamente especifica la influencia mínima de . Incluso cuando los regresores están correlacionados, la primera vez que se activa un parámetro de regresión ocurre cuando es igual al elemento diagonal más alto de .

Estos resultados se pueden comparar con una versión reescalada del lazo definiendo , que es la desviación absoluta promedio de con respecto a . Suponiendo que los regresores no están correlacionados, entonces el momento de activación del regresor viene dado por

Para , el momento de activación está dado nuevamente por . Si es un vector de ceros y un subconjunto de parámetros relevantes son igualmente responsables de un ajuste perfecto de , entonces este subconjunto se activa en un valor de . El momento de activación de un regresor relevante entonces es igual a . En otras palabras, la inclusión de regresores irrelevantes retrasa el momento en que los regresores relevantes son activados por este lazo reescalado. El lazo adaptativo y el lazo son casos especiales de un estimador '1ASTc'. El último solo agrupa parámetros si la correlación absoluta entre regresores es mayor que un valor especificado por el usuario. [8]

Así como la regresión ridge puede interpretarse como una regresión lineal para la cual los coeficientes tienen distribuciones a priori normales , lasso puede interpretarse como una regresión lineal para la cual los coeficientes tienen distribuciones a priori de Laplace . La distribución de Laplace tiene un pico pronunciado en cero (su primera derivada es discontinua en cero) y concentra su masa de probabilidad más cerca de cero que la distribución normal. Esto proporciona una explicación alternativa de por qué lasso tiende a establecer algunos coeficientes en cero, mientras que la regresión ridge no lo hace. [2]

Lasso también puede verse como una relajación convexa del mejor problema de regresión de selección de subconjunto, que consiste en encontrar el subconjunto de covariables que dé como resultado el valor más pequeño de la función objetivo para algún fijo , donde n es el número total de covariables. La " norma", , (el número de entradas distintas de cero de un vector), es el caso límite de las " normas", de la forma (donde las comillas significan que estas no son realmente normas para ya que no es convexo para , por lo que la desigualdad triangular no se cumple). Por lo tanto, dado que p = 1 es el valor más pequeño para el que la " norma" es convexa (y, por lo tanto, en realidad una norma), lasso es, en cierto sentido, la mejor aproximación convexa al mejor problema de selección de subconjunto, ya que la región definida por es la envoltura convexa de la región definida por para .

Se han creado variantes de Lasso para remediar las limitaciones de la técnica original y hacer que el método sea más útil para problemas específicos. Casi todas ellas se centran en respetar o explotar las dependencias entre las covariables.

La regularización de red elástica agrega una penalización adicional similar a una regresión de cresta que mejora el rendimiento cuando la cantidad de predictores es mayor que el tamaño de la muestra, permite que el método seleccione variables fuertemente correlacionadas juntas y mejora la precisión general de la predicción. [7]

El lazo de grupo permite seleccionar grupos de covariables relacionadas como una sola unidad, lo que puede ser útil en entornos donde no tiene sentido incluir algunas covariables sin otras. [11] Otras extensiones del lazo de grupo realizan la selección de variables dentro de grupos individuales (lazo de grupo disperso) y permiten la superposición entre grupos (lazo de grupo superpuesto). [12] [13]

El lazo fusionado puede dar cuenta de las características espaciales o temporales de un problema, lo que da como resultado estimaciones que se ajustan mejor a la estructura del sistema. [14] Los modelos regularizados con lazo se pueden ajustar utilizando técnicas que incluyen métodos de subgradiente , regresión de ángulo mínimo (LARS) y métodos de gradiente proximal . Determinar el valor óptimo para el parámetro de regularización es una parte importante para garantizar que el modelo funcione bien; generalmente se elige mediante validación cruzada .

En 2005, Zou y Hastie introdujeron la red elástica . [7] Cuando p > n (la cantidad de covariables es mayor que el tamaño de la muestra), Lasso puede seleccionar solo n covariables (incluso cuando hay más asociadas con el resultado) y tiende a seleccionar una covariable de cualquier conjunto de covariables altamente correlacionadas. Además, incluso cuando n > p , la regresión de cresta tiende a tener un mejor desempeño dadas las covariables fuertemente correlacionadas.

La red elástica extiende el lazo añadiendo un término de penalización adicional, lo que equivale a resolver

Este problema se puede escribir en forma de lazo simple, dejando

Entonces , lo cual, cuando las covariables son ortogonales entre sí, da

Por lo tanto, el resultado de la penalización de la red elástica es una combinación de los efectos de las penalizaciones de lazo y de cresta.

Volviendo al caso general, el hecho de que la función de penalización ahora sea estrictamente convexa significa que si , , lo cual es un cambio con respecto a lasso. [7] En general, si es la matriz de correlación de muestra porque las están normalizadas.

Por lo tanto, las covariables altamente correlacionadas tienden a tener coeficientes de regresión similares, y el grado de similitud depende tanto de como de , lo cual es diferente de lasso. Este fenómeno, en el que las covariables fuertemente correlacionadas tienen coeficientes de regresión similares, se conoce como efecto de agrupación. La agrupación es deseable ya que, en aplicaciones como la vinculación de genes a una enfermedad, es preferible encontrar todas las covariables asociadas, en lugar de seleccionar una de cada conjunto de covariables correlacionadas, como suele hacer lasso. [7] Además, seleccionar solo una de cada grupo generalmente da como resultado un mayor error de predicción, ya que el modelo es menos robusto (razón por la cual la regresión ridge a menudo supera a lasso).

En 2006, Yuan y Lin introdujeron el lazo de grupo para permitir que grupos predefinidos de covariables se seleccionen conjuntamente dentro o fuera de un modelo. [11] Esto es útil en muchos entornos, quizás más obviamente cuando una variable categórica se codifica como una colección de covariables binarias. En este caso, el lazo de grupo puede garantizar que todas las variables que codifican la covariable categórica se incluyan o excluyan juntas. Otro entorno en el que la agrupación es natural es en los estudios biológicos. Dado que los genes y las proteínas a menudo se encuentran en vías conocidas, qué vías están relacionadas con un resultado puede ser más significativo que si los genes individuales lo están. La función objetivo para el lazo de grupo es una generalización natural del objetivo lazo estándar donde la matriz de diseño y el vector de covariables han sido reemplazados por una colección de matrices de diseño y vectores de covariables , uno para cada uno de los J grupos. Además, el término de penalización es ahora una suma sobre normas definidas por las matrices definidas positivas . Si cada covariable está en su propio grupo y , entonces esto se reduce al lazo estándar, mientras que si solo hay un solo grupo y , se reduce a la regresión de cresta. Dado que la penalización se reduce a una norma en los subespacios definidos por cada grupo, no puede seleccionar solo algunas de las covariables de un grupo, al igual que la regresión de cresta no puede. Sin embargo, debido a que la penalización es la suma sobre las diferentes normas de subespacio, como en el lazo estándar, la restricción tiene algunos puntos no diferenciales, que corresponden a algunos subespacios que son idénticamente cero. Por lo tanto, puede establecer los vectores de coeficientes correspondientes a algunos subespacios en cero, mientras que solo reduce otros. Sin embargo, es posible extender el lazo de grupo al llamado lazo de grupo disperso, que puede seleccionar covariables individuales dentro de un grupo, agregando una penalización adicional a cada subespacio de grupo. [12] Otra extensión, el lazo de grupo con superposición, permite que las covariables se compartan entre grupos, por ejemplo, si un gen ocurriera en dos vías. [13]

El paquete "gglasso" de R permite una implementación rápida y eficiente de Group LASSO. [15]

En algunos casos, el fenómeno en estudio puede tener una estructura espacial o temporal importante que debe considerarse durante el análisis, como series temporales o datos basados en imágenes. En 2005, Tibshirani y sus colegas introdujeron el lazo fusionado para extender el uso del lazo a este tipo de datos. [14] La función objetivo del lazo fusionado es

La primera restricción es la restricción de lazo, mientras que la segunda penaliza directamente los grandes cambios con respecto a la estructura temporal o espacial, lo que obliga a los coeficientes a variar suavemente para reflejar la lógica subyacente del sistema. El lazo agrupado [16] es una generalización del lazo fusionado que identifica y agrupa las covariables relevantes en función de sus efectos (coeficientes). La idea básica es penalizar las diferencias entre los coeficientes de modo que los unos distintos de cero se agrupen. Esto se puede modelar utilizando la siguiente regularización:

Por el contrario, las variables se pueden agrupar en grupos altamente correlacionados y luego se puede extraer una única covariable representativa de cada grupo. [17]

Existen algoritmos que resuelven el problema del lazo fusionado y algunas generalizaciones del mismo. Los algoritmos pueden resolverlo exactamente en un número finito de operaciones. [18]

Lasso, red elástica, grupo y lazo fusionado construyen las funciones de penalización a partir de las normas y (con pesos, si es necesario). La regresión puente utiliza normas generales ( ) y cuasinormas ( ). [20] Por ejemplo, para p = 1/2 el análogo del objetivo de lasso en la forma lagrangiana es resolver donde

Se afirma que las cuasi-normas fraccionarias ( ) proporcionan resultados más significativos en el análisis de datos tanto teórica como empíricamente. [21] La no convexidad de estas cuasi-normas complica el problema de optimización. Para resolver este problema, se desarrolla un procedimiento de minimización de expectativas [22] e implementa [19] para la minimización de la función donde es una función cóncava arbitraria de aumento monótono (por ejemplo, da la penalización de lazo y da la penalización).

El algoritmo eficiente para la minimización se basa en la aproximación cuadrática por partes del crecimiento subcuadrático (PQSQ). [22]

El lazo adaptativo fue introducido por Zou en 2006 para la regresión lineal [10] y por Zhang y Lu en 2007 para la regresión de riesgos proporcionales. [23]

El lazo previo fue introducido para modelos lineales generalizados por Jiang et al. en 2016 para incorporar información previa, como la importancia de ciertas covariables. [24] En el lazo previo, dicha información se resume en pseudorespuestas (llamadas respuestas previas) y luego se agrega una función de criterio adicional a la función objetivo habitual con una penalización de lazo. Sin pérdida de generalidad, en regresión lineal, la nueva función objetivo se puede escribir como que es equivalente a

la función objetivo de lazo habitual con las respuestas reemplazadas por un promedio ponderado de las respuestas observadas y las respuestas anteriores (llamadas valores de respuesta ajustados por la información previa).

En el caso de lasso a priori, el parámetro se denomina parámetro de equilibrio, ya que equilibra la importancia relativa de los datos y la información a priori. En el caso extremo de , lasso a priori se reduce a lasso. Si , lasso a priori se basará únicamente en la información a priori para ajustar el modelo. Además, el parámetro de equilibrio tiene otra interpretación atractiva: controla la varianza de en su distribución a priori desde un punto de vista bayesiano.

El lazo previo es más eficiente en la estimación y predicción de parámetros (con un error de estimación y un error de predicción menores) cuando la información previa es de alta calidad, y es robusto a la información previa de baja calidad con una buena elección del parámetro de equilibrio .

La función de pérdida del lazo no es diferenciable, pero se ha desarrollado una amplia variedad de técnicas de análisis convexo y teoría de optimización para calcular la ruta de soluciones del lazo. Estas incluyen el descenso de coordenadas, [25] métodos de subgradiente, regresión de ángulo mínimo (LARS) y métodos de gradiente proximal. [26] Los métodos de subgradiente son la generalización natural de los métodos tradicionales, como el descenso de gradiente y el descenso de gradiente estocástico , al caso en el que la función objetivo no es diferenciable en todos los puntos. LARS es un método que está estrechamente vinculado a los modelos de lazo y, en muchos casos, permite que se ajusten de manera eficiente, aunque puede no funcionar bien en todas las circunstancias. LARS genera rutas de solución completas. [26] Los métodos proximales se han vuelto populares debido a su flexibilidad y rendimiento y son un área de investigación activa. La elección del método dependerá de la variante particular del lazo, los datos y los recursos disponibles. Sin embargo, los métodos proximales generalmente funcionan bien.

El paquete "glmnet" en R, donde "glm" es una referencia a "modelos lineales generalizados" y "net" se refiere a la "red" de "red elástica", proporciona una forma extremadamente eficiente de implementar LASSO y algunas de sus variantes. [27] [28] [29]

El paquete "celer" de Python ofrece un solucionador muy eficiente para el problema Lasso, que a menudo supera a los solucionadores tradicionales como scikit-learn hasta 100 veces en ciertos escenarios, en particular con conjuntos de datos de alta dimensión. Este paquete aprovecha las técnicas de extrapolación dual para lograr mejoras de rendimiento. [30] [31] El paquete celer está disponible en GitHub.

La elección del parámetro de regularización ( ) es una parte fundamental de lasso. Un buen valor es esencial para el rendimiento de lasso, ya que controla la fuerza de la contracción y la selección de variables, lo que, con moderación, puede mejorar tanto la precisión de la predicción como la interpretabilidad. Sin embargo, si la regularización se vuelve demasiado fuerte, se pueden omitir variables importantes y los coeficientes pueden reducirse excesivamente, lo que puede dañar tanto la capacidad predictiva como la inferencia. La validación cruzada se utiliza a menudo para encontrar el parámetro de regularización.

Los criterios de información como el criterio de información bayesiano (BIC) y el criterio de información de Akaike (AIC) pueden ser preferibles a la validación cruzada, porque son más rápidos de calcular y su rendimiento es menos volátil en muestras pequeñas. [32] Un criterio de información selecciona el parámetro de regularización del estimador maximizando la precisión en la muestra de un modelo mientras penaliza su número efectivo de parámetros/grados de libertad. Zou et al. propusieron medir los grados de libertad efectivos contando el número de parámetros que se desvían de cero. [33] El enfoque de los grados de libertad fue considerado defectuoso por Kaufman y Rosset [34] y Janson et al., [35] porque los grados de libertad de un modelo pueden aumentar incluso cuando es penalizado más duramente por el parámetro de regularización. Como alternativa, la medida de simplicidad relativa definida anteriormente se puede utilizar para contar el número efectivo de parámetros. [32] Para el lazo, esta medida se da por que aumenta monótonamente de cero a a medida que el parámetro de regularización disminuye de a cero.

LASSO se ha aplicado en economía y finanzas, y se ha descubierto que mejora la predicción y selecciona variables a veces descuidadas, por ejemplo en la literatura de predicción de quiebras corporativas [36] o en la predicción de empresas de alto crecimiento [37] .