En el aprendizaje automático , un clasificador probabilístico es un clasificador que puede predecir, dada una observación de una entrada, una distribución de probabilidad sobre un conjunto de clases, en lugar de solo generar la clase más probable a la que debería pertenecer la observación. Los clasificadores probabilísticos proporcionan una clasificación que puede ser útil por sí misma [1] o al combinar clasificadores en conjuntos .

Formalmente, un clasificador "ordinario" es alguna regla o función que asigna a una muestra x una etiqueta de clase ŷ :

Las muestras provienen de algún conjunto X (por ejemplo, el conjunto de todos los documentos o el conjunto de todas las imágenes ), mientras que las etiquetas de clase forman un conjunto finito Y definido antes del entrenamiento.

Los clasificadores probabilísticos generalizan esta noción de clasificadores: en lugar de funciones, son distribuciones condicionales , lo que significa que para un determinado , asignan probabilidades a todos (y estas probabilidades suman uno). La clasificación "dura" se puede realizar utilizando la regla de decisión óptima [2] : 39–40

o, en inglés, la clase predicha es la que tiene la mayor probabilidad.

Los clasificadores probabilísticos binarios también se denominan modelos de regresión binaria en estadística . En econometría , la clasificación probabilística en general se denomina elección discreta .

Algunos modelos de clasificación, como el bayesiano ingenuo , la regresión logística y los perceptrones multicapa (cuando se entrenan con una función de pérdida adecuada ) son naturalmente probabilísticos. Otros modelos, como las máquinas de vectores de soporte , no lo son, pero existen métodos para convertirlos en clasificadores probabilísticos.

Algunos modelos, como la regresión logística , se entrenan condicionalmente: optimizan la probabilidad condicional directamente en un conjunto de entrenamiento (ver minimización de riesgo empírico ). Otros clasificadores, como Bayes ingenuo , se entrenan generativamente : en el momento del entrenamiento, se encuentran la distribución condicional de clase y la distribución previa de clase, y la distribución condicional se deriva utilizando la regla de Bayes . [2] : 43

No todos los modelos de clasificación son naturalmente probabilísticos, y algunos que lo son, en particular los clasificadores Bayes ingenuos, los árboles de decisión y los métodos de refuerzo , producen distribuciones de probabilidad de clase distorsionadas. [3] En el caso de los árboles de decisión, donde Pr( y | x ) es la proporción de muestras de entrenamiento con la etiqueta y en la hoja donde termina x , estas distorsiones se producen porque los algoritmos de aprendizaje como C4.5 o CART apuntan explícitamente a producir hojas homogéneas (dando probabilidades cercanas a cero o uno, y por lo tanto un alto sesgo ) mientras se utilizan pocas muestras para estimar la proporción relevante (alta varianza ). [4]

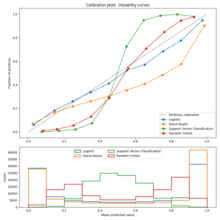

La calibración se puede evaluar utilizando un gráfico de calibración (también llamado diagrama de confiabilidad ). [3] [5] Un gráfico de calibración muestra la proporción de elementos en cada clase para bandas de probabilidad o puntuación predichas (como una distribución de probabilidad distorsionada o la "distancia con signo al hiperplano" en una máquina de vectores de soporte). Las desviaciones de la función de identidad indican un clasificador mal calibrado para el cual las probabilidades o puntuaciones predichas no se pueden usar como probabilidades. En este caso, se puede utilizar un método para convertir estas puntuaciones en probabilidades de pertenencia a la clase calibradas correctamente .

Para el caso binario , un enfoque común es aplicar la escala de Platt , que aprende un modelo de regresión logística sobre las puntuaciones. [6] Un método alternativo que utiliza regresión isotónica [7] es generalmente superior al método de Platt cuando se dispone de suficientes datos de entrenamiento. [3]

En el caso multiclase , se puede utilizar una reducción a tareas binarias, seguida de una calibración univariante con un algoritmo como el descrito anteriormente y una aplicación adicional del algoritmo de acoplamiento por pares de Hastie y Tibshirani. [8]

Las métricas de evaluación que se utilizan comúnmente para comparar la probabilidad predicha con los resultados observados incluyen la pérdida de registro , la puntuación de Brier y una variedad de errores de calibración. La primera también se utiliza como función de pérdida en el entrenamiento de modelos logísticos.

Las métricas de errores de calibración tienen como objetivo cuantificar hasta qué punto los resultados de un clasificador probabilístico están bien calibrados . Como dijo Philip Dawid , "un pronosticador está bien calibrado si, por ejemplo, de aquellos eventos a los que asigna una probabilidad del 30 por ciento, la proporción a largo plazo que realmente ocurre resulta ser del 30 por ciento". [9] El trabajo fundamental en el campo de la medición del error de calibración es la métrica del Error de Calibración Esperado (ECE). [10] Trabajos más recientes proponen variantes del ECE que abordan las limitaciones de la métrica ECE que pueden surgir cuando las puntuaciones del clasificador se concentran en un subconjunto estrecho de [0,1], incluido el Error de Calibración Adaptativo (ACE) [11] y el Error de Calibración Basado en Pruebas (TCE). [12]

Un método utilizado para asignar puntuaciones a pares de probabilidades predichas y resultados discretos reales, de modo que se puedan comparar diferentes métodos predictivos, se denomina regla de puntuación .

[E]n las aplicaciones de minería de datos , el interés suele estar más en las probabilidades de clase en sí mismas que en realizar una tarea de clase.