La teoría del aprendizaje estadístico es un marco para el aprendizaje automático que se nutre de los campos de la estadística y el análisis funcional . [1] [2] [3] La teoría del aprendizaje estadístico se ocupa del problema de inferencia estadística de encontrar una función predictiva basada en datos. La teoría del aprendizaje estadístico ha dado lugar a aplicaciones exitosas en campos como la visión artificial , el reconocimiento de voz y la bioinformática .

Los objetivos del aprendizaje son la comprensión y la predicción. El aprendizaje se divide en muchas categorías, entre ellas el aprendizaje supervisado , el aprendizaje no supervisado , el aprendizaje en línea y el aprendizaje de refuerzo . Desde la perspectiva de la teoría del aprendizaje estadístico, el aprendizaje supervisado se entiende mejor. [4] El aprendizaje supervisado implica aprender a partir de un conjunto de datos de entrenamiento. Cada punto del entrenamiento es un par de entrada-salida, donde la entrada se asigna a una salida. El problema de aprendizaje consiste en inferir la función que se asigna entre la entrada y la salida, de modo que la función aprendida se pueda utilizar para predecir la salida a partir de la entrada futura.

Dependiendo del tipo de salida, los problemas de aprendizaje supervisado son problemas de regresión o problemas de clasificación . Si la salida toma un rango continuo de valores, es un problema de regresión. Usando la ley de Ohm como ejemplo, una regresión podría realizarse con voltaje como entrada y corriente como salida. La regresión encontraría que la relación funcional entre voltaje y corriente es , de modo que Los problemas de clasificación son aquellos para los cuales la salida será un elemento de un conjunto discreto de etiquetas. La clasificación es muy común para aplicaciones de aprendizaje automático. En el reconocimiento facial , por ejemplo, una foto de la cara de una persona sería la entrada, y la etiqueta de salida sería el nombre de esa persona. La entrada estaría representada por un gran vector multidimensional cuyos elementos representan píxeles en la imagen.

Después de aprender una función basada en los datos del conjunto de entrenamiento, esa función se valida en un conjunto de datos de prueba, datos que no aparecieron en el conjunto de entrenamiento.

Tome como el espacio vectorial de todas las entradas posibles, y como el espacio vectorial de todas las salidas posibles. La teoría del aprendizaje estadístico asume la perspectiva de que existe una distribución de probabilidad desconocida sobre el espacio del producto , es decir, existe alguna incógnita . El conjunto de entrenamiento está formado por muestras de esta distribución de probabilidad y se anota Cada es un vector de entrada de los datos de entrenamiento, y es la salida que le corresponde.

En este formalismo, el problema de inferencia consiste en encontrar una función tal que . Sea un espacio de funciones llamado espacio de hipótesis. El espacio de hipótesis es el espacio de funciones en el que buscará el algoritmo. Sea la función de pérdida , una métrica para la diferencia entre el valor predicho y el valor real . El riesgo esperado se define como La función objetivo, la mejor función posible que se puede elegir, viene dada por que satisface

Como la distribución de probabilidad es desconocida, se debe utilizar una medida proxy del riesgo esperado. Esta medida se basa en el conjunto de entrenamiento, una muestra de esta distribución de probabilidad desconocida. Se denomina riesgo empírico. Un algoritmo de aprendizaje que elige la función que minimiza el riesgo empírico se denomina minimización del riesgo empírico .

La elección de la función de pérdida es un factor determinante de la función que elegirá el algoritmo de aprendizaje. La función de pérdida también afecta la tasa de convergencia de un algoritmo. Es importante que la función de pérdida sea convexa . [5]

Se utilizan diferentes funciones de pérdida dependiendo de si el problema es de regresión o de clasificación.

La función de pérdida más común para la regresión es la función de pérdida cuadrática (también conocida como norma L2 ). Esta función de pérdida tan conocida se utiliza en la regresión de mínimos cuadrados ordinarios . La forma es:

La pérdida de valor absoluto (también conocida como norma L1 ) también se utiliza a veces:

En cierto sentido, la función indicadora 0-1 es la función de pérdida más natural para la clasificación. Toma el valor 0 si la salida prevista es la misma que la salida real, y toma el valor 1 si la salida prevista es diferente de la salida real. Para la clasificación binaria con , esto es: donde es la función de paso de Heaviside .

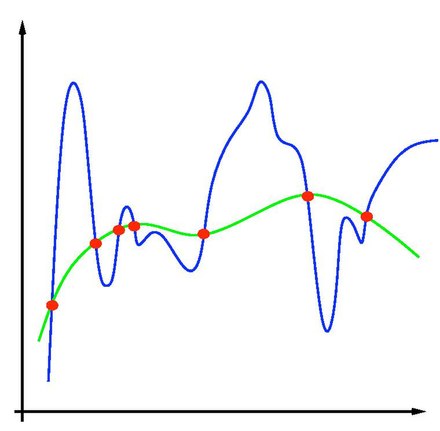

En los problemas de aprendizaje automático, un problema importante que surge es el del sobreajuste . Como el aprendizaje es un problema de predicción, el objetivo no es encontrar una función que se ajuste lo más posible a los datos (previamente observados), sino encontrar una que prediga con mayor precisión el resultado a partir de la entrada futura. La minimización del riesgo empírico corre el riesgo del sobreajuste: encontrar una función que coincida exactamente con los datos pero que no prediga bien el resultado futuro.

El sobreajuste es un síntoma de soluciones inestables; una pequeña perturbación en los datos del conjunto de entrenamiento provocaría una gran variación en la función aprendida. Se puede demostrar que si se puede garantizar la estabilidad de la solución, también se garantizan la generalización y la consistencia. [6] [7] La regularización puede resolver el problema del sobreajuste y darle estabilidad al problema.

La regularización se puede lograr restringiendo el espacio de hipótesis . Un ejemplo común sería la restricción a funciones lineales: esto puede verse como una reducción al problema estándar de regresión lineal . También podría restringirse a polinomios de grado , exponenciales o funciones acotadas en L1 . La restricción del espacio de hipótesis evita el sobreajuste porque la forma de las funciones potenciales es limitada y, por lo tanto, no permite la elección de una función que dé un riesgo empírico arbitrariamente cercano a cero.

Un ejemplo de regularización es la regularización de Tikhonov . Esta consiste en minimizar donde es un parámetro fijo y positivo, el parámetro de regularización. La regularización de Tikhonov asegura la existencia, unicidad y estabilidad de la solución. [8]

Consideremos un clasificador binario . Podemos aplicar la desigualdad de Hoeffding para limitar la probabilidad de que el riesgo empírico se desvíe del riesgo verdadero para que sea una distribución subgaussiana . Pero, en general, cuando hacemos una minimización del riesgo empírico, no se nos da un clasificador; debemos elegirlo. Por lo tanto, un resultado más útil es limitar la probabilidad del supremo de la diferencia sobre toda la clase. donde es el número de ruptura y es el número de muestras en su conjunto de datos. El término exponencial proviene de Hoeffding, pero hay un costo adicional de tomar el supremo sobre toda la clase, que es el número de ruptura.