La clasificación del vecino más cercano de margen grande ( LMNN ) [1] es un algoritmo estadístico de aprendizaje automático para el aprendizaje métrico . Aprende una pseudométrica diseñada para la clasificación de k vecinos más cercanos . El algoritmo se basa en programación semidefinida , una subclase de optimización convexa .

El objetivo del aprendizaje supervisado (más específicamente la clasificación) es aprender una regla de decisión que pueda categorizar instancias de datos en clases predefinidas. La regla del vecino k-más cercano supone un conjunto de datos de entrenamiento de instancias etiquetadas (es decir, las clases son conocidas). Clasifica una nueva instancia de datos con la clase obtenida del voto mayoritario de las k instancias de entrenamiento más cercanas (etiquetadas). La cercanía se mide con una métrica predefinida . Los vecinos más cercanos de margen grande son un algoritmo que aprende esta (pseudo)métrica global de forma supervisada para mejorar la precisión de la clasificación de la regla del vecino k-más cercano.

La principal intuición detrás de LMNN es aprender una pseudométrica según la cual todas las instancias de datos en el conjunto de entrenamiento están rodeadas por al menos k instancias que comparten la misma etiqueta de clase. Si esto se logra, se minimiza el error de dejar uno fuera (un caso especial de validación cruzada ). Deje que los datos de entrenamiento consistan en un conjunto de datos , donde está el conjunto de posibles categorías de clases .

El algoritmo aprende una pseudométrica del tipo

Para que esté bien definida, la matriz debe ser semidefinida positiva . La métrica euclidiana es un caso especial, donde está la matriz identidad. Esta generalización a menudo se denomina (falsamente [ cita requerida ] ) métrica de Mahalanobis .

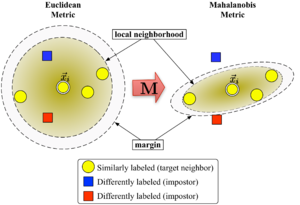

La Figura 1 ilustra el efecto de la métrica bajo variaciones . Los dos círculos muestran el conjunto de puntos con igual distancia al centro . En el caso euclidiano este conjunto es un círculo, mientras que bajo la métrica modificada (Mahalanobis) se convierte en un elipsoide .

El algoritmo distingue entre dos tipos de puntos de datos especiales: vecinos objetivo e impostores .

Los vecinos objetivo se seleccionan antes de aprender. Cada instancia tiene vecinos objetivo exactamente diferentes , los cuales comparten la misma etiqueta de clase . Los vecinos objetivo son los puntos de datos que deberían convertirse en vecinos más cercanos según la métrica aprendida . Denotaremos el conjunto de vecinos objetivo para un punto de datos como .

Un impostor de un punto de datos es otro punto de datos con una etiqueta de clase diferente (es decir , ) que es uno de los vecinos más cercanos de . Durante el aprendizaje, el algoritmo intenta minimizar la cantidad de impostores para todas las instancias de datos en el conjunto de entrenamiento.

Los vecinos más cercanos de gran margen optimizan la matriz con la ayuda de la programación semidefinida . El objetivo es doble: para cada punto de datos , los vecinos objetivo deben estar cerca y los impostores deben estar lejos . La Figura 1 muestra el efecto de dicha optimización en un ejemplo ilustrativo. La métrica aprendida hace que el vector de entrada esté rodeado por instancias de entrenamiento de la misma clase. Si fuera un punto de prueba, se clasificaría correctamente según la regla del vecino más cercano.

El primer objetivo de optimización se logra minimizando la distancia promedio entre las instancias y sus vecinos objetivo.

El segundo objetivo se logra penalizando las distancias a los impostores que están a menos de una unidad de distancia de los vecinos objetivo (y, por lo tanto, expulsándolos del vecindario local de ). El valor resultante a minimizar se puede expresar como:

Con función de pérdida de bisagra , que garantiza que la proximidad del impostor no sea penalizada cuando esté fuera del margen. El margen de exactamente una unidad fija la escala de la matriz . Cualquier elección alternativa daría como resultado un cambio de escala de por un factor de .

El problema de optimización final se convierte en:

El hiperparámetro es una constante positiva (normalmente establecida mediante validación cruzada). Aquí las variables (junto con dos tipos de restricciones) reemplazan el término en la función de costos. Desempeñan un papel similar al de las variables de holgura para absorber el alcance de las violaciones de las restricciones del impostor. La última restricción asegura que sea semidefinida positiva. El problema de optimización es un ejemplo de programación semidefinida (SDP). Aunque los SDP tienden a sufrir una alta complejidad computacional, esta instancia de SDP en particular se puede resolver de manera muy eficiente debido a las propiedades geométricas subyacentes del problema. En particular, la mayoría de las restricciones del impostor se satisfacen naturalmente y no es necesario aplicarlas durante el tiempo de ejecución (es decir, el conjunto de variables es escaso). Una técnica de resolución particularmente adecuada es el método del conjunto de trabajo , que mantiene un pequeño conjunto de restricciones que se aplican activamente y monitorea las restricciones restantes (probablemente satisfechas) sólo ocasionalmente para garantizar su corrección.

LMNN se amplió a múltiples métricas locales en el documento de 2008. [2] Esta extensión mejora significativamente el error de clasificación, pero implica un problema de optimización más costoso. En su publicación de 2009 en el Journal of Machine Learning Research, [3] Weinberger y Saul obtienen un solucionador eficiente para el programa semidefinido. Puede aprender una métrica para el conjunto de datos de dígitos escritos a mano MNIST en varias horas, lo que implica miles de millones de restricciones por pares. Una implementación de Matlab de código abierto está disponible gratuitamente en la página web del autor.

Kumal et al. [4] amplió el algoritmo para incorporar invarianzas locales a transformaciones polinómicas multivariadas y mejoró la regularización.