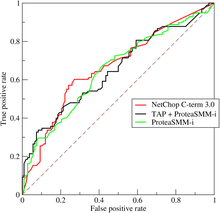

Una curva característica operativa del receptor , o curva ROC , es un gráfico que ilustra el rendimiento de un modelo de clasificador binario (también se puede utilizar para clasificación de clases múltiples) en valores de umbral variables.

La curva ROC es la gráfica de la tasa de verdaderos positivos (TPR) frente a la tasa de falsos positivos (FPR) en cada configuración de umbral.

La República de China también se puede considerar como una gráfica del poder estadístico en función del error tipo I de la regla de decisión (cuando el desempeño se calcula a partir de solo una muestra de la población, se puede considerar como estimadores de estas cantidades). ). La curva ROC es, por tanto, la sensibilidad o recuperación en función de la tasa de falsos positivos .

Dado que se conocen las distribuciones de probabilidad tanto para los verdaderos positivos como para los falsos positivos, la curva ROC se obtiene como la función de distribución acumulada (CDF, área bajo la distribución de probabilidad desde hasta el umbral de discriminación) de la probabilidad de detección en el eje y versus la CDF. de la probabilidad de falso positivo en el eje x.

El análisis ROC proporciona herramientas para seleccionar modelos posiblemente óptimos y descartar los subóptimos independientemente (y antes de especificar) el contexto de costos o la distribución de clases. El análisis ROC se relaciona de forma directa y natural con el análisis coste/beneficio de la toma de decisiones diagnósticas .

La tasa de verdaderos positivos también se conoce como sensibilidad , recuperación o probabilidad de detección . [1] La tasa de falsos positivos también se conoce como probabilidad de falsa alarma [1] y es igual a (1 − especificidad ). La ROC también se conoce como curva característica operativa relativa, porque es una comparación de dos características operativas (TPR y FPR) a medida que cambia el criterio. [2]

La curva ROC fue desarrollada por primera vez por ingenieros eléctricos y de radar durante la Segunda Guerra Mundial para detectar objetos enemigos en los campos de batalla, a partir de 1941, lo que dio lugar a su nombre ("característica operativa del receptor"). [3]

Pronto se introdujo en la psicología para dar cuenta de la detección perceptual de estímulos. El análisis ROC se ha utilizado en medicina , radiología , biometría , pronóstico de peligros naturales , [4] meteorología , [5] evaluación del desempeño de modelos, [6] y otras áreas durante muchas décadas y se usa cada vez más en el aprendizaje automático y la investigación de minería de datos .

Un modelo de clasificación ( clasificador o diagnóstico [7] ) es un mapeo de instancias entre ciertas clases/grupos. Debido a que el resultado del clasificador o del diagnóstico puede ser un valor real arbitrario (salida continua), el límite del clasificador entre clases debe determinarse mediante un valor umbral (por ejemplo, para determinar si una persona tiene hipertensión basándose en una medida de presión arterial ). O puede ser una etiqueta de clase discreta , que indica una de las clases.

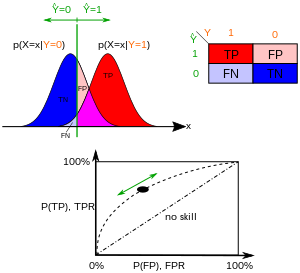

Considere un problema de predicción de dos clases ( clasificación binaria ), en el que los resultados se etiquetan como positivos ( p ) o negativos ( n ). Hay cuatro resultados posibles de un clasificador binario. Si el resultado de una predicción es p y el valor real también es p , entonces se llama verdadero positivo (TP); sin embargo, si el valor real es n , se dice que es un falso positivo (FP). Por el contrario, se ha producido un verdadero negativo (TN) cuando tanto el resultado de la predicción como el valor real son n , y un falso negativo (FN) se produce cuando el resultado de la predicción es n mientras que el valor real es p .

Para obtener un ejemplo apropiado de un problema del mundo real, consideremos una prueba de diagnóstico que busca determinar si una persona tiene una determinada enfermedad. Un falso positivo en este caso ocurre cuando la persona da positivo, pero en realidad no tiene la enfermedad. Un falso negativo, por otro lado, ocurre cuando la persona da negativo, lo que sugiere que está sana, cuando en realidad tiene la enfermedad.

Considere un experimento de P casos positivos y N casos negativos para alguna condición. Los cuatro resultados se pueden formular en una tabla de contingencia o matriz de confusión de 2×2 , de la siguiente manera:

La tabla de contingencia puede derivar varias "métricas" de evaluación (ver cuadro de información). Para dibujar una curva ROC, solo se necesitan la tasa de verdaderos positivos (TPR) y la tasa de falsos positivos (FPR) (como funciones de algún parámetro clasificador). El TPR define cuántos resultados positivos correctos ocurren entre todas las muestras positivas disponibles durante la prueba. FPR, por otro lado, define cuántos resultados positivos incorrectos ocurren entre todas las muestras negativas disponibles durante la prueba.

Un espacio ROC está definido por FPR y TPR como ejes xey , respectivamente, lo que representa compensaciones relativas entre verdaderos positivos (beneficios) y falsos positivos (costos). Dado que TPR es equivalente a sensibilidad y FPR es igual a 1 - especificidad, el gráfico ROC a veces se denomina gráfico de sensibilidad versus (1 - especificidad). Cada resultado de predicción o instancia de una matriz de confusión representa un punto en el espacio ROC.

El mejor método de predicción posible produciría un punto en la esquina superior izquierda o coordenada (0,1) del espacio ROC, que representa el 100 % de sensibilidad (sin falsos negativos) y el 100 % de especificidad (sin falsos positivos). El punto (0,1) también se llama clasificación perfecta . Una suposición aleatoria daría un punto a lo largo de una línea diagonal (la llamada línea de no discriminación ) desde las esquinas inferior izquierda hasta la superior derecha (independientemente de los tipos base positivos y negativos ). [16] Un ejemplo intuitivo de adivinación aleatoria es una decisión lanzando monedas. A medida que aumenta el tamaño de la muestra, el punto ROC de un clasificador aleatorio tiende hacia la línea diagonal. En el caso de una moneda equilibrada, tenderá al punto (0,5, 0,5).

La diagonal divide el espacio de la República de China. Los puntos por encima de la diagonal representan buenos resultados de clasificación (mejores que los aleatorios); Los puntos debajo de la línea representan malos resultados (peores que aleatorios). Tenga en cuenta que el resultado de un predictor consistentemente malo podría simplemente invertirse para obtener un buen predictor.

Considere cuatro resultados de predicción de 100 casos positivos y 100 negativos:

En la figura se muestran los gráficos de los cuatro resultados anteriores en el espacio de la República de China. El resultado del método A muestra claramente el mejor poder predictivo entre A , B y C. El resultado de B se encuentra en la línea de conjetura aleatoria (la línea diagonal) y en la tabla se puede ver que la precisión de B es del 50%. Sin embargo, cuando C se refleja a través del punto central (0.5,0.5), el método resultante C′ es incluso mejor que A. Este método reflejado simplemente invierte las predicciones de cualquier método o prueba que haya producido la tabla de contingencia C. Aunque el método C original tiene poder predictivo negativo, simplemente revertir sus decisiones conduce a un nuevo método predictivo C′ que tiene poder predictivo positivo. Cuando el método C predice p o n , el método C′ predeciría n o p , respectivamente. De esta manera, la prueba C′ tendría el mejor rendimiento. Cuanto más cerca esté el resultado de una tabla de contingencia de la esquina superior izquierda, mejor predice, pero la distancia desde la línea de conjetura aleatoria en cualquier dirección es el mejor indicador de cuánto poder predictivo tiene un método. Si el resultado está por debajo de la línea (es decir, el método es peor que una suposición aleatoria), todas las predicciones del método deben revertirse para utilizar su poder, moviendo así el resultado por encima de la línea de suposición aleatoria.

En la clasificación binaria, la predicción de clase para cada instancia a menudo se realiza basándose en una variable aleatoria continua , que es una "puntuación" calculada para la instancia (por ejemplo, la probabilidad estimada en regresión logística). Dado un parámetro de umbral , la instancia se clasifica como "positiva" si y "negativa" en caso contrario. sigue una densidad de probabilidad si la instancia realmente pertenece a la clase "positiva", y en caso contrario. Por lo tanto, la tasa de verdaderos positivos está dada por y la tasa de falsos positivos está dada por . La curva ROC se traza paramétricamente versus con como parámetro variable.

Por ejemplo, imagine que los niveles de proteína en sangre en personas enfermas y personas sanas se distribuyen normalmente con medias de 2 g / dL y 1 g/dL respectivamente. Una prueba médica puede medir el nivel de una determinada proteína en una muestra de sangre y clasificar cualquier número por encima de cierto umbral como indicativo de enfermedad. El experimentador puede ajustar el umbral (línea vertical verde en la figura), lo que a su vez cambiará la tasa de falsos positivos. Aumentar el umbral daría como resultado menos falsos positivos (y más falsos negativos), lo que correspondería a un movimiento hacia la izquierda en la curva. La forma real de la curva está determinada por el grado de superposición que tienen las dos distribuciones.

Varios estudios critican determinadas aplicaciones de la curva ROC y su área bajo la curva como medidas para evaluar clasificaciones binarias cuando no capturan la información relevante para la aplicación. [18] [17] [19] [20] [21]

La principal crítica a la curva ROC descrita en estos estudios se refiere a la incorporación de áreas con baja sensibilidad y baja especificidad (ambas inferiores a 0,5) para el cálculo del área total bajo la curva (AUC), [19] como se describe en el trama de la derecha.

Según los autores de estos estudios, esa porción del área bajo la curva (con baja sensibilidad y baja especificidad) se refiere a matrices de confusión donde las predicciones binarias obtienen malos resultados y, por lo tanto, no debe incluirse en la evaluación del desempeño general. Además, esa parte del AUC indica un espacio con un umbral de matriz de confusión alto o bajo que rara vez es de interés para los científicos que realizan una clasificación binaria en cualquier campo. [19]

Otra crítica a la República de China y su área bajo la curva es que no dicen nada sobre la precisión y el valor predictivo negativo. [17]

Un AUC de ROC alto, como 0,9 por ejemplo, podría corresponder a valores bajos de precisión y valor predictivo negativo, como 0,2 y 0,1 en el rango [0, 1]. Si uno realizara una clasificación binaria, obtuviera un AUC ROC de 0,9 y decidiera centrarse solo en esta métrica, podría creer de manera demasiado optimista que su prueba binaria fue excelente. Sin embargo, si esta persona observara los valores de precisión y valor predictivo negativo, podría descubrir que sus valores son bajos.

El AUC de la República de China resume la sensibilidad y la especificidad, pero no informa sobre la precisión y el valor predictivo negativo. [17]

A veces, la República de China se utiliza para generar una estadística resumida. Las versiones comunes son:

Sin embargo, cualquier intento de resumir la curva ROC en un solo número pierde información sobre el patrón de compensaciones del algoritmo discriminador particular.

El área bajo la curva (a menudo denominada simplemente AUC) es igual a la probabilidad de que un clasificador clasifique una instancia positiva elegida al azar por encima de una negativa elegida al azar (suponiendo que "positivo" tenga una clasificación más alta que "negativa"). [26] En otras palabras, cuando se le da una instancia positiva seleccionada al azar y una instancia negativa seleccionada al azar, AUC es la probabilidad de que el clasificador pueda decir cuál es cuál.

Esto se puede ver de la siguiente manera: el área bajo la curva está dada por (los límites integrales se invierten ya que el umbral grande tiene un valor más bajo en el eje x)

donde es la puntuación de una instancia positiva y es la puntuación de una instancia negativa, y son densidades de probabilidad definidas en la sección anterior.

Se puede demostrar que el AUC está estrechamente relacionado con la U de Mann-Whitney , [27] [28] que prueba si los positivos se clasifican por encima de los negativos. Para un predictor , un estimador insesgado de su AUC se puede expresar mediante el siguiente estadístico de Wilcoxon-Mann-Whitney : [29]

donde denota una función indicadora que devuelve 1 en caso contrario devuelve 0; es el conjunto de ejemplos negativos y es el conjunto de ejemplos positivos.

En el contexto de la calificación crediticia , a menudo se utiliza una versión reescalada de AUC:

.

Se le conoce como índice de Gini o coeficiente de Gini, [30] pero no debe confundirse con la medida de dispersión estadística que también se llama coeficiente de Gini . es un caso especial de la D de Somers .

También es común calcular el área bajo el casco convexo de la República de China (ROC AUCH = ROCH AUC), ya que cualquier punto en el segmento de línea entre dos resultados de predicción se puede lograr usando aleatoriamente uno u otro sistema con probabilidades proporcionales a la longitud relativa de el componente opuesto del segmento. [31] También es posible invertir las concavidades, tal como en la figura la peor solución puede reflejarse para convertirse en una mejor solución; Las concavidades pueden reflejarse en cualquier segmento de línea, pero es mucho más probable que esta forma más extrema de fusión se ajuste demasiado a los datos. [32]

La comunidad de aprendizaje automático utiliza con mayor frecuencia la estadística ROC AUC para comparar modelos. [33] Esta práctica ha sido cuestionada porque las estimaciones del AUC son bastante ruidosas y adolecen de otros problemas. [34] [35] [36] No obstante, la coherencia del AUC como medida del desempeño de la clasificación agregada ha sido reivindicada, en términos de una distribución de tasas uniforme, [37] y el AUC se ha vinculado a una serie de otras métricas de desempeño, como como la puntuación de Brier . [38]

Otro problema con ROC AUC es que reducir la curva ROC a un solo número ignora el hecho de que se trata de las compensaciones entre los diferentes sistemas o puntos de rendimiento trazados y no del rendimiento de un sistema individual, además de ignorar la posibilidad de reparación de la concavidad. , por lo que se recomiendan medidas alternativas relacionadas, como la información [ cita necesaria ] o DeltaP. [23] [39] Estas medidas son esencialmente equivalentes al Gini para un único punto de predicción con DeltaP' = Información = 2AUC-1, mientras que DeltaP = Marcación representa el dual (es decir, predecir la predicción a partir de la clase real) y su geometría. La media es el coeficiente de correlación de Matthews . [ cita necesaria ]

Mientras que el AUC de la República de China varía entre 0 y 1, con un clasificador no informativo que arroja 0,5, las medidas alternativas conocidas como Información , [ cita necesaria ] Certeza [23] y Coeficiente de Gini (en el caso de parametrización única o sistema único) [ cita necesaria ] todas tienen la ventaja de que 0 representa un desempeño aleatorio, mientras que 1 representa un desempeño perfecto, y −1 representa el caso "perverso" de plena información que siempre da la respuesta incorrecta. [40] Llevar el rendimiento de probabilidad a 0 permite que estas escalas alternativas se interpreten como estadísticas Kappa. Se ha demostrado que la información tiene características deseables para el aprendizaje automático frente a otras definiciones comunes de Kappa, como Cohen Kappa y Fleiss Kappa . [ cita necesaria ] [41]

A veces puede resultar más útil observar una región específica de la curva ROC que toda la curva. Es posible calcular el AUC parcial . [42] Por ejemplo, uno podría centrarse en la región de la curva con una baja tasa de falsos positivos, que a menudo es de gran interés para las pruebas de detección de la población. [43] Otro enfoque común para los problemas de clasificación en los que P ≪ N (común en aplicaciones bioinformáticas) es utilizar una escala logarítmica para el eje x. [44]

El área ROC bajo la curva también se llama estadístico c o estadístico c . [45]

La característica operativa total (TOC) también caracteriza la capacidad de diagnóstico y revela más información que la ROC. Para cada umbral, la República de China revela dos proporciones, TP/(TP + FN) y FP/(FP + TN). En otras palabras, la República de China revela y . Por otro lado, TOC muestra la información total en la tabla de contingencia para cada umbral. [46] El método TOC revela toda la información que proporciona el método ROC, además de información adicional importante que ROC no revela, es decir, el tamaño de cada entrada en la tabla de contingencia para cada umbral. TOC también proporciona las populares AUC de la República de China. [47]

Estas cifras son las curvas TOC y ROC que utilizan los mismos datos y umbrales. Considere el punto que corresponde a un umbral de 74. La curva TOC muestra el número de aciertos, que es 3, y por tanto el número de fallos, que es 7. Además, la curva TOC muestra que el número de falsas alarmas es 4 y el número de rechazos correctos es 16. En cualquier punto dado de la curva ROC, es posible obtener valores para las proporciones de y . Por ejemplo, en el umbral 74, es evidente que la coordenada x es 0,2 y la coordenada y es 0,3. Sin embargo, estos dos valores son insuficientes para construir todas las entradas de la tabla de contingencia subyacente de dos por dos.

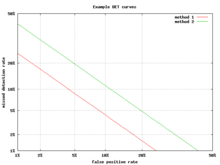

Una alternativa a la curva ROC es el gráfico de compensación de errores de detección (DET), que traza la tasa de falsos negativos (detecciones perdidas) frente a la tasa de falsos positivos (falsas alarmas) en los ejes x e y transformados no linealmente. La función de transformación es la función cuantil de la distribución normal, es decir, la inversa de la distribución normal acumulativa. De hecho, es la misma transformación que zROC, a continuación, excepto que se utiliza el complemento de la tasa de aciertos, la tasa de errores o la tasa de falsos negativos. Esta alternativa dedica más área del gráfico a la región de interés. La mayor parte del área de la República de China es de poco interés; uno se preocupa principalmente por la región estrecha contra el eje y y la esquina superior izquierda, que, debido al uso de la tasa de fallos en lugar de su complemento, la tasa de aciertos, es la esquina inferior izquierda en un gráfico DET. Además, los gráficos DET tienen la útil propiedad de linealidad y un comportamiento de umbral lineal para distribuciones normales. [48] El gráfico DET se utiliza ampliamente en la comunidad de reconocimiento automático de hablantes , donde se utilizó por primera vez el nombre DET. El análisis del desempeño de la República de China en gráficos con esta deformación de los ejes fue utilizado por los psicólogos en estudios de percepción a mediados del siglo XX, [ cita necesaria ] donde se lo denominó "artículo de doble probabilidad". [49]

Si se aplica una puntuación estándar a la curva ROC, la curva se transformará en una línea recta. [50] Esta puntuación z se basa en una distribución normal con una media de cero y una desviación estándar de uno. En la teoría de la fuerza de la memoria , se debe suponer que el zROC no solo es lineal, sino que tiene una pendiente de 1,0. La distribución normal de objetivos (objetos estudiados que los sujetos necesitan recordar) y señuelos (objetos no estudiados que los sujetos intentan recordar) es el factor que hace que el zROC sea lineal.

La linealidad de la curva zROC depende de las desviaciones estándar de las distribuciones de fuerza del objetivo y del señuelo. Si las desviaciones estándar son iguales, la pendiente será 1,0. Si la desviación estándar de la distribución de la fuerza del objetivo es mayor que la desviación estándar de la distribución de la fuerza del señuelo, entonces la pendiente será menor que 1,0. En la mayoría de los estudios, se ha descubierto que las pendientes de la curva zROC caen constantemente por debajo de 1, normalmente entre 0,5 y 0,9. [51] Muchos experimentos arrojaron una pendiente zROC de 0,8. Una pendiente de 0,8 implica que la variabilidad de la distribución de la fuerza del objetivo es un 25% mayor que la variabilidad de la distribución de la fuerza del señuelo. [52]

Otra variable utilizada es d' (d prima) (analizada anteriormente en "Otras medidas"), que se puede expresar fácilmente en términos de valores z. Aunque d ' es un parámetro comúnmente utilizado, debe reconocerse que sólo es relevante cuando se adhiere estrictamente a los supuestos muy sólidos de la teoría de la resistencia formulados anteriormente. [53]

La puntuación z de una curva ROC siempre es lineal, como se supone, excepto en situaciones especiales. El modelo de familiaridad-recuerdo de Yonelinas es un relato bidimensional de la memoria de reconocimiento. En lugar de que el sujeto simplemente responda sí o no a una entrada específica, el sujeto le da a la entrada una sensación de familiaridad, que funciona como la curva ROC original. Sin embargo, lo que cambia es un parámetro para Recuerdo (R). Se supone que el recuerdo es todo o nada y triunfa sobre la familiaridad. Si no hubiera un componente de recolección, zROC tendría una pendiente prevista de 1. Sin embargo, al agregar el componente de recolección, la curva de zROC será cóncava hacia arriba, con una pendiente disminuida. Esta diferencia en forma y pendiente resulta de un elemento añadido de variabilidad debido a la recolección de algunos elementos. Los pacientes con amnesia anterógrada no pueden recordar, por lo que su curva zROC de Yonelinas tendría una pendiente cercana a 1,0. [54]

La curva ROC se utilizó por primera vez durante la Segunda Guerra Mundial para el análisis de señales de radar antes de ser empleada en la teoría de detección de señales . [55] Tras el ataque a Pearl Harbor en 1941, el ejército de los Estados Unidos comenzó una nueva investigación para aumentar la predicción de aviones japoneses correctamente detectados a partir de sus señales de radar. Para estos fines midieron la capacidad del operador de un receptor de radar para hacer estas importantes distinciones, lo que se denominó Característica Operativa del Receptor. [56]

En la década de 1950, las curvas ROC se empleaban en psicofísica para evaluar la detección de señales débiles en humanos (y ocasionalmente en animales no humanos). [55] En medicina , el análisis ROC se ha utilizado ampliamente en la evaluación de pruebas de diagnóstico . [57] [58] Las curvas ROC también se utilizan ampliamente en epidemiología e investigación médica y se mencionan con frecuencia junto con la medicina basada en evidencia . En radiología , el análisis ROC es una técnica común para evaluar nuevas técnicas de radiología. [59] En las ciencias sociales, el análisis ROC a menudo se denomina índice de precisión de la ROC, una técnica común para juzgar la precisión de los modelos de probabilidad de incumplimiento. Las curvas ROC se utilizan ampliamente en medicina de laboratorio para evaluar la precisión diagnóstica de una prueba, elegir el punto de corte óptimo de una prueba y comparar la precisión diagnóstica de varias pruebas.

Las curvas ROC también resultaron útiles para la evaluación de técnicas de aprendizaje automático . La primera aplicación de ROC en el aprendizaje automático fue la de Spackman, quien demostró el valor de las curvas ROC al comparar y evaluar diferentes algoritmos de clasificación . [60]

Las curvas ROC también se utilizan en la verificación de pronósticos en meteorología. [61]

Como se mencionó, las curvas ROC son fundamentales para la teoría y el funcionamiento del radar . Las señales recibidas en una estación receptora, reflejadas por un objetivo, suelen tener muy poca energía, en comparación con el ruido de fondo . La relación entre señal y ruido es una métrica importante a la hora de determinar si se detectará un objetivo. Esta relación señal-ruido está directamente correlacionada con las características operativas del receptor de todo el sistema de radar, que se utiliza para cuantificar la capacidad de un sistema de radar.

Consideremos el desarrollo de un sistema de radar. Se puede proporcionar una especificación de las capacidades del sistema en términos de probabilidad de detección, con una cierta tolerancia a falsas alarmas . Se puede calcular una aproximación simplificada de la relación señal-ruido requerida en la estación receptora resolviendo [62]

para la relación señal/ruido . Aquí, no está en decibeles , como es habitual en muchas aplicaciones de radar. La conversión a decibelios se realiza mediante . A partir de esta figura, se pueden resolver las entradas comunes en la ecuación de alcance del radar (con factores de ruido) para estimar la potencia radiada efectiva requerida .

La extensión de las curvas ROC para problemas de clasificación con más de dos clases es engorrosa. Dos enfoques comunes cuando hay varias clases son (1) promediar todos los valores AUC por pares [63] y (2) calcular el volumen bajo la superficie (VUS). [64] [65] Para promediar todas las clases por pares, se calcula el AUC para cada par de clases, utilizando solo los ejemplos de esas dos clases como si no hubiera otras clases, y luego se promedian estos valores de AUC sobre todos los pares posibles. Cuando haya c clases, habrá c ( c − 1) / 2 posibles pares de clases.

El enfoque de volumen bajo la superficie consiste en trazar una hipersuperficie en lugar de una curva y luego medir el hipervolumen debajo de esa hipersuperficie. Cada posible regla de decisión que uno podría usar para un clasificador para c clases puede describirse en términos de sus tasas positivas verdaderas (TPR 1 ,..., TPR c ) . Es este conjunto de tasas el que define un punto, y el conjunto de todas las reglas de decisión posibles produce una nube de puntos que definen la hipersuperficie. Con esta definición, la VUS es la probabilidad de que el clasificador pueda etiquetar correctamente todos los c ejemplos cuando se le proporciona un conjunto que tiene un ejemplo seleccionado aleatoriamente de cada clase. La implementación de un clasificador que sabe que su conjunto de entrada consta de un ejemplo de cada clase podría primero calcular una puntuación de bondad de ajuste para cada uno de los c 2 posibles emparejamientos de un ejemplo con una clase, y luego emplear el algoritmo húngaro para maximizar la suma de las c puntuaciones seleccionadas sobre todo c ! posibles formas de asignar exactamente un ejemplo a cada clase.

Dado el éxito de las curvas ROC para la evaluación de modelos de clasificación, también se ha investigado la extensión de las curvas ROC para otras tareas supervisadas. Propuestas notables para problemas de regresión son las llamadas curvas de característica de error de regresión (REC) [66] y las curvas de regresión ROC (RROC). [67] En este último, las curvas RROC se vuelven extremadamente similares a las curvas ROC para la clasificación, con las nociones de asimetría, dominancia y casco convexo. Además, el área bajo las curvas RROC es proporcional a la varianza del error del modelo de regresión.

{{cite journal}}: CS1 maint: multiple names: authors list (link){{cite journal}}: CS1 maint: multiple names: authors list (link){{cite journal}}: CS1 maint: multiple names: authors list (link){{cite journal}}: CS1 maint: multiple names: authors list (link){{cite journal}}: CS1 maint: multiple names: authors list (link)