La ingeniería de confiabilidad es una subdisciplina de la ingeniería de sistemas que enfatiza la capacidad de un equipo para funcionar sin fallas. La confiabilidad se define como la probabilidad de que un producto, sistema o servicio realice su función prevista de manera adecuada durante un período de tiempo específico, O que funcione en un entorno definido sin fallas. [1] La confiabilidad está estrechamente relacionada con la disponibilidad , que generalmente se describe como la capacidad de un componente o sistema para funcionar en un momento o intervalo de tiempo específico.

La función de confiabilidad se define teóricamente como la probabilidad de éxito. En la práctica, se calcula utilizando diferentes técnicas y su valor varía entre 0 y 1, donde 0 indica que no hay probabilidad de éxito, mientras que 1 indica un éxito definitivo. Esta probabilidad se estima a partir de un análisis detallado (física de fallas), conjuntos de datos anteriores o mediante pruebas y modelos de confiabilidad. La disponibilidad , la capacidad de prueba , la mantenibilidad y el mantenimiento se definen a menudo como parte de la "ingeniería de confiabilidad" en los programas de confiabilidad. La confiabilidad a menudo juega un papel clave en la relación costo-efectividad de los sistemas.

La ingeniería de confiabilidad se ocupa de la predicción, prevención y gestión de altos niveles de incertidumbre de ingeniería de " vida útil " y riesgos de falla. Aunque los parámetros estocásticos definen y afectan la confiabilidad, la confiabilidad no solo se logra mediante matemáticas y estadísticas. [2] [3] "Casi toda la enseñanza y la literatura sobre el tema enfatizan estos aspectos e ignoran la realidad de que los rangos de incertidumbre involucrados invalidan en gran medida los métodos cuantitativos para la predicción y la medición". [4] Por ejemplo, es fácil representar la "probabilidad de falla" como un símbolo o valor en una ecuación, pero es casi imposible predecir su verdadera magnitud en la práctica, que es masivamente multivariada , por lo que tener la ecuación para la confiabilidad no equivale ni de lejos a tener una medición predictiva precisa de la confiabilidad.

La ingeniería de confiabilidad se relaciona estrechamente con la ingeniería de calidad, la ingeniería de seguridad y la seguridad del sistema , ya que utilizan métodos comunes para su análisis y pueden requerir aportes mutuos. Se puede decir que un sistema debe ser confiablemente seguro.

La ingeniería de confiabilidad se centra en los costos de fallas causadas por el tiempo de inactividad del sistema, el costo de los repuestos, el equipo de reparación, el personal y el costo de los reclamos de garantía. [5]

La palabra confiabilidad se remonta a 1816 y el primer testimonio se debe al poeta Samuel Taylor Coleridge . [6] Antes de la Segunda Guerra Mundial, el término se vinculaba principalmente a la repetibilidad ; una prueba (en cualquier tipo de ciencia) se consideraba "confiable" si se obtenían repetidamente los mismos resultados. En la década de 1920, el Dr. Walter A. Shewhart promovió la mejora del producto mediante el uso del control estadístico de procesos en Bell Labs , [7] en la época en que Waloddi Weibull estaba trabajando en modelos estadísticos para la fatiga. El desarrollo de la ingeniería de confiabilidad estaba aquí en un camino paralelo con la calidad. El uso moderno de la palabra confiabilidad fue definido por el ejército estadounidense en la década de 1940, caracterizando un producto que funcionaría cuando se esperaba y durante un período específico.

En la Segunda Guerra Mundial, muchos problemas de fiabilidad se debieron a la falta de fiabilidad inherente de los equipos electrónicos disponibles en ese momento y a problemas de fatiga. En 1945, MA Miner publicó un artículo seminal titulado "Cumulative Damage in Fatigue" en una revista de ASME. Una de las principales aplicaciones de la ingeniería de fiabilidad en el ámbito militar fue el tubo de vacío utilizado en los sistemas de radar y otros dispositivos electrónicos, para los que la fiabilidad resultó ser muy problemática y costosa. El IEEE formó la Reliability Society en 1948. En 1950, el Departamento de Defensa de los Estados Unidos formó un grupo llamado "Advisory Group on the Reliability of Electronic Equipment" (Grupo Asesor sobre la Fiabilidad de los Equipos Electrónicos) (AGREE) para investigar los métodos de fiabilidad de los equipos militares. [8] Este grupo recomendó tres formas principales de trabajar:

En la década de 1960, se dio más énfasis a las pruebas de confiabilidad a nivel de componentes y sistemas. En esa época se creó el famoso estándar militar MIL-STD-781. En esa época, también se publicó el predecesor del manual militar 217, muy utilizado por la RCA , que se utilizó para predecir las tasas de fallas de los componentes electrónicos. El énfasis en la confiabilidad de los componentes y la investigación empírica (por ejemplo, Mil Std 217) disminuyó lentamente. Se estaban utilizando enfoques más pragmáticos, como los utilizados en las industrias de consumo. En la década de 1980, los televisores se componía cada vez más de semiconductores de estado sólido. Los automóviles aumentaron rápidamente el uso de semiconductores con una variedad de microcomputadoras debajo del capó y en el tablero. Los grandes sistemas de aire acondicionado desarrollaron controladores electrónicos, al igual que los hornos microondas y una variedad de otros electrodomésticos. Los sistemas de comunicaciones comenzaron a adoptar la electrónica para reemplazar los antiguos sistemas de conmutación mecánica. Bellcore publicó la primera metodología de predicción del consumidor para telecomunicaciones, y SAE desarrolló un documento similar SAE870050 para aplicaciones automotrices. La naturaleza de las predicciones evolucionó durante la década, y se hizo evidente que la complejidad de la matriz no era el único factor que determinaba las tasas de falla de los circuitos integrados (CI). Kam Wong publicó un artículo cuestionando la curva de la bañera [9] —ver también mantenimiento centrado en la confiabilidad . Durante esta década, la tasa de falla de muchos componentes se redujo en un factor de 10. El software se volvió importante para la confiabilidad de los sistemas. En la década de 1990, el ritmo de desarrollo de CI estaba aumentando. El uso más amplio de microcomputadoras independientes era común, y el mercado de PC ayudó a mantener las densidades de CI siguiendo la ley de Moore y duplicándose aproximadamente cada 18 meses. La ingeniería de confiabilidad ahora estaba cambiando a medida que avanzaba hacia la comprensión de la física de la falla . Las tasas de falla de los componentes siguieron cayendo, pero los problemas a nivel de sistema se volvieron más prominentes. El pensamiento sistémico se ha vuelto cada vez más importante. Para el software, se desarrolló el modelo CMM ( Capability Maturity Model ), que proporcionó un enfoque más cualitativo a la confiabilidad. ISO 9000 agregó medidas de confiabilidad como parte de la parte de diseño y desarrollo de la certificación. La expansión de la World Wide Web creó nuevos desafíos en materia de seguridad y confianza. El antiguo problema de la escasez de información fiable disponible había sido sustituido por una excesiva cantidad de información de valor cuestionable. Los problemas de fiabilidad de los consumidores podían ahora discutirse en línea en tiempo real utilizando datos. Nuevas tecnologías como los sistemas microelectromecánicos ( MEMS ), los GPS portátilesLos dispositivos portátiles que combinan teléfonos celulares y computadoras representan desafíos para mantener la confiabilidad. El tiempo de desarrollo de productos siguió acortándose durante esta década y lo que se había logrado en tres años se estaba logrando en 18 meses. Esto significó que las herramientas y tareas de confiabilidad debían estar más estrechamente vinculadas al proceso de desarrollo en sí. En muchos sentidos, la confiabilidad se ha convertido en parte de la vida cotidiana y de las expectativas de los consumidores.

La confiabilidad es la probabilidad de que un producto realice su función prevista en condiciones operativas específicas de una manera que cumpla o supere las expectativas del cliente. [10]

Los objetivos de la ingeniería de confiabilidad, en orden decreciente de prioridad, son: [11]

La razón de este énfasis prioritario es que es, con diferencia, la forma más eficaz de trabajar, en términos de minimizar costes y generar productos fiables. Las principales competencias que se requieren, por tanto, son la capacidad de comprender y anticipar las posibles causas de los fallos, y saber cómo prevenirlos. También es necesario conocer los métodos que se pueden utilizar para analizar los diseños y los datos.

La ingeniería de confiabilidad para " sistemas complejos " requiere un enfoque de sistemas diferente y más elaborado que el de los sistemas no complejos. En ese caso, la ingeniería de confiabilidad puede implicar:

Una ingeniería de confiabilidad eficaz requiere comprender los conceptos básicos de los mecanismos de falla , para lo cual se requiere experiencia, amplias habilidades de ingeniería y un buen conocimiento de muchos campos especiales diferentes de la ingeniería, [12] por ejemplo:

La confiabilidad puede definirse de las siguientes maneras:

En las evaluaciones de riesgo de confiabilidad se utilizan muchas técnicas de ingeniería , como diagramas de bloques de confiabilidad, análisis de peligros , análisis de modos de falla y efectos (FMEA), [13] análisis de árboles de fallas (FTA), mantenimiento centrado en la confiabilidad , cálculos (probabilísticos) de carga y estrés y desgaste de materiales, análisis (probabilísticos) de fatiga y fluencia, análisis de errores humanos, análisis de defectos de fabricación, pruebas de confiabilidad, etc. Estos análisis deben realizarse correctamente y con mucha atención al detalle para que sean efectivos. Debido a la gran cantidad de técnicas de confiabilidad, su costo y los diferentes grados de confiabilidad requeridos para diferentes situaciones, la mayoría de los proyectos desarrollan un plan de programa de confiabilidad para especificar las tareas de confiabilidad ( requisitos de declaración de trabajo (SoW)) que se realizarán para ese sistema específico.

En consonancia con la creación de casos de seguridad , por ejemplo según ARP4761 , el objetivo de las evaluaciones de confiabilidad es proporcionar un conjunto sólido de evidencia cualitativa y cuantitativa de que el uso de un componente o sistema no estará asociado con un riesgo inaceptable. Los pasos básicos a seguir [14] son:

El riesgo aquí es la combinación de probabilidad y gravedad de que ocurra el incidente (escenario) de falla. La gravedad puede analizarse desde el punto de vista de la seguridad del sistema o de la disponibilidad del sistema. La confiabilidad para la seguridad puede considerarse un enfoque muy diferente de la confiabilidad para la disponibilidad del sistema. La disponibilidad y la seguridad pueden existir en tensión dinámica, ya que mantener un sistema demasiado disponible puede ser inseguro. Forzar un sistema de ingeniería a un estado seguro demasiado rápido puede provocar falsas alarmas que impidan la disponibilidad del sistema.

En una definición de minimis , la gravedad de las fallas incluye el costo de las piezas de repuesto, las horas de trabajo, la logística, los daños (fallas secundarias) y el tiempo de inactividad de las máquinas que pueden causar pérdidas de producción. Una definición más completa de falla también puede significar lesiones, desmembramiento y muerte de personas dentro del sistema (como lo demuestran los accidentes mineros, los accidentes industriales, las fallas de los transbordadores espaciales) y lo mismo para los transeúntes inocentes (como lo demuestran los ciudadanos de ciudades como Bhopal, Love Canal, Chernobyl o Sendai, y otras víctimas del terremoto y tsunami de Tōhoku de 2011); en este caso, la ingeniería de confiabilidad se convierte en seguridad del sistema. Lo que es aceptable lo determina la autoridad administrativa, los clientes o las comunidades afectadas. El riesgo residual es el riesgo que queda después de que todas las actividades de confiabilidad han terminado e incluye el riesgo no identificado, y por lo tanto no es completamente cuantificable.

La complejidad de los sistemas técnicos, como las mejoras de diseño y materiales, las inspecciones planificadas, el diseño a prueba de errores y la redundancia de respaldo, disminuyen el riesgo y aumentan el costo. El riesgo se puede reducir a niveles ALARA (tan bajo como sea razonablemente alcanzable) o ALAPA (tan bajo como sea prácticamente alcanzable).

La implementación de un programa de confiabilidad no es simplemente una compra de software, ni una lista de elementos que se deben completar para garantizar que se cuente con productos y procesos confiables. Un programa de confiabilidad es un sistema complejo basado en el aprendizaje y el conocimiento, exclusivo de los productos y procesos de una empresa. Está respaldado por el liderazgo, se basa en las habilidades que se desarrollan dentro de un equipo, se integra en los procesos de negocios y se ejecuta siguiendo prácticas laborales estándar comprobadas. [15]

Un plan de programa de confiabilidad se utiliza para documentar exactamente qué "mejores prácticas" (tareas, métodos, herramientas, análisis y pruebas) se requieren para un (sub)sistema en particular, así como para aclarar los requisitos del cliente para la evaluación de la confiabilidad. Para sistemas complejos a gran escala, el plan de programa de confiabilidad debe ser un documento separado . La determinación de recursos para la mano de obra y los presupuestos para pruebas y otras tareas es fundamental para el éxito del programa. En general, la cantidad de trabajo necesaria para un programa eficaz para sistemas complejos es grande.

Un plan de programa de confiabilidad es esencial para lograr altos niveles de confiabilidad, capacidad de prueba, mantenibilidad y la disponibilidad del sistema resultante , y se desarrolla en las primeras etapas del desarrollo del sistema y se perfecciona durante el ciclo de vida del sistema. Especifica no solo lo que hace el ingeniero de confiabilidad, sino también las tareas que realizan otras partes interesadas . Un plan de programa de confiabilidad efectivo debe ser aprobado por la alta gerencia del programa, que es responsable de la asignación de recursos suficientes para su implementación.

Un plan de programa de confiabilidad también puede utilizarse para evaluar y mejorar la disponibilidad de un sistema con la estrategia de centrarse en aumentar la capacidad de prueba y mantenimiento y no en la confiabilidad. Mejorar la capacidad de mantenimiento es generalmente más fácil que mejorar la confiabilidad. Las estimaciones de capacidad de mantenimiento (tasas de reparación) también son generalmente más precisas. Sin embargo, debido a que las incertidumbres en las estimaciones de confiabilidad son en la mayoría de los casos muy grandes, es probable que dominen el cálculo de disponibilidad (problema de incertidumbre de predicción), incluso cuando los niveles de capacidad de mantenimiento son muy altos. Cuando la confiabilidad no está bajo control, pueden surgir problemas más complicados, como escasez de mano de obra (mantenedores/capacidad de servicio al cliente), disponibilidad de repuestos, demoras logísticas, falta de instalaciones de reparación, costos extensos de modernización y gestión de configuración compleja, y otros. El problema de la falta de confiabilidad también puede aumentar debido al "efecto dominó" de fallas inducidas por el mantenimiento después de las reparaciones. Por lo tanto, centrarse solo en la capacidad de mantenimiento no es suficiente. Si se previenen las fallas, ninguno de los otros problemas tiene importancia y, por lo tanto, la confiabilidad generalmente se considera la parte más importante de la disponibilidad. La confiabilidad debe evaluarse y mejorarse en relación con la disponibilidad y el costo total de propiedad (TCO) debido al costo de las piezas de repuesto, las horas de mantenimiento, los costos de transporte, los costos de almacenamiento, los riesgos de obsolescencia de las piezas, etc. Pero, como GM y Toyota descubrieron tardíamente, el TCO también incluye los costos de responsabilidad posteriores cuando los cálculos de confiabilidad no han abordado de manera suficiente o precisa los riesgos físicos de los clientes. A menudo, se necesita un equilibrio entre los dos. Puede haber una relación máxima entre la disponibilidad y el costo de propiedad. La capacidad de prueba de un sistema también debe abordarse en el plan, ya que este es el vínculo entre la confiabilidad y la capacidad de mantenimiento. La estrategia de mantenimiento puede influir en la confiabilidad de un sistema (por ejemplo, mediante mantenimiento preventivo y/o predictivo ), aunque nunca puede llevarla por encima de la confiabilidad inherente.

El plan de confiabilidad debe proporcionar claramente una estrategia para el control de la disponibilidad. El que sea más importante solo la disponibilidad o también el costo de propiedad depende del uso del sistema. Por ejemplo, un sistema que es un eslabón crítico en un sistema de producción (por ejemplo, una gran plataforma petrolífera) normalmente puede tener un costo de propiedad muy alto si ese costo se traduce en un aumento incluso menor de la disponibilidad, ya que la falta de disponibilidad de la plataforma da como resultado una pérdida masiva de ingresos que puede superar fácilmente el alto costo de propiedad. Un plan de confiabilidad adecuado siempre debe abordar el análisis RAMT en su contexto total. RAMT significa confiabilidad, disponibilidad, mantenibilidad/mantenimiento y capacidad de prueba en el contexto de las necesidades del cliente.

Para cualquier sistema, una de las primeras tareas de la ingeniería de confiabilidad es especificar adecuadamente los requisitos de confiabilidad y mantenibilidad asignados a partir de las necesidades generales de disponibilidad y, lo que es más importante, derivados de un análisis de fallas de diseño adecuado o de los resultados preliminares de pruebas de prototipos. Los requisitos claros (que se puedan diseñar) deben restringir a los diseñadores de diseñar elementos/construcciones/interfaces/sistemas no confiables particulares. Establecer solo objetivos de disponibilidad, confiabilidad, capacidad de prueba o capacidad de mantenimiento (por ejemplo, tasas máximas de falla) no es apropiado. Este es un malentendido general sobre la ingeniería de requisitos de confiabilidad. Los requisitos de confiabilidad abordan el sistema en sí, incluidos los requisitos de prueba y evaluación, y las tareas y la documentación asociadas. Los requisitos de confiabilidad se incluyen en las especificaciones de requisitos del sistema o subsistema apropiados, los planes de prueba y las declaraciones contractuales. La creación de requisitos de nivel inferior adecuados es fundamental. [16] La provisión solo de objetivos mínimos cuantitativos (por ejemplo, valores de tiempo medio entre fallas (MTBF) o tasas de falla) no es suficiente por diferentes razones. Una de las razones es que (a menudo) no se puede realizar una validación completa (relacionada con la exactitud y verificabilidad en el tiempo) de una asignación de confiabilidad cuantitativa (especificación de requisitos) en niveles inferiores para sistemas complejos como consecuencia de (1) el hecho de que los requisitos son probabilísticos, (2) el nivel extremadamente alto de incertidumbres involucradas para demostrar el cumplimiento de todos estos requisitos probabilísticos y porque (3) la confiabilidad es una función del tiempo y las estimaciones precisas de un número de confiabilidad (probabilística) por elemento están disponibles solo muy tarde en el proyecto, a veces incluso después de muchos años de uso en servicio. Compare este problema con el (re)equilibrio continuo de, por ejemplo, los requisitos de masa del sistema de nivel inferior en el desarrollo de una aeronave, que ya es a menudo una gran tarea. Observe que en este caso, las masas solo difieren en términos de solo un cierto porcentaje, no son una función del tiempo y los datos no son probabilísticos y ya están disponibles en modelos CAD. En el caso de la confiabilidad, los niveles de falta de confiabilidad (tasas de falla) pueden cambiar con factores de décadas (múltiplos de 10) como resultado de desviaciones muy menores en el diseño, el proceso o cualquier otra cosa. [17]La información no suele estar disponible sin grandes incertidumbres en la fase de desarrollo. Esto hace que este problema de asignación sea casi imposible de resolver de una manera útil, práctica y válida que no dé como resultado una sobreespecificación o subespecificación masiva. Por lo tanto, se necesita un enfoque pragmático; por ejemplo, el uso de niveles/clases generales de requisitos cuantitativos que dependan únicamente de la gravedad de los efectos de falla. Además, la validación de los resultados es una tarea mucho más subjetiva que cualquier otro tipo de requisito. Los parámetros de confiabilidad (cuantitativos) -en términos de MTBF- son, con mucho, los parámetros de diseño más inciertos en cualquier diseño.

Además, los requisitos de diseño de confiabilidad deben impulsar un diseño (de sistema o de pieza) para incorporar características que eviten que ocurran fallas o limiten las consecuencias de una falla en primer lugar. No solo ayudaría en algunas predicciones, este esfuerzo evitaría distraer el esfuerzo de ingeniería hacia una especie de trabajo de contabilidad. Un requisito de diseño debe ser lo suficientemente preciso para que un diseñador pueda "diseñar para" él y también pueda demostrar, mediante análisis o pruebas, que el requisito se ha cumplido y, si es posible, dentro de un cierto nivel de confianza establecido. Cualquier tipo de requisito de confiabilidad debe ser detallado y podría derivarse del análisis de fallas (análisis de fatiga y estrés de elementos finitos, análisis de riesgos de confiabilidad, FTA, FMEA, análisis de factores humanos, análisis de riesgos funcionales, etc.) o cualquier tipo de prueba de confiabilidad. Además, se necesitan requisitos para pruebas de verificación (por ejemplo, tensiones de sobrecarga requeridas) y el tiempo de prueba necesario. Para derivar estos requisitos de manera efectiva, se debe utilizar una lógica de mitigación y evaluación de riesgos basada en ingeniería de sistemas . Se deben crear sistemas de registro de riesgos robustos que contengan información detallada sobre por qué y cómo los sistemas podrían o han fallado. Los requisitos se deben derivar y controlar de esta manera. Estos requisitos prácticos de diseño deben guiar el diseño y no utilizarse solo con fines de verificación. Estos requisitos (a menudo restricciones de diseño) se derivan de esta manera del análisis de fallas o pruebas preliminares. La comprensión de esta diferencia en comparación con la especificación de requisitos puramente cuantitativos (logísticos) (por ejemplo, tasa de fallas / objetivo de MTBF) es fundamental para el desarrollo de sistemas exitosos (complejos). [18]

Los requisitos de mantenibilidad abordan los costos de las reparaciones, así como el tiempo de reparación. Los requisitos de capacidad de prueba (que no deben confundirse con los requisitos de prueba) proporcionan el vínculo entre la confiabilidad y la capacidad de mantenimiento y deben abordar la detectabilidad de los modos de falla (en un nivel de sistema particular), los niveles de aislamiento y la creación de diagnósticos (procedimientos). Como se indicó anteriormente, los ingenieros de confiabilidad también deben abordar los requisitos para varias tareas de confiabilidad y documentación durante el desarrollo, prueba, producción y operación del sistema. Estos requisitos generalmente se especifican en la declaración de trabajo del contrato y dependen de cuánta libertad de acción desee proporcionar el cliente al contratista. Las tareas de confiabilidad incluyen varios análisis, planificación e informes de fallas. La selección de tareas depende de la criticidad del sistema, así como del costo. Un sistema crítico para la seguridad puede requerir un proceso formal de informe y revisión de fallas durante el desarrollo, mientras que un sistema no crítico puede depender de informes de pruebas finales. Las tareas de programa de confiabilidad más comunes están documentadas en estándares de programa de confiabilidad, como MIL-STD-785 e IEEE 1332. El análisis de informes de fallas y los sistemas de acciones correctivas son un enfoque común para el monitoreo de confiabilidad de productos/procesos.

En la práctica, la mayoría de los fallos se pueden atribuir a algún tipo de error humano , por ejemplo en:

Sin embargo, los seres humanos también son muy buenos para detectar tales fallas, corregirlas e improvisar cuando ocurren situaciones anormales. Por lo tanto, las políticas que descartan por completo las acciones humanas en los procesos de diseño y producción para mejorar la confiabilidad pueden no ser efectivas. Algunas tareas son realizadas mejor por humanos y otras por máquinas. [19]

Además, los errores humanos en la gestión, la organización de los datos y la información, o el uso indebido o el abuso de los elementos también pueden contribuir a la falta de fiabilidad. Esta es la razón principal por la que sólo se pueden lograr altos niveles de fiabilidad para sistemas complejos siguiendo un proceso de ingeniería de sistemas sólido con una planificación y ejecución adecuadas de las tareas de validación y verificación. Esto también incluye la organización cuidadosa del intercambio de datos e información y la creación de una "cultura de la fiabilidad", de la misma manera que tener una "cultura de la seguridad" es primordial en el desarrollo de sistemas críticos para la seguridad.

La predicción de confiabilidad combina:

En el caso de los sistemas existentes, se puede argumentar que cualquier intento de un programa responsable de corregir la causa raíz de las fallas descubiertas puede invalidar la estimación inicial del MTBF, ya que deben hacerse nuevas suposiciones (que en sí mismas están sujetas a altos niveles de error) sobre el efecto de esta corrección. Otro problema práctico es la falta general de disponibilidad de datos detallados sobre fallas, ya que los que están disponibles a menudo presentan un filtrado inconsistente de los datos de fallas (retroalimentación) e ignoran los errores estadísticos (que son muy altos para eventos poco frecuentes como fallas relacionadas con la confiabilidad). Deben existir pautas muy claras para contar y comparar fallas relacionadas con diferentes tipos de causas raíz (por ejemplo, fallas de diseño inherentes o inducidas por la fabricación, el mantenimiento, el transporte o el sistema). Comparar diferentes tipos de causas puede conducir a estimaciones incorrectas y decisiones comerciales incorrectas sobre el enfoque de la mejora.

Realizar una predicción cuantitativa adecuada de la fiabilidad de los sistemas puede resultar difícil y muy costoso si se realiza mediante pruebas. A nivel de piezas individuales, los resultados de fiabilidad suelen obtenerse con una confianza comparativamente alta, ya que es posible realizar pruebas de muchas piezas de muestra utilizando el presupuesto de pruebas disponible. Sin embargo, lamentablemente, estas pruebas pueden carecer de validez a nivel de sistema debido a las suposiciones realizadas en las pruebas a nivel de piezas. Estos autores destacaron la importancia de realizar pruebas iniciales a nivel de piezas o sistemas hasta que se produzcan fallos, y de aprender de dichos fallos para mejorar el sistema o la pieza. Se llega a la conclusión general de que, en la mayoría de los casos, no es posible realizar una predicción precisa y absoluta de la fiabilidad (ya sea mediante la comparación de datos de campo o mediante pruebas). Una excepción podrían ser los fallos debidos a problemas de desgaste, como los fallos por fatiga. En la introducción de la norma MIL-STD-785 se indica que la predicción de la fiabilidad debe utilizarse con gran precaución, si no se utiliza únicamente para comparar en estudios de compensaciones.

El diseño para la confiabilidad (DfR) es un proceso que abarca herramientas y procedimientos para garantizar que un producto cumpla con sus requisitos de confiabilidad, en su entorno de uso, durante toda su vida útil. El DfR se implementa en la etapa de diseño de un producto para mejorar de manera proactiva la confiabilidad del producto. [21] El DfR se utiliza a menudo como parte de una estrategia general de diseño para la excelencia (DfX) .

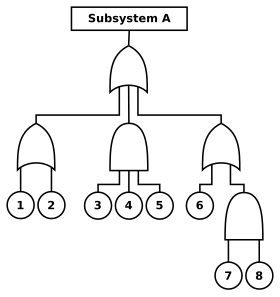

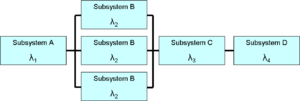

El diseño de confiabilidad comienza con el desarrollo de un modelo (del sistema) . Los modelos de confiabilidad y disponibilidad utilizan diagramas de bloques y análisis de árboles de fallas para proporcionar un medio gráfico de evaluación de las relaciones entre las diferentes partes del sistema. Estos modelos pueden incorporar predicciones basadas en tasas de fallas tomadas de datos históricos. Si bien las predicciones (de datos de entrada) a menudo no son precisas en un sentido absoluto, son valiosas para evaluar las diferencias relativas en las alternativas de diseño. Los parámetros de mantenibilidad, por ejemplo, el tiempo medio de reparación (MTTR), también se pueden utilizar como entradas para dichos modelos.

Las causas fundamentales de inicio y los mecanismos de falla más importantes deben identificarse y analizarse con herramientas de ingeniería. Se debe proporcionar a los diseñadores un conjunto diverso de orientación práctica sobre desempeño y confiabilidad para que puedan generar diseños y productos de bajo estrés que protejan, o estén protegidos contra, daños y desgaste excesivo. Puede ser necesaria una validación adecuada de las cargas de entrada (requisitos), además de la verificación del "desempeño" de confiabilidad mediante pruebas.

Una de las técnicas de diseño más importantes es la redundancia . Esto significa que si una parte del sistema falla, existe una ruta de éxito alternativa, como un sistema de respaldo. La razón por la que esta es la opción de diseño definitiva está relacionada con el hecho de que la evidencia de confiabilidad de alta confianza para nuevas partes o sistemas a menudo no está disponible, o es extremadamente costosa de obtener. Al combinar la redundancia, junto con un alto nivel de monitoreo de fallas y la evitación de fallas de causa común; incluso un sistema con una confiabilidad de canal único (parte) relativamente baja, puede volverse altamente confiable a nivel de sistema (hasta confiabilidad crítica para la misión). No se requiere ninguna prueba de confiabilidad para esto. Junto con la redundancia, el uso de diseños o procesos de fabricación diferentes (por ejemplo, a través de diferentes proveedores de partes similares) para canales independientes únicos, puede proporcionar menos sensibilidad a los problemas de calidad (por ejemplo, fallas en la primera infancia en un solo proveedor), lo que permite lograr niveles muy altos de confiabilidad en todos los momentos del ciclo de desarrollo (desde la vida temprana hasta el largo plazo). La redundancia también se puede aplicar en la ingeniería de sistemas verificando dos veces los requisitos, los datos, los diseños, los cálculos, el software y las pruebas para superar fallas sistemáticas.

Otra forma eficaz de abordar los problemas de confiabilidad es realizar análisis que predigan la degradación, lo que permite prevenir eventos de inactividad o fallas no programadas. Para esto se pueden utilizar programas RCM (mantenimiento centrado en la confiabilidad).

En el caso de los conjuntos electrónicos, se ha producido un cambio creciente hacia un enfoque diferente denominado física de fallos . Esta técnica se basa en la comprensión de los mecanismos físicos estáticos y dinámicos de fallos. Tiene en cuenta la variación de la carga, la resistencia y la tensión que conducen a un fallo con un alto nivel de detalle, lo que es posible gracias al uso de programas de software de método de elementos finitos (FEM) modernos que pueden manejar geometrías y mecanismos complejos como fluencia, relajación de tensiones, fatiga y diseño probabilístico ( métodos de Monte Carlo /DOE). El material o componente se puede rediseñar para reducir la probabilidad de fallo y hacerlo más resistente a dichas variaciones. Otra técnica de diseño común es la reducción de potencia de los componentes : es decir, la selección de componentes cuyas especificaciones superen significativamente los niveles de tensión esperados, como el uso de cables eléctricos de mayor calibre que el que normalmente se podría especificar para la corriente eléctrica esperada .

Muchas de las tareas, técnicas y análisis utilizados en la ingeniería de confiabilidad son específicos de industrias y aplicaciones particulares, pero comúnmente pueden incluir:

Los resultados de estos métodos se presentan durante las revisiones del diseño de piezas o sistemas y la logística. La confiabilidad es solo un requisito entre muchos para una pieza o sistema complejo. Los estudios de compensaciones de ingeniería se utilizan para determinar el equilibrio óptimo entre los requisitos de confiabilidad y otras limitaciones.

Los ingenieros de confiabilidad, ya sea que utilicen métodos cuantitativos o cualitativos para describir una falla o un peligro, se basan en el lenguaje para identificar los riesgos y permitir que se resuelvan los problemas. El lenguaje utilizado debe ayudar a crear una descripción ordenada de la función/elemento/sistema y su entorno complejo en relación con la falla de estas funciones/elementos/sistemas. La ingeniería de sistemas se trata en gran medida de encontrar las palabras correctas para describir el problema (y los riesgos relacionados), de modo que puedan resolverse fácilmente mediante soluciones de ingeniería. Jack Ring dijo que el trabajo de un ingeniero de sistemas es "darle lenguaje al proyecto" (Ring et al. 2000) [23]. Para las fallas de partes/sistemas, los ingenieros de confiabilidad deben concentrarse más en el "por qué y el cómo", en lugar de predecir el "cuándo". Es mucho más probable que comprender el "por qué" se produjo una falla (por ejemplo, debido a componentes sobrecargados o problemas de fabricación) conduzca a una mejora en los diseños y procesos utilizados [4] que cuantificar el "cuándo" es probable que ocurra una falla (por ejemplo, mediante la determinación del MTBF). Para ello, primero es necesario clasificar y ordenar los riesgos de fiabilidad relacionados con la pieza o el sistema (en base a alguna forma de lógica cualitativa y cuantitativa, si es posible) para permitir una evaluación más eficiente y una mejora eventual. Esto se hace en parte en lenguaje puro y lógica de proposiciones , pero también en base a la experiencia con elementos similares. Esto se puede ver, por ejemplo, en las descripciones de eventos en el análisis de árboles de fallas , el análisis FMEA y los registros (de seguimiento) de riesgos. En este sentido, el lenguaje y la gramática adecuada (parte del análisis cualitativo) desempeñan un papel importante en la ingeniería de fiabilidad, al igual que en la ingeniería de seguridad o, en general, en la ingeniería de sistemas .

El uso correcto del lenguaje también puede ser clave para identificar o reducir los riesgos de error humano , que a menudo son la causa principal de muchos fallos. Esto puede incluir instrucciones adecuadas en manuales de mantenimiento, manuales de operación, procedimientos de emergencia y otros para evitar errores humanos sistemáticos que pueden provocar fallos del sistema. Estos deben ser escritos por autores técnicos capacitados o experimentados utilizando el llamado inglés simplificado o inglés técnico simplificado , donde las palabras y la estructura se eligen y crean específicamente para reducir la ambigüedad o el riesgo de confusión (por ejemplo, un "reemplazar la pieza vieja" podría referirse ambiguamente a cambiar una pieza desgastada por una que no esté desgastada, o reemplazar una pieza por una que utilice un diseño más reciente y, con suerte, mejorado).

El modelado de confiabilidad es el proceso de predecir o comprender la confiabilidad de un componente o sistema antes de su implementación. Dos tipos de análisis que se utilizan a menudo para modelar el comportamiento de disponibilidad de un sistema completo , incluidos los efectos de los problemas logísticos como el aprovisionamiento de repuestos, el transporte y la mano de obra, son el análisis del árbol de fallas y los diagramas de bloques de confiabilidad . A nivel de componente, se pueden utilizar los mismos tipos de análisis junto con otros. La información de entrada para los modelos puede provenir de muchas fuentes, incluidas las pruebas, la experiencia operativa previa, los datos de campo y los manuales de datos de industrias similares o relacionadas. Independientemente de la fuente, todos los datos de entrada del modelo deben usarse con gran precaución, ya que las predicciones solo son válidas en los casos en que se utilizó el mismo producto en el mismo contexto. Como tal, las predicciones a menudo solo se utilizan para ayudar a comparar alternativas.

Para las predicciones a nivel de piezas, son comunes dos campos de investigación separados:

La confiabilidad se define como la probabilidad de que un dispositivo realice su función prevista durante un período de tiempo específico en condiciones establecidas. Matemáticamente, esto se puede expresar como:

,

donde es la función de densidad de probabilidad de falla y es la longitud del período de tiempo (que se supone que comienza desde el tiempo cero).

Hay algunos elementos clave de esta definición:

Los requisitos cuantitativos se especifican utilizando parámetros de confiabilidad . El parámetro de confiabilidad más común es el tiempo medio hasta el fallo (MTTF), que también se puede especificar como la tasa de fallos (esto se expresa como una frecuencia o una función de densidad de probabilidad condicional (PDF)) o el número de fallos durante un período determinado. Estos parámetros pueden ser útiles para niveles de sistema superiores y sistemas que se operan con frecuencia (es decir, vehículos, maquinaria y equipos electrónicos). La confiabilidad aumenta a medida que aumenta el MTTF. El MTTF suele especificarse en horas, pero también se puede utilizar con otras unidades de medida, como millas o ciclos. El uso de valores de MTTF en niveles de sistema inferiores puede ser muy engañoso, especialmente si no especifican los modos y mecanismos de fallos asociados (la F en MTTF). [17]

En otros casos, la fiabilidad se especifica como la probabilidad de éxito de la misión. Por ejemplo, la fiabilidad de un vuelo programado de una aeronave se puede especificar como una probabilidad adimensional o un porcentaje, como se suele utilizar en la ingeniería de seguridad de sistemas .

Un caso especial de éxito de misión es el dispositivo o sistema de un solo disparo. Se trata de dispositivos o sistemas que permanecen relativamente inactivos y solo funcionan una vez. Algunos ejemplos son los airbags de los automóviles , las baterías térmicas y los misiles . La fiabilidad de un solo disparo se especifica como una probabilidad de éxito de una sola vez o se incluye en un parámetro relacionado. La fiabilidad de un misil de un solo disparo puede especificarse como un requisito para la probabilidad de un impacto. Para tales sistemas, la probabilidad de fallo a demanda (PFD) es la medida de fiabilidad; en realidad, se trata de un número de "indisponibilidad". La PFD se deriva de la tasa de fallos (una frecuencia de ocurrencia) y el tiempo de misión para los sistemas no reparables.

En el caso de los sistemas reparables, se obtiene a partir de la tasa de fallos, el tiempo medio de reparación (MTTR) y el intervalo de prueba. Esta medida puede no ser única para un sistema determinado, ya que depende del tipo de demanda. Además de los requisitos a nivel de sistema, se pueden especificar requisitos de fiabilidad para subsistemas críticos. En la mayoría de los casos, los parámetros de fiabilidad se especifican con intervalos de confianza estadísticos adecuados .

El propósito de las pruebas de confiabilidad o verificación de confiabilidad es descubrir problemas potenciales con el diseño lo antes posible y, en última instancia, brindar confianza de que el sistema cumple con sus requisitos de confiabilidad. Se debe considerar la confiabilidad del producto en todos los entornos, como el uso esperado, el transporte o el almacenamiento durante la vida útil especificada. [10] Es exponer el producto a condiciones ambientales naturales o artificiales para someterlo a su acción para evaluar el desempeño del producto en las condiciones ambientales de uso, transporte y almacenamiento reales, y para analizar y estudiar el grado de influencia de los factores ambientales y su mecanismo de acción. [24] Mediante el uso de varios equipos de prueba ambiental para simular la alta temperatura, baja temperatura y alta humedad, y los cambios de temperatura en el entorno climático, para acelerar la reacción del producto en el entorno de uso, para verificar si alcanza la calidad esperada en I + D , diseño y fabricación. [25]

La verificación de confiabilidad también se denomina prueba de confiabilidad, que se refiere al uso de modelos, estadísticas y otros métodos para evaluar la confiabilidad del producto en función de la vida útil del producto y el rendimiento esperado. [26] La mayoría de los productos en el mercado requieren pruebas de confiabilidad, como los automóviles, los circuitos integrados , la maquinaria pesada utilizada para extraer recursos naturales y el software de automóviles para aeronaves. [27] [28]

Las pruebas de confiabilidad se pueden realizar en varios niveles y existen diferentes tipos de pruebas. Los sistemas complejos se pueden probar en los niveles de componentes, placas de circuitos, unidades, conjuntos, subsistemas y sistemas. [29] (La nomenclatura del nivel de prueba varía entre aplicaciones). Por ejemplo, realizar pruebas de detección de estrés ambiental en niveles inferiores, como piezas o conjuntos pequeños, detecta problemas antes de que provoquen fallas en niveles superiores. Las pruebas se realizan durante cada nivel de integración a través de pruebas de sistema completo, pruebas de desarrollo y pruebas operativas, lo que reduce el riesgo del programa. Sin embargo, las pruebas no mitigan el riesgo de falta de confiabilidad.

En cada prueba se pueden cometer errores estadísticos de tipo I y de tipo II , dependiendo del tamaño de la muestra, el tiempo de prueba, los supuestos y la razón de discriminación necesaria. Existe el riesgo de rechazar incorrectamente un buen diseño (error de tipo I) y el riesgo de aceptar incorrectamente un mal diseño (error de tipo II).

No siempre es posible probar todos los requisitos del sistema. Algunos sistemas son prohibitivamente costosos de probar; algunos modos de falla pueden tardar años en observarse; algunas interacciones complejas dan como resultado una gran cantidad de posibles casos de prueba; y algunas pruebas requieren el uso de rangos de prueba limitados u otros recursos. En tales casos, se pueden utilizar diferentes enfoques para las pruebas, como pruebas de vida útil (altamente) aceleradas, diseño de experimentos y simulaciones .

El nivel deseado de confianza estadística también desempeña un papel en las pruebas de fiabilidad. La confianza estadística aumenta al aumentar el tiempo de prueba o la cantidad de elementos probados. Los planes de pruebas de fiabilidad están diseñados para lograr la fiabilidad especificada en el nivel de confianza especificado con la cantidad mínima de unidades de prueba y tiempo de prueba. Los diferentes planes de prueba dan como resultado diferentes niveles de riesgo para el productor y el consumidor. La fiabilidad deseada, la confianza estadística y los niveles de riesgo para cada parte influyen en el plan de prueba final. El cliente y el desarrollador deben acordar de antemano cómo se probarán los requisitos de fiabilidad.

Un aspecto clave de las pruebas de confiabilidad es definir el "error". Aunque esto puede parecer obvio, hay muchas situaciones en las que no está claro si un error es realmente culpa del sistema. Las variaciones en las condiciones de prueba, las diferencias entre los operadores, el clima y las situaciones inesperadas crean diferencias entre el cliente y el desarrollador del sistema. Una estrategia para abordar esta cuestión es utilizar un proceso de conferencia de calificación. Una conferencia de calificación incluye representantes del cliente, el desarrollador, la organización de pruebas, la organización de confiabilidad y, a veces, observadores independientes. El proceso de conferencia de calificación se define en la declaración de trabajo. Cada caso de prueba es considerado por el grupo y "puntuado" como un éxito o un fracaso. Esta puntuación es el resultado oficial utilizado por el ingeniero de confiabilidad.

Como parte de la fase de requisitos, el ingeniero de confiabilidad desarrolla una estrategia de prueba con el cliente. La estrategia de prueba busca equilibrios entre las necesidades de la organización de confiabilidad, que desea la mayor cantidad de datos posible, y las limitaciones, como el costo, el cronograma y los recursos disponibles. Se desarrollan planes y procedimientos de prueba para cada prueba de confiabilidad y se documentan los resultados.

Las pruebas de fiabilidad son habituales en la industria de la fotónica. Algunos ejemplos de pruebas de fiabilidad de los láseres son la prueba de vida útil y el ensayo de quemado . Estas pruebas consisten en el envejecimiento altamente acelerado, en condiciones controladas, de un grupo de láseres. Los datos recopilados de estas pruebas de vida útil se utilizan para predecir la expectativa de vida útil del láser en las características operativas previstas. [30]

Existen muchos criterios para realizar pruebas que dependen del producto o proceso que se esté probando, y principalmente, hay cinco componentes que son los más comunes: [31] [32]

La vida útil del producto se puede dividir en cuatro etapas diferentes para su análisis. La vida útil es la vida económica estimada del producto, que se define como el tiempo que se puede utilizar antes de que el costo de la reparación no justifique el uso continuo del producto. La vida útil de la garantía es el tiempo que el producto debe cumplir con la función dentro del período de tiempo especificado. La vida útil del diseño es cuando, durante el diseño del producto, el diseñador toma en consideración la vida útil del producto competitivo y el deseo del cliente y se asegura de que el producto no genere insatisfacción en el cliente. [34] [35]

Los requisitos de las pruebas de fiabilidad pueden surgir de cualquier análisis para el que sea necesario justificar la primera estimación de la probabilidad, el modo o el efecto de la falla. Se pueden generar pruebas con cierto nivel de confianza mediante pruebas. En los sistemas basados en software, la probabilidad es una combinación de fallas de software y hardware. Probar los requisitos de fiabilidad es problemático por varias razones. En la mayoría de los casos, una sola prueba no es suficiente para generar suficientes datos estadísticos. Las pruebas múltiples o de larga duración suelen ser muy costosas. Algunas pruebas son simplemente poco prácticas y las condiciones ambientales pueden ser difíciles de predecir a lo largo del ciclo de vida de un sistema.

La ingeniería de confiabilidad se utiliza para diseñar un programa de pruebas realista y asequible que proporcione evidencia empírica de que el sistema cumple con sus requisitos de confiabilidad. Los niveles de confianza estadística se utilizan para abordar algunas de estas preocupaciones. Se expresa un parámetro determinado junto con un nivel de confianza correspondiente: por ejemplo, un MTBF de 1000 horas con un nivel de confianza del 90%. A partir de esta especificación, el ingeniero de confiabilidad puede, por ejemplo, diseñar una prueba con criterios explícitos para la cantidad de horas y la cantidad de fallas hasta que se cumpla o no el requisito. Son posibles diferentes tipos de pruebas.

La combinación del nivel de confiabilidad requerido y el nivel de confianza requerido afecta en gran medida el costo de desarrollo y el riesgo tanto para el cliente como para el productor. Es necesario tener cuidado para seleccionar la mejor combinación de requisitos, por ejemplo, la relación costo-beneficio. Las pruebas de confiabilidad se pueden realizar en varios niveles, como componente, subsistema y sistema . Además, se deben abordar muchos factores durante las pruebas y el funcionamiento, como temperatura y humedad extremas, golpes, vibraciones u otros factores ambientales (como pérdida de señal, refrigeración o energía; u otras catástrofes como incendios, inundaciones, calor excesivo, violaciones físicas o de seguridad u otras innumerables formas de daño o degradación). Para los sistemas que deben durar muchos años, pueden ser necesarias pruebas de vida aceleradas.

Un enfoque sistemático para las pruebas de confiabilidad es, en primer lugar, determinar el objetivo de confiabilidad, luego realizar pruebas vinculadas con el rendimiento y determinar la confiabilidad del producto. [36] Una prueba de verificación de confiabilidad en las industrias modernas debe determinar claramente cómo se relacionan con el rendimiento de confiabilidad general del producto y cómo las pruebas individuales impactan el costo de la garantía y la satisfacción del cliente. [37]

El objetivo de las pruebas de vida acelerada (prueba ALT) es inducir una falla en el laboratorio a un ritmo mucho más rápido al proporcionar un entorno más severo, pero representativo. En una prueba de este tipo, se espera que el producto falle en el laboratorio de la misma manera que hubiera fallado en el campo, pero en mucho menos tiempo. El objetivo principal de una prueba acelerada es uno de los siguientes:

Un programa de pruebas aceleradas se puede dividir en los siguientes pasos:

Las formas más comunes de determinar una relación de estrés en la vida son:

La confiabilidad del software es un aspecto especial de la ingeniería de confiabilidad. Se centra en los fundamentos y técnicas para hacer que el software sea más confiable, es decir, resistente a las fallas. La confiabilidad del sistema, por definición, incluye todas las partes del sistema, incluido el hardware, el software, la infraestructura de soporte (incluidas las interfaces externas críticas), los operadores y los procedimientos. Tradicionalmente, la ingeniería de confiabilidad se centra en las partes críticas del hardware del sistema. Desde el uso generalizado de la tecnología de circuitos integrados digitales , el software se ha convertido en una parte cada vez más crítica de la mayoría de los dispositivos electrónicos y, por lo tanto, de casi todos los sistemas actuales. Por lo tanto, la confiabilidad del software ha ganado prominencia dentro del campo de la confiabilidad del sistema.

Sin embargo, existen diferencias significativas en el comportamiento del software y el hardware. La mayor parte de la falta de fiabilidad del hardware es el resultado de un fallo de un componente o material que hace que el sistema no realice su función prevista. La reparación o sustitución del componente de hardware restaura el sistema a su estado operativo original. Sin embargo, el software no falla en el mismo sentido que falla el hardware. En cambio, la falta de fiabilidad del software es el resultado de resultados imprevistos de las operaciones del software. Incluso los programas de software relativamente pequeños pueden tener combinaciones astronómicas de entradas y estados que no es factible probar exhaustivamente. Restaurar el software a su estado original solo funciona hasta que la misma combinación de entradas y estados dé como resultado el mismo resultado no previsto. La ingeniería de fiabilidad del software debe tener esto en cuenta.

A pesar de esta diferencia en la fuente de falla entre software y hardware, se han propuesto varios modelos de confiabilidad de software basados en estadísticas para cuantificar lo que experimentamos con el software: cuanto más tiempo se ejecuta el software, mayor es la probabilidad de que eventualmente se use de manera no probada y presente un defecto latente que resulte en una falla (Shooman 1987), (Musa 2005), (Denney 2005).

Al igual que con el hardware, la confiabilidad del software depende de buenos requisitos, diseño e implementación. La ingeniería de confiabilidad del software se basa en gran medida en un proceso de ingeniería de software disciplinado para anticipar y diseñar contra consecuencias no deseadas . Existe más superposición entre la ingeniería de calidad del software y la ingeniería de confiabilidad del software que entre la calidad del hardware y la confiabilidad. Un buen plan de desarrollo de software es un aspecto clave del programa de confiabilidad del software. El plan de desarrollo de software describe los estándares de diseño y codificación, revisiones por pares , pruebas unitarias , gestión de configuración , métricas de software y modelos de software que se utilizarán durante el desarrollo del software.

Una métrica de confiabilidad común es la cantidad de fallas de software por línea de código (FLOC), que generalmente se expresa como fallas por cada mil líneas de código. Esta métrica, junto con el tiempo de ejecución del software, es clave para la mayoría de los modelos y estimaciones de confiabilidad del software. La teoría es que la confiabilidad del software aumenta a medida que disminuye la cantidad de fallas (o densidad de fallas). Sin embargo, establecer una conexión directa entre la densidad de fallas y el tiempo medio entre fallas es difícil debido a la forma en que se distribuyen las fallas de software en el código, su gravedad y la probabilidad de la combinación de entradas necesarias para encontrar la falla. No obstante, la densidad de fallas sirve como un indicador útil para el ingeniero de confiabilidad. También se utilizan otras métricas de software, como la complejidad. Esta métrica sigue siendo controvertida, ya que los cambios en las prácticas de desarrollo y verificación de software pueden tener un impacto dramático en las tasas generales de defectos.

Las pruebas de software son un aspecto importante de la confiabilidad del software. Incluso el mejor proceso de desarrollo de software da como resultado algunos fallos de software que son casi indetectables hasta que se prueban. El software se prueba en varios niveles, comenzando con unidades individuales , pasando por la integración y la prueba del sistema completo . En todas las fases de prueba, se descubren, corrigen y vuelven a probar los fallos del software. Las estimaciones de confiabilidad se actualizan en función de la densidad de fallos y otras métricas. A nivel de sistema, se pueden recopilar datos de tiempo medio entre fallos y utilizarlos para estimar la confiabilidad. A diferencia del hardware, realizar exactamente la misma prueba en exactamente la misma configuración de software no proporciona una mayor confianza estadística. En cambio, la confiabilidad del software utiliza diferentes métricas, como la cobertura del código .

El modelo de madurez de capacidad del Software Engineering Institute es un medio común para evaluar el proceso general de desarrollo de software con fines de confiabilidad y calidad.

La confiabilidad estructural o confiabilidad de estructuras es la aplicación de la teoría de confiabilidad al comportamiento de las estructuras . Se utiliza tanto en el diseño como en el mantenimiento de diferentes tipos de estructuras, incluidas las estructuras de hormigón y acero. [38] [39] En los estudios de confiabilidad estructural, tanto las cargas como las resistencias se modelan como variables probabilísticas. Utilizando este enfoque se calcula la probabilidad de falla de una estructura.

La confiabilidad en cuanto a seguridad y la confiabilidad en cuanto a disponibilidad suelen estar estrechamente relacionadas. La pérdida de disponibilidad de un sistema de ingeniería puede costar dinero. Si un sistema de metro no está disponible, el operador del metro perderá dinero por cada hora que el sistema esté inactivo. El operador del metro perderá más dinero si se compromete la seguridad. La definición de confiabilidad está vinculada a la probabilidad de no encontrarse con una falla. Una falla puede causar pérdida de seguridad, pérdida de disponibilidad o ambas. No es deseable perder seguridad o disponibilidad en un sistema crítico.

La ingeniería de confiabilidad se ocupa de la minimización general de fallas que podrían provocar pérdidas financieras para la entidad responsable, mientras que la ingeniería de seguridad se centra en minimizar un conjunto específico de tipos de fallas que, en general, podrían provocar pérdida de vidas, lesiones o daños a los equipos.

Los riesgos de confiabilidad podrían transformarse en incidentes que conduzcan a una pérdida de ingresos para la empresa o el cliente, por ejemplo debido a costos directos e indirectos asociados con: pérdida de producción debido a la falta de disponibilidad del sistema; demandas inesperadas altas o bajas de repuestos; costos de reparación; horas-hombre; rediseños o interrupciones de la producción normal. [40]

La ingeniería de seguridad suele ser muy específica y se relaciona únicamente con ciertas industrias, aplicaciones o áreas estrictamente reguladas. Se centra principalmente en los riesgos de seguridad del sistema que podrían provocar accidentes graves, como la pérdida de vidas, la destrucción de equipos o el daño ambiental. Por ello, los requisitos de fiabilidad funcional del sistema relacionados suelen ser extremadamente altos. Aunque se ocupa de los fallos no deseados en el mismo sentido que la ingeniería de fiabilidad, se centra menos en los costes directos y no se ocupa de las acciones de reparación posteriores a los fallos. Otra diferencia es el nivel de impacto de los fallos en la sociedad, lo que lleva a una tendencia a un control estricto por parte de los gobiernos o los organismos reguladores (por ejemplo, las industrias nuclear, aeroespacial, de defensa, ferroviaria y petrolera). [40]

La seguridad se puede aumentar utilizando un sistema redundante con verificación cruzada 2oo2. La disponibilidad se puede aumentar utilizando redundancia "1oo2" (1 de 2) a nivel de parte o sistema. Si ambos elementos redundantes no están de acuerdo, el elemento más permisivo maximizará la disponibilidad. Nunca se debe confiar en un sistema 1oo2 para la seguridad. Los sistemas tolerantes a fallas a menudo dependen de redundancia adicional (por ejemplo, lógica de votación 2oo3 ) donde múltiples elementos redundantes deben estar de acuerdo sobre una acción potencialmente insegura antes de que se realice. Esto aumenta tanto la disponibilidad como la seguridad a nivel de sistema. Esta es una práctica común en sistemas aeroespaciales que necesitan disponibilidad continua y no tienen un modo a prueba de fallas . Por ejemplo, las aeronaves pueden usar redundancia modular triple para computadoras de vuelo y superficies de control (que incluyen ocasionalmente diferentes modos de operación, por ejemplo, eléctrico/mecánico/hidráulico) ya que estos deben estar siempre operativos, debido al hecho de que no hay posiciones predeterminadas "seguras" para superficies de control como timones o alerones cuando la aeronave está volando.

El ejemplo anterior de un sistema tolerante a fallos 2oo3 aumenta tanto la fiabilidad de la misión como la seguridad. Sin embargo, la fiabilidad "básica" del sistema en este caso seguirá siendo inferior a la de un sistema no redundante (1oo1) o 2oo2. La ingeniería de fiabilidad básica cubre todos los fallos, incluidos aquellos que podrían no dar lugar a un fallo del sistema, pero que sí suponen un coste adicional debido a: acciones de mantenimiento y reparación; logística; piezas de repuesto, etc. Por ejemplo, la sustitución o reparación de un canal defectuoso en un sistema de votación 2oo3 (el sistema sigue funcionando, aunque con un canal averiado se ha convertido en un sistema 2oo2) contribuye a la falta de fiabilidad básica, pero no a la falta de fiabilidad de la misión. Por ejemplo, la avería de la luz trasera de un avión no impedirá que el avión vuele (y por tanto no se considera una avería de la misión), pero sí es necesario remediarla (con un coste relacionado, y por tanto contribuye a los niveles de falta de fiabilidad básica).

Cuando se utilizan sistemas tolerantes a fallas (redundantes) o sistemas que están equipados con funciones de protección, la detectabilidad de fallas y la evitación de fallas por causas comunes se vuelven fundamentales para el funcionamiento seguro y/o la confiabilidad de la misión.

La calidad suele centrarse en los defectos de fabricación durante la fase de garantía. La fiabilidad analiza la intensidad de las fallas a lo largo de toda la vida útil de un producto o sistema de ingeniería, desde la puesta en servicio hasta el desmantelamiento. Six Sigma tiene sus raíces en el control estadístico de la calidad de la fabricación. La ingeniería de fiabilidad es una parte especializada de la ingeniería de sistemas. El proceso de ingeniería de sistemas es un proceso de descubrimiento que a menudo es diferente de un proceso de fabricación. Un proceso de fabricación a menudo se centra en actividades repetitivas que logran resultados de alta calidad con un costo y un tiempo mínimos. [41]

El término de uso cotidiano "calidad de un producto" se entiende de manera imprecisa como su grado inherente de excelencia. En la industria, se utiliza una definición más precisa de calidad como "conformidad con los requisitos o especificaciones al inicio del uso". Suponiendo que la especificación del producto final captura adecuadamente los requisitos originales y las necesidades del cliente/sistema, el nivel de calidad se puede medir como la fracción de unidades de producto enviadas que cumplen con las especificaciones. [42] La calidad de los bienes manufacturados a menudo se centra en el número de reclamos de garantía durante el período de garantía.

La calidad es una instantánea al comienzo de la vida a través del período de garantía y está relacionada con el control de las especificaciones del producto de nivel inferior. Esto incluye defectos de tiempo cero, es decir, donde los errores de fabricación escaparon al Control de Calidad final. En teoría, el nivel de calidad podría describirse por una sola fracción de productos defectuosos. La confiabilidad, como parte de la ingeniería de sistemas, actúa más como una evaluación continua de las tasas de falla a lo largo de muchos años. Teóricamente, todos los artículos fallarán durante un período de tiempo infinito. [43] Los defectos que aparecen con el tiempo se conocen como repercusión de confiabilidad. Para describir la repercusión de confiabilidad se necesita un modelo de probabilidad que describa la fracción de repercusión a lo largo del tiempo. Esto se conoce como el modelo de distribución de vida. [42] Algunos de estos problemas de confiabilidad pueden deberse a problemas de diseño inherentes, que pueden existir incluso si el producto se ajusta a las especificaciones. Incluso los artículos que se producen perfectamente fallarán con el tiempo debido a uno o más mecanismos de falla (por ejemplo, debido a error humano o factores mecánicos, eléctricos y químicos). Estos problemas de confiabilidad también pueden verse influenciados por niveles aceptables de variación durante la producción inicial.

Por lo tanto, la calidad y la fiabilidad están relacionadas con la fabricación. La fiabilidad está más orientada a los clientes que se centran en los fallos a lo largo de toda la vida útil del producto, como el ejército, las aerolíneas o los ferrocarriles. Los artículos que no se ajustan a las especificaciones del producto generalmente tendrán un peor rendimiento en términos de fiabilidad (tendrán un MTTF inferior), pero esto no siempre tiene por qué ser así. La cuantificación matemática completa (en modelos estadísticos) de esta relación combinada es en general muy difícil o incluso prácticamente imposible. En los casos en los que las variaciones de fabricación se pueden reducir de forma eficaz, las herramientas de seis sigma han demostrado ser útiles para encontrar soluciones de proceso óptimas que puedan aumentar la calidad y la fiabilidad. Seis Sigma también puede ayudar a diseñar productos que sean más resistentes a los fallos inducidos por la fabricación y a los defectos de mortalidad infantil en los sistemas de ingeniería y en los productos fabricados.

A diferencia de Six Sigma, las soluciones de ingeniería de confiabilidad generalmente se encuentran centrándose en las pruebas de confiabilidad y el diseño del sistema. Las soluciones se encuentran de diferentes maneras, como simplificando un sistema para permitir que se comprendan más mecanismos de falla involucrados; realizando cálculos detallados de los niveles de tensión del material que permitan determinar los factores de seguridad adecuados; encontrando posibles condiciones de carga anormales del sistema y utilizándolas para aumentar la solidez de un diseño ante los mecanismos de falla relacionados con la variación de fabricación. Además, la ingeniería de confiabilidad utiliza soluciones a nivel de sistema, como el diseño de sistemas redundantes y tolerantes a fallas para situaciones con necesidades de alta disponibilidad (consulte Ingeniería de confiabilidad versus Ingeniería de seguridad más arriba).

Nota: Un "defecto" en la literatura sobre calidad/seis sigma no es lo mismo que un "error" (error de campo, por ejemplo, un elemento fracturado) en términos de confiabilidad. Un defecto de calidad/seis sigma se refiere generalmente a la no conformidad con un requisito (por ejemplo, una funcionalidad básica o una dimensión clave). Sin embargo, los elementos pueden fallar con el tiempo, incluso si se cumplen todos estos requisitos. La calidad generalmente no se ocupa de hacer la pregunta crucial "¿son los requisitos realmente correctos?", mientras que la confiabilidad sí lo hace.

Once systems or parts are being produced, reliability engineering attempts to monitor, assess, and correct deficiencies. Monitoring includes electronic and visual surveillance of critical parameters identified during the fault tree analysis design stage. Data collection is highly dependent on the nature of the system. Most large organizations have quality control groups that collect failure data on vehicles, equipment and machinery. Consumer product failures are often tracked by the number of returns. For systems in dormant storage or on standby, it is necessary to establish a formal surveillance program to inspect and test random samples. Any changes to the system, such as field upgrades or recall repairs, require additional reliability testing to ensure the reliability of the modification. Since it is not possible to anticipate all the failure modes of a given system, especially ones with a human element, failures will occur. The reliability program also includes a systematic root cause analysis that identifies the causal relationships involved in the failure such that effective corrective actions may be implemented. When possible, system failures and corrective actions are reported to the reliability engineering organization.

Some of the most common methods to apply to a reliability operational assessment are failure reporting, analysis, and corrective action systems (FRACAS). This systematic approach develops a reliability, safety, and logistics assessment based on failure/incident reporting, management, analysis, and corrective/preventive actions. Organizations today are adopting this method and utilizing commercial systems (such as Web-based FRACAS applications) that enable them to create a failure/incident data repository from which statistics can be derived to view accurate and genuine reliability, safety, and quality metrics.

It is extremely important for an organization to adopt a common FRACAS system for all end items. Also, it should allow test results to be captured in a practical way. Failure to adopt one easy-to-use (in terms of ease of data-entry for field engineers and repair shop engineers) and easy-to-maintain integrated system is likely to result in a failure of the FRACAS program itself.

Some of the common outputs from a FRACAS system include Field MTBF, MTTR, spares consumption, reliability growth, failure/incidents distribution by type, location, part no., serial no., and symptom.

The use of past data to predict the reliability of new comparable systems/items can be misleading as reliability is a function of the context of use and can be affected by small changes in design/manufacturing.

Systems of any significant complexity are developed by organizations of people, such as a commercial company or a government agency. The reliability engineering organization must be consistent with the company's organizational structure. For small, non-critical systems, reliability engineering may be informal. As complexity grows, the need arises for a formal reliability function. Because reliability is important to the customer, the customer may even specify certain aspects of the reliability organization.

There are several common types of reliability organizations. The project manager or chief engineer may employ one or more reliability engineers directly. In larger organizations, there is usually a product assurance or specialty engineering organization, which may include reliability, maintainability, quality, safety, human factors, logistics, etc. In such case, the reliability engineer reports to the product assurance manager or specialty engineering manager.

In some cases, a company may wish to establish an independent reliability organization. This is desirable to ensure that the system reliability, which is often expensive and time-consuming, is not unduly slighted due to budget and schedule pressures. In such cases, the reliability engineer works for the project day-to-day, but is actually employed and paid by a separate organization within the company.

Because reliability engineering is critical to early system design, it has become common for reliability engineers, however, the organization is structured, to work as part of an integrated product team.

Some universities offer graduate degrees in reliability engineering. Other reliability professionals typically have a physics degree from a university or college program. Many engineering programs offer reliability courses, and some universities have entire reliability engineering programs. A reliability engineer must be registered as a professional engineer by the state or province by law, but not all reliability professionals are engineers. Reliability engineers are required in systems where public safety is at risk. There are many professional conferences and industry training programs available for reliability engineers. Several professional organizations exist for reliability engineers, including the American Society for Quality Reliability Division (ASQ-RD),[44] the IEEE Reliability Society, the American Society for Quality (ASQ),[45] and the Society of Reliability Engineers (SRE).[46]

{{cite journal}}: Cite journal requires |journal= (help){{cite journal}}: CS1 maint: multiple names: authors list (link)http://standards.sae.org/ja1000/1_199903/ SAE JA1000/1 Reliability Program Standard Implementation Guide

In the UK, there are more up to date standards maintained under the sponsorship of UK MOD as Defence Standards. The relevant Standards include:

DEF STAN 00-40 Reliability and Maintainability (R&M)

DEF STAN 00-42 RELIABILITY AND MAINTAINABILITY ASSURANCE GUIDES

DEF STAN 00-43 RELIABILITY AND MAINTAINABILITY ASSURANCE ACTIVITY

DEF STAN 00-44 RELIABILITY AND MAINTAINABILITY DATA COLLECTION AND CLASSIFICATION

DEF STAN 00-45 Issue 1: RELIABILITY CENTERED MAINTENANCE

DEF STAN 00-49 Issue 1: RELIABILITY AND MAINTAINABILITY MOD GUIDE TO TERMINOLOGY DEFINITIONS

These can be obtained from DSTAN. There are also many commercial standards, produced by many organisations including the SAE, MSG, ARP, and IEE.