La computación o red peer-to-peer ( P2P ) es una arquitectura de aplicación distribuida que divide tareas o cargas de trabajo entre pares. Los pares son participantes equipotenciales y con privilegios iguales en la red, que forman una red peer-to-peer de nodos . [1] Además, una red de área personal (PAN) también es por naturaleza un tipo de red peer-to-peer descentralizada , normalmente entre dos dispositivos. [2]

Los pares ponen una parte de sus recursos, como potencia de procesamiento, almacenamiento en disco o ancho de banda de red , directamente a disposición de otros participantes de la red, sin necesidad de una coordinación central por parte de servidores o hosts estables. [3] Los pares son a la vez proveedores y consumidores de recursos, en contraste con el modelo tradicional cliente-servidor en el que el consumo y el suministro de recursos están divididos. [4]

Si bien los sistemas P2P se habían utilizado anteriormente en muchos dominios de aplicación , [5] la arquitectura se popularizó con el sistema de intercambio de archivos de Internet Napster , lanzado originalmente en 1999. [6] P2P se utiliza en muchos protocolos como el intercambio de archivos BitTorrent a través de Internet [7] y en redes personales como la visualización Miracast y la radio Bluetooth . [8] El concepto ha inspirado nuevas estructuras y filosofías en muchas áreas de la interacción humana. En tales contextos sociales, peer-to-peer como meme se refiere a la red social igualitaria que ha surgido en toda la sociedad, posibilitada por las tecnologías de Internet en general.

Si bien los sistemas P2P se habían utilizado anteriormente en muchos dominios de aplicación, [5] el concepto se popularizó gracias a los sistemas de intercambio de archivos , como la aplicación para compartir música Napster . El movimiento peer-to-peer permitió que millones de usuarios de Internet se conectaran "directamente, formando grupos y colaborando para convertirse en motores de búsqueda creados por los usuarios, supercomputadoras virtuales y sistemas de archivos". [9] El concepto básico de computación peer-to-peer fue concebido en discusiones anteriores sobre sistemas de software y redes, y se remonta a los principios establecidos en la primera Solicitud de comentarios , RFC 1. [10]

La visión de Tim Berners-Lee para la World Wide Web se acercaba a una red P2P en el sentido de que suponía que cada usuario de la web sería un editor y colaborador activo, que crearía y vincularía contenido para formar una "red" interconectada de enlaces. La Internet primitiva era más abierta que la actual, donde dos máquinas conectadas a Internet podían enviarse paquetes entre sí sin cortafuegos ni otras medidas de seguridad. [11] [9] [ página necesaria ] Esto contrasta con la estructura de difusión de la web tal como se ha desarrollado a lo largo de los años. [12] [13] [14] Como precursora de Internet, ARPANET fue una red peer to peer exitosa en la que "cada nodo participante podía solicitar y servir contenido". Sin embargo, ARPANET no estaba autoorganizada y no podía "ofrecer ningún medio para el enrutamiento basado en contexto o contenido más allá del enrutamiento 'simple' basado en direcciones". [14]

Por lo tanto, se estableció Usenet , un sistema de mensajería distribuida que a menudo se describe como una arquitectura peer-to-peer temprana. Fue desarrollado en 1979 como un sistema que aplica un modelo descentralizado de control. [15] El modelo básico es un modelo cliente-servidor desde la perspectiva del usuario o cliente que ofrece un enfoque autoorganizado para los servidores de grupos de noticias. Sin embargo, los servidores de noticias se comunican entre sí como pares para propagar artículos de noticias de Usenet por todo el grupo de servidores de red. La misma consideración se aplica al correo electrónico SMTP en el sentido de que la red central de retransmisión de correo electrónico de los agentes de transferencia de correo tiene un carácter peer-to-peer, mientras que la periferia de los clientes de correo electrónico y sus conexiones directas es estrictamente una relación cliente-servidor. [16]

En mayo de 1999, cuando ya había millones de personas en Internet, Shawn Fanning presentó la aplicación para compartir música y archivos llamada Napster. [14] Napster fue el comienzo de las redes peer-to-peer, tal como las conocemos hoy, donde "los usuarios participantes establecen una red virtual, completamente independiente de la red física, sin tener que obedecer a ninguna autoridad administrativa ni restricción". [14]

Una red peer-to-peer está diseñada en torno a la noción de nodos pares iguales que funcionan simultáneamente como "clientes" y "servidores" para los otros nodos de la red. [17] Este modelo de organización de la red difiere del modelo cliente-servidor , en el que la comunicación suele ser hacia y desde un servidor central. Un ejemplo típico de una transferencia de archivos que utiliza el modelo cliente-servidor es el servicio de Protocolo de Transferencia de Archivos (FTP), en el que los programas cliente y servidor son distintos: los clientes inician la transferencia y los servidores satisfacen estas solicitudes.

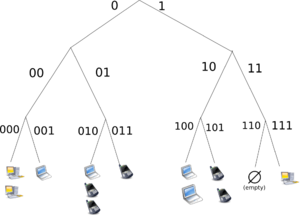

Las redes entre pares generalmente implementan algún tipo de red superpuesta virtual sobre la topología de red física, donde los nodos en la superposición forman un subconjunto de los nodos en la red física. [18] Los datos todavía se intercambian directamente a través de la red TCP/IP subyacente , pero en la capa de aplicación los pares pueden comunicarse entre sí directamente, a través de los enlaces superpuestos lógicos (cada uno de los cuales corresponde a una ruta a través de la red física subyacente). Las superposiciones se utilizan para indexar y descubrir pares, y hacen que el sistema P2P sea independiente de la topología de red física. En función de cómo se vinculan los nodos entre sí dentro de la red superpuesta, y cómo se indexan y ubican los recursos, podemos clasificar las redes como no estructuradas o estructuradas (o como un híbrido entre las dos). [19] [20] [21]

Las redes peer to peer no estructuradas no imponen una estructura particular en la red superpuesta por diseño, sino que están formadas por nodos que forman conexiones aleatoriamente entre sí. [22] ( Gnutella , Gossip y Kazaa son ejemplos de protocolos P2P no estructurados). [23]

Debido a que no existe una estructura globalmente impuesta sobre ellas, las redes no estructuradas son fáciles de construir y permiten optimizaciones localizadas para diferentes regiones de la superposición. [24] Además, debido a que el rol de todos los pares en la red es el mismo, las redes no estructuradas son altamente robustas frente a altas tasas de "rotación", es decir, cuando un gran número de pares se unen y abandonan frecuentemente la red. [25] [26]

Sin embargo, las principales limitaciones de las redes no estructuradas también surgen de esta falta de estructura. En particular, cuando un par quiere encontrar un dato deseado en la red, la consulta de búsqueda debe inundarse a través de la red para encontrar tantos pares como sea posible que compartan los datos. La inundación causa una gran cantidad de tráfico de señalización en la red, utiliza más CPU /memoria (al requerir que cada par procese todas las consultas de búsqueda) y no garantiza que las consultas de búsqueda siempre se resuelvan. Además, dado que no hay correlación entre un par y el contenido que administra, no hay garantía de que la inundación encuentre un par que tenga los datos deseados. Es probable que el contenido popular esté disponible en varios pares y cualquier par que lo busque probablemente encuentre lo mismo. Pero si un par está buscando datos raros compartidos por solo unos pocos otros pares, entonces es muy poco probable que la búsqueda tenga éxito. [27]

En redes peer to peer estructuradas, la superposición se organiza en una topología específica y el protocolo garantiza que cualquier nodo pueda [28] buscar de manera eficiente un archivo/recurso en la red, incluso si el recurso es extremadamente raro. [23]

El tipo más común de redes P2P estructuradas implementa una tabla hash distribuida (DHT), [4] [29] en la que se utiliza una variante de hash consistente para asignar la propiedad de cada archivo a un par en particular. [30] [31] Esto permite a los pares buscar recursos en la red utilizando una tabla hash : es decir, los pares ( clave , valor ) se almacenan en la DHT, y cualquier nodo participante puede recuperar de manera eficiente el valor asociado con una clave dada. [32] [33]

Sin embargo, para enrutar el tráfico de manera eficiente a través de la red, los nodos en una superposición estructurada deben mantener listas de vecinos [34] que satisfacen criterios específicos. Esto los hace menos robustos en redes con una alta tasa de rotación (es decir, con una gran cantidad de nodos que se unen y abandonan la red con frecuencia). [26] [35] Una evaluación más reciente de soluciones de descubrimiento de recursos P2P bajo cargas de trabajo reales ha señalado varios problemas en las soluciones basadas en DHT, como el alto costo de publicidad/descubrimiento de recursos y el desequilibrio de carga estática y dinámica. [36]

Las redes distribuidas notables que utilizan DHT incluyen Tixati , una alternativa al rastreador distribuido de BitTorrent , la red Kad , la botnet Storm y YaCy . Algunos proyectos de investigación destacados incluyen el proyecto Chord , Kademlia , la utilidad de almacenamiento PAST , P-Grid , una red superpuesta autoorganizada y emergente, y el sistema de distribución de contenido CoopNet . [37] Las redes basadas en DHT también se han utilizado ampliamente para lograr un descubrimiento de recursos eficiente [38] [39] para sistemas de computación en cuadrícula , ya que ayuda en la gestión de recursos y la programación de aplicaciones.

Los modelos híbridos son una combinación de modelos peer-to-peer y cliente-servidor. [40] Un modelo híbrido común es tener un servidor central que ayuda a los pares a encontrarse entre sí. Spotify fue un ejemplo de un modelo híbrido [hasta 2014]. [ cita requerida ] Hay una variedad de modelos híbridos, todos los cuales hacen concesiones entre la funcionalidad centralizada proporcionada por una red estructurada servidor/cliente y la igualdad de nodos proporcionada por las redes no estructuradas peer-to-peer puras. Actualmente, los modelos híbridos tienen un mejor rendimiento que las redes no estructuradas puras o las redes estructuradas puras porque ciertas funciones, como la búsqueda, requieren una funcionalidad centralizada pero se benefician de la agregación descentralizada de nodos proporcionada por las redes no estructuradas. [41]

CoopNet (Cooperative Networking) fue un sistema propuesto para descargar el servicio a los pares que han descargado contenido recientemente, propuesto por los científicos informáticos Venkata N. Padmanabhan y Kunwadee Sripanidkulchai, que trabajan en Microsoft Research y la Universidad Carnegie Mellon . [42] [43] Cuando un servidor experimenta un aumento en la carga, redirige a los pares entrantes a otros pares que han acordado reflejar el contenido, descargando así el equilibrio del servidor. Toda la información se conserva en el servidor. Este sistema aprovecha el hecho de que el cuello de botella es más probable que esté en el ancho de banda saliente que en la CPU , de ahí su diseño centrado en el servidor. Asigna pares a otros pares que están "cerca en IP " a sus vecinos [mismo rango de prefijo] en un intento de utilizar la localidad. Si se encuentran varios pares con el mismo archivo, designa que el nodo elija el más rápido de sus vecinos. La transmisión de medios se transmite haciendo que los clientes almacenen en caché la transmisión anterior y luego la transmitan por partes a nuevos nodos.

Los sistemas peer-to-peer plantean desafíos únicos desde una perspectiva de seguridad informática . Como cualquier otra forma de software , las aplicaciones P2P pueden contener vulnerabilidades . Sin embargo, lo que hace que esto sea particularmente peligroso para el software P2P es que las aplicaciones peer-to-peer actúan como servidores y clientes, lo que significa que pueden ser más vulnerables a ataques remotos . [44]

Dado que cada nodo desempeña un papel en el enrutamiento del tráfico a través de la red, los usuarios maliciosos pueden realizar una variedad de "ataques de enrutamiento" o ataques de denegación de servicio . Algunos ejemplos de ataques de enrutamiento comunes incluyen "enrutamiento de búsqueda incorrecta", en el que los nodos maliciosos reenvían deliberadamente solicitudes de forma incorrecta o devuelven resultados falsos; "actualizaciones de enrutamiento incorrectas", en las que los nodos maliciosos corrompen las tablas de enrutamiento de los nodos vecinos enviándoles información falsa; y "partición de red de enrutamiento incorrecta", en la que cuando se unen nuevos nodos, se inician a través de un nodo malicioso, que coloca al nuevo nodo en una partición de la red que está poblada por otros nodos maliciosos. [44]

La prevalencia de malware varía entre los distintos protocolos P2P. [45] Los estudios que analizaron la propagación de malware en redes P2P descubrieron, por ejemplo, que el 63% de las solicitudes de descarga respondidas en la red gnutella contenían algún tipo de malware, mientras que solo el 3% del contenido en OpenFT contenía malware. En ambos casos, los tres tipos de malware más comunes representaron la gran mayoría de los casos (el 99% en gnutella y el 65% en OpenFT). Otro estudio que analizó el tráfico en la red Kazaa descubrió que el 15% de la muestra de 500.000 archivos tomada estaba infectada por uno o más de los 365 virus informáticos diferentes que se analizaron. [46]

Los datos corruptos también pueden distribuirse en redes P2P modificando archivos que ya se están compartiendo en la red. Por ejemplo, en la red FastTrack , la RIAA logró introducir fragmentos falsos en las descargas y en los archivos descargados (en su mayoría archivos MP3 ). Los archivos infectados con el virus RIAA quedaron inutilizables después y contenían código malicioso. También se sabe que la RIAA ha subido música y películas falsas a las redes P2P para disuadir el intercambio ilegal de archivos. [47] En consecuencia, las redes P2P de hoy han visto un enorme aumento de su seguridad y de sus mecanismos de verificación de archivos. El hashing moderno , la verificación de fragmentos y los diferentes métodos de cifrado han hecho que la mayoría de las redes sean resistentes a casi cualquier tipo de ataque, incluso cuando partes importantes de la red respectiva han sido reemplazadas por hosts falsos o no funcionales. [48]

La naturaleza descentralizada de las redes P2P aumenta la robustez porque elimina el punto único de fallo que puede ser inherente a un sistema basado en cliente-servidor. [49] A medida que llegan los nodos y aumenta la demanda en el sistema, la capacidad total del sistema también aumenta y la probabilidad de fallo disminuye. Si un par de la red no funciona correctamente, toda la red no se ve comprometida ni dañada. Por el contrario, en una arquitectura cliente-servidor típica, los clientes solo comparten sus demandas con el sistema, pero no sus recursos. En este caso, a medida que más clientes se unen al sistema, hay menos recursos disponibles para atender a cada cliente y, si el servidor central falla, toda la red se cae.

Las redes P2P tienen ventajas y desventajas en lo que respecta a la copia de seguridad , la recuperación y la disponibilidad de los datos. En una red centralizada, los administradores del sistema son las únicas fuerzas que controlan la disponibilidad de los archivos que se comparten. Si los administradores deciden no distribuir más un archivo, simplemente tienen que eliminarlo de sus servidores y ya no estará disponible para los usuarios. Además de dejar a los usuarios sin poder decidir qué se distribuye en la comunidad, esto hace que todo el sistema sea vulnerable a amenazas y solicitudes del gobierno y otras fuerzas importantes.

Por ejemplo, la RIAA , la MPAA y la industria del entretenimiento han presionado a YouTube para que filtre el contenido protegido por derechos de autor. Aunque las redes servidor-cliente pueden supervisar y gestionar la disponibilidad del contenido, pueden tener más estabilidad en la disponibilidad del contenido que eligen alojar. Un cliente no debería tener problemas para acceder a contenido desconocido que se comparte en una red centralizada estable. Sin embargo, las redes P2P son menos fiables a la hora de compartir archivos impopulares porque compartir archivos en una red P2P requiere que al menos un nodo de la red tenga los datos solicitados, y ese nodo debe poder conectarse al nodo que solicita los datos. Este requisito es a veces difícil de cumplir porque los usuarios pueden eliminar o dejar de compartir datos en cualquier momento. [50]

En una red P2P, la comunidad de usuarios es completamente responsable de decidir qué contenido está disponible. Los archivos impopulares eventualmente desaparecen y dejan de estar disponibles a medida que menos personas los comparten. Sin embargo, los archivos populares se distribuyen en gran medida y con facilidad. Los archivos populares en una red P2P son más estables y están más disponibles que los archivos en redes centrales. En una red centralizada, una simple pérdida de conexión entre el servidor y los clientes puede causar un fallo, pero en las redes P2P, las conexiones entre cada nodo deben perderse para causar un fallo en el intercambio de datos. En un sistema centralizado, los administradores son responsables de toda la recuperación de datos y las copias de seguridad, mientras que en los sistemas P2P, cada nodo requiere su sistema de copia de seguridad. Debido a la falta de autoridad central en las redes P2P, fuerzas como la industria discográfica, la RIAA , la MPAA y el gobierno no pueden eliminar o detener el intercambio de contenido en los sistemas P2P. [51]

En las redes P2P, los clientes proporcionan y utilizan recursos. Esto significa que, a diferencia de los sistemas cliente-servidor, la capacidad de distribución de contenido de las redes P2P puede aumentar a medida que más usuarios comienzan a acceder al contenido (especialmente con protocolos como Bittorrent que requieren que los usuarios compartan, consulte un estudio de medición de rendimiento [52] ). Esta propiedad es una de las principales ventajas de usar redes P2P porque hace que los costos de instalación y funcionamiento sean muy bajos para el distribuidor de contenido original. [53] [54]

Las redes de intercambio de archivos entre pares, como Gnutella , G2 y la red eDonkey , han sido útiles para popularizar las tecnologías entre pares. Estos avances han allanado el camino para las redes y servicios de distribución de contenido entre pares , incluidos los sistemas de almacenamiento en caché distribuido como Correli Caches para mejorar el rendimiento. [55] Además, las redes entre pares han hecho posible la publicación y distribución de software, lo que permite compartir de manera eficiente la distribución de Linux y varios juegos a través de redes de intercambio de archivos .

Las redes peer to peer implican la transferencia de datos de un usuario a otro sin utilizar un servidor intermedio. Las empresas que desarrollan aplicaciones P2P se han visto involucradas en numerosos casos legales, principalmente en los Estados Unidos, por conflictos con la ley de derechos de autor . [56] Dos casos importantes son Grokster vs. RIAA y MGM Studios, Inc. v. Grokster, Ltd. [ 57] En el último caso, el Tribunal sostuvo por unanimidad que las empresas de intercambio de archivos peer to peer demandadas Grokster y Streamcast podían ser demandadas por inducir a la infracción de los derechos de autor.

Los protocolos P2PTV y PDTP se utilizan en varias aplicaciones peer-to-peer. Algunas aplicaciones multimedia propietarias aprovechan una red peer-to-peer junto con servidores de streaming para transmitir audio y vídeo a sus clientes. El peercasting se utiliza para la multidifusión de transmisiones. Además, un proyecto llamado LionShare, llevado a cabo por la Universidad Estatal de Pensilvania , el MIT y la Universidad Simon Fraser , tiene como objetivo facilitar el intercambio de archivos entre instituciones educativas de todo el mundo. Otro programa notable, Osiris , permite a los usuarios crear portales web anónimos y autónomos que se distribuyen a través de una red peer-to-peer.

Dat es una plataforma de publicación distribuida controlada por versiones. I2P , es una red superpuesta que se utiliza para navegar por Internet de forma anónima . A diferencia de I2P, relacionada con ella, la red Tor no es en sí misma peer-to-peer [ dudoso – discutir ] ; sin embargo, puede permitir que se creen aplicaciones peer-to-peer sobre ella a través de servicios de cebolla . El Sistema de archivos interplanetarios (IPFS) es un protocolo y una red diseñados para crear un método peer-to-peer direccionable por contenido para almacenar y compartir un protocolo de distribución de hipermedia , con nodos en la red IPFS que forman un sistema de archivos distribuido . Jami es una aplicación de chat y SIP peer-to-peer. JXTA es un protocolo peer-to-peer diseñado para la plataforma Java . Netsukuku es una red comunitaria inalámbrica diseñada para ser independiente de Internet. Open Garden es una aplicación de conexión compartida que comparte el acceso a Internet con otros dispositivos mediante Wi-Fi o Bluetooth.

Resilio Sync es una aplicación de sincronización de directorios. La investigación incluye proyectos como el proyecto Chord , la utilidad de almacenamiento PAST , P-Grid y el sistema de distribución de contenido CoopNet . Secure Scuttlebutt es un protocolo de chismes peer-to-peer capaz de soportar muchos tipos diferentes de aplicaciones, principalmente redes sociales . Syncthing también es una aplicación de sincronización de directorios. Las aplicaciones Tradepal l y M-commerce están diseñadas para impulsar mercados en tiempo real. El Departamento de Defensa de los EE. UU. está realizando investigaciones sobre redes P2P como parte de su estrategia de guerra de redes moderna. [58] En mayo de 2003, Anthony Tether , entonces director de DARPA , testificó que el ejército de los Estados Unidos usa redes P2P. WebTorrent es un cliente de torrent de transmisión P2P en JavaScript para usar en navegadores web , así como en la versión independiente WebTorrent Desktop que une las redes sin servidor WebTorrent y BitTorrent . Microsoft , en Windows 10 , utiliza una tecnología peer-to-peer patentada llamada "Optimización de entrega" para implementar actualizaciones del sistema operativo utilizando las PC de los usuarios finales, ya sea en la red local u otras PC. Según el Canal 9 de Microsoft, esto llevó a una reducción del 30% al 50% en el uso del ancho de banda de Internet. [59] LANtastic de Artisoft fue construido como un sistema operativo peer-to-peer donde las máquinas pueden funcionar como servidores y estaciones de trabajo simultáneamente. Hotline Communications Hotline Client fue construido con servidores descentralizados y software de seguimiento dedicado a cualquier tipo de archivos y continúa funcionando hoy. Las criptomonedas son monedas digitales basadas en peer-to-peer que utilizan cadenas de bloques.

La cooperación entre una comunidad de participantes es fundamental para el éxito continuo de los sistemas P2P dirigidos a usuarios humanos ocasionales; estos alcanzan su máximo potencial solo cuando un gran número de nodos aportan recursos. Pero en la práctica actual, las redes P2P a menudo contienen un gran número de usuarios que utilizan recursos compartidos por otros nodos, pero que no comparten nada entre sí (lo que suele denominarse el "problema del gorronero").

El aprovechamiento gratuito puede tener un profundo impacto en la red y en algunos casos puede provocar el colapso de la comunidad. [60] En este tipo de redes, "los usuarios tienen desincentivos naturales para cooperar porque la cooperación consume sus propios recursos y puede degradar su propio rendimiento". [61] Estudiar los atributos sociales de las redes P2P es un desafío debido a las grandes poblaciones de rotación, la asimetría de intereses y la identidad de costo cero. [61] Se han implementado diversos mecanismos de incentivos para alentar o incluso forzar a los nodos a contribuir con recursos. [62] [44]

Algunos investigadores han explorado los beneficios de permitir que las comunidades virtuales se autoorganicen e introducir incentivos para compartir recursos y cooperar, argumentando que el aspecto social que falta en los sistemas P2P actuales debería verse como un objetivo y un medio para construir y fomentar comunidades virtuales autoorganizadas. [63] Los esfuerzos de investigación en curso para diseñar mecanismos de incentivos efectivos en sistemas P2P, basados en principios de la teoría de juegos, están comenzando a tomar una dirección más psicológica y de procesamiento de información.

Algunas redes peer-to-peer (por ejemplo, Freenet ) ponen un gran énfasis en la privacidad y el anonimato , es decir, garantizar que el contenido de las comunicaciones esté oculto a los espías y que las identidades y ubicaciones de los participantes estén ocultas. La criptografía de clave pública se puede utilizar para proporcionar cifrado , validación de datos , autorización y autenticación de datos/mensajes. El enrutamiento de cebolla y otros protocolos de red mixtos (por ejemplo, Tarzan) se pueden utilizar para proporcionar anonimato. [64]

Los autores de abusos sexuales transmitidos en vivo y otros delitos cibernéticos han utilizado plataformas peer to peer para llevar a cabo actividades de forma anónima. [65]

Aunque las redes peer to peer pueden utilizarse con fines legítimos, los titulares de derechos han criticado a las redes peer to peer por su implicación en el intercambio de material protegido por derechos de autor. Las redes peer to peer implican la transferencia de datos de un usuario a otro sin utilizar un servidor intermedio. Las empresas que desarrollan aplicaciones P2P se han visto implicadas en numerosos casos legales, principalmente en los Estados Unidos, sobre todo por cuestiones relacionadas con la legislación sobre derechos de autor . [56] Dos casos importantes son Grokster vs. RIAA y MGM Studios, Inc. vs. Grokster, Ltd. [57] En ambos casos se dictaminó que la tecnología de intercambio de archivos era legal siempre que los desarrolladores no tuvieran la capacidad de impedir el intercambio de material protegido por derechos de autor.

Para establecer la responsabilidad penal por la infracción de los derechos de autor en los sistemas peer-to-peer, el gobierno debe probar que el acusado infringió un derecho de autor voluntariamente con el propósito de obtener un beneficio económico o comercial personal. [66] Las excepciones de uso justo permiten el uso limitado de material protegido por derechos de autor para su descarga sin obtener el permiso de los titulares de los derechos. Estos documentos suelen ser informes de noticias o trabajos de investigación y académicos. Se han desarrollado controversias sobre la preocupación por el uso ilegítimo de las redes peer-to-peer en relación con la seguridad pública y la seguridad nacional. Cuando se descarga un archivo a través de una red peer-to-peer, es imposible saber quién creó el archivo o qué usuarios están conectados a la red en un momento dado. La fiabilidad de las fuentes es una amenaza potencial para la seguridad que se puede ver en los sistemas peer-to-peer. [67]

Un estudio encargado por la Unión Europea concluyó que las descargas ilegales pueden llevar a un aumento de las ventas generales de videojuegos porque los juegos más nuevos cobran por funciones o niveles adicionales. El artículo concluyó que la piratería tenía un impacto financiero negativo en las películas, la música y la literatura. El estudio se basó en datos autodeclarados sobre compras de juegos y uso de sitios de descarga ilegal. Se tomaron medidas para eliminar los efectos de las respuestas falsas y mal recordadas. [68] [69] [70]

Las aplicaciones peer-to-peer presentan uno de los problemas centrales en la controversia de la neutralidad de la red . Se sabe que los proveedores de servicios de Internet ( ISP ) limitan el tráfico de intercambio de archivos P2P debido a su alto uso de ancho de banda . [71] En comparación con la navegación web, el correo electrónico o muchos otros usos de Internet, donde los datos solo se transfieren en intervalos cortos y cantidades relativamente pequeñas, el intercambio de archivos P2P a menudo consiste en un uso relativamente alto del ancho de banda debido a las transferencias de archivos en curso y los paquetes de coordinación de red/enjambre. En octubre de 2007, Comcast , uno de los proveedores de Internet de banda ancha más grandes de los Estados Unidos, comenzó a bloquear aplicaciones P2P como BitTorrent . Su razonamiento fue que P2P se usa principalmente para compartir contenido ilegal y su infraestructura no está diseñada para un tráfico continuo de alto ancho de banda.

Los críticos señalan que las redes P2P tienen usos legales legítimos, y que esta es otra forma en que los grandes proveedores están tratando de controlar el uso y el contenido en Internet, y dirigir a las personas hacia una arquitectura de aplicaciones basada en cliente-servidor . El modelo cliente-servidor proporciona barreras financieras de entrada a pequeños editores e individuos, y puede ser menos eficiente para compartir archivos grandes. Como reacción a esta limitación del ancho de banda , varias aplicaciones P2P comenzaron a implementar la ofuscación de protocolos, como el cifrado del protocolo BitTorrent . Las técnicas para lograr la "ofuscación de protocolos" implican eliminar propiedades de los protocolos que de otro modo serían fácilmente identificables, como secuencias de bytes deterministas y tamaños de paquetes, haciendo que los datos parezcan aleatorios. [72] La solución del ISP al alto ancho de banda es el almacenamiento en caché P2P , donde un ISP almacena la parte de los archivos a la que más acceden los clientes P2P para ahorrar acceso a Internet.

Los investigadores han utilizado simulaciones por ordenador para ayudar a comprender y evaluar los comportamientos complejos de los individuos dentro de la red. "La investigación en redes a menudo se basa en la simulación para probar y evaluar nuevas ideas. Un requisito importante de este proceso es que los resultados deben ser reproducibles para que otros investigadores puedan replicar, validar y ampliar el trabajo existente". [73] Si la investigación no se puede reproducir, se obstaculiza la oportunidad de realizar más investigaciones. "Aunque se siguen lanzando nuevos simuladores, la comunidad de investigación tiende a utilizar solo un puñado de simuladores de código abierto. La demanda de funciones en los simuladores, como lo demuestran nuestros criterios y encuesta, es alta. Por lo tanto, la comunidad debería trabajar en conjunto para obtener estas funciones en el software de código abierto. Esto reduciría la necesidad de simuladores personalizados y, por lo tanto, aumentaría la repetibilidad y la reputación de los experimentos". [73]

Los simuladores populares que se usaron ampliamente en el pasado son NS2, OMNeT++, SimPy, NetLogo, PlanetLab, ProtoPeer, QTM, PeerSim, ONE, P2PStrmSim, PlanetSim, GNUSim y Bharambe. [74]

Además de todos los hechos mencionados anteriormente, también se ha trabajado en simuladores de red de código abierto ns-2. Aquí se ha explorado un problema de investigación relacionado con la detección y el castigo de los oportunistas utilizando el simulador ns-2. [75]

{{cite web}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite web}}: CS1 maint: copia archivada como título ( enlace )