La transparencia de la investigación es un aspecto fundamental de la investigación científica. Abarca una variedad de principios y prácticas científicas: reproducibilidad , intercambio de datos y códigos, normas de citación o verificabilidad.

Las definiciones y normas de transparencia en la investigación difieren significativamente según las disciplinas y los campos de investigación. Debido a la falta de una terminología uniforme, la transparencia en la investigación se ha definido con frecuencia de forma negativa, abordando usos no transparentes (que forman parte de prácticas de investigación cuestionables ).

Después de 2010, los problemas recurrentes de la metodología de investigación se han reconocido cada vez más como crisis estructurales que implican cambios profundos en todas las etapas del proceso de investigación. La transparencia se ha convertido en un valor clave del movimiento de ciencia abierta , que evolucionó de un enfoque inicial en la publicación para abarcar una gran diversidad de resultados de investigación. Los nuevos estándares comunes para la transparencia de la investigación, como las Directrices TOP , tienen como objetivo construir y fortalecer una cultura de investigación abierta en todas las disciplinas y culturas epistémicas.

No existe un consenso generalizado sobre la definición de transparencia de la investigación.

Las diferencias entre disciplinas y culturas epistémicas han contribuido en gran medida a diferentes acepciones. La reproducción de investigaciones anteriores ha sido una fuente importante de disenso. En un entorno experimental, la reproducción se basa en la misma configuración y el mismo aparato, mientras que la replicación solo requiere el uso de la misma metodología. Por el contrario, las disciplinas computacionales utilizan definiciones invertidas de los términos replicabilidad y reproducibilidad . [1] Las taxonomías alternativas han propuesto arreglárselas por completo con la ambigüedad de reproducibilidad/replicabilidad/repetibilidad. Goodman, Fanelli e Ioannidis recomendaron en cambio una distinción entre reproducibilidad del método (misma configuración experimental/computacional) y reproducibilidad del resultado (configuración diferente pero mismos principios generales). [2]

Los actores institucionales centrales siguen estando en desacuerdo sobre el significado y el uso de conceptos clave. En 2019, las Academias Nacionales de Ciencias de los Estados Unidos mantuvieron la definición experimental de replicación y reproducción, que sigue "en desacuerdo con la forma más flexible en que las utilizan [otras] organizaciones importantes". [3] La Asociación para la Maquinaria Computacional optó en 2016 por la definición computacional y agregó también una noción intermedia de repetibilidad , donde un equipo de investigación diferente utiliza exactamente el mismo sistema y procedimiento de medición. [4]

El debate sobre la transparencia de la investigación también ha creado nuevas convergencias entre diferentes disciplinas y círculos académicos. En El problema de la ciencia (2021), Rufus Barker Bausell sostiene que todas las disciplinas, incluidas las ciencias sociales, enfrentan actualmente problemas similares a los de la medicina y las ciencias físicas: "El problema, que ha llegado a conocerse como la crisis de la reproducibilidad, afecta a casi toda la ciencia, no a una o dos disciplinas individuales". [5]

Debido a la falta de una terminología consistente sobre la transparencia de la investigación, los científicos, los encargados de formular políticas y otras partes interesadas importantes recurren cada vez más a definiciones negativas: ¿cuáles son las prácticas y formas que dañan o alteran cualquier ideal común de transparencia de la investigación? [ cita requerida ]

La taxonomía de las malas prácticas científicas se ha ampliado gradualmente desde la década de 1980. El concepto de prácticas de investigación cuestionables (o QRP) se introdujo por primera vez en un informe de 1992 del Comité de Ciencia, Ingeniería y Políticas Públicas como una forma de abordar los posibles fallos de investigación no intencionales (como las deficiencias en el proceso de gestión de datos de investigación). [6] Las prácticas de investigación cuestionables revelan una gran zona gris de prácticas problemáticas, que con frecuencia se asocian a deficiencias en la transparencia de la investigación. En 2016, un estudio identificó hasta 34 prácticas de investigación cuestionables o "grados de libertad", que pueden ocurrir en todas las etapas del proyecto (la hipótesis inicial, el diseño del estudio, la recopilación de datos, el análisis y la presentación de informes). [7]

Las encuestas sobre prácticas disciplinarias han mostrado grandes diferencias en la admisibilidad y difusión de prácticas de investigación cuestionables. Si bien la fabricación de datos y, en menor medida, el redondeo de indicadores estadísticos como el valor p son ampliamente rechazados, la no publicación de resultados negativos o la adición de datos complementarios no se identifican como problemas importantes. [8] [9]

En 2009, un metaanálisis de 18 encuestas estimó que menos del 2% de los científicos "admitieron haber fabricado, falsificado o modificado datos o resultados al menos una vez". La prevalencia real puede estar subestimada debido a la autodeclaración: con respecto a "la conducta de los colegas, las tasas de admisión fueron del 14,12%". [10] Las prácticas de investigación cuestionables están más extendidas, ya que más de un tercio de los encuestados admiten haberlo hecho una vez. [10] Una gran encuesta de 2021 de 6.813 encuestados en los Países Bajos arrojó una estimación significativamente más alta, con un 4% de los encuestados participando en la fabricación de datos y más de la mitad de los encuestados participando en prácticas de investigación cuestionables. [11] Las tasas más altas pueden atribuirse a un deterioro de las normas éticas o a "la mayor conciencia de la integridad de la investigación en los últimos años". [12]

La transparencia ha sido reconocida cada vez más como un componente importante de la ciencia abierta . Hasta la década de 2010, las definiciones de ciencia abierta se han centrado principalmente en el acceso técnico y la mejora de la participación y la colaboración entre académicos y no académicos. En 2016, Liz Lyon identificó la transparencia como una "tercera dimensión" de la ciencia abierta, debido al hecho de que "el concepto de transparencia y el término asociado 'reproducibilidad', han adquirido cada vez mayor importancia en el actual entorno de investigación interdisciplinaria". [13] Según Kevin Elliott, el movimiento de la ciencia abierta "abarca una serie de iniciativas diferentes destinadas a formas algo diferentes de transparencia". [14]

Las directrices TOP, redactadas por primera vez en 2014, han contribuido significativamente a incluir la transparencia en la agenda de los movimientos de ciencia abierta. [15] Su objetivo es promover una "cultura de investigación abierta" e implementar "fuertes incentivos para ser más transparentes". [16] Se basan en ocho estándares, con diferentes niveles de cumplimiento. Si bien los estándares son modulares, también apuntan a articular un espíritu científico coherente, ya que "también se complementan entre sí, en el sentido de que el compromiso con un estándar puede facilitar la adopción de otros". [15]

Este marco de transparencia de la ciencia abierta ha sido a su vez cooptado por los principales contribuyentes e instituciones en el tema de la transparencia de la investigación. Después de 2015, las contribuciones de los historiadores de la ciencia subrayaron que no ha habido un deterioro significativo de la calidad de la investigación, ya que los experimentos anteriores y el diseño de la investigación no estaban significativamente mejor concebidos y la tasa de resultados falsos o parcialmente falsos probablemente se ha mantenido aproximadamente constante durante las últimas décadas. [17] [18] En consecuencia, los defensores de la transparencia de la investigación han llegado a adoptar de manera más explícita el discurso de la ciencia abierta: la cultura de la transparencia científica se convierte en un nuevo ideal a alcanzar en lugar de un principio fundamental a restablecer.

El concepto de transparencia ha contribuido a crear convergencias entre la ciencia abierta y otros movimientos abiertos en diferentes áreas, como los datos abiertos o el gobierno abierto . En 2015, la OCDE describió la transparencia como una "razón de ser común para la ciencia abierta y los datos abiertos". [19]

La transparencia ha sido un criterio fundamental de la investigación experimental durante siglos. [20] Las réplicas exitosas se han convertido en una parte integral del discurso institucional de las ciencias naturales (entonces llamada filosofía natural ) en el siglo XVII. [21] Una sociedad científica temprana de Florencia, la Accademia del Cimento, adoptó en 1657 el lema provando e riprovando como un llamado a "representaciones repetidas (públicas) de ensayos experimentales" [22] Un miembro clave de la Accademia , el naturalista Francesco Redi describió extensamente las formas y beneficios de la experimentación procedimental, que hizo posible verificar los efectos aleatorios, la solidez del diseño del experimento o las relaciones causales a través de ensayos repetidos [23] La replicación y la documentación abierta de los experimentos científicos se ha convertido en un componente clave de la difusión del conocimiento científico en la sociedad: una vez que alcanzaron una tasa satisfactoria de éxito, los experimentos podrían realizarse en una variedad de espacios sociales como tribunales, mercados o salones académicos . [24]

Aunque la transparencia se reconoció desde el principio como un componente clave de la ciencia, no se definió de manera uniforme. La mayoría de los conceptos asociados hoy en día con la transparencia de la investigación surgieron como términos técnicos sin definiciones claras y generalizadas. El concepto de reproducibilidad apareció en un artículo sobre los "Métodos de iluminación" publicado por primera vez en 1902: uno de los métodos examinados se consideró limitado en cuanto a "reproducibilidad y constancia" [25]. En 2019, las Academias Nacionales subrayaron que la distinción entre reproducción, repetición y replicación ha permanecido en gran medida poco clara y sin armonización entre disciplinas: "Lo que un grupo quiere decir con una palabra, el otro grupo lo quiere decir con la otra palabra. Estos términos -y otros, como repetibilidad- se han utilizado durante mucho tiempo en relación con el concepto general de un experimento o estudio que confirma los resultados de otro". [26]

Más allá de esta falta de formalización, se produjo una importante desviación entre el discurso institucional y disciplinario sobre la transparencia de la investigación y la realidad del trabajo de investigación, que ha persistido hasta el siglo XXI. Debido al alto coste de los aparatos y a la falta de incentivos, la mayoría de las experiencias no fueron reproducidas por los investigadores contemporáneos: incluso un defensor comprometido del experimentalismo como Robert Doyle tuvo que recurrir a una forma de experimentalismo virtual , describiendo en detalle un diseño de investigación que sólo se ha llevado a cabo una vez [27]. Para Friedrich Steinle, la brecha entre la virtud postulada de la transparencia y las condiciones materiales de la ciencia nunca se ha resuelto: "Los raros casos en los que realmente se intenta la replicación son aquellos que son centrales para el desarrollo de la teoría (por ejemplo, por ser incompatibles con la teoría existente) o prometen una amplia atención debido a importantes perspectivas económicas. A pesar del ideal formal de la replicabilidad, no vivimos en una cultura de la replicación". [28]

El desarrollo de la gran ciencia después de la Segunda Guerra Mundial ha creado desafíos sin precedentes para la transparencia de la investigación. La generalización de los métodos estadísticos a un gran número de campos, así como la creciente amplitud y complejidad de los proyectos de investigación, conllevaron una serie de preocupaciones sobre la falta de documentación adecuada del proceso científico.

Debido a la expansión de la producción científica publicada, se han desarrollado nuevos métodos cuantitativos para el estudio de la literatura, denominados metaanálisis o metaciencia . Estos métodos se basan en el supuesto de que los resultados cuantitativos y los detalles del marco experimental y observacional son sólidos (como el tamaño o la composición de la muestra). En 1966, Stanley Schor e Irving Karten publicaron una de las primeras evaluaciones genéricas de métodos estadísticos en 67 revistas médicas de primera línea. Si bien se encontraron pocos artículos claramente problemáticos, "en casi el 73% de los informes leídos (los que necesitaban revisión y los que deberían haber sido rechazados), se extrajeron conclusiones cuando la justificación de estas conclusiones no era válida" [29].

En los años 1970 y 1980, las malas conductas científicas dejaron de presentarse gradualmente como malas conductas individuales y se convirtieron en problemas colectivos que las instituciones y comunidades científicas deben abordar. Entre 1979 y 1981, varios casos importantes de fraudes científicos y plagio atrajeron una mayor atención sobre el tema por parte de investigadores y responsables de políticas en los Estados Unidos [30] . En una investigación muy publicitada, Betrayers of Science , dos periodistas científicos describieron el fraude científico como un problema estructural: "A medida que más casos de fraude salían a la luz pública (...) nos preguntamos si el fraude no era una característica menor bastante habitual del panorama científico (...) La lógica, la replicación, la revisión por pares: todo había sido desafiado con éxito por falsificadores científicos, a menudo durante largos períodos de tiempo". [31] La codificación de la integridad de la investigación ha sido la principal respuesta institucional a este mayor escrutinio público con "numerosos códigos de conducta específicos de cada campo, nacionales e internacionales por igual". [32]

En la década de 2000, los problemas de larga data sobre la estandarización de la metodología de investigación se han presentado cada vez más como una crisis estructural que "si no se aborda, el público en general inevitablemente perderá su confianza en la ciencia". [33] El comienzo de la década de 2010 se considera comúnmente como un punto de inflexión: "no fue hasta alrededor de 2011-2012 que la conciencia de la comunidad científica fue bombardeada con advertencias de irreproducibilidad". [34]

Una contribución temprana e importante al debate ha sido la controvertida e influyente afirmación de John Ioannidis de 2005: " la mayoría de los resultados de investigación publicados son falsos" . [35] El argumento principal se basaba en los estándares experimentales excesivamente laxos establecidos, con numerosos resultados débiles presentados como investigaciones sólidas: "la mayoría de la investigación biomédica moderna está operando en áreas con una probabilidad muy baja de obtener resultados verdaderos antes y después del estudio" [36].

Debido a que se publicó en PLOS Medicine, el estudio de Ioannidis tuvo un eco considerable en psicología, medicina y biología. En las décadas siguientes, proyectos de gran alcance intentaron evaluar la reproducibilidad experimental. En 2015, el Proyecto de Reproducibilidad: Psicología intentó reproducir 100 estudios de tres revistas de psicología importantes ( Journal of Personality and Social Psychology , Journal of Experimental Psychology: Learning, Memory, and Cognition y Psychological Science ): si bien casi todos los artículos tenían efectos reproducibles, se encontró que solo el 36% de las réplicas eran lo suficientemente significativas ( valor p por encima del umbral común de 0,05). [37] En 2021, otro Proyecto de Reproducibilidad, Cancer Biology, analizó 53 artículos importantes sobre el cáncer publicados entre 2010 y 2012 y estableció que los tamaños del efecto eran un 85% más pequeños en promedio que los hallazgos originales. [38]

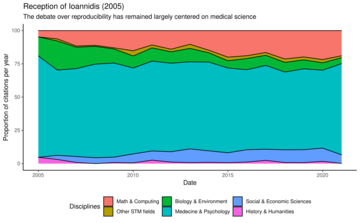

Durante la década de 2010, el concepto de crisis de reproducibilidad se ha ampliado a un abanico más amplio de disciplinas. La proporción de citas por año del artículo seminal de John Ioannidis, Why Most Published Research Findings Are False en los principales campos de investigación según los metadatos registrados por el motor de búsqueda académico Semantic Scholar (6.349 citas a junio de 2022) muestra cómo este marco se ha expandido especialmente a las ciencias de la computación. En Economía, una réplica de 18 estudios experimentales en dos revistas importantes encontró una tasa de fracaso comparable a la de la psicología o la medicina (39%). [39]

Varias encuestas globales han informado de un creciente malestar de las comunidades científicas sobre la reproducibilidad y otras cuestiones de transparencia de la investigación. En 2016, Nature destacó que "más del 70% de los investigadores han intentado y fracasado en reproducir los experimentos de otros científicos, y más de la mitad no han podido reproducir sus propios experimentos" [40]. La encuesta también encontró que "no hay consenso sobre qué es o debería ser la reproducibilidad", en parte debido a las diferencias disciplinarias, lo que hace más difícil evaluar cuáles podrían ser los pasos necesarios para superar el problema en juego. [40] La encuesta de Nature también ha sido criticada por su paradójica falta de transparencia de la investigación, ya que no se basó en una muestra representativa sino en una encuesta en línea: se ha "basado en muestras de conveniencia y otras opciones metodológicas que limitan las conclusiones que se pueden sacar sobre las actitudes entre la comunidad científica en general" [41]. A pesar de los resultados mixtos, la encuesta de Nature se ha difundido en gran medida y se ha convertido en un dato de entrada común para cualquier estudio de transparencia de la investigación. [42]

La crisis de reproducibilidad y otras cuestiones de transparencia en la investigación se han convertido en un tema público abordado en la prensa general: "Las conversaciones sobre reproducibilidad también son únicas en comparación con otras conversaciones metodológicas porque han recibido una atención sostenida tanto en la literatura científica como en la prensa popular". [43]

Desde el año 2000, el movimiento de la ciencia abierta se ha expandido más allá del acceso a los resultados científicos (publicaciones, datos o software) para abarcar todo el proceso de producción científica. En 2018, Vicente-Saez y Martínez-Fuentes han intentado mapear los valores comunes compartidos por las definiciones estándar de ciencia abierta en la literatura científica de habla inglesa indexada en Scopus y la Web of Science . [44] El acceso ya no es la dimensión principal de la ciencia abierta, ya que se ha ampliado con compromisos más recientes hacia la transparencia, el trabajo colaborativo y el impacto social. [45] A través de este proceso, la ciencia abierta se ha estructurado cada vez más sobre un conjunto consistente de principios éticos: "se han desarrollado nuevas prácticas de ciencia abierta en conjunto con nuevas formas de organización de realizar y compartir investigaciones a través de repositorios abiertos, laboratorios físicos abiertos y plataformas de investigación transdisciplinarias. Juntas, estas nuevas prácticas y formas de organización están expandiendo el espíritu de la ciencia en las universidades". [46]

La escala global del movimiento de ciencia abierta y su integración en una gran variedad de herramientas técnicas, estándares y regulaciones permite superar el "clásico problema de acción colectiva" encarnado por la transparencia de la investigación: existe una discrepancia estructural entre el objetivo declarado de las instituciones científicas y la falta de incentivos para implementarlos a nivel individual. [15]

La formalización de la ciencia abierta como un marco potencial para garantizar la transparencia de la investigación ha sido inicialmente emprendida por iniciativas institucionales y comunitarias. Las directrices TOP fueron elaboradas en 2014 por un comité para la Promoción de la Transparencia y la Apertura que incluía "líderes disciplinarios, editores de revistas, representantes de agencias de financiación y expertos disciplinarios en gran medida de las ciencias sociales y del comportamiento". [15] Las directrices se basan en ocho estándares, con diferentes niveles de cumplimiento. Si bien los estándares son modulares, también apuntan a articular un ethos consistente de la ciencia ya que "también se complementan entre sí, en el sentido de que el compromiso con un estándar puede facilitar la adopción de otros". [15]

Después de 2015, estas iniciativas han influido en parte en nuevas regulaciones y códigos éticos. El Código de Conducta Europeo para la Integridad en la Investigación de 2017 está fuertemente estructurado en torno a la ciencia abierta y los datos abiertos: “presta a la gestión de datos casi la misma atención que a la publicación y también es, en este sentido, el más avanzado de los cuatro Códigos de Conducta”. [47] Adoptados por primera vez en julio de 2020, los principios de Hong Kong para evaluar a los investigadores reconocen la ciencia abierta como uno de los cinco pilares de la integridad científica: “Parece claro que las diversas modalidades de ciencia abierta deben ser recompensadas en la evaluación de los investigadores porque estas conductas aumentan fuertemente la transparencia, que es un principio central de la integridad de la investigación”. [48]

La transparencia de la investigación tiene una gran variedad de formas dependiendo de la cultura disciplinaria, la condición material de la investigación y la interacción entre los científicos y otros círculos sociales (responsables de la formulación de políticas, profesionales no académicos, público en general). Para Lyon, Jeng y Mattern, "el término 'transparencia' ha sido aplicado en una variedad de contextos por diversos actores de la investigación, que han articulado y enmarcado el concepto de varias maneras diferentes". [19] En 2020, Kevin Elliott presentó una taxonomía de ocho dimensiones de la transparencia de la investigación: propósito, audiencia, contenido, marco temporal, actores, mecanismo, lugares y peligros. [49] Para Elliott no todas las formas de transparencia son alcanzables y deseables, por lo que una terminología adecuada puede ayudar a tomar las decisiones más apropiadas: "Si bien estas son objeciones importantes, la taxonomía de la transparencia considerada aquí sugiere que la mejor respuesta a ellas es, por lo general, no abandonar por completo el objetivo de la transparencia para considerar qué formas de transparencia son las más capaces de minimizarlas". [50]

Goodman, Fanelli e Ioannidis definen la reproducibilidad de un método como “la provisión de suficientes detalles sobre los procedimientos y datos de un estudio para que los mismos procedimientos puedan, en teoría o en la realidad, repetirse exactamente”. [2] Esta acepción es en gran medida sinónimo de replicabilidad en un contexto computacional o reproducibilidad en un contexto experimental. En el informe de las Academias Nacionales de Ciencias, que optaron por una terminología experimental, la contraparte de la reproducibilidad de un método se describió como “la obtención de resultados consistentes utilizando los mismos datos de entrada; pasos computacionales, métodos y códigos; y condiciones de análisis”. [26]

La reproducibilidad de los métodos es más alcanzable en las ciencias computacionales: siempre que se comporte como se espera, el mismo código debería producir el mismo resultado. El código abierto, los datos abiertos y, más recientemente, los cuadernos de investigación son recomendaciones comunes para mejorar la reproducibilidad de los métodos. En principio, la mayor disponibilidad de los resultados de la investigación permite evaluar y auditar el proceso de análisis. En la práctica, Roger Peng ya subrayó en 2011 que muchos proyectos requieren "poder de cómputo que puede no estar disponible para todos los investigadores". [51] Este problema ha empeorado en algunas áreas como la inteligencia artificial o la visión por computadora , ya que el desarrollo de modelos de aprendizaje profundo muy grandes hace que sea casi imposible recrearlos (o a un costo prohibitivo), incluso cuando el código y los datos originales están abiertos. La reproducibilidad de los métodos también puede verse afectada por la dependencia de la biblioteca , ya que el código abierto puede depender de programas externos que pueden no estar siempre disponibles o no ser compatibles. Dos estudios realizados en 2018 y 2019 han demostrado que una gran parte de los cuadernos de investigación alojados en GitHub ya no se pueden utilizar, ya sea porque las extensiones necesarias ya no están disponibles o porque hay problemas en el código. [52] [53]

En las ciencias experimentales, no existe un criterio comúnmente acordado de reproducibilidad de un método: "en la práctica, el nivel de detalle procedimental necesario para describir un estudio como "metodológicamente reproducible" no tiene consenso". [2]

Goodman, Fanelli e Ioannidis definen la reproducibilidad de los resultados como "obtener los mismos resultados a partir de la realización de un estudio independiente cuyos procedimientos son lo más parecidos posible". [2] La reproducibilidad de los resultados es comparable a la replicación en un contexto experimental y a la reproducibilidad en un contexto computacional. La definición de replicabilidad que se mantiene en las Academias Nacionales de Ciencias se aplica en gran medida a ella: "obtener resultados consistentes en estudios destinados a responder la misma pregunta científica, cada uno de los cuales ha obtenido sus propios datos". [26] La crisis de reproducibilidad que se encuentra en disciplinas experimentales como la psicología o la medicina es principalmente una crisis de "reproducibilidad de los resultados", ya que se refiere a investigaciones que no se pueden volver a ejecutar simplemente, sino que implican la recreación independiente del diseño experimental. [26] Como tal, se podría decir que es la forma más debatida de transparencia de la investigación en los últimos años. [14]

La reproducibilidad de los resultados es más difícil de lograr que otras formas de transparencia en la investigación. Implica una variedad de cuestiones que pueden incluir la reproducibilidad computacional, la precisión de la medición científica [26] y la diversidad de enfoques metodológicos. [54] No existen estándares universales para determinar cuán cerca están de coincidir los procedimientos originales y el criterio puede variar dependiendo de las disciplinas o, incluso, del campo de investigación. En consecuencia, el metaanálisis de la reproducibilidad se ha enfrentado a desafíos significativos. Un estudio de 2015 de 100 artículos de psicología realizado por Open Science Collaboration se enfrentó a la "falta de una única definición aceptada", lo que "abrió la puerta a la controversia sobre su enfoque metodológico y sus conclusiones" y obligó a recurrir a "evaluaciones subjetivas" de la reproducibilidad de los resultados. [55]

En 2018 Sabina Leonelli define la reproducibilidad de la observación como la "expectativa de que cualquier investigador experto colocado en el mismo tiempo y lugar pueda detectar, si no los mismos datos, al menos patrones similares". [56] Esta expectativa recupera una amplia gama de prácticas científicas y académicas en disciplinas no experimentales: [57] "Una enorme cantidad de investigación en las ciencias médicas, históricas y sociales no se basa en la experimentación, sino más bien en técnicas de observación como encuestas, descripciones e informes de casos que documentan circunstancias únicas" [56]

El desarrollo de una infraestructura científica abierta ha transformado radicalmente el estatus y la disponibilidad de los datos científicos y otras fuentes primarias. El acceso a estos recursos se ha transformado por completo gracias a la digitalización y la atribución de identificadores únicos. Los identificadores de objetos digitales permanentes (o DOI) se han asignado por primera vez a los conjuntos de datos desde principios de la década de 2000 [58], lo que resolvió un debate de larga data sobre la citabilidad de los datos científicos. [59]

Andrew Moravcsik ha definido la mayor transparencia de las citas de fuentes primarias o materiales de investigación como una "revolución en la investigación cualitativa". [60] El acceso a estos recursos se ha transformado por completo gracias a la digitalización y la atribución de identificadores únicos. Los identificadores de objetos digitales permanentes (o DOI) se han asignado por primera vez a los conjuntos de datos desde principios de la década de 2000 [58], lo que resolvió un debate de larga data sobre la citabilidad de los datos científicos. [59]

La transparencia de los valores de la investigación ha sido un tema central en las disciplinas con una fuerte participación en la formulación de políticas, como los estudios ambientales o las ciencias sociales. En 2009, Heather Douglas subrayó que el discurso público sobre la ciencia ha estado dominado en gran medida por ideales normativos de investigación objetiva: si los procedimientos se han aplicado correctamente, los resultados científicos deberían estar "libres de valores". [61] Para Douglas, este ideal sigue siendo en gran medida inviable en el proceso eficaz de investigación y asesoramiento científico, ya que los valores predefinidos pueden ser en gran medida anteriores a las decisiones sobre los conceptos, los protocolos y los datos utilizados. [62] Douglas argumentó en cambio a favor de una divulgación de los valores defendidos por los investigadores: "los valores deberían hacerse lo más explícitos posible en este papel indirecto, ya sea en los documentos de políticas o en los artículos de investigación de los científicos". [63]

En la década de 2010, varios filósofos de la ciencia intentaron sistematizar la transparencia de los valores en el contexto de la ciencia abierta. En 2017, Kevin Elliott destacó tres condiciones para la transparencia de los valores en la investigación; la primera de ellas implicaba “ser lo más transparente posible sobre (…) los datos, métodos, modelos y supuestos para que la influencia de los valores pueda ser examinada”. [64]

Hasta la década de 2010, las prácticas editoriales de las publicaciones académicas han permanecido en gran medida informales y poco estudiadas: “A pesar de 350 años de publicaciones académicas (…) la investigación sobre las ItAs [Instrucción a los autores], y sobre su evolución y cambio, es escasa”. [65]

Recientemente se ha reconocido que la transparencia editorial es una expansión natural del debate sobre la reproducibilidad de la investigación. [66] [67] Varios principios establecidos en las directrices TOP de 2015 ya implicaban la existencia de estándares editoriales explícitos. [68] La atención sin precedentes prestada a la transparencia editorial también ha sido motivada por la diversificación y la complejización del panorama de la publicación científica abierta: "Impulsadas por una amplia variedad de expectativas para los procesos editoriales de las revistas, las revistas han comenzado a experimentar con nuevas formas de organizar sus sistemas de evaluación editorial y revisión por pares (...) La llegada de estas innovaciones a un conjunto ya diverso de prácticas de revisión por pares y selección editorial significa que ya no podemos asumir que los autores, lectores y revisores simplemente saben cómo funciona la evaluación editorial". [66]

Las directrices TOPs han establecido un estándar transdisciplinario influyente para establecer la reproducibilidad de los resultados en un contexto de ciencia abierta. Si bien las disciplinas experimentales y computacionales siguen siendo el foco principal, los estándares se han esforzado por integrar inquietudes y formatos más específicos de otras prácticas disciplinarias (como los materiales de investigación).

Los incentivos informales, como las insignias o los índices, se han propuesto inicialmente como una forma de apoyar la adopción de políticas armonizadas en materia de transparencia en la investigación. Debido al desarrollo de la ciencia abierta, la regulación y las infraestructuras o procesos estandarizados son cada vez más favorecidos.

El intercambio de datos se ha identificado desde el principio como una posible solución a la crisis de reproducibilidad y a la falta de directrices sólidas para los indicadores estadísticos. En 2005, John Ioannidis planteó la hipótesis de que "algún tipo de registro o interconexión de recopilaciones de datos o investigadores dentro de los campos puede ser más factible que el registro de todos y cada uno de los experimentos generadores de hipótesis". [69]

La puesta en común de los resultados de las investigaciones está cubierta por tres normas de las directrices TOP: transparencia de los datos (2), transparencia de los métodos analíticos y de los códigos (3) y transparencia de los materiales de investigación (4). Todos los datos, códigos y materiales de investigación pertinentes deben almacenarse en un "repositorio de confianza" y todos los análisis deben reproducirse de forma independiente antes de su publicación. [70]

Si bien los estándares de citación se aplican comúnmente a las referencias académicas, hay mucha menos formalización para todos los demás resultados de investigación, como datos, códigos, fuentes primarias o evaluaciones cualitativas.

En 2012, la Asociación Estadounidense de Ciencias Políticas adoptó nuevas políticas para la investigación cualitativa abierta. [71] Cubrieron tres dimensiones de transparencia: transparencia de datos (en el sentido de datos bibliográficos precisos de las fuentes originales), transparencia analítica (en relación con las afirmaciones extrapoladas de las fuentes citadas) y transparencia de producción (en referencia a las decisiones editoriales realizadas en la selección de las fuentes). [72] En 2014, Andrew Moravcsik abogó por la implementación de un apéndice de transparencia , que contenga citas detalladas de las fuentes originales, así como anotaciones "que expliquen cómo la fuente respalda la afirmación que se está haciendo". [73]

Según las directrices TOP , se debe proporcionar una "cita apropiada de los datos y materiales" en cada publicación. [70] En consecuencia, los resultados científicos como el código o el conjunto de datos se reconocen plenamente como contribuciones citables: "La cita regular y rigurosa de estos materiales los acredita como contribuciones intelectuales originales". [70]

Los prerregistros están cubiertos por dos directrices TOP: Prerregistro de estudios (6) y Prerregistro de planes de análisis (7). En ambos casos, para el nivel más alto de cumplimiento, la revista debe proporcionar "un enlace y una insignia en el artículo para cumplir con los requisitos". [70]

El objetivo de los prerregistros es abordar de manera preventiva una variedad de prácticas de investigación cuestionables . Por lo general, adopta la forma de "un plan de investigación no editable con marca de tiempo que se envía a un archivo público [que] establece las hipótesis que se deben probar y los tamaños de muestra objetivo". [74] El prerregistro actúa como un contrato ético, ya que teóricamente restringe "los grados de libertad del investigador que hacen que los QRP y el p-hacking funcionen". [74]

El prerregistro no resuelve toda la gama de prácticas de investigación cuestionables. La presentación selectiva de los resultados sería especialmente compatible con un plan de investigación predefinido: "el prerregistro no contrarresta totalmente el sesgo de publicación, ya que no garantiza que se publiquen los resultados". [75] Se ha argumentado que el prerregistro también puede, en algunos casos, perjudicar la calidad de los resultados de la investigación al crear restricciones artificiales que no se ajustan a la realidad del campo de investigación: "El prerregistro puede interferir con la inferencia válida porque nada impide que un investigador prerregistre un plan analítico deficiente". [76]

Aunque se la defiende como una solución relativamente gratuita, la preinscripción puede ser en realidad más difícil de implementar, ya que depende de un compromiso significativo por parte de los investigadores. Un estudio empírico sobre la adopción de experimentos de ciencia abierta en una revista de psicología ha demostrado que "la adopción de la preinscripción va a la zaga de otras prácticas de ciencia abierta (...) entre 2015 y 2020". [77] En consecuencia, "incluso entre los investigadores que ven beneficios de la preinscripción para todo el campo, existe incertidumbre en torno a los costos y beneficios para las personas". [77]

Los estudios de replicación o evaluaciones de replicabilidad tienen como objetivo rehacer uno o varios estudios originales. Aunque el concepto apareció recién en la década de 2010, los estudios de replicación existen desde hace décadas, pero no se los reconoce como tales. [78] El informe de 2019 de las Academias Nacionales incluye un metaanálisis de 25 replicaciones publicadas entre 1986 y 2019. En él se concluye que la mayoría de las replicaciones se refieren a las ciencias médicas y sociales (especialmente, la psicología y la economía del comportamiento) y que por ahora no hay criterios de evaluación estandarizados: "los métodos para evaluar la replicabilidad son inconsistentes y los porcentajes de replicabilidad dependen en gran medida de los métodos utilizados". [78] En consecuencia, al menos en lo que respecta a 2019, los estudios de replicación no se pueden agregar para extrapolar una tasa de replicabilidad: "no son necesariamente indicativos de la tasa real de no replicabilidad en la ciencia para un número" [78]

Las directrices TOPs han pedido un mayor reconocimiento y valorización de los estudios de replicación. La octava norma establece que las revistas que cumplan con las normas deben utilizar "informes registrados como una opción de presentación para estudios de replicación con revisión por pares". [70]

En julio de 2018, varios editores, bibliotecarios, editores de revistas e investigadores redactaron una Declaración de Leiden para políticas editoriales transparentes . [79] La declaración subrayó que las revistas "a menudo no contienen información sobre la selección de revisores, los criterios de revisión, el cegamiento, el uso de herramientas digitales como escáneres de similitud de texto, así como políticas sobre correcciones y retractaciones" y esta falta de transparencia. [79] La declaración identifica cuatro fases principales de publicación y revisión por pares que deberían estar mejor documentadas:

En 2020, la Declaración de Leiden se ha ampliado y complementado con una Plataforma para Políticas Editoriales Responsables (PREP). [80] Esta iniciativa también tiene como objetivo resolver la escasez estructural de datos e información empírica sobre políticas editoriales y prácticas de revisión por pares. [66] [81] A partir de 2022, esta base de datos contiene información parcialmente colaborativa sobre los procedimientos editoriales de 490 revistas, [82] a partir de una base inicial de 353 revistas. [83] Los procedimientos evaluados incluyen especialmente "el nivel de anonimato otorgado a los autores y revisores; el uso de herramientas digitales como escáneres de plagio; y el momento de la revisión por pares en el proceso de investigación y publicación". [84] A pesar de estos avances, la investigación sobre la investigación editorial aún destaca la necesidad de "una base de datos integral que permita a los autores u otras partes interesadas comparar revistas en función de sus (...) requisitos o recomendaciones" [85]

{{cite journal}}: CS1 maint: DOI inactivo a partir de agosto de 2024 ( enlace ){{cite journal}}: CS1 maint: DOI inactivo a partir de agosto de 2024 ( enlace ){{cite journal}}: Requiere citar revista |journal=( ayuda ){{cite journal}}: Mantenimiento CS1: fecha y año ( enlace )