En la teoría matemática de la probabilidad , una cadena de Markov absorbente es una cadena de Markov en la que cada estado puede alcanzar un estado absorbente. Un estado absorbente es un estado del que, una vez ingresado, no se puede salir.

Al igual que las cadenas de Markov generales, puede haber cadenas de Markov absorbentes en tiempo continuo con un espacio de estados infinito. Sin embargo, este artículo se concentra en el caso de espacio de estados discreto en tiempo discreto.

Una cadena de Markov es una cadena absorbente si [1] [2]

En una cadena de Markov absorbente, un estado que no es absorbente se denomina transitorio.

Sea una cadena absorbente de Markov con matriz de transición P que tenga t estados transitorios y r estados absorbentes. A diferencia de una matriz de transición típica, las filas de P representan fuentes, mientras que las columnas representan destinos. Entonces

donde Q es una matriz t por t , R es una matriz t por r distinta de cero, 0 es una matriz cero r por t e I r es la matriz identidad r por r . Por lo tanto, Q describe la probabilidad de transición de un estado transitorio a otro, mientras que R describe la probabilidad de transición de un estado transitorio a un estado absorbente.

La probabilidad de transición de i a j en exactamente k pasos es la entrada ( i , j ) de P k , calculada con más detalle a continuación. Al considerar solo los estados transitorios, la probabilidad que se encuentra en la parte superior izquierda de P k , la entrada ( i , j ) de Q k .

Una propiedad básica de una cadena de Markov absorbente es el número esperado de visitas a un estado transitorio j a partir de un estado transitorio i (antes de ser absorbida). Se puede establecer que esto viene dado por la entrada ( i , j ) de la llamada matriz fundamental N , obtenida sumando Q k para todos los k (de 0 a ∞). Se puede demostrar que

donde I t es la matriz identidad t por t . El cálculo de esta fórmula es la matriz equivalente de la serie geométrica de escalares, .

Con la matriz N en mano, también es fácil obtener otras propiedades de la cadena de Markov. [2]

El número esperado de pasos antes de ser absorbido en cualquier estado absorbente, al comenzar en el estado transitorio i, se puede calcular mediante una suma de los estados transitorios. El valor se da por la entrada i del vector

donde 1 es un vector de columna de longitud t cuyas entradas son todas 1.

Por inducción,

La probabilidad de ser finalmente absorbido en el estado absorbente j al partir del estado transitorio i está dada por la entrada ( i , j ) de la matriz

El número de columnas de esta matriz es igual al número de estados absorbentes r .

También se puede obtener una aproximación de esas probabilidades directamente a partir de la entrada ( i , j ) de para un valor suficientemente grande de k , cuando i es el índice de un estado transitorio y j el índice de un estado absorbente. Esto se debe a que

La probabilidad de visitar el estado transitorio j al comenzar en un estado transitorio i es la entrada ( i , j ) de la matriz

donde N dg es la matriz diagonal con la misma diagonal que N .

La varianza en el número de visitas a un estado transitorio j comenzando en un estado transitorio i (antes de ser absorbido) es la entrada ( i , j ) de la matriz

donde N sq es el producto Hadamard de N consigo mismo (es decir, cada entrada de N se eleva al cuadrado).

La varianza en el número de pasos antes de ser absorbido al comenzar en el estado transitorio i es la i- ésima entrada del vector

donde t sq es el producto de Hadamard de t consigo mismo (es decir, como con N sq , cada entrada de t se eleva al cuadrado).

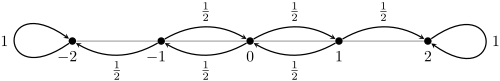

Considere el proceso de lanzar repetidamente una moneda justa hasta que aparezca la secuencia (cara, cruz, cara). Este proceso se modela mediante una cadena de Markov absorbente con matriz de transición.

El primer estado representa la cadena vacía , el segundo estado la cadena "H", el tercer estado la cadena "HT" y el cuarto estado la cadena "HTH". Aunque en realidad los lanzamientos de moneda cesan después de que se genera la cadena "HTH", la perspectiva de la cadena de Markov absorbente es que el proceso ha pasado al estado absorbente que representa la cadena "HTH" y, por lo tanto, no puede salir.

Para esta cadena absorbente de Markov, la matriz fundamental es

El número esperado de pasos a partir de cada uno de los estados transitorios es

Por lo tanto, el número esperado de lanzamientos de moneda antes de observar la secuencia (cara, cruz, cara) es 10, la entrada para el estado que representa la cadena vacía.

Los juegos basados completamente en el azar pueden modelarse mediante una cadena absorbente de Markov. Un ejemplo clásico de esto es el antiguo juego de mesa indio Serpientes y escaleras . El gráfico de la izquierda [3] representa la masa de probabilidad en el único estado absorbente que representa el cuadrado final a medida que la matriz de transición se eleva a potencias cada vez mayores. Para determinar el número esperado de turnos para completar el juego, calcule el vector t como se describió anteriormente y examine t start , que es aproximadamente 39,2.

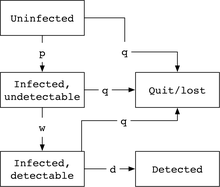

Las pruebas de enfermedades infecciosas, ya sea de productos sanguíneos o en clínicas médicas, a menudo se enseñan como un ejemplo de una cadena de Markov absorbente. [4] El modelo público de los Centros para el Control y la Prevención de Enfermedades (CDC) de los EE. UU. para el VIH y la hepatitis B, por ejemplo, [5] ilustra la propiedad de que la absorción de cadenas de Markov puede conducir a la detección de enfermedades, frente a la pérdida de detección a través de otros medios.

En el modelo estándar de los CDC, la cadena de Markov tiene cinco estados: un estado en el que el individuo no está infectado, luego un estado con el virus infectado pero indetectable, un estado con el virus detectable y estados absorbentes de haber abandonado/haberse perdido de la clínica, o de haber sido detectado (el objetivo). Las tasas típicas de transición entre los estados de Markov son la probabilidad p por unidad de tiempo de estar infectado con el virus, w para la tasa de eliminación del período ventana (tiempo hasta que el virus es detectable), q para la tasa de abandono/pérdida del sistema, y d para la detección, suponiendo una tasa típica a la que el sistema de salud administra pruebas del producto sanguíneo o de los pacientes en cuestión.

De ello se deduce que podemos "recorrer" el modelo de Markov para identificar la probabilidad general de detección de una persona que comienza sin ser detectada, multiplicando las probabilidades de transición a cada siguiente estado del modelo como:

.

El número absoluto total subsiguiente de pruebas de falsos negativos (la principal preocupación de los CDC) sería entonces la tasa de pruebas, multiplicada por la probabilidad de alcanzar el estado infectado pero indetectable, multiplicada por la duración de la permanencia en el estado infectado pero indetectable:

.