El modelado de ecuaciones estructurales ( SEM ) es un conjunto diverso de métodos utilizados por científicos que realizan investigaciones tanto observacionales como experimentales. SEM se utiliza principalmente en las ciencias sociales y del comportamiento, pero también se utiliza en epidemiología, [2] negocios, [3] y otros campos. Es difícil definir SEM sin hacer referencia al lenguaje técnico, pero un buen punto de partida es el nombre mismo.

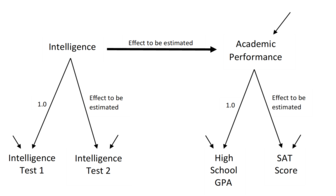

SEM implica un modelo que representa cómo se cree que varios aspectos de un fenómeno se conectan causalmente entre sí. Los modelos de ecuaciones estructurales a menudo contienen conexiones causales postuladas entre algunas variables latentes (variables que se cree que existen pero que no se pueden observar directamente). Conexiones causales adicionales vinculan esas variables latentes con variables observadas cuyos valores aparecen en un conjunto de datos. Las conexiones causales se representan mediante ecuaciones , pero la estructuración postulada también se puede presentar mediante diagramas que contienen flechas como en las Figuras 1 y 2. Las estructuras causales implican que deben aparecer patrones específicos entre los valores de las variables observadas. Esto hace posible utilizar las conexiones entre los valores de las variables observadas para estimar las magnitudes de los efectos postulados y probar si los datos observados son consistentes o no con los requisitos de las estructuras causales hipotéticas. [4]

El límite entre lo que es y lo que no es un modelo de ecuaciones estructurales no siempre es claro, pero los modelos SE a menudo contienen conexiones causales postuladas entre un conjunto de variables latentes (variables que se cree que existen pero que no se pueden observar directamente, como una actitud, inteligencia o enfermedad mental) y conexiones causales que vinculan las variables latentes postuladas con variables que pueden observarse y cuyos valores están disponibles en algún conjunto de datos. Las variaciones entre los estilos de conexiones causales latentes, las variaciones entre las variables observadas que miden las variables latentes y las variaciones en las estrategias de estimación estadística dan como resultado el conjunto de herramientas SEM que incluye análisis factorial confirmatorio , análisis compuesto confirmatorio , análisis de ruta , modelado multigrupo y modelado longitudinal. , modelado de trayectorias de mínimos cuadrados parciales , modelado de crecimiento latente y modelado jerárquico o multinivel. [5] [6] [7] [8] [9]

Los investigadores del SEM utilizan programas informáticos para estimar la fuerza y el signo de los coeficientes correspondientes a las conexiones estructurales modeladas, por ejemplo, los números conectados a las flechas en la Figura 1. Debido a que un modelo postulado como el de la Figura 1 puede no corresponder a las fuerzas mundanas que controlan la mediciones de datos observados, los programas también proporcionan pruebas de modelos y pistas de diagnóstico que sugieren qué indicadores, o qué componentes del modelo, podrían introducir inconsistencia entre el modelo y los datos observados. Las críticas a los métodos SEM insinúan: desprecio de las pruebas de modelos disponibles, problemas en la especificación del modelo, una tendencia a aceptar modelos sin considerar la validez externa y posibles sesgos filosóficos. [10]

Una gran ventaja de SEM es que todas estas mediciones y pruebas ocurren simultáneamente en un procedimiento de estimación estadística, donde todos los coeficientes del modelo se calculan utilizando toda la información de las variables observadas. Esto significa que las estimaciones son más precisas que si un investigador calculara cada parte del modelo por separado. [11]

El modelado de ecuaciones estructurales (SEM) comenzó a diferenciarse de la correlación y la regresión cuando Sewall Wright proporcionó interpretaciones causales explícitas para un conjunto de ecuaciones de estilo de regresión basadas en una sólida comprensión de los mecanismos físicos y fisiológicos que producen efectos directos e indirectos entre las variables observadas. [12] [13] [14] Las ecuaciones se estimaron como ecuaciones de regresión ordinarias, pero el contexto sustantivo de las variables medidas permitió una comprensión causal clara, no meramente predictiva. OD Duncan introdujo el SEM en las ciencias sociales en su libro de 1975 [15] y el SEM floreció a finales de los años 1970 y 1980, cuando el aumento de la potencia informática permitió la estimación práctica de modelos. En 1987, Hayduk [6] proporcionó la primera introducción en un libro al modelado de ecuaciones estructurales con variables latentes, y pronto fue seguida por el popular texto de Bollen (1989). [dieciséis]

Enfoques de modelado diferentes pero relacionados matemáticamente desarrollados en psicología, sociología y economía. Los primeros trabajos de la Comisión Cowles sobre estimación de ecuaciones simultáneas se centraron en los algoritmos de Koopman y Hood (1953) de la economía del transporte y el enrutamiento óptimo, con estimación de máxima verosimilitud y cálculos algebraicos de forma cerrada, ya que las técnicas iterativas de búsqueda de soluciones eran limitadas en la época anterior a las computadoras. La convergencia de dos de estas corrientes de desarrollo (el análisis factorial desde la psicología y el análisis de trayectorias desde la sociología a través de Duncan) produjo el núcleo actual del SEM. Uno de los varios programas que Karl Jöreskog desarrolló en Educational Testing Services, LISREL [17] [18] [19] incorporó variables latentes (que los psicólogos conocían como factores latentes del análisis factorial) dentro de ecuaciones de estilo análisis de trayectoria (que los sociólogos heredaron de Wright). y Duncan). La parte del modelo estructurada por factores incorporó errores de medición que permitieron un ajuste por error de medición, aunque no necesariamente una estimación libre de errores, de los efectos que conectan diferentes variables latentes postuladas.

Persisten rastros de la convergencia histórica de las tradiciones del análisis de factores y del análisis de trayectorias como la distinción entre las partes de medición y estructurales de los modelos; y como desacuerdos continuos sobre las pruebas de modelos y sobre si la medición debe preceder o acompañar a las estimaciones estructurales. [20] [21] Ver el análisis factorial como una técnica de reducción de datos resta importancia a las pruebas, lo que contrasta con la apreciación analítica de la ruta para probar conexiones causales postuladas, donde el resultado de la prueba podría indicar una especificación errónea del modelo. La fricción entre las tradiciones del análisis de factores y del análisis de trayectorias continúa apareciendo en la literatura.

El análisis de trayectoria de Wright influyó en Hermann Wold, el alumno de Wold, Karl Jöreskog, y el alumno de Jöreskog, Claes Fornell, pero SEM nunca ganó un gran número de seguidores entre los econometristas estadounidenses, posiblemente debido a diferencias fundamentales en los objetivos de modelado y las estructuras de datos típicas. La prolongada separación de la rama económica del SEM dio lugar a diferencias procesales y terminológicas, aunque persisten profundas conexiones matemáticas y estadísticas. [22] [23] La versión económica de SEM se puede ver en las discusiones de SEMNET sobre endogeneidad, y en el calor producido cuando el enfoque de Judea Pearl sobre la causalidad a través de gráficos acíclicos dirigidos (DAG) choca con los enfoques económicos de modelación. [4] Se encuentran disponibles debates que comparan y contrastan varios enfoques SEM [24] [25] pero las diferencias disciplinarias en las estructuras de datos y las preocupaciones que motivan los modelos económicos hacen que la reunión sea poco probable. Pearl [4] amplió el SEM de modelos lineales a modelos no paramétricos y propuso interpretaciones causales y contrafácticas de las ecuaciones. Los SEM no paramétricos permiten estimar los efectos totales, directos e indirectos sin comprometerse con la linealidad de los efectos ni hacer supuestos sobre las distribuciones de los términos de error. [25]

Los análisis SEM son populares en las ciencias sociales porque los programas informáticos permiten estimar estructuras causales complicadas, pero la complejidad de los modelos introduce una variabilidad sustancial en la calidad de los resultados. Algunos resultados, pero no todos, se obtienen sin el "inconveniente" de comprender el diseño experimental, el control estadístico, las consecuencias del tamaño de la muestra y otras características que contribuyen a un buen diseño de investigación. [ cita necesaria ]

Las siguientes consideraciones se aplican a la construcción y evaluación de muchos modelos de ecuaciones estructurales.

Construir o especificar un modelo requiere prestar atención a:

Los modelos de ecuaciones estructurales intentan reflejar las fuerzas mundanas que operan en casos causalmente homogéneos, es decir, casos enredados en las mismas estructuras causales mundanas pero cuyos valores sobre las causas difieren y que, por lo tanto, poseen diferentes valores sobre las variables de resultado. La homogeneidad causal puede facilitarse mediante la selección de casos o mediante la segregación de casos en un modelo multigrupo. La especificación de un modelo no está completa hasta que el investigador especifica:

El nivel latente de un modelo está compuesto por variables endógenas y exógenas . Las variables latentes endógenas son las variables de puntuación verdadera que se postula que reciben efectos de al menos otra variable modelada. Cada variable endógena se modela como la variable dependiente en una ecuación de estilo regresión. Las variables latentes exógenas son variables de fondo que se postula que causan una o más de las variables endógenas y se modelan como las variables predictoras en ecuaciones de estilo de regresión. Las conexiones causales entre las variables exógenas no se modelan explícitamente, pero generalmente se reconocen al modelar las variables exógenas como que se correlacionan libremente entre sí. El modelo puede incluir variables intermedias: variables que reciben efectos de algunas variables pero que también envían efectos a otras variables. Como en la regresión, a cada variable endógena se le asigna una variable residual o de error que encapsula los efectos de causas no disponibles y generalmente desconocidas. Se piensa que cada variable latente, ya sea exógena o endógena , contiene las puntuaciones verdaderas de los casos en esa variable, y estas puntuaciones verdaderas contribuyen causalmente a variaciones válidas/genuinas en una o más de las variables indicadoras observadas/reportadas. [26]

El programa LISREL asignó nombres griegos a los elementos de un conjunto de matrices para realizar un seguimiento de los distintos componentes del modelo. Estos nombres se convirtieron en notación relativamente estándar, aunque la notación se ha ampliado y modificado para adaptarse a una variedad de consideraciones estadísticas. [19] [6] [16] [27] Los textos y programas que "simplifican" la especificación del modelo mediante diagramas o mediante el uso de ecuaciones que permiten nombres de variables seleccionados por el usuario, reconvierten el modelo del usuario en alguna forma estándar de álgebra matricial en segundo plano. Las "simplificaciones" se logran introduciendo implícitamente "supuestos" predeterminados en el programa sobre las características del modelo con las que los usuarios supuestamente no necesitan preocuparse. Desafortunadamente, estos supuestos predeterminados oscurecen fácilmente los componentes del modelo, lo que deja problemas no reconocidos acechando dentro de la estructura del modelo y de las matrices subyacentes.

En SEM se distinguen dos componentes principales de los modelos: el modelo estructural que muestra posibles dependencias causales entre variables latentes endógenas y exógenas , y el modelo de medición que muestra las conexiones causales entre las variables latentes y los indicadores. Los modelos de análisis factorial exploratorio y confirmatorio , por ejemplo, se centran en las conexiones de medición causales, mientras que los modelos de trayectoria corresponden más estrechamente a las conexiones estructurales latentes de los SEM.

Los modeladores especifican que cada coeficiente en un modelo puede estimarse libremente o fijarse en algún valor. Los coeficientes libres pueden ser efectos postulados que el investigador desea probar, correlaciones de fondo entre las variables exógenas o las varianzas de las variables residuales o de error que proporcionan variaciones adicionales en las variables latentes endógenas. Los coeficientes fijos pueden ser valores como los valores de 1,0 en la Figura 2 que proporcionan una escala para las variables latentes, o valores de 0,0 que afirman desconexiones causales, como la afirmación de que no hay efectos directos (sin flechas) que apuntan desde el rendimiento académico a cualquier de las cuatro escalas en la Figura 1. Los programas SEM proporcionan estimaciones y pruebas de los coeficientes libres, mientras que los coeficientes fijos contribuyen de manera importante a probar la estructura general del modelo. También se pueden utilizar varios tipos de restricciones entre coeficientes. [27] [6] [16] La especificación del modelo depende de lo que se sabe de la literatura, la experiencia del investigador con las variables indicadoras modeladas y las características que se investigan mediante el uso de la estructura del modelo específico.

Existe un límite en cuanto a la cantidad de coeficientes que se pueden estimar en un modelo. Si hay menos puntos de datos que el número de coeficientes estimados, se dice que el modelo resultante está "no identificado" y no se pueden obtener estimaciones de coeficientes. El efecto recíproco y otros bucles causales también pueden interferir con la estimación. [28] [29] [27]

Los coeficientes del modelo fijados en cero, 1,0 u otros valores no requieren estimación porque ya tienen valores especificados. Los valores estimados para los coeficientes del modelo libre se obtienen maximizando el ajuste o minimizando la diferencia de los datos en relación con las características de los datos si los coeficientes del modelo libre tomaran los valores estimados. Las implicaciones del modelo sobre cómo deberían verse los datos para un conjunto específico de valores de coeficientes dependen de: a) la ubicación de los coeficientes en el modelo (por ejemplo, qué variables están conectadas/desconectadas), b) la naturaleza de las conexiones entre las variables ( covarianzas o efectos; a menudo se supone que los efectos son lineales), c) la naturaleza del error o las variables residuales (a menudo se supone que son independientes de muchas variables o están causalmente desconectadas de ellas), y d) las escalas de medición apropiadas para el variables (a menudo se supone una medición de nivel de intervalo).

Un efecto más fuerte que conecta dos variables latentes implica que los indicadores de esas latentes deberían estar más fuertemente correlacionados. Por lo tanto, una estimación razonable del efecto latente será cualquier valor que mejor coincida con las correlaciones entre los indicadores de las variables latentes correspondientes, es decir, el valor estimado que maximice la coincidencia con los datos o minimice las diferencias con los datos. Con la estimación de máxima verosimilitud, los valores numéricos de todos los coeficientes del modelo libre se ajustan individualmente (aumentan o disminuyen progresivamente desde los valores iniciales) hasta que maximizan la probabilidad de observar los datos de la muestra, ya sea que los datos sean las covarianzas/correlaciones de las variables, o los valores reales de los casos en las variables indicadoras. Las estimaciones de mínimos cuadrados ordinarios son los valores de los coeficientes que minimizan las diferencias al cuadrado entre los datos y cómo se verían los datos si el modelo se especificara correctamente, es decir, si todas las características estimadas del modelo corresponden a características del mundo real.

La característica estadística apropiada para maximizar o minimizar para obtener estimaciones depende de los niveles de medición de las variables (la estimación es generalmente más fácil con mediciones a nivel de intervalo que con medidas nominales u ordinales) y de dónde aparece una variable específica en el modelo (por ejemplo, variables dicotómicas endógenas). crean más dificultades de estimación que las variables dicotómicas exógenas). La mayoría de los programas SEM ofrecen varias opciones sobre lo que se debe maximizar o minimizar para obtener estimaciones de los coeficientes del modelo. Las opciones a menudo incluyen estimación de máxima verosimilitud (MLE), máxima verosimilitud con información completa (FIML), mínimos cuadrados ordinarios (OLS), mínimos cuadrados ponderados (WLS), mínimos cuadrados ponderados diagonalmente (DWLS) y mínimos cuadrados de dos etapas. [27]

Un problema común es que el valor estimado de un coeficiente puede estar subidentificado porque no está suficientemente restringido por el modelo y los datos. No existe una mejor estimación única a menos que el modelo y los datos juntos restrinjan o restrinjan suficientemente el valor de un coeficiente. Por ejemplo, la magnitud de una única correlación de datos entre dos variables es insuficiente para proporcionar estimaciones de un par recíproco de efectos modelados entre esas variables. La correlación podría explicarse porque uno de los efectos recíprocos es más fuerte que el otro efecto, o porque el otro efecto es más fuerte que aquel, o por efectos de igual magnitud. Las estimaciones de efectos no identificados pueden identificarse introduciendo restricciones adicionales de modelo y/o datos. Por ejemplo, los efectos recíprocos pueden identificarse restringiendo una estimación del efecto a ser doble, triple o equivalente a la otra estimación del efecto, [29] pero las estimaciones resultantes sólo serán confiables si la restricción adicional del modelo corresponde a la estructura del mundo. . Los datos sobre una tercera variable que causa directamente sólo una de un par de variables recíprocamente conectadas causalmente también pueden ayudar a la identificación. [28] Restringir una tercera variable para que no cause directamente una de las variables recíprocamente causales rompe la simetría que de otro modo afectaría las estimaciones del efecto recíproco porque esa tercera variable debe estar más fuertemente correlacionada con la variable que causa directamente que con la variable en el "otro". " Fin del recíproco al que afecta sólo indirectamente. [28] Obsérvese que esto supone nuevamente la idoneidad de la especificación causal del modelo, es decir, que realmente hay un efecto directo que va de la tercera variable a la variable en este extremo de los efectos recíprocos y ningún efecto directo sobre la variable en el "otro extremo". final" del par de variables recíprocamente conectadas. Las demandas teóricas de efectos nulos/cero proporcionan restricciones útiles que ayudan a la estimación, aunque las teorías a menudo no informan claramente qué efectos son supuestamente inexistentes.

La evaluación del modelo depende de la teoría, los datos, el modelo y la estrategia de estimación. Por lo tanto, las evaluaciones de modelos consideran:

La investigación que pretende probar o "investigar" una teoría requiere atender a la inconsistencia de los datos del modelo más allá del azar. La estimación ajusta los coeficientes libres del modelo para proporcionar el mejor ajuste posible a los datos. El resultado de los programas SEM incluye una matriz que informa las relaciones entre las variables observadas que se observarían si los efectos estimados del modelo realmente controlaran los valores de las variables observadas. El "ajuste" de un modelo informa coincidencia o discrepancia entre las relaciones implícitas en el modelo (a menudo covarianzas) y las correspondientes relaciones observadas entre las variables. Las diferencias grandes y significativas entre los datos y las implicaciones del modelo señalan problemas. La probabilidad que acompaña a una prueba de χ 2 ( chi-cuadrado ) es la probabilidad de que los datos puedan surgir mediante variaciones de muestreo aleatorias si el modelo estimado constituyera las fuerzas poblacionales subyacentes reales. Una pequeña probabilidad χ 2 indica que sería poco probable que los datos actuales hubieran surgido si la estructura modelada constituyera las fuerzas causales de la población real, atribuyéndose las diferencias restantes a variaciones de muestreo aleatorias.

Si un modelo sigue siendo inconsistente con los datos a pesar de seleccionar estimaciones de coeficientes óptimas, una respuesta de investigación honesta informa y atiende a esta evidencia (a menudo una prueba significativa de χ 2 del modelo ). [30] La inconsistencia de los datos del modelo más allá del azar desafía tanto las estimaciones de los coeficientes como la capacidad del modelo para adjudicar la estructura del modelo, independientemente de si la inconsistencia se origina en datos problemáticos, una estimación estadística inapropiada o una especificación incorrecta del modelo. Las estimaciones de coeficientes en modelos con datos inconsistentes ("fallidos") son interpretables, como informes de cómo le parecería el mundo a alguien que cree en un modelo que entra en conflicto con los datos disponibles. Las estimaciones en modelos con datos inconsistentes no necesariamente se vuelven "obviamente erróneas" al volverse estadísticamente extrañas o estar mal firmadas según la teoría. Las estimaciones pueden incluso coincidir estrechamente con los requisitos de una teoría, pero la inconsistencia restante de los datos hace que la coincidencia entre las estimaciones y la teoría no pueda proporcionar ayuda. Los modelos fallidos siguen siendo interpretables, pero sólo como interpretaciones que entran en conflicto con la evidencia disponible.

Es poco probable que la replicación detecte modelos mal especificados que no se ajusten apropiadamente a los datos. Si los datos replicados se encuentran dentro de variaciones aleatorias de los datos originales, las mismas ubicaciones incorrectas de los coeficientes que proporcionaron un ajuste inadecuado a los datos originales probablemente también ajustarán incorrectamente los datos replicados. La replicación ayuda a detectar problemas como errores en los datos (cometidos por diferentes grupos de investigación), pero es especialmente débil a la hora de detectar especificaciones erróneas después de la modificación exploratoria del modelo, como cuando se aplica el análisis factorial confirmatorio (AFC) a una segunda mitad aleatoria de los datos después del análisis factorial exploratorio. (EFA) de los datos del primer semestre.

Un índice de modificación es una estimación de cuánto "mejoraría" el ajuste de un modelo a los datos (pero no necesariamente cuánto mejoraría la estructura del modelo) si se liberara para la estimación un coeficiente específico del modelo actualmente fijo. Los investigadores que confrontan modelos con datos inconsistentes pueden liberar fácilmente los coeficientes que los índices de modificación reportan como propensos a producir mejoras sustanciales en el ajuste. Esto simultáneamente introduce un riesgo sustancial de pasar de un modelo causalmente incorrecto y fallido a un modelo causalmente incorrecto pero ajustado porque un mejor ajuste de datos no proporciona seguridad de que los coeficientes liberados sean sustancialmente razonables o coincidan con el mundo. El modelo original puede contener especificaciones causales erróneas, como efectos dirigidos incorrectamente o suposiciones incorrectas sobre variables no disponibles, y dichos problemas no pueden corregirse agregando coeficientes al modelo actual. En consecuencia, dichos modelos siguen estando mal especificados a pesar del ajuste más cercano proporcionado por coeficientes adicionales. Es especialmente probable que surjan modelos ajustados pero inconsistentes si un investigador comprometido con un modelo particular (por ejemplo, un modelo factorial que tiene un número deseado de factores) consigue que un modelo inicialmente fallido se ajuste insertando covarianzas de error de medición "sugeridas" mediante modificación. índices. MacCallum (1986) demostró que "incluso en condiciones favorables, los modelos que surgen de los buscadores de especificaciones deben considerarse con precaución". [31] La especificación errónea del modelo a veces puede corregirse mediante la inserción de coeficientes sugeridos por los índices de modificación, pero se plantean muchas más posibilidades correctivas empleando algunos indicadores de variables latentes similares pero significativamente diferentes. [32]

"Aceptar" modelos fallidos como "lo suficientemente parecidos" tampoco es una alternativa razonable. Browne, MacCallum, Kim, Anderson y Glaser brindaron un ejemplo de advertencia, quienes abordaron las matemáticas detrás de por qué la prueba de χ 2 puede tener (aunque no siempre tiene) un poder considerable para detectar especificaciones erróneas del modelo. [33] La probabilidad que acompaña a una prueba de χ 2 es la probabilidad de que los datos puedan surgir mediante variaciones de muestreo aleatorias si el modelo actual, con sus estimaciones óptimas, constituyera las verdaderas fuerzas poblacionales subyacentes. Una pequeña probabilidad χ 2 indica que sería poco probable que los datos actuales hubieran surgido si la estructura del modelo actual constituyera las fuerzas causales de la población real, y las diferencias restantes se atribuyerían a variaciones de muestreo aleatorias. Browne, McCallum, Kim, Andersen y Glaser presentaron un modelo factorial que consideraron aceptable a pesar de que el modelo era significativamente inconsistente con sus datos según χ 2 . La falacia de su afirmación de que el ajuste perfecto debería considerarse suficientemente bueno fue demostrada por Hayduk, Pazkerka-Robinson, Cummings, Levers y Beres [34] , quienes demostraron un modelo apropiado para los propios datos de Browne et al. incorporando un característica experimental Browne, et al. pasado por alto. El fallo no estaba en las matemáticas de los índices ni en la excesiva sensibilidad de las pruebas de χ2 . La culpa fue que Browne, MacCallum y los otros autores olvidaron, descuidaron o pasaron por alto que no se puede confiar en que la cantidad de mal ajuste corresponda a la naturaleza, ubicación o gravedad de los problemas en la especificación de un modelo. [35]

Muchos investigadores intentaron justificar el cambio a índices de ajuste, en lugar de probar sus modelos, afirmando que χ 2 aumenta (y por lo tanto la probabilidad de χ 2 disminuye) al aumentar el tamaño de la muestra (N). Hay dos errores al descontar χ 2 sobre esta base. Primero, para modelos adecuados, χ 2 no aumenta al aumentar N, [30] por lo que si χ 2 aumenta con N, eso en sí mismo es una señal de que algo es detectablemente problemático. Y en segundo lugar, para los modelos que están claramente mal especificados, el aumento de χ 2 con N proporciona la buena noticia de un mayor poder estadístico para detectar errores de especificación del modelo (es decir, poder para detectar errores de Tipo II). Algunos tipos de especificaciones erróneas importantes no pueden detectarse mediante χ 2 , [35] por lo que cualquier cantidad de mal ajuste más allá de lo que podría producirse razonablemente mediante variaciones aleatorias merece informe y consideración. [36] [30] La prueba del modelo χ 2 , posiblemente ajustada, [37] es la prueba de modelo de ecuación estructural más sólida disponible.

Numerosos índices de ajuste cuantifican qué tan cerca se ajusta un modelo a los datos, pero todos los índices de ajuste adolecen de la dificultad lógica de que el tamaño o la cantidad del mal ajuste no están coordinados de manera confiable con la gravedad o naturaleza de los problemas que producen la inconsistencia de los datos. [35] Los modelos con diferentes estructuras causales que se ajustan idénticamente bien a los datos se han denominado modelos equivalentes. [27] Dichos modelos son equivalentes en términos de ajuste de datos, aunque no causalmente equivalentes, por lo que al menos uno de los llamados modelos equivalentes debe ser inconsistente con la estructura del mundo. Si existe una correlación perfecta de 1,0 entre X e Y y la modelamos como X causa Y, habrá un ajuste perfecto y un error residual cero. Pero es posible que el modelo no coincida con el mundo porque Y puede en realidad causar X, o tanto X como Y pueden estar respondiendo a una causa común Z, o el mundo puede contener una mezcla de estos efectos (por ejemplo, una causa común más un efecto de Y). en X), u otras estructuras causales. El ajuste perfecto no nos dice que la estructura del modelo corresponde a la estructura del mundo, y esto a su vez implica que acercarse al ajuste perfecto no necesariamente corresponde a acercarse a la estructura del mundo; tal vez sí, tal vez no. Esto hace que sea incorrecto que un investigador afirme que incluso un ajuste perfecto del modelo implica que el modelo está correctamente especificado causalmente. Incluso para modelos moderadamente complejos, los modelos que se ajustan con precisión equivalente son raros. Los modelos que casi se ajustan a los datos, según cualquier índice, inevitablemente introducen especificaciones erróneas adicionales potencialmente importantes pero desconocidas. Estos modelos constituyen un impedimento mayor para la investigación.

Esta debilidad lógica hace que todos los índices de ajuste sean "inútiles" siempre que un modelo de ecuación estructural sea significativamente inconsistente con los datos, [36] pero varias fuerzas continúan propagando el uso del índice de ajuste. Por ejemplo, Dag Sorbom informó que cuando alguien le preguntó a Karl Joreskog, el desarrollador del primer programa de modelado de ecuaciones estructurales, "¿Por qué entonces agregó GFI?" a su programa LISREL, Joreskog respondió: "Bueno, los usuarios nos amenazan diciendo que dejarían de usar LISREL si siempre produce chi-cuadrados tan grandes. Así que tuvimos que inventar algo para hacer feliz a la gente. GFI sirve para ese propósito". [38] La evidencia χ 2 de la inconsistencia de los datos del modelo era demasiado sólida estadísticamente para ser desalojada o descartada, pero al menos se podía proporcionar a las personas una manera de distraerse de la evidencia "inquietante". Aún se pueden acumular beneficios profesionales desarrollando índices adicionales, informando investigaciones sobre el comportamiento de los índices y publicando modelos que entierran intencionalmente evidencia de inconsistencia de los datos del modelo bajo un MDI (un montón de índices que distraen). No parece haber ninguna justificación general de por qué un investigador debería "aceptar" un modelo causalmente incorrecto, en lugar de intentar corregir las especificaciones erróneas detectadas. Y algunas partes de la literatura parecen no haber notado que "aceptar un modelo" (sobre la base de "satisfacer" un valor de índice) sufre una versión intensificada de la crítica aplicada a la "aceptación" de una hipótesis nula. Los textos de introducción a la estadística suelen recomendar reemplazar el término "aceptar" por "no se pudo rechazar la hipótesis nula" para reconocer la posibilidad de error de tipo II. Un error de tipo III surge de "aceptar" la hipótesis de un modelo cuando los datos actuales son suficientes para rechazar el modelo.

Una preocupación fundamental es si los investigadores están comprometidos o no con la búsqueda de la estructura del mundo. Desplazar la evidencia de la inconsistencia de los datos del modelo ocultándola detrás de afirmaciones de ajuste aceptable del índice, introduce el costo en toda la disciplina de desviar la atención de cualquier cosa que la disciplina podría haber hecho para lograr una comprensión estructuralmente mejorada de la sustancia de la disciplina. La disciplina termina pagando costos reales por el desplazamiento basado en índices de la evidencia de especificación errónea del modelo. Las fricciones creadas por los desacuerdos sobre la necesidad de corregir las especificaciones erróneas de los modelos probablemente aumentarán con el uso cada vez mayor de modelos no estructurados por factores y con el uso de menos indicadores y más precisos de variables latentes similares pero significativamente diferentes. [32]

Las consideraciones relevantes para el uso de índices de ajuste incluyen verificar:

Algunas de las estadísticas de ajuste más utilizadas incluyen

La siguiente tabla proporciona referencias que documentan estas y otras características de algunos índices comunes: RMSEA (error cuadrático medio de aproximación), SRMR (residual cuadrático medio estandarizado), CFI (índice de ajuste confirmatorio) y TLI (índice de ajuste de Tucker). -Índice de Lewis). En la mayoría de las presentaciones de SEM se pueden encontrar índices adicionales como el AIC (Akaike Information Criterion). [27] Para cada medida de ajuste, una decisión sobre qué representa un ajuste suficientemente bueno entre el modelo y los datos refleja el objetivo de modelado del investigador (quizás desafiar el modelo de otra persona o mejorar la medición); si se debe afirmar o no que el modelo ha sido "probado"; y si el investigador se siente cómodo "ignorando" la evidencia del grado de mal ajuste documentado en el índice. [30]

Los investigadores coinciden en que las muestras deben ser lo suficientemente grandes como para proporcionar estimaciones de coeficientes estables y un poder de prueba razonable, pero no existe un consenso general sobre los tamaños de muestra específicos requeridos, ni siquiera sobre cómo determinar los tamaños de muestra apropiados. Las recomendaciones se han basado en la cantidad de coeficientes que se estimarán, la cantidad de variables modeladas y simulaciones de Monte Carlo que abordan coeficientes específicos del modelo. [27] Las recomendaciones sobre el tamaño de la muestra basadas en la relación entre el número de indicadores y los latentes están orientadas a factores y no se aplican a modelos que emplean indicadores únicos que tienen varianzas de error de medición fijas distintas de cero. [32] En general, para modelos de tamaño moderado sin coeficientes estadísticamente difíciles de estimar, los tamaños de muestra requeridos (N) parecen aproximadamente comparables a los N requeridos para una regresión que emplea todos los indicadores.

Cuanto mayor sea el tamaño de la muestra, mayor será la probabilidad de incluir casos que no sean causalmente homogéneos. En consecuencia, aumentar N para mejorar la probabilidad de poder informar un coeficiente deseado como estadísticamente significativo, aumenta simultáneamente el riesgo de especificación errónea del modelo y el poder para detectar la especificación errónea. Los investigadores que deseen aprender de su modelización (incluido el posible aprendizaje de que su modelo requiere ajuste o reemplazo) se esforzarán por lograr un tamaño de muestra tan grande como lo permita la financiación y su evaluación de la posible heterogeneidad/homogeneidad causal basada en la población. Si el N disponible es enorme, modelar subconjuntos de casos puede controlar variables que de otro modo podrían alterar la homogeneidad causal. Los investigadores que temen tener que informar sobre las deficiencias de su modelo se debaten entre querer un N mayor para proporcionar potencia suficiente para detectar coeficientes estructurales de interés, y al mismo tiempo evitar la potencia capaz de señalar la inconsistencia de los datos del modelo. La enorme variación en las estructuras de los modelos y las características de los datos sugiere que sería útil localizar tamaños de muestra adecuados considerando las experiencias de otros investigadores (tanto buenas como malas) con modelos de tamaño y complejidad comparables que han sido estimados con datos similares.

Las interpretaciones causales de los modelos SE son las más claras y comprensibles, pero esas interpretaciones serán falaces o incorrectas si la estructura del modelo no corresponde a la estructura causal del mundo. En consecuencia, la interpretación debe abordar el estado y la estructura generales del modelo, no simplemente los coeficientes estimados del modelo. Si un modelo se ajusta a los datos y/o cómo llegó a ajustarse a los datos, son aspectos fundamentales para la interpretación. El ajuste de los datos obtenido mediante la exploración o siguiendo índices de modificación sucesivos no garantiza que el modelo sea incorrecto, pero plantea serias dudas porque estos enfoques son propensos a modelar incorrectamente las características de los datos. Por ejemplo, explorar para ver cuántos factores se requieren evita encontrar que los datos no están estructurados por factores, especialmente si se ha "persuadido" al modelo de factores para que se ajuste mediante la inclusión de covarianzas de error de medición. La capacidad de los datos para hablar en contra de un modelo postulado se erosiona progresivamente con cada inclusión injustificada de un efecto de “índice de modificación sugerido” o covarianza de error. Resulta extremadamente difícil recuperar un modelo adecuado si el modelo inicial/base contiene varias especificaciones erróneas. [46]

Las estimaciones de efectos directos se interpretan en paralelo a la interpretación de los coeficientes en las ecuaciones de regresión, pero con un compromiso causal. Se considera que cada aumento unitario en el valor de una variable causal produce un cambio de la magnitud estimada en el valor de la variable dependiente dado el control o ajuste de todos los demás mecanismos causales operativos/modelados. Los efectos indirectos se interpretan de manera similar, siendo la magnitud de un efecto indirecto específico igual al producto de la serie de efectos directos que comprende ese efecto indirecto. Las unidades involucradas son las escalas reales de los valores de las variables observadas y los valores de escala asignados para las variables latentes. Un efecto 1.0 especificado/fijo de un indicador latente en un indicador específico coordina la escala de ese indicador con la escala de la variable latente. La presunción de que el resto del modelo permanece constante o sin cambios puede requerir descontar efectos indirectos que, en el mundo real, podrían ser provocados simultáneamente por un aumento de unidades reales. Y el aumento unitario en sí mismo podría ser inconsistente con lo que es posible en el mundo real porque puede que no se conozca una manera de cambiar el valor de la variable causal. Si un modelo se ajusta por errores de medición, el ajuste permite interpretar los efectos de nivel latente como si se refirieran a variaciones en las puntuaciones reales. [26]

Las interpretaciones SEM se alejan más radicalmente de las interpretaciones de regresión cuando una red de coeficientes causales conecta las variables latentes porque las regresiones no contienen estimaciones de efectos indirectos. Las interpretaciones SEM deben transmitir las consecuencias de los patrones de efectos indirectos que transmiten efectos desde las variables de fondo, a través de las variables intermedias, hasta las variables dependientes posteriores. Las interpretaciones SEM fomentan la comprensión de cómo múltiples vías causales mundanas pueden funcionar en coordinación, de forma independiente o incluso contrarrestarse entre sí. Los efectos directos pueden ser contrarrestados (o reforzados) por efectos indirectos, o sus implicaciones correlacionales pueden contrarrestarse (o reforzarse) por los efectos de causas comunes. [15] El significado y la interpretación de estimaciones específicas deben contextualizarse en el modelo completo.

La interpretación del modelo SE debe conectar segmentos causales específicos del modelo con sus implicaciones de varianza y covarianza. Un solo efecto directo informa que la varianza en la variable independiente produce una cantidad específica de variación en los valores de la variable dependiente, pero los detalles causales de exactamente qué hace que esto suceda permanece sin especificar porque un coeficiente de efecto único no contiene subcomponentes disponibles para la integración. en una historia estructurada de cómo surge ese efecto. Se necesitaría un modelo SE más detallado que incorporara variables que intervienen entre la causa y el efecto para proporcionar características que constituyan una historia sobre cómo funciona cualquier efecto. Hasta que llegue ese modelo, cada efecto directo estimado conserva un matiz de desconocido, invocando así la esencia de una teoría. Una incógnita esencial paralela acompañaría a cada coeficiente estimado incluso en el modelo más detallado, por lo que la sensación de misterio fundamental nunca se erradica por completo de los modelos SE.

Incluso si cada efecto modelado se desconoce más allá de la identidad de las variables involucradas y la magnitud estimada del efecto, las estructuras que vinculan múltiples efectos modelados brindan oportunidades para expresar cómo funcionan las cosas para coordinar las variables observadas, brindando así posibilidades de interpretación útiles. Por ejemplo, una causa común contribuye a la covarianza o correlación entre dos variables afectadas, porque si el valor de la causa aumenta, los valores de ambos efectos también deberían aumentar (asumiendo efectos positivos) incluso si no conocemos la historia completa. subyacente a cada causa. [15] (Una correlación es la covarianza entre dos variables que han sido estandarizadas para tener una varianza de 1,0). Se podría hacer otra contribución interpretativa expresando cómo dos variables causales pueden explicar la varianza en una variable dependiente, así como cómo la covarianza entre dos de esas causas puede aumentar o disminuir la varianza explicada en la variable dependiente. Es decir, la interpretación puede implicar explicar cómo un patrón de efectos y covarianzas puede contribuir a disminuir la varianza de una variable dependiente. [47] Comprender las implicaciones causales se conecta implícitamente con la comprensión del “control” y, potencialmente, con la explicación de por qué algunas variables, pero no otras, deben controlarse. [4] [48] A medida que los modelos se vuelven más complejos, estos componentes fundamentales se pueden combinar de maneras no intuitivas, como explicar cómo no puede haber correlación (covarianza cero) entre dos variables a pesar de que las variables estén conectadas por una relación causal directa distinta de cero. efecto. [15] [16] [6] [29]

La insignificancia estadística de una estimación del efecto indica que la estimación podría fácilmente surgir como una variación de muestreo aleatoria en torno a un efecto nulo/cero, por lo que interpretar la estimación como un efecto real resulta equívoco. Al igual que en la regresión, R 2 proporciona la proporción de la varianza de cada variable dependiente explicada por variaciones en las causas modeladas , aunque el error bloqueado R 2 debe usarse si la variable dependiente está involucrada en efectos recíprocos o de bucle, o si tiene una variable de error correlacionada con la variable de error de cualquier predictor. [49]

La precaución que aparece en la sección Evaluación del modelo merece repetirse. Debería ser posible interpretar si un modelo es o no consistente con los datos. Las estimaciones informan cómo le parecería el mundo a alguien que creyera en el modelo, incluso si esa creencia es infundada porque resulta que el modelo es incorrecto. La interpretación debe reconocer que los coeficientes del modelo pueden corresponder o no a “parámetros”, porque los coeficientes del modelo pueden no tener características estructurales mundanas correspondientes.

Agregar nuevas variables latentes que entran o salen del modelo original en algunas ubicaciones/variables causales claras contribuye a detectar especificaciones erróneas del modelo que, de otro modo, podrían arruinar las interpretaciones de los coeficientes. Las correlaciones entre los nuevos indicadores latentes y todos los indicadores originales contribuyen a probar la estructura del modelo original porque los pocos coeficientes de efectos nuevos y enfocados deben trabajar en coordinación con los efectos directos e indirectos originales del modelo para coordinar los nuevos indicadores con los indicadores originales. Si la estructura del modelo original era problemática, las escasas nuevas conexiones causales serán insuficientes para coordinar los nuevos indicadores con los indicadores originales, señalando así la inadecuación de los coeficientes del modelo original a través de la inconsistencia de los datos del modelo. [29] Las restricciones correlacionales basadas en coeficientes de efecto nulo/cero y los coeficientes a los que se les asignan valores fijos distintos de cero contribuyen tanto a la prueba del modelo como a la estimación de coeficientes y, por lo tanto, merecen reconocimiento como el andamiaje que respalda las estimaciones y su interpretación. [29]

Las interpretaciones se vuelven progresivamente más complejas para los modelos que contienen interacciones, no linealidades, múltiples grupos, múltiples niveles y variables categóricas. [27] Los efectos que tocan bucles causales, efectos recíprocos o residuos correlacionados también requieren interpretaciones ligeramente revisadas. [6] [29]

La interpretación cuidadosa de los modelos fallidos y de ajuste puede proporcionar avances en la investigación. Para ser confiable, el modelo debe investigar estructuras causales académicamente informativas, ajustar los datos aplicables con estimaciones comprensibles y no incluir coeficientes vacíos. [50] Los modelos de ajuste confiables son más raros que los modelos que fallan o los modelos forzados de manera inapropiada para que se ajusten, pero los modelos que se ajustan apropiadamente son posibles. [34] [51] [52] [53]

Las múltiples formas de conceptualizar los modelos PLS [54] complican la interpretación de los modelos PLS. Muchos de los comentarios anteriores son aplicables si un modelador de PLS adopta una perspectiva realista esforzándose por garantizar que sus indicadores modelados se combinen de una manera que coincida con alguna variable latente existente pero no disponible. Los modelos PLS no causales, como los que se centran principalmente en R 2 o en el poder predictivo fuera de la muestra, cambian los criterios de interpretación al disminuir la preocupación por si los coeficientes del modelo tienen o no contrapartes mundanas. Las características fundamentales que diferencian las cinco perspectivas de modelado PLS discutidas por Rigdon, Sarstedt y Ringle [54] apuntan a diferencias en los objetivos de los modeladores PLS y las correspondientes diferencias en las características del modelo que justifican su interpretación.

Se debe tener precaución al hacer afirmaciones de causalidad, incluso cuando se hayan realizado experimentos o investigaciones ordenadas en el tiempo. Debe entenderse que el término modelo causal significa "un modelo que transmite supuestos causales", no necesariamente un modelo que produce conclusiones causales validadas; tal vez sí, tal vez no. La recopilación de datos en múltiples momentos y el uso de un diseño experimental o cuasiexperimental puede ayudar a descartar ciertas hipótesis rivales, pero ni siquiera un experimento aleatorio puede descartar por completo las amenazas a las afirmaciones causales. Ningún diseño de investigación puede garantizar plenamente las estructuras causales. [4]

El modelado de ecuaciones estructurales está plagado de controversias. Los investigadores de la tradición analítica factorial comúnmente intentan reducir conjuntos de indicadores múltiples a menos escalas o puntuaciones de factores más manejables para su uso posterior en modelos estructurados por trayectorias. Esto constituye un proceso gradual en el que el paso de medición inicial proporciona escalas o puntuaciones de factores que se utilizarán más adelante en un modelo estructurado por trayectoria. Este enfoque gradual parece obvio, pero en realidad enfrenta graves deficiencias subyacentes. La segmentación en pasos interfiere con la verificación exhaustiva de si las escalas o puntuaciones de factores representan válidamente los indicadores y/o informan válidamente sobre los efectos de nivel latente. Un modelo de ecuaciones estructurales que incorpora simultáneamente las estructuras de nivel latente y de medición no sólo verifica si los factores latentes coordinan apropiadamente los indicadores, sino que también verifica si ese mismo latente coordina simultáneamente de manera apropiada los indicadores de cada latente con los indicadores de las causas y/o consecuencias teorizadas de que latente. [29] Si un latente no puede realizar ambos estilos de coordinación, se cuestiona la validez de ese latente y se cuestiona una escala o puntuaciones de factores que pretenden medir ese latente. Los desacuerdos giraron en torno al respeto o la falta de respeto hacia la evidencia que cuestionaba la validez de los factores latentes postulados. Las discusiones a fuego lento, a veces hirviendo, dieron como resultado un número especial de la revista Structural Equation Modeling centrado en un artículo objetivo de Hayduk y Glaser [20] seguido de varios comentarios y una réplica, [21] todos disponibles gratuitamente, gracias a los esfuerzos. de Jorge Marcoulides.

Estas discusiones alimentaron el desacuerdo sobre si se debía o no probar la coherencia de los modelos de ecuaciones estructurales con los datos, y las pruebas de modelos se convirtieron en el siguiente foco de discusión. Los académicos que tenían antecedentes en el modelado de trayectorias tendían a defender pruebas cuidadosas de los modelos, mientras que aquellos con antecedentes en factores tendían a defender la indexación de ajuste en lugar de las pruebas de ajuste. Estas discusiones llevaron a un artículo en Personality and Individual Differences de Paul Barrett [36] que decía: “De hecho, ahora recomendaría prohibir que TODOS esos índices aparezcan en cualquier artículo como indicativos de la “aceptabilidad” o el “grado de aceptación” del modelo. inadaptado"." [36] (página 821). El artículo de Barrett también estuvo acompañado de comentarios desde ambas perspectivas. [50] [55]

La controversia sobre las pruebas de modelos disminuyó a medida que se hizo obligatorio informar claramente sobre inconsistencias significativas en los datos del modelo. Los científicos no pueden ignorar o dejar de informar la evidencia simplemente porque no les gusta lo que informa. [30] El requisito de prestar atención a la evidencia que apunta a una especificación errónea del modelo sustenta la preocupación más reciente por abordar la “endogeneidad”, un estilo de especificación errónea del modelo que interfiere con la estimación debido a la falta de independencia de las variables de error/residuales. En general, también ha ido disminuyendo la controversia sobre la naturaleza causal de los modelos de ecuaciones estructurales, incluidos los modelos factoriales. Stan Mulaik, un incondicional del análisis factorial, ha reconocido la base causal de los modelos factoriales. [56] Los comentarios de Bollen y Pearl sobre los mitos sobre la causalidad en el contexto de SEM [25] reforzaron la centralidad del pensamiento causal en el contexto de SEM.

Una controversia más breve se centró en los modelos competidores. Comparar modelos competitivos puede resultar muy útil, pero hay cuestiones fundamentales que no se pueden resolver creando dos modelos y conservando el modelo que mejor se ajuste. La sofisticación estadística de presentaciones como las de Levy y Hancock (2007), [57] por ejemplo, hace que sea fácil pasar por alto que un investigador puede comenzar con un modelo terrible y un modelo atroz, y terminar reteniendo el modelo estructuralmente terrible porque algunos informes del índice considera que encaja mejor que el modelo atroz. Es desafortunado que incluso textos SEM sólidos como Kline (2016) [27] sigan siendo inquietantemente débiles en su presentación de las pruebas de modelos. [58] En general, las contribuciones que pueden hacerse mediante el modelado de ecuaciones estructurales dependen de una evaluación cuidadosa y detallada del modelo, incluso si un modelo fallido resulta ser el mejor disponible.

Una controversia adicional que rozó los márgenes de las controversias anteriores está a punto de estallar. [ cita necesaria ] Los modelos factoriales y las estructuras factoriales integradas en la teoría que tienen múltiples indicadores tienden a fallar, y eliminar indicadores débiles tiende a reducir la inconsistencia de los datos del modelo. La reducción del número de indicadores genera preocupación y controversia sobre el número mínimo de indicadores necesarios para respaldar una variable latente en un modelo de ecuación estructural. Se puede persuadir a los investigadores vinculados a la tradición factorial para que reduzcan el número de indicadores a tres por variable latente, pero tres o incluso dos indicadores aún pueden ser inconsistentes con una causa común de factor subyacente propuesta. Hayduk y Littvay (2012) [32] analizaron cómo pensar, defender y ajustar el error de medición cuando se utiliza un solo indicador para cada variable latente modelada. Los indicadores únicos se han utilizado eficazmente en los modelos SE durante mucho tiempo, [51] pero la controversia sigue estando tan lejos como un revisor que ha considerado la medición únicamente desde la perspectiva analítica factorial.

Aunque van en declive, los rastros de estas controversias se encuentran dispersos por toda la literatura SEM, y es fácil incitar al desacuerdo preguntando: ¿Qué se debe hacer con los modelos que son significativamente inconsistentes con los datos? O preguntando: ¿La simplicidad del modelo anula el respeto por la evidencia de inconsistencia de los datos? O, ¿qué peso debería darse a los índices que muestran un ajuste de datos cercano o no tan cercano para algunos modelos? ¿O deberíamos ser especialmente indulgentes y “recompensar” los modelos parsimoniosos que son inconsistentes con los datos? O, dado que la RMSEA permite ignorar algunos grados de libertad realmente inadecuados para cada modelo, ¿no significa eso que las personas que prueban modelos con hipótesis nulas de RMSEA distinto de cero están realizando pruebas de modelos deficientes? Se requiere una variación considerable en la sofisticación estadística para abordar de manera convincente tales preguntas, aunque las respuestas probablemente se centrarán en la cuestión no técnica de si los investigadores están obligados o no a informar y respetar la evidencia.

Los programas de modelado de ecuaciones estructurales difieren ampliamente en sus capacidades y requisitos de usuario. [64]

{{cite book}}: CS1 maint: location missing publisher (link)