En estadística , la pérdida de Huber es una función de pérdida que se utiliza en la regresión robusta y que es menos sensible a los valores atípicos en los datos que la pérdida por error al cuadrado . A veces también se utiliza una variante para la clasificación.

La función de pérdida de Huber describe la penalización incurrida por un procedimiento de estimación f . Huber (1964) define la función de pérdida por partes mediante [1]

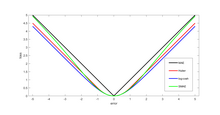

Esta función es cuadrática para valores pequeños de a , y lineal para valores grandes, con valores y pendientes iguales de las diferentes secciones en los dos puntos donde . La variable a a menudo se refiere a los residuos, es decir, a la diferencia entre los valores observados y predichos , por lo que la primera se puede expandir a [2]

La pérdida de Huber es la convolución de la función de valor absoluto con la función rectangular , escalada y trasladada. Por lo tanto, "suaviza" el vértice de la primera en el origen.

Dos funciones de pérdida muy utilizadas son la pérdida al cuadrado , , y la pérdida absoluta , . La función de pérdida al cuadrado da como resultado un estimador insesgado de media aritmética , y la función de pérdida de valor absoluto da como resultado un estimador insesgado de mediana (en el caso unidimensional, y un estimador insesgado de mediana geométrica para el caso multidimensional). La pérdida al cuadrado tiene la desventaja de que tiende a estar dominada por valores atípicos: cuando se suma sobre un conjunto de s (como en ), la media de la muestra está demasiado influenciada por unos pocos valores particularmente grandes cuando la distribución es de cola pesada: en términos de la teoría de la estimación , la eficiencia relativa asintótica de la media es pobre para distribuciones de cola pesada.

Como se definió anteriormente, la función de pérdida de Huber es fuertemente convexa en un entorno uniforme de su mínimo ; en el límite de este entorno uniforme, la función de pérdida de Huber tiene una extensión diferenciable a una función afín en los puntos y . Estas propiedades le permiten combinar gran parte de la sensibilidad del estimador de varianza mínima y sin sesgo de media (usando la función de pérdida cuadrática) y la robustez del estimador sin sesgo de mediana (usando la función de valor absoluto).

La función de pérdida pseudo-Huber se puede utilizar como una aproximación suave de la función de pérdida de Huber. Combina las mejores propiedades de la pérdida al cuadrado L2 y la pérdida absoluta L1 al ser fuertemente convexa cuando está cerca del objetivo/mínimo y menos pronunciada para valores extremos. La escala en la que la función de pérdida pseudo-Huber pasa de pérdida L2 para valores cercanos al mínimo a pérdida L1 para valores extremos y la pendiente en valores extremos se puede controlar mediante el valor. La función de pérdida pseudo-Huber garantiza que las derivadas sean continuas para todos los grados. Se define como [3] [4]

Como tal, esta función se aproxima a valores pequeños de , y se aproxima a una línea recta con pendiente para valores grandes de .

Si bien la anterior es la forma más común, también existen otras aproximaciones suaves de la función de pérdida de Huber. [5]

Para fines de clasificación , a veces se utiliza una variante de la pérdida de Huber denominada Huber modificado . Dada una predicción (una puntuación de clasificador de valor real) y una etiqueta de clase binaria verdadera , la pérdida de Huber modificada se define como [6]

El término es pérdida de bisagra utilizada por las máquinas de vectores de soporte ; la pérdida de bisagra suavizada cuadráticamente es una generalización de . [6]

La función de pérdida de Huber se utiliza en estadísticas robustas , estimación M y modelado aditivo . [7]