En matemáticas , un sistema de ecuaciones lineales (o sistema lineal ) es una colección de dos o más ecuaciones lineales que involucran las mismas variables . [1] [2] Por ejemplo,

es un sistema de tres ecuaciones en las tres variables x , y , z . Una solución de un sistema lineal es una asignación de valores a las variables de modo que todas las ecuaciones se satisfagan simultáneamente. En el ejemplo anterior, la solución la da la terna ordenada , ya que hace que las tres ecuaciones sean válidas.

Los sistemas lineales son una parte fundamental del álgebra lineal , una disciplina utilizada en la mayoría de las matemáticas modernas. Los algoritmos computacionales para hallar las soluciones son una parte importante del álgebra lineal numérica y desempeñan un papel destacado en la ingeniería , la física , la química , la informática y la economía . Un sistema de ecuaciones no lineales puede aproximarse a menudo mediante un sistema lineal (véase linealización ), una técnica útil para hacer un modelo matemático o una simulación por ordenador de un sistema relativamente complejo .

Muy a menudo, y en este artículo, los coeficientes y soluciones de las ecuaciones están restringidos a ser números reales o complejos , pero la teoría y los algoritmos se aplican a coeficientes y soluciones en cualquier campo . Para otras estructuras algebraicas , se han desarrollado otras teorías. Para coeficientes y soluciones en un dominio integral , como el anillo de números enteros , véase Ecuación lineal sobre un anillo . Para coeficientes y soluciones que son polinomios, véase Base de Gröbner . Para encontrar las "mejores" soluciones enteras entre muchas, véase Programación lineal entera . Para un ejemplo de una estructura más exótica a la que se puede aplicar el álgebra lineal, véase Geometría tropical .

El sistema de una ecuación con una incógnita

tiene la solucion

Sin embargo, la mayoría de los sistemas lineales interesantes tienen al menos dos ecuaciones.

El tipo más simple de sistema lineal no trivial implica dos ecuaciones y dos variables:

Un método para resolver un sistema de este tipo es el siguiente: primero, se resuelve la ecuación superior para en términos de :

Ahora sustituya esta expresión por x en la ecuación inferior:

Esto da como resultado una única ecuación que involucra únicamente la variable . Al resolverla se obtiene , y al sustituirla nuevamente en la ecuación se obtiene . Este método se generaliza a sistemas con variables adicionales (consulte "eliminación de variables" a continuación o el artículo sobre álgebra elemental ).

Un sistema general de m ecuaciones lineales con n incógnitas y coeficientes se puede escribir como

donde son las incógnitas, son los coeficientes del sistema y son los términos constantes. [3]

A menudo, los coeficientes y las incógnitas son números reales o complejos , pero también se ven números enteros y racionales , así como polinomios y elementos de una estructura algebraica abstracta .

Un punto de vista extremadamente útil es que cada incógnita es un peso para un vector de columna en una combinación lineal .

Esto permite que todo el lenguaje y la teoría de los espacios vectoriales (o, de manera más general, de los módulos ) se apliquen. Por ejemplo, la colección de todas las combinaciones lineales posibles de los vectores del lado izquierdo se llama su amplitud , y las ecuaciones tienen una solución solo cuando el vector del lado derecho está dentro de esa amplitud. Si cada vector dentro de esa amplitud tiene exactamente una expresión como combinación lineal de los vectores dados del lado izquierdo, entonces cualquier solución es única. En cualquier caso, la amplitud tiene una base de vectores linealmente independientes que sí garantizan exactamente una expresión; y el número de vectores en esa base (su dimensión ) no puede ser mayor que m o n , pero puede ser menor. Esto es importante porque si tenemos m vectores independientes, se garantiza una solución independientemente del lado derecho, y de lo contrario no se garantiza.

La ecuación vectorial es equivalente a una ecuación matricial de la forma donde A es una matriz m × n , x es un vector columna con n entradas y b es un vector columna con m entradas. [4]

El número de vectores en una base para el intervalo ahora se expresa como el rango de la matriz.

La solución de un sistema lineal es la asignación de valores a las variables de manera que se satisfagan todas las ecuaciones. El conjunto de todas las posibles soluciones se denomina conjunto solución . [5]

Un sistema lineal puede comportarse de cualquiera de tres maneras posibles:

En un sistema que involucra dos variables ( x e y ), cada ecuación lineal determina una línea en el plano xy . Debido a que una solución para un sistema lineal debe satisfacer todas las ecuaciones, el conjunto solución es la intersección de estas líneas y, por lo tanto, es una línea, un solo punto o el conjunto vacío .

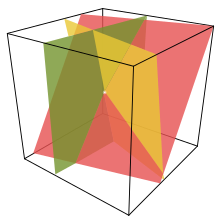

Para tres variables, cada ecuación lineal determina un plano en el espacio tridimensional , y el conjunto solución es la intersección de estos planos. Así, el conjunto solución puede ser un plano, una línea, un único punto o el conjunto vacío. Por ejemplo, como tres planos paralelos no tienen un punto común, el conjunto solución de sus ecuaciones es vacío; el conjunto solución de las ecuaciones de tres planos que se cortan en un punto es un único punto; si tres planos pasan por dos puntos, sus ecuaciones tienen al menos dos soluciones comunes; de hecho, el conjunto solución es infinito y consiste en todas las líneas que pasan por estos puntos. [6]

Para n variables, cada ecuación lineal determina un hiperplano en un espacio de n dimensiones . El conjunto solución es la intersección de estos hiperplanos, y es un plano , que puede tener cualquier dimensión menor que n .

En general, el comportamiento de un sistema lineal está determinado por la relación entre el número de ecuaciones y el número de incógnitas. Aquí, "en general" significa que puede ocurrir un comportamiento diferente para valores específicos de los coeficientes de las ecuaciones.

En el primer caso, la dimensión del conjunto solución es, en general, igual a n − m , donde n es el número de variables y m es el número de ecuaciones.

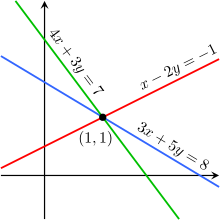

Las siguientes imágenes ilustran esta tricotomía en el caso de dos variables:

El primer sistema tiene infinitas soluciones, es decir, todos los puntos de la línea azul. El segundo sistema tiene una única solución, es decir, la intersección de las dos líneas. El tercer sistema no tiene soluciones, ya que las tres líneas no comparten ningún punto en común.

Hay que tener en cuenta que las imágenes anteriores muestran únicamente el caso más común (el caso general). Es posible que un sistema de dos ecuaciones y dos incógnitas no tenga solución (si las dos rectas son paralelas), o que un sistema de tres ecuaciones y dos incógnitas sea solucionable (si las tres rectas se cortan en un único punto).

Un sistema de ecuaciones lineales se comporta de manera diferente al caso general si las ecuaciones son linealmente dependientes , o si es inconsistente y no tiene más ecuaciones que incógnitas.

Las ecuaciones de un sistema lineal son independientes si ninguna de ellas puede derivarse algebraicamente de las demás. Cuando las ecuaciones son independientes, cada una de ellas contiene información nueva sobre las variables y la eliminación de cualquiera de ellas aumenta el tamaño del conjunto de soluciones. En el caso de las ecuaciones lineales, la independencia lógica es lo mismo que la independencia lineal .

Por ejemplo, las ecuaciones

no son independientes: son la misma ecuación cuando se escalan por un factor de dos y producirían gráficos idénticos. Este es un ejemplo de equivalencia en un sistema de ecuaciones lineales.

Para un ejemplo más complicado, las ecuaciones

no son independientes, porque la tercera ecuación es la suma de las otras dos. De hecho, cualquiera de estas ecuaciones puede derivarse de las otras dos, y cualquiera de las ecuaciones puede eliminarse sin afectar el conjunto solución. Los gráficos de estas ecuaciones son tres líneas que se intersecan en un único punto.

Un sistema lineal es inconsistente si no tiene solución, y en caso contrario, se dice que es consistente . [7] Cuando el sistema es inconsistente, es posible derivar una contradicción de las ecuaciones, que siempre puede reescribirse como la afirmación 0 = 1 .

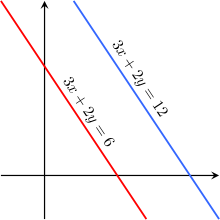

Por ejemplo, las ecuaciones

son inconsistentes. De hecho, al restar la primera ecuación de la segunda y multiplicar ambos lados del resultado por 1/6, obtenemos 0 = 1. Las gráficas de estas ecuaciones en el plano xy son un par de líneas paralelas .

Es posible que tres ecuaciones lineales sean inconsistentes, aunque dos de ellas sean consistentes entre sí. Por ejemplo, las ecuaciones

son inconsistentes. Al sumar las dos primeras ecuaciones se obtiene 3 x + 2 y = 2 , que se puede restar de la tercera ecuación para obtener 0 = 1 . Dos de estas ecuaciones tienen una solución común. El mismo fenómeno puede ocurrir para cualquier número de ecuaciones.

En general, se producen inconsistencias si los lados izquierdos de las ecuaciones de un sistema son linealmente dependientes y los términos constantes no satisfacen la relación de dependencia. Un sistema de ecuaciones cuyos lados izquierdos son linealmente independientes siempre es consistente.

Dicho de otro modo, según el teorema de Rouché-Capelli , cualquier sistema de ecuaciones (sobredeterminado o no) es inconsistente si el rango de la matriz aumentada es mayor que el rango de la matriz de coeficientes . Si, por el contrario, los rangos de estas dos matrices son iguales, el sistema debe tener al menos una solución. La solución es única si y solo si el rango es igual al número de variables. De lo contrario, la solución general tiene k parámetros libres donde k es la diferencia entre el número de variables y el rango; por lo tanto, en tal caso hay una infinitud de soluciones. El rango de un sistema de ecuaciones (es decir, el rango de la matriz aumentada) nunca puede ser mayor que [el número de variables] + 1, lo que significa que un sistema con cualquier número de ecuaciones siempre puede reducirse a un sistema que tenga un número de ecuaciones independientes que sea como máximo igual a [el número de variables] + 1.

Dos sistemas lineales que utilizan el mismo conjunto de variables son equivalentes si cada una de las ecuaciones del segundo sistema puede derivarse algebraicamente de las ecuaciones del primer sistema, y viceversa. Dos sistemas son equivalentes si ambos son inconsistentes o cada ecuación de cada uno de ellos es una combinación lineal de las ecuaciones del otro. De ello se deduce que dos sistemas lineales son equivalentes si y solo si tienen el mismo conjunto de soluciones.

Existen varios algoritmos para resolver un sistema de ecuaciones lineales.

Cuando el conjunto de soluciones es finito, se reduce a un único elemento. En este caso, la solución única se describe mediante una secuencia de ecuaciones cuyos lados izquierdos son los nombres de las incógnitas y los lados derechos son los valores correspondientes, por ejemplo . Cuando se ha fijado un orden de incógnitas, por ejemplo el orden alfabético, la solución puede describirse como un vector de valores, como en el ejemplo anterior.

Para describir un conjunto con un número infinito de soluciones, normalmente algunas de las variables se designan como libres (o independientes , o como parámetros ), lo que significa que pueden tomar cualquier valor, mientras que las variables restantes dependen de los valores de las variables libres.

Por ejemplo, consideremos el siguiente sistema:

El conjunto solución de este sistema se puede describir mediante las siguientes ecuaciones:

Aquí z es la variable libre, mientras que x e y dependen de z . Cualquier punto en el conjunto de soluciones se puede obtener eligiendo primero un valor para z y luego calculando los valores correspondientes para x e y .

Cada variable libre otorga al espacio de soluciones un grado de libertad , cuyo número es igual a la dimensión del conjunto de soluciones. Por ejemplo, el conjunto de soluciones para la ecuación anterior es una línea, ya que se puede elegir un punto en el conjunto de soluciones especificando el valor del parámetro z . Una solución infinita de orden superior puede describir un plano o un conjunto de dimensiones superiores.

Diferentes opciones para las variables libres pueden llevar a diferentes descripciones del mismo conjunto de soluciones. Por ejemplo, la solución de las ecuaciones anteriores se puede describir alternativamente de la siguiente manera:

Aquí x es la variable libre, e y y z son dependientes.

El método más simple para resolver un sistema de ecuaciones lineales es eliminar variables repetidamente. Este método puede describirse de la siguiente manera:

Por ejemplo, consideremos el siguiente sistema:

Resolviendo la primera ecuación para x obtenemos , y al introducir esto en la segunda y tercera ecuación obtenemos

Dado que el lado izquierdo de ambas ecuaciones es igual a y , se iguala el lado derecho de las ecuaciones. Ahora tenemos:

Sustituyendo z = 2 en la segunda o tercera ecuación obtenemos y = 8, y los valores de y y z en la primera ecuación dan x = −15. Por lo tanto, el conjunto solución es la terna ordenada .

En la reducción por filas (también conocida como eliminación gaussiana ), el sistema lineal se representa como una matriz aumentada [8]

Esta matriz se modifica luego mediante operaciones elementales de fila hasta alcanzar la forma escalonada reducida . Existen tres tipos de operaciones elementales de fila: [8]

Como estas operaciones son reversibles, la matriz aumentada producida siempre representa un sistema lineal equivalente al original.

Existen varios algoritmos específicos para reducir por filas una matriz aumentada, de los cuales los más simples son la eliminación gaussiana y la eliminación de Gauss-Jordan . El siguiente cálculo muestra la eliminación de Gauss-Jordan aplicada a la matriz anterior:

La última matriz está en forma escalonada reducida y representa el sistema x = −15 , y = 8 , z = 2 . Una comparación con el ejemplo de la sección anterior sobre la eliminación algebraica de variables muestra que estos dos métodos son, de hecho, el mismo; la diferencia radica en cómo se escriben los cálculos.

La regla de Cramer es una fórmula explícita para la solución de un sistema de ecuaciones lineales, donde cada variable está dada por un cociente de dos determinantes . [9] Por ejemplo, la solución del sistema

viene dado por

Para cada variable, el denominador es el determinante de la matriz de coeficientes , mientras que el numerador es el determinante de una matriz en la que una columna ha sido reemplazada por el vector de términos constantes.

Aunque la regla de Cramer es importante en teoría, tiene poco valor práctico para matrices grandes, ya que el cálculo de determinantes grandes es algo engorroso. (De hecho, los determinantes grandes se calculan más fácilmente utilizando reducción de filas). Además, la regla de Cramer tiene propiedades numéricas muy pobres, lo que la hace inadecuada para resolver incluso sistemas pequeños de manera confiable, a menos que las operaciones se realicen en aritmética racional con precisión ilimitada. [ cita requerida ]

Si el sistema de ecuaciones se expresa en forma matricial , todo el conjunto de soluciones también se puede expresar en forma matricial. Si la matriz A es cuadrada (tiene m filas y n = m columnas) y tiene rango completo (todas las m filas son independientes), entonces el sistema tiene una solución única dada por

donde es la inversa de A . De manera más general, independientemente de si m = n o no y sin importar el rango de A , todas las soluciones (si existen) se dan utilizando la inversa de Moore-Penrose de A , denotada , de la siguiente manera:

donde es un vector de parámetros libres que abarca todos los posibles vectores n ×1. Una condición necesaria y suficiente para que exista(n) solución(es) es que la solución potencial obtenida con satisfaga , es decir, que si esta condición no se cumple, el sistema de ecuaciones es inconsistente y no tiene solución. Si la condición se cumple, el sistema es consistente y existe al menos una solución. Por ejemplo, en el caso mencionado anteriormente en el que A es cuadrado y de rango completo, simplemente es igual a y la ecuación de solución general se simplifica a

Como se dijo anteriormente, donde ha desaparecido completamente de la solución, quedando solo una solución. En otros casos, sin embargo, permanece y, por lo tanto, una infinidad de valores potenciales del vector de parámetros libres da una infinidad de soluciones de la ecuación.

Aunque los sistemas de tres o cuatro ecuaciones se pueden resolver fácilmente a mano (véase el método de Cracovia ), a menudo se utilizan ordenadores para sistemas más grandes. El algoritmo estándar para resolver un sistema de ecuaciones lineales se basa en la eliminación gaussiana con algunas modificaciones. En primer lugar, es esencial evitar la división por números pequeños, lo que puede dar lugar a resultados inexactos. Esto se puede hacer reordenando las ecuaciones si es necesario, un proceso conocido como pivoteo . En segundo lugar, el algoritmo no realiza exactamente la eliminación gaussiana, pero calcula la descomposición LU de la matriz A. Esta es principalmente una herramienta organizativa, pero es mucho más rápida si uno tiene que resolver varios sistemas con la misma matriz A pero diferentes vectores b .

Si la matriz A tiene alguna estructura especial, esto puede aprovecharse para obtener algoritmos más rápidos o más precisos. Por ejemplo, los sistemas con una matriz definida positiva simétrica pueden resolverse el doble de rápido con la descomposición de Cholesky . La recursión de Levinson es un método rápido para las matrices de Toeplitz . También existen métodos especiales para matrices con muchos elementos cero (las llamadas matrices dispersas ), que aparecen a menudo en las aplicaciones.

A menudo se adopta un enfoque completamente diferente para sistemas muy grandes, que de otro modo requerirían demasiado tiempo o memoria. La idea es comenzar con una aproximación inicial a la solución (que no tiene que ser precisa en absoluto) y cambiar esta aproximación en varios pasos para acercarla a la solución verdadera. Una vez que la aproximación es lo suficientemente precisa, se toma como la solución del sistema. Esto conduce a la clase de métodos iterativos . Para algunas matrices dispersas, la introducción de aleatoriedad mejora la velocidad de los métodos iterativos. [10] Un ejemplo de un método iterativo es el método de Jacobi , donde la matriz se divide en su componente diagonal y su componente no diagonal . Se utiliza una estimación inicial al comienzo del algoritmo. Cada estimación posterior se calcula utilizando la ecuación iterativa:

Cuando la diferencia entre las suposiciones y es suficientemente pequeña, se dice que el algoritmo ha convergido hacia la solución. [11]

También existe un algoritmo cuántico para sistemas lineales de ecuaciones . [12]

Un sistema de ecuaciones lineales es homogéneo si todos los términos constantes son cero:

Un sistema homogéneo es equivalente a una ecuación matricial de la forma

donde A es una matriz m × n , x es un vector columna con n entradas y 0 es el vector cero con m entradas.

Todo sistema homogéneo tiene al menos una solución, llamada solución cero (o trivial ), que se obtiene asignando el valor cero a cada una de las variables. Si el sistema tiene una matriz no singular ( det( A ) ≠ 0 ), entonces también es la única solución. Si el sistema tiene una matriz singular, entonces existe un conjunto de soluciones con un número infinito de soluciones. Este conjunto de soluciones tiene las siguientes propiedades adicionales:

Éstas son exactamente las propiedades requeridas para que el conjunto solución sea un subespacio lineal de R n . En particular, el conjunto solución de un sistema homogéneo es el mismo que el espacio nulo de la matriz correspondiente A .

Existe una estrecha relación entre las soluciones de un sistema lineal y las soluciones del sistema homogéneo correspondiente:

Específicamente, si p es cualquier solución específica del sistema lineal A x = b , entonces todo el conjunto de soluciones puede describirse como

Geométricamente, esto dice que el conjunto de soluciones para A x = b es una traslación del conjunto de soluciones para A x = 0. Específicamente, el plano para el primer sistema se puede obtener trasladándose el subespacio lineal para el sistema homogéneo por el vector p .

Este razonamiento sólo es válido si el sistema A x = b tiene al menos una solución. Esto ocurre si y sólo si el vector b se encuentra en la imagen de la transformación lineal A .