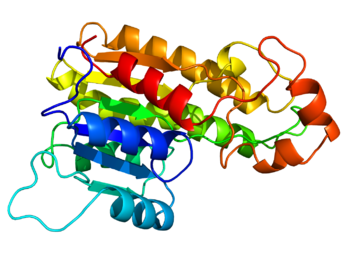

El modelado de homología , también conocido como modelado comparativo de proteínas, se refiere a la construcción de un modelo de resolución atómica de la proteína " objetivo " a partir de su secuencia de aminoácidos y una estructura tridimensional experimental de una proteína homóloga relacionada (la " plantilla "). El modelado de homología se basa en la identificación de una o más estructuras proteínicas conocidas que probablemente se asemejen a la estructura de la secuencia de consulta, y en la producción de una alineación de secuencias que mapee los residuos en la secuencia de consulta con los residuos en la secuencia de plantilla. Se ha visto que las estructuras proteínicas están más conservadas que las secuencias proteínicas entre homólogos, pero las secuencias que caen por debajo de un 20% de identidad de secuencia pueden tener una estructura muy diferente. [1]

Las proteínas relacionadas evolutivamente tienen secuencias similares y las proteínas homólogas naturales tienen una estructura proteica similar. Se ha demostrado que la estructura proteica tridimensional está evolutivamente más conservada de lo que cabría esperar basándose únicamente en la conservación de la secuencia. [2]

La alineación de secuencias y la estructura de la plantilla se utilizan luego para producir un modelo estructural del objetivo, ya que las estructuras de las proteínas están más conservadas que las secuencias de ADN y los niveles detectables de similitud de secuencias generalmente implican una similitud estructural significativa. [3]

La calidad del modelo de homología depende de la calidad de la alineación de la secuencia y de la estructura de la plantilla. El enfoque puede complicarse por la presencia de brechas de alineación (comúnmente llamadas indels) que indican una región estructural presente en el objetivo pero no en la plantilla, y por brechas estructurales en la plantilla que surgen de una mala resolución en el procedimiento experimental (generalmente cristalografía de rayos X ) utilizado para resolver la estructura. La calidad del modelo disminuye con la disminución de la identidad de secuencia ; un modelo típico tiene una desviación cuadrática media de ~1–2 Å entre los átomos de C α coincidentes con una identidad de secuencia del 70%, pero solo una concordancia de 2–4 Å con una identidad de secuencia del 25%. Sin embargo, los errores son significativamente mayores en las regiones de bucle, donde las secuencias de aminoácidos de las proteínas objetivo y de la plantilla pueden ser completamente diferentes.

Las regiones del modelo que se construyeron sin una plantilla, generalmente mediante modelado de bucles , son generalmente mucho menos precisas que el resto del modelo. Los errores en el empaquetamiento y la posición de la cadena lateral también aumentan con la disminución de la identidad, y las variaciones en estas configuraciones de empaquetamiento se han sugerido como una razón principal para la mala calidad del modelo con baja identidad. [4] En conjunto, estos diversos errores de posición atómica son significativos e impiden el uso de modelos de homología para fines que requieren datos de resolución atómica, como el diseño de fármacos y las predicciones de interacciones proteína-proteína ; incluso la estructura cuaternaria de una proteína puede ser difícil de predecir a partir de modelos de homología de su(s) subunidad(es). Sin embargo, los modelos de homología pueden ser útiles para llegar a conclusiones cualitativas sobre la bioquímica de la secuencia de consulta, especialmente para formular hipótesis sobre por qué se conservan ciertos residuos, lo que a su vez puede conducir a experimentos para probar esas hipótesis. Por ejemplo, la disposición espacial de los residuos conservados puede sugerir si un residuo particular se conserva para estabilizar el plegamiento, para participar en la unión de alguna molécula pequeña o para fomentar la asociación con otra proteína o ácido nucleico. [5]

El modelado de homología puede producir modelos estructurales de alta calidad cuando el objetivo y la plantilla están estrechamente relacionados, lo que ha inspirado la formación de un consorcio de genómica estructural dedicado a la producción de estructuras experimentales representativas para todas las clases de pliegues de proteínas. [6] Las principales inexactitudes en el modelado de homología, que empeoran con una menor identidad de secuencia , derivan de errores en la alineación de secuencia inicial y de una selección incorrecta de la plantilla. [7] Al igual que otros métodos de predicción de la estructura, la práctica actual en el modelado de homología se evalúa en un experimento bienal a gran escala conocido como la Evaluación crítica de técnicas para la predicción de la estructura de proteínas o Evaluación crítica de la predicción de la estructura ( CASP ).

El método de modelado de homología se basa en la observación de que la estructura terciaria de las proteínas se conserva mejor que la secuencia de aminoácidos . [3] Por lo tanto, incluso las proteínas que han divergido apreciablemente en la secuencia pero aún comparten una similitud detectable también compartirán propiedades estructurales comunes, en particular el plegamiento general. Debido a que es difícil y requiere mucho tiempo obtener estructuras experimentales a partir de métodos como la cristalografía de rayos X y la RMN de proteínas para cada proteína de interés, el modelado de homología puede proporcionar modelos estructurales útiles para generar hipótesis sobre la función de una proteína y dirigir el trabajo experimental posterior.

Existen excepciones a la regla general de que las proteínas que comparten una identidad de secuencia significativa compartirán un pliegue. Por ejemplo, un conjunto de mutaciones elegidas juiciosamente de menos del 50% de una proteína puede hacer que la proteína adopte un pliegue completamente diferente. [8] [9] Sin embargo, es poco probable que ocurra un reordenamiento estructural tan masivo en la evolución , especialmente porque la proteína generalmente está bajo la restricción de que debe plegarse correctamente y llevar a cabo su función en la célula. En consecuencia, la estructura plegada de una proteína (su "topología") se conserva más tiempo que su secuencia de aminoácidos y mucho más tiempo que la secuencia de ADN correspondiente; en otras palabras, dos proteínas pueden compartir un pliegue similar incluso si su relación evolutiva es tan distante que no se puede discernir de manera confiable. A modo de comparación, la función de una proteína se conserva mucho menos que la secuencia de la proteína, ya que se requieren relativamente pocos cambios en la secuencia de aminoácidos para asumir una función relacionada.

El procedimiento de modelado de homología se puede dividir en cuatro pasos secuenciales: selección de la plantilla, alineación objetivo-plantilla, construcción del modelo y evaluación del modelo. [3] Los dos primeros pasos suelen realizarse esencialmente juntos, ya que los métodos más comunes de identificación de plantillas se basan en la producción de alineaciones de secuencias; sin embargo, estas alineaciones pueden no ser de suficiente calidad porque las técnicas de búsqueda en bases de datos priorizan la velocidad sobre la calidad de la alineación. Estos procesos se pueden realizar de forma iterativa para mejorar la calidad del modelo final, aunque las evaluaciones de calidad que no dependen de la verdadera estructura del objetivo aún están en desarrollo.

Optimizar la velocidad y precisión de estos pasos para su uso en la predicción automatizada de estructuras a gran escala es un componente clave de las iniciativas de genómica estructural, en parte porque el volumen de datos resultante será demasiado grande para procesarlo manualmente y en parte porque el objetivo de la genómica estructural requiere proporcionar modelos de calidad razonable a investigadores que no son expertos en predicción de estructuras. [3]

El primer paso crítico en el modelado de homología es la identificación de la mejor estructura de plantilla, si es que hay alguna disponible. El método más simple de identificación de plantillas se basa en alineaciones de secuencias por pares en serie asistidas por técnicas de búsqueda en bases de datos como FASTA y BLAST . Los métodos más sensibles basados en la alineación de secuencias múltiples , de los cuales PSI-BLAST es el ejemplo más común, actualizan iterativamente su matriz de puntuación específica de posición para identificar sucesivamente homólogos más distantes relacionados. Se ha demostrado que esta familia de métodos produce una mayor cantidad de plantillas potenciales e identifica mejores plantillas para secuencias que solo tienen relaciones distantes con cualquier estructura resuelta. El enhebrado de proteínas [10], también conocido como reconocimiento de pliegues o alineación 3D-1D , también se puede utilizar como una técnica de búsqueda para identificar plantillas que se utilizarán en los métodos tradicionales de modelado de homología. [3] Experimentos CASP recientes indican que algunos métodos de enhebrado de proteínas como RaptorX son más sensibles que los métodos basados puramente en secuencias (perfiles) cuando solo hay plantillas distantes relacionadas disponibles para las proteínas bajo predicción. Al realizar una búsqueda BLAST, un primer enfoque confiable es identificar coincidencias con un valor E suficientemente bajo , que se consideren suficientemente cercanas en evolución para hacer un modelo de homología confiable. Otros factores pueden inclinar la balanza en casos marginales; por ejemplo, la plantilla puede tener una función similar a la de la secuencia de consulta, o puede pertenecer a un operón homólogo . Sin embargo, una plantilla con un valor E bajo generalmente no debe elegirse, incluso si es la única disponible, ya que puede tener una estructura incorrecta, lo que lleva a la producción de un modelo equivocado. Un mejor enfoque es enviar la secuencia primaria a servidores de reconocimiento de pliegues [10] o, mejor aún, a metaservidores de consenso que mejoran los servidores de reconocimiento de pliegues individuales al identificar similitudes (consenso) entre predicciones independientes.

A menudo, estos enfoques identifican varias estructuras de plantilla candidatas. Aunque algunos métodos pueden generar modelos híbridos con mejor precisión a partir de múltiples plantillas, [10] [11] la mayoría de los métodos se basan en una sola plantilla. Por lo tanto, elegir la mejor plantilla entre las candidatas es un paso clave y puede afectar significativamente la precisión final de la estructura. Esta elección está guiada por varios factores, como la similitud de las secuencias de consulta y plantilla, de sus funciones y de las estructuras secundarias de consulta y plantilla observadas previstas . Quizás lo más importante sea la cobertura de las regiones alineadas: la fracción de la estructura de la secuencia de consulta que se puede predecir a partir de la plantilla y la plausibilidad del modelo resultante. Por lo tanto, a veces se producen varios modelos de homología para una sola secuencia de consulta, y el candidato más probable se elige solo en el paso final.

Es posible utilizar la alineación de secuencias generada por la técnica de búsqueda en la base de datos como base para la posterior producción del modelo; sin embargo, también se han explorado enfoques más sofisticados. Una propuesta genera un conjunto de alineaciones por pares definidas estocásticamente entre la secuencia objetivo y una única plantilla identificada como un medio para explorar el "espacio de alineación" en regiones de secuencia con baja similitud local. [12] Alineaciones "perfil-perfil" que primero generan un perfil de secuencia del objetivo y lo comparan sistemáticamente con los perfiles de secuencia de estructuras resueltas; se cree que el granulado grueso inherente a la construcción del perfil reduce el ruido introducido por la deriva de la secuencia en regiones no esenciales de la secuencia. [13]

Dada una plantilla y una alineación, la información contenida en ella debe utilizarse para generar un modelo estructural tridimensional del objetivo, representado como un conjunto de coordenadas cartesianas para cada átomo de la proteína. Se han propuesto tres clases principales de métodos de generación de modelos. [14] [15]

El método original de modelado de homología se basaba en el ensamblaje de un modelo completo a partir de fragmentos estructurales conservados identificados en estructuras resueltas estrechamente relacionadas. Por ejemplo, un estudio de modelado de serina proteasas en mamíferos identificó una clara distinción entre regiones estructurales "centrales" conservadas en todas las estructuras experimentales de la clase y regiones variables ubicadas típicamente en los bucles donde se localizaban la mayoría de las diferencias de secuencia. Por lo tanto, las proteínas no resueltas se podían modelar construyendo primero el núcleo conservado y luego sustituyendo regiones variables de otras proteínas en el conjunto de estructuras resueltas. [16] Las implementaciones actuales de este método difieren principalmente en la forma en que tratan las regiones que no están conservadas o que carecen de una plantilla. [17] Las regiones variables a menudo se construyen con la ayuda de una biblioteca de fragmentos de proteínas .

El método de emparejamiento de segmentos divide el objetivo en una serie de segmentos cortos, cada uno de los cuales se empareja con su propia plantilla ajustada a partir del Protein Data Bank . De este modo, la alineación de secuencias se realiza sobre segmentos en lugar de sobre toda la proteína. La selección de la plantilla para cada segmento se basa en la similitud de secuencias, comparaciones de coordenadas de carbono alfa y conflictos estéricos previstos que surgen de los radios de van der Waals de los átomos divergentes entre el objetivo y la plantilla. [18]

El método de modelado de homología actual más común se inspira en los cálculos necesarios para construir una estructura tridimensional a partir de datos generados por espectroscopia de RMN . Se utilizan una o más alineaciones de objetivo-plantilla para construir un conjunto de criterios geométricos que luego se convierten en funciones de densidad de probabilidad para cada restricción. Las restricciones aplicadas a las coordenadas internas principales de la proteína ( distancias de la cadena principal de la proteína y ángulos diedros ) sirven como base para un procedimiento de optimización global que originalmente utilizaba la minimización de energía del gradiente conjugado para refinar iterativamente las posiciones de todos los átomos pesados en la proteína. [19]

Este método se ha ampliado drásticamente para aplicarlo específicamente al modelado de bucles, que puede ser extremadamente difícil debido a la alta flexibilidad de los bucles en proteínas en solución acuosa . [20] Una expansión más reciente aplica el modelo de restricción espacial a los mapas de densidad electrónica derivados de estudios de microscopía crioelectrónica , que proporcionan información de baja resolución que normalmente no es suficiente para generar modelos estructurales de resolución atómica. [21] Para abordar el problema de las imprecisiones en la alineación inicial de la secuencia objetivo-plantilla, también se ha introducido un procedimiento iterativo para refinar la alineación sobre la base del ajuste estructural inicial. [22] El software más comúnmente utilizado en el modelado basado en restricción espacial es MODELLER y se ha establecido una base de datos llamada ModBase para modelos confiables generados con él. [23]

Las regiones de la secuencia objetivo que no están alineadas con una plantilla se modelan mediante modelado de bucles ; son las más susceptibles a errores de modelado importantes y ocurren con mayor frecuencia cuando el objetivo y la plantilla tienen baja identidad de secuencia. Las coordenadas de las secciones no coincidentes determinadas por los programas de modelado de bucles son generalmente mucho menos precisas que las obtenidas simplemente copiando las coordenadas de una estructura conocida, particularmente si el bucle tiene más de 10 residuos. Los primeros dos ángulos diedros de la cadena lateral (χ 1 y χ 2 ) generalmente se pueden estimar dentro de los 30° para una estructura de cadena principal precisa; sin embargo, los ángulos diedros posteriores encontrados en cadenas laterales más largas como la lisina y la arginina son notoriamente difíciles de predecir. Además, pequeños errores en χ 1 (y, en menor medida, en χ 2 ) pueden causar errores relativamente grandes en las posiciones de los átomos en el extremo de la cadena lateral; dichos átomos a menudo tienen una importancia funcional, particularmente cuando se ubican cerca del sitio activo .

Se han desarrollado una gran cantidad de métodos para seleccionar una estructura similar a la nativa a partir de un conjunto de modelos. Las funciones de puntuación se han basado en funciones de energía de mecánica molecular (Lazaridis y Karplus 1999; Petrey y Honig 2000; Feig y Brooks 2002; Felts et al. 2002; Lee y Duan 2004), potenciales estadísticos (Sippl 1995; Melo y Feytmans 1998; Samudrala y Moult 1998; Rojnuckarin y Subramaniam 1999; Lu y Skolnick 2001; Wallqvist et al. 2002; Zhou y Zhou 2002), entornos de residuos (Luthy et al. 1992; Eisenberg et al. 1997; Park et al. 1997; Summa et al. 2005), interacciones locales de cadena lateral y cadena principal (Fang y Shortle 2005), propiedades dependientes de la orientación (Buchete et al. 2004a,b; Hamelryck 2005), estimaciones de empaquetamiento (Berglund et al. 2004), energía de solvatación (Petrey y Honig 2000; McConkey et al. 2003; Wallner y Elofsson 2003; Berglund et al. 2004), enlaces de hidrógeno (Kortemme et al. 2003) y propiedades geométricas (Colovos y Yeates 1993; Kleywegt 2000; Lovell et al. 2003; Mihalek et al. 2003). Existen varios métodos que combinan diferentes potenciales en una puntuación global, generalmente mediante una combinación lineal de términos (Kortemme et al., 2003; Tosatto, 2005) o con la ayuda de técnicas de aprendizaje automático, como redes neuronales (Wallner y Elofsson, 2003) y máquinas de vectores de soporte (SVM) (Eramian et al., 2006). Se pueden encontrar comparaciones de diferentes programas de evaluación de la calidad de modelos globales en artículos recientes de Pettitt et al. (2005), Tosatto (2005) y Eramian et al. (2006).

Se ha publicado menos trabajo sobre la evaluación de la calidad local de los modelos. Las puntuaciones locales son importantes en el contexto del modelado porque pueden dar una estimación de la fiabilidad de las diferentes regiones de una estructura prevista. Esta información se puede utilizar a su vez para determinar qué regiones se deben refinar, cuáles se deben tener en cuenta para el modelado mediante múltiples plantillas y cuáles se deben predecir ab initio. La información sobre la calidad del modelo local también se podría utilizar para reducir el problema combinatorio al considerar alineaciones alternativas; por ejemplo, al puntuar los diferentes modelos locales por separado, se tendrían que construir menos modelos (suponiendo que las interacciones entre las regiones separadas son insignificantes o se pueden estimar por separado).

Uno de los métodos de puntuación local más utilizados es Verify3D (Luthy et al. 1992; Eisenberg et al. 1997), que combina la estructura secundaria, la accesibilidad del disolvente y la polaridad de los entornos de los residuos. ProsaII (Sippl 1993), que se basa en una combinación de un potencial estadístico por pares y un término de solvatación, también se aplica ampliamente en la evaluación de modelos. Otros métodos incluyen el programa Errat (Colovos y Yeates 1993), que considera las distribuciones de átomos no enlazados según el tipo de átomo y la distancia, y el método de deformación de energía (Maiorov y Abagyan 1998), que utiliza las diferencias de las energías promedio de los residuos en diferentes entornos para indicar qué partes de una estructura de proteína podrían ser problemáticas. Melo y Feytmans (1998) utilizan un potencial atómico por pares y un potencial de solvatación basado en la superficie (ambos basados en el conocimiento) para evaluar las estructuras de las proteínas. Aparte del método de deformación de energía, que es un enfoque semiempírico basado en el campo de fuerza ECEPP3 (Nemethy et al. 1992), todos los métodos locales enumerados anteriormente se basan en potenciales estadísticos. Un enfoque conceptualmente distinto es el método ProQres, que fue introducido muy recientemente por Wallner y Elofsson (2006). ProQres se basa en una red neuronal que combina características estructurales para distinguir las regiones correctas de las incorrectas. Se demostró que ProQres superaba a las metodologías anteriores basadas en enfoques estadísticos (Verify3D, ProsaII y Errat). Los datos presentados en el estudio de Wallner y Elofsson sugieren que su enfoque de aprendizaje automático basado en características estructurales es de hecho superior a los métodos basados en estadísticas. Sin embargo, los métodos basados en el conocimiento examinados en su trabajo, Verify3D (Luthy et al. 1992; Eisenberg et al. 1997), Prosa (Sippl 1993) y Errat (Colovos y Yeates 1993), no se basan en potenciales estadísticos más nuevos.

Se han realizado varios esfuerzos de evaluación comparativa a gran escala para evaluar la calidad relativa de varios métodos de modelado de homología actuales. La Evaluación crítica de la predicción de la estructura ( CASP ) es un experimento de predicción de toda la comunidad que se realiza cada dos años durante los meses de verano y desafía a los equipos de predicción a enviar modelos estructurales para una serie de secuencias cuyas estructuras se han resuelto recientemente de forma experimental pero que aún no se han publicado. Su socio, la Evaluación crítica de la predicción de la estructura totalmente automatizada ( CAFASP ), se ha ejecutado en paralelo con CASP, pero evalúa solo los modelos producidos a través de servidores completamente automatizados. Los experimentos de ejecución continua que no tienen "temporadas" de predicción se centran principalmente en la evaluación comparativa de servidores web disponibles públicamente. LiveBench y EVA se ejecutan continuamente para evaluar el rendimiento de los servidores participantes en la predicción de estructuras publicadas inminentemente desde el PDB. CASP y CAFASP sirven principalmente como evaluaciones del estado del arte en modelado, mientras que las evaluaciones continuas buscan evaluar la calidad del modelo que obtendría un usuario no experto que empleara herramientas disponibles públicamente.

La precisión de las estructuras generadas por el modelado de homología depende en gran medida de la identidad de secuencia entre el objetivo y la plantilla. Por encima del 50% de identidad de secuencia, los modelos tienden a ser confiables, con solo errores menores en el empaquetamiento de la cadena lateral y el estado rotámero , y una desviación estándar media global entre la estructura modelada y la experimental que cae alrededor de 1 Å . Este error es comparable a la resolución típica de una estructura resuelta por RMN. En el rango de identidad del 30 al 50%, los errores pueden ser más graves y a menudo se ubican en bucles. Por debajo del 30% de identidad, ocurren errores graves, que a veces dan como resultado una predicción errónea del plegamiento básico. [14] Esta región de baja identidad a menudo se conoce como la "zona crepuscular" dentro de la cual el modelado de homología es extremadamente difícil, y para la cual posiblemente sea menos adecuado que los métodos de reconocimiento de plegamiento . [24]

En el caso de identidades de secuencia elevadas, la principal fuente de error en el modelado de homología se deriva de la elección de la plantilla o plantillas en las que se basa el modelo, mientras que las identidades más bajas muestran errores graves en la alineación de secuencias que inhiben la producción de modelos de alta calidad. [7] Se ha sugerido que el principal impedimento para la producción de modelos de calidad son las deficiencias en la alineación de secuencias, ya que las alineaciones estructurales "óptimas" entre dos proteínas de estructura conocida se pueden utilizar como entrada para los métodos de modelado actuales para producir reproducciones bastante precisas de la estructura experimental original. [25]

Se han hecho intentos para mejorar la precisión de los modelos de homología construidos con métodos existentes al someterlos a simulación de dinámica molecular en un esfuerzo por mejorar su RMSD con respecto a la estructura experimental. Sin embargo, las parametrizaciones actuales de los campos de fuerza pueden no ser lo suficientemente precisas para esta tarea, ya que los modelos de homología utilizados como estructuras iniciales para la dinámica molecular tienden a producir estructuras ligeramente peores. [26] Se han observado ligeras mejoras en casos en los que se utilizaron restricciones significativas durante la simulación. [27]

Las dos fuentes de error más comunes y a gran escala en el modelado de homología son la mala selección de plantillas y las imprecisiones en la alineación de secuencia objetivo-plantilla. [7] [28] Controlar estos dos factores mediante el uso de una alineación estructural , o una alineación de secuencia producida sobre la base de la comparación de dos estructuras resueltas, reduce drásticamente los errores en los modelos finales; estas alineaciones de "estándar de oro" se pueden utilizar como entrada a los métodos de modelado actuales para producir reproducciones bastante precisas de la estructura experimental original. [25] Los resultados del experimento CASP más reciente sugieren que los métodos de "consenso" que recopilan los resultados del reconocimiento de múltiples pliegues y múltiples búsquedas de alineación aumentan la probabilidad de identificar la plantilla correcta; de manera similar, el uso de múltiples plantillas en el paso de construcción del modelo puede ser peor que el uso de la única plantilla correcta, pero mejor que el uso de una única plantilla subóptima. [28] Los errores de alineación se pueden minimizar mediante el uso de una alineación múltiple incluso si solo se utiliza una plantilla, y mediante el refinamiento iterativo de las regiones locales de baja similitud. [3] [12] Una fuente menor de errores de modelo son los errores en la estructura de la plantilla. El PDBREPORT, archivado el 31 de mayo de 2007 en la base de datos Wayback Machine , enumera varios millones de errores, en su mayoría muy pequeños pero ocasionalmente dramáticos, en estructuras experimentales (plantilla) que se han depositado en el PDB .

En los modelos de homología pueden surgir errores locales graves en los que una mutación por inserción o deleción o un hueco en una estructura resuelta dan como resultado una región de la secuencia diana para la que no existe una plantilla correspondiente. Este problema se puede minimizar mediante el uso de múltiples plantillas, pero el método se complica por las diferentes estructuras locales de las plantillas alrededor del hueco y por la probabilidad de que una región faltante en una estructura experimental también esté faltante en otras estructuras de la misma familia de proteínas. Las regiones faltantes son más comunes en los bucles donde la alta flexibilidad local aumenta la dificultad de resolver la región mediante métodos de determinación de la estructura. Aunque se proporciona cierta orientación incluso con una sola plantilla mediante la posición de los extremos de la región faltante, cuanto más largo sea el hueco, más difícil es modelar. En algunos casos, se pueden modelar bucles de hasta aproximadamente 9 residuos con una precisión moderada si la alineación local es correcta. [3] Las regiones más grandes a menudo se modelan individualmente utilizando técnicas de predicción de estructura ab initio , aunque este enfoque solo ha tenido un éxito aislado. [29]

Los estados rotámeros de las cadenas laterales y su disposición de empaquetamiento interno también presentan dificultades en el modelado de homología, incluso en dianas para las que la estructura de la cadena principal es relativamente fácil de predecir. Esto se debe en parte al hecho de que muchas cadenas laterales en estructuras cristalinas no están en su estado rotámero "óptimo" como resultado de factores energéticos en el núcleo hidrofóbico y en el empaquetamiento de las moléculas individuales en un cristal de proteína. [30] Un método para abordar este problema requiere buscar en una biblioteca rotámera para identificar combinaciones de estados de empaquetamiento de energía localmente baja. [31] Se ha sugerido que una razón principal por la que el modelado de homología es tan difícil cuando la identidad de secuencia diana-molde se encuentra por debajo del 30% es que dichas proteínas tienen pliegues ampliamente similares pero disposiciones de empaquetamiento de cadena lateral ampliamente divergentes. [4]

Los usos de los modelos estructurales incluyen la predicción de interacciones proteína-proteína , el acoplamiento proteína-proteína , el acoplamiento molecular y la anotación funcional de genes identificados en el genoma de un organismo . [32] Incluso los modelos de homología de baja precisión pueden ser útiles para estos fines, porque sus imprecisiones tienden a ubicarse en los bucles de la superficie de la proteína, que normalmente son más variables incluso entre proteínas estrechamente relacionadas. Las regiones funcionales de la proteína, especialmente su sitio activo , tienden a estar más conservadas y, por lo tanto, a modelarse con mayor precisión. [14]

Los modelos de homología también se pueden utilizar para identificar diferencias sutiles entre proteínas relacionadas que no se han resuelto todas estructuralmente. Por ejemplo, el método se utilizó para identificar sitios de unión de cationes en la ATPasa Na + /K + y para proponer hipótesis sobre la afinidad de unión de diferentes ATPasas. [33] Utilizados junto con simulaciones de dinámica molecular , los modelos de homología también pueden generar hipótesis sobre la cinética y la dinámica de una proteína, como en los estudios de la selectividad iónica de un canal de potasio . [34] Se ha intentado el modelado automatizado a gran escala de todas las regiones codificantes de proteínas identificadas en un genoma para la levadura Saccharomyces cerevisiae , lo que dio como resultado casi 1000 modelos de calidad para proteínas cuyas estructuras aún no se habían determinado en el momento del estudio, e identificar nuevas relaciones entre 236 proteínas de levadura y otras estructuras resueltas previamente. [35]