Las redes neuronales de picos ( SNN ) son redes neuronales artificiales (ANN) que imitan más de cerca las redes neuronales naturales. [1] Además del estado neuronal y sináptico , los SNN incorporan el concepto de tiempo en su modelo operativo. La idea es que las neuronas del SNN no transmiten información en cada ciclo de propagación (como ocurre con las típicas redes de perceptrones multicapa ), sino que transmiten información sólo cuando se activa el potencial de membrana , una cualidad intrínseca de la neurona relacionada con su conexión eléctrica de membrana . carga: alcanza un valor específico, llamado umbral. Cuando el potencial de membrana alcanza el umbral, la neurona se activa y genera una señal que viaja a otras neuronas que, a su vez, aumentan o disminuyen sus potenciales en respuesta a esta señal. Un modelo de neurona que se activa en el momento de cruzar el umbral también se denomina modelo de neurona de picos . [2]

Aunque anteriormente se creía que el cerebro codificaba información a través de velocidades de pico, que pueden considerarse como la salida variable analógica de una RNA tradicional, [3] la investigación en el campo de la neurobiología ha indicado que el procesamiento de alta velocidad no puede realizarse únicamente a través de una velocidad esquema basado. Por ejemplo, los humanos pueden realizar una tarea de reconocimiento de imágenes a una velocidad que no requiere más de 10 ms de tiempo de procesamiento por neurona a través de las capas sucesivas (desde la retina hasta el lóbulo temporal). Esta ventana de tiempo es demasiado corta para una codificación basada en tasas. Los tiempos precisos de los picos en un pequeño conjunto de neuronas que se disparan también tienen una mayor capacidad de codificación de información en comparación con un enfoque basado en la velocidad. [4]

El modelo de neuronas con picos más destacado es el modelo de integración y disparo con fugas . [5] En el modelo de integración y disparo, el nivel de activación momentáneo (modelado como una ecuación diferencial ) normalmente se considera el estado de la neurona, con picos entrantes que empujan este valor hacia arriba o hacia abajo, hasta que el estado eventualmente decae o— si se alcanza el umbral de activación, la neurona se activa. Después del disparo, la variable de estado se restablece a un valor más bajo.

Existen varios métodos de decodificación para interpretar el tren de picos saliente como un número de valor real, basándose en la frecuencia de los picos ( código de tasa ), el tiempo hasta el primer pico después de la estimulación o el intervalo entre picos.

Muchas redes neuronales artificiales multicapa están completamente conectadas , reciben información de cada neurona en la capa anterior y envían señales a cada neurona en la capa siguiente. Aunque estas redes han logrado avances en muchos campos, son biológicamente inexactas y no imitan el mecanismo de funcionamiento de las neuronas en el cerebro de un ser vivo. [6]

El modelo de Hodgkin-Huxley, de inspiración biológica , de una neurona activada se propuso en 1952. Este modelo describe cómo se inician y propagan los potenciales de acción . La comunicación entre neuronas, que requiere el intercambio de neurotransmisores químicos en la brecha sináptica , se describe en varios modelos, como el modelo de integración y disparo , el modelo de FitzHugh-Nagumo (1961-1962) y el modelo de Hindmarsh-Rose (1984). . El modelo de integración y disparo con fugas (o un derivado) se usa comúnmente porque es más fácil de calcular que el modelo de Hodgkin-Huxley. [7]

La información en el cerebro se representa como potenciales de acción (picos neuronales), que pueden agruparse en trenes de picos o incluso ondas coordinadas de actividad cerebral. Una cuestión fundamental de la neurociencia es determinar si las neuronas se comunican mediante un código de velocidad o temporal . [8] La codificación temporal sugiere que una sola neurona con picos puede reemplazar cientos de unidades ocultas en una red neuronal sigmoidea . [1]

Un SNN calcula en el dominio continuo en lugar de en el discreto. La idea es que las neuronas no pueden probar su activación en cada iteración de propagación (como es el caso en una red de perceptrón multicapa típica ), sino sólo cuando sus potenciales de membrana alcanzan un cierto valor. Cuando se activa una neurona, produce una señal que se transmite a las neuronas conectadas, aumentando o disminuyendo su potencial de membrana.

En una red neuronal con picos, el estado actual de una neurona se define como su potencial de membrana (posiblemente modelado como una ecuación diferencial). Un pulso de entrada hace que el potencial de membrana aumente durante un período de tiempo y luego disminuya gradualmente. Se han construido esquemas de codificación para interpretar estas secuencias de pulsos como un número, teniendo en cuenta tanto la frecuencia del pulso como el intervalo del pulso. Se puede establecer un modelo de red neuronal basado en el tiempo de generación de pulsos. Utilizando el momento exacto en que se produce el pulso, una red neuronal puede emplear más información y ofrecer mejores propiedades informáticas.

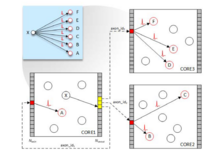

El enfoque SNN produce una salida continua en lugar de la salida binaria de las redes neuronales artificiales (ANN) tradicionales. Los trenes de impulsos no son fácilmente interpretables, de ahí la necesidad de esquemas de codificación como los anteriores. Sin embargo, una representación de tren de pulsos puede ser más adecuada para procesar datos espaciotemporales (o clasificación continua de datos sensoriales del mundo real). [9] Los SNN consideran el espacio conectando neuronas solo a neuronas cercanas para que procesen los bloques de entrada por separado (similar a CNN que usa filtros). Consideran el tiempo codificando la información como trenes de pulsos para no perder información en una codificación binaria. Esto evita la complejidad adicional de una red neuronal recurrente (RNN). Resulta que las neuronas de impulso son unidades computacionales más poderosas que las neuronas artificiales tradicionales. [10]

Las SNN son teóricamente más poderosas que las llamadas "redes de segunda generación" definidas en [10] como "[ANN] basadas en unidades computacionales que aplican la función de activación con un conjunto continuo de posibles valores de salida a una suma ponderada (o polinomio) de las entradas; sin embargo, los problemas de capacitación de SNN y los requisitos de hardware limitan su uso. Aunque hay métodos de aprendizaje no supervisados de inspiración biológica disponibles, como el aprendizaje hebbiano y STDP , ningún método de capacitación supervisada eficaz es adecuado para SNN que pueda proporcionar un mejor rendimiento que las redes de segunda generación . 10] La activación de SNN basada en picos no es diferenciable, lo que dificulta el desarrollo de métodos de entrenamiento basados en descenso de gradiente para realizar la retropropagación de errores .

Las SNN tienen costos computacionales mucho mayores para simular modelos neuronales realistas que las ANN tradicionales. [11]

Las redes neuronales acopladas por pulsos (PCNN) a menudo se confunden con las SNN. Una PCNN puede verse como una especie de SNN.

Actualmente existen algunos desafíos al usar SNN en los que los investigadores están trabajando activamente. El primer desafío se refiere a la no diferenciabilidad de la no linealidad de los picos. Las expresiones para los métodos de aprendizaje hacia adelante y hacia atrás contienen la derivada de la función de activación neuronal que no es diferenciable porque la salida de la neurona es 1 cuando alcanza un pico y 0 en caso contrario. Este comportamiento de todo o nada de la no linealidad de picos binarios impide que los gradientes "fluyan" y hace que las neuronas LIF no sean adecuadas para la optimización basada en gradientes. El segundo desafío tiene que ver con la implementación del propio algoritmo de optimización. La PA estándar puede ser costosa en términos de computación, memoria y comunicación y puede no adaptarse a las limitaciones dictadas por el hardware que la implementa (p. ej., una computadora, un cerebro o un dispositivo neuromórfico). [12] Respecto al primer desafío, existen varios abordados para superarlo. Algunos de ellos son:

En el desarrollo de SNN, la incorporación de dinámicas neuronales adicionales como la Adaptación de frecuencia de picos (SFA) en los modelos neuronales marca un avance notable, ya que mejora tanto la eficiencia como la potencia computacional. [5] [13] Estas neuronas se encuentran entre la complejidad biológica y la complejidad computacional. [14] Originado a partir de conocimientos biológicos, SFA ofrece importantes beneficios computacionales al reducir el uso de energía a través de una codificación eficiente, [15] especialmente en casos de estímulos repetitivos o intensos. Esta adaptación mejora la claridad de la señal frente al ruido de fondo e introduce una memoria elemental a corto plazo a nivel neuronal, que a su vez refina la precisión y eficiencia del procesamiento de la información. [16] Recientemente, este fenómeno se logra principalmente utilizando modelos de neuronas compartimentales. Las versiones más simples son modelos neuronales con umbrales adaptativos, una forma indirecta de lograr SFA, equipa a los SNN con capacidades de aprendizaje mejoradas, incluso con plasticidad sináptica restringida, y eleva la eficiencia computacional. [17] [18] Esta característica disminuye la demanda en las capas de red al disminuir la necesidad de procesamiento de picos, reduciendo así la carga computacional y el tiempo de acceso a la memoria, aspectos esenciales de la computación neuronal. Además, los SNN que utilizan neuronas capaces de SFA alcanzan niveles de precisión que rivalizan con los de las redes neuronales artificiales convencionales, incluidas aquellas basadas en modelos de memoria a corto plazo, [19] [20] y, al mismo tiempo, requieren menos neuronas para tareas computacionales comparables. Esta eficiencia no solo agiliza el flujo de trabajo computacional sino que también conserva espacio y energía, ofreciendo un paso pragmático hacia la aplicación práctica de SNN para tareas informáticas complejas, manteniendo al mismo tiempo un compromiso con la integridad técnica.

En principio, las SNN pueden aplicarse a las mismas aplicaciones que las ANN tradicionales. [21] Además, los SNN pueden modelar el sistema nervioso central de organismos biológicos, como un insecto que busca alimento sin conocimiento previo del medio ambiente. [22] Debido a su relativo realismo, pueden usarse para estudiar el funcionamiento de circuitos neuronales biológicos . A partir de una hipótesis sobre la topología de un circuito neuronal biológico y su función, las grabaciones de este circuito se pueden comparar con la salida del SNN correspondiente, evaluando la plausibilidad de la hipótesis. Sin embargo, faltan mecanismos de entrenamiento efectivos para los SNN, lo que puede resultar inhibidor para algunas aplicaciones, incluidas las tareas de visión por computadora.

A partir de 2019, las SNN están por detrás de las ANN en términos de precisión, pero la brecha está disminuyendo y ha desaparecido en algunas tareas. [23]

Cuando utilizamos SNN para datos basados en imágenes, necesitamos convertir imágenes estáticas en codificación de trenes de picos binarios. [24] Tipos de codificaciones: [25]

Una amplia gama de software de aplicación puede simular SNN. Este software se puede clasificar según sus usos:

Estos simulan modelos neuronales complejos con un alto nivel de detalle y precisión. Las redes grandes suelen requerir un procesamiento prolongado. Los candidatos incluyen: [26]

Las arquitecturas neuromórficas futuras [29] comprenderán miles de millones de nanosinapsis de este tipo, que requieren una comprensión clara de los mecanismos físicos responsables de la plasticidad. Se han utilizado sistemas experimentales basados en uniones de túneles ferroeléctricos para demostrar que el STDP se puede aprovechar a partir de una conmutación de polarización heterogénea. Mediante imágenes combinadas de sondas de escaneo, transporte eléctrico y dinámica molecular a escala atómica, las variaciones de conductancia se pueden modelar mediante la inversión de dominios dominada por la nucleación. Las simulaciones muestran que conjuntos de nanosinapsis ferroeléctricas pueden aprender de forma autónoma a reconocer patrones de forma predecible, abriendo el camino hacia el aprendizaje no supervisado . [30]

Las capacidades de clasificación de las redes de picos entrenadas según métodos de aprendizaje no supervisados [35] se han probado en conjuntos de datos de referencia comunes, como Iris, Wisconsin Breast Cancer o Statlog Landsat. [36] [37] Se han utilizado varios enfoques para la codificación de información y el diseño de redes. Por ejemplo, una red feedforward de 2 capas para agrupación y clasificación de datos. Basándose en la idea propuesta por Hopfield (1995), los autores implementaron modelos de campos receptivos locales que combinan las propiedades de las funciones de base radial (RBF) y neuronas con picos para convertir señales de entrada (datos clasificados) que tienen una representación de punto flotante en una representación con picos. [38] [39]

{{cite book}}: |journal=ignorado ( ayuda )