En el aprendizaje de árboles de decisión , la tasa de ganancia de información es una relación entre la ganancia de información y la información intrínseca. Ross Quinlan [1] propuso reducir el sesgo hacia atributos multivalor teniendo en cuenta el número y tamaño de las ramas al elegir un atributo . [2]

La ganancia de información también se conoce como información mutua . [3]

La ganancia de información es la reducción de entropía producida al dividir un conjunto con atributos y encontrar el candidato óptimo que produzca el valor más alto:

donde es una variable aleatoria y es la entropía de dado el valor del atributo .

La ganancia de información es igual a la entropía total de un atributo si para cada uno de los valores del atributo se puede realizar una clasificación única para el atributo de resultado. En este caso las entropías relativas restadas de la entropía total son 0.

El valor de información dividida para una prueba se define de la siguiente manera:

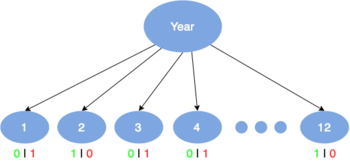

donde es una variable aleatoria discreta con valores posibles y siendo el número de veces que ocurre dividido por el recuento total de eventos donde es el conjunto de eventos.

El valor de la información dividida es un número positivo que describe el valor potencial de dividir una rama de un nodo. Este, a su vez, es el valor intrínseco que posee la variable aleatoria y se utilizará para eliminar el sesgo en el cálculo del índice de ganancia de información.

La relación de ganancia de información es la relación entre la ganancia de información y el valor de información dividida:

Utilizando datos meteorológicos publicados por la Universidad de Fordham, [4] se creó la siguiente tabla:

Usando la tabla anterior, se puede encontrar la entropía, la ganancia de información, la información dividida y la relación de ganancia de información para cada variable (perspectiva, temperatura, humedad y viento). Estos cálculos se muestran en las tablas siguientes:

Utilizando las tablas anteriores, se puede deducir que Outlook tiene el índice de ganancia de información más alto. A continuación, se deben encontrar las estadísticas para los subgrupos de la variable Outlook (soleado, nublado y lluvioso), para este ejemplo solo construiremos la rama soleada (como se muestra en la siguiente tabla):

Se pueden encontrar las siguientes estadísticas para las otras variables (temperatura, humedad y viento) para ver cuáles tienen el mayor efecto sobre el elemento soleado de la variable de perspectiva:

Se descubrió que la humedad tiene el índice de ganancia de información más alto. Se repetirán los mismos pasos que antes y se encontrarán las estadísticas de los eventos de la variable Humedad (alta y normal):

Dado que todos los valores de juego son "No" o "Sí", el valor de la relación de ganancia de información será igual a 1. Además, ahora que uno ha llegado al final de la cadena de variables con Viento como la última variable restante, pueden construir una línea completa de rama del nodo raíz al nodo hoja de un árbol de decisión.

Una vez que se termina de llegar a este nodo hoja, se seguiría el mismo procedimiento para el resto de los elementos que aún no se han dividido en el árbol de decisión. Este conjunto de datos era relativamente pequeño; sin embargo, si se utiliza un conjunto más grande, se pueden ver más las ventajas de utilizar el índice de ganancia de información como factor de división de un árbol de decisión.

La relación de ganancia de información predispone al árbol de decisión a considerar atributos con una gran cantidad de valores distintos.

Por ejemplo, supongamos que estamos creando un árbol de decisiones para algunos datos que describen a los clientes de una empresa. El índice de ganancia de información se utiliza para decidir cuáles de los atributos son los más relevantes. Estos se probarán cerca de la raíz del árbol. Uno de los atributos de entrada podría ser el número de teléfono del cliente . Este atributo tiene una alta ganancia de información, porque identifica de forma única a cada cliente. Debido a su gran cantidad de valores distintos, no se elegirá para probarlo cerca de la raíz.

Aunque el ratio de ganancia de información resuelve el problema clave de la ganancia de información, crea otro problema. Si se considera una cantidad de atributos que tienen un número elevado de valores distintos, estos nunca estarán por encima de uno que tenga un número menor de valores distintos.