En inferencia estadística , específicamente en inferencia predictiva , un intervalo de predicción es una estimación de un intervalo en el que caerá una observación futura, con cierta probabilidad, dado lo que ya se ha observado. Los intervalos de predicción se utilizan a menudo en el análisis de regresión .

Un ejemplo sencillo es el de un dado de seis caras con valores nominales que van del 1 al 6. El intervalo de confianza para el valor esperado estimado del valor nominal será de alrededor de 3,5 y se hará más estrecho cuanto mayor sea el tamaño de la muestra. Sin embargo, el intervalo de predicción para la siguiente tirada oscilará aproximadamente entre 1 y 6, incluso con cualquier número de muestras vistas hasta el momento.

Los intervalos de predicción se utilizan tanto en las estadísticas frecuentistas como en las bayesianas : un intervalo de predicción tiene la misma relación con una observación futura que un intervalo de confianza frecuentista o un intervalo creíble bayesiano con un parámetro poblacional no observable: los intervalos de predicción predicen la distribución de puntos futuros individuales, mientras que los intervalos de confianza y los intervalos creíbles de parámetros predicen la distribución de estimaciones de la media real de la población u otra cantidad de interés que no se puede observar.

Si se hace la suposición paramétrica de que la distribución subyacente es una distribución normal , y tiene un conjunto de muestra { X 1 , ..., X n }, entonces se pueden usar intervalos de confianza e intervalos creíbles para estimar la media poblacional μ y la desviación estándar poblacional σ de la población subyacente, mientras que se pueden usar intervalos de predicción para estimar el valor de la siguiente variable de muestra, X n +1 .

Alternativamente, en términos bayesianos, un intervalo de predicción puede describirse como un intervalo creíble para la variable misma, en lugar de para un parámetro de su distribución.

El concepto de intervalos de predicción no tiene por qué limitarse a la inferencia sobre un único valor de muestra futuro, sino que puede extenderse a casos más complicados. Por ejemplo, en el contexto de las inundaciones fluviales, donde los análisis suelen basarse en valores anuales del caudal más elevado del año, puede resultar interesante realizar inferencias sobre la mayor inundación que probablemente se produzca en los próximos 50 años.

Dado que los intervalos de predicción solo se ocupan de observaciones pasadas y futuras, en lugar de parámetros poblacionales no observables, algunos estadísticos, como Seymour Geisser , [ cita requerida ] los defienden como un método mejor que los intervalos de confianza, siguiendo el enfoque en los observables de Bruno de Finetti . [ cita requerida ]

Dada una muestra de una distribución normal , cuyos parámetros son desconocidos, es posible dar intervalos de predicción en el sentido frecuentista, es decir, un intervalo [ a , b ] basado en estadísticas de la muestra tales que en experimentos repetidos, X n +1 cae en el intervalo el porcentaje deseado del tiempo; uno puede llamar a estos " intervalos de confianza predictivos ". [1]

Una técnica general de intervalos de predicción frecuentistas es encontrar y calcular una cantidad pivote de los observables X 1 , ..., X n , X n +1 – es decir, una función de observables y parámetros cuya distribución de probabilidad no depende de los parámetros – que se puede invertir para dar una probabilidad de que la futura observación X n +1 caiga en algún intervalo calculado en términos de los valores observados hasta el momento. Tal cantidad pivote, que depende solo de los observables, se llama estadística auxiliar . [2] El método habitual de construir cantidades pivote es tomar la diferencia de dos variables que dependen de la ubicación, de modo que la ubicación se cancele, y luego tomar la relación de dos variables que dependen de la escala, de modo que la escala se cancele. La cantidad pivote más familiar es la estadística t de Student , que se puede derivar por este método y se utiliza en la secuela.

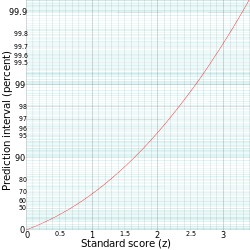

Un intervalo de predicción [ ℓ , u ] para una observación futura X en una distribución normal N ( μ , σ 2 ) con media y varianza conocidas se puede calcular a partir de

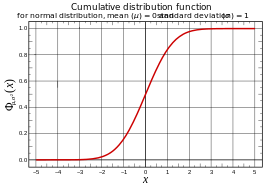

donde , la puntuación estándar de X , se distribuye como normal estándar.

Por eso

o

siendo z el cuartil en la distribución normal estándar para el cual:

o equivalentemente;

El intervalo de predicción se escribe convencionalmente como:

Por ejemplo, para calcular el intervalo de predicción del 95% para una distribución normal con una media ( μ ) de 5 y una desviación estándar ( σ ) de 1, entonces z es aproximadamente 2. Por lo tanto, el límite inferior del intervalo de predicción es aproximadamente 5 ‒ (2⋅1) = 3, y el límite superior es aproximadamente 5 + (2⋅1) = 7, dando así un intervalo de predicción de aproximadamente 3 a 7.

En el caso de una distribución con parámetros desconocidos, un enfoque directo para la predicción es estimar los parámetros y luego usar la función cuantil asociada; por ejemplo, se podría usar la media de la muestra como estimación para μ y la varianza de la muestra s 2 como estimación para σ 2 . Aquí hay dos opciones naturales para s 2 : dividir por produce una estimación no sesgada, mientras que dividir por n produce el estimador de máxima verosimilitud , y se puede usar cualquiera de los dos. Luego se usa la función cuantil con estos parámetros estimados para dar un intervalo de predicción.

Este enfoque se puede utilizar, pero el intervalo resultante no tendrá la interpretación del muestreo repetido [4] : no es un intervalo de confianza predictivo.

Para la secuela, utilice la media muestral:

y la varianza de la muestra (imparcial):

Dado [5] una distribución normal con media desconocida μ pero varianza conocida 1, la media de la muestra de las observaciones tiene distribución mientras que la observación futura tiene distribución. Tomando la diferencia de estos se cancela el μ y se obtiene una distribución normal de varianza , por lo tanto

Al resolver para se obtiene la distribución de predicción a partir de la cual se pueden calcular intervalos como antes. Este es un intervalo de confianza predictivo en el sentido de que si se utiliza un rango de cuantiles del 100 p %, entonces, en aplicaciones repetidas de este cálculo, la observación futura caerá en el intervalo predicho el 100 p % del tiempo.

Tenga en cuenta que esta distribución de predicción es más conservadora que la que utiliza la media estimada y la varianza conocida 1, ya que utiliza la varianza , por lo que produce intervalos más amplios. Esto es necesario para que se cumpla la propiedad de intervalo de confianza deseada.

Por el contrario, dada una distribución normal con media conocida 0 pero varianza desconocida , la varianza muestral de las observaciones tiene, hasta la escala, una distribución ; más precisamente:

mientras que la observación futura tiene distribución Tomando la relación entre la observación futura y la desviación estándar de la muestra [ aclaración necesaria ] se cancela σ, obteniéndose una distribución t de Student con n – 1 grados de libertad :

Al resolver se obtiene la distribución de predicción a partir de la cual se pueden calcular intervalos como antes.

Tenga en cuenta que esta distribución de predicción es más conservadora que el uso de una distribución normal con la desviación estándar estimada y una media conocida de 0, ya que utiliza la distribución t en lugar de la distribución normal, por lo que produce intervalos más amplios. Esto es necesario para que se cumpla la propiedad de intervalo de confianza deseada.

Combinando lo anterior para una distribución normal con μ y σ 2 desconocidos se obtiene la siguiente estadística auxiliar: [6]

Esta simple combinación es posible porque la media de la muestra y la varianza de la muestra de la distribución normal son estadísticas independientes; esto sólo es cierto para la distribución normal y, de hecho, caracteriza a la distribución normal.

Resolviendo se obtiene la distribución de predicción

La probabilidad de caer en un intervalo dado es entonces:

donde T a es el percentil 100((1 − p )/2) de la distribución t de Student con n − 1 grados de libertad. Por lo tanto, los números

son los puntos finales de un intervalo de predicción del 100(1 − p )% para .

Se pueden calcular intervalos de predicción sin ninguna suposición sobre la población, es decir, de forma no paramétrica .

El método bootstrap residual se puede utilizar para construir intervalos de predicción no paramétricos.

En general, el método de predicción conforme es más general. Veamos el caso especial de usar el mínimo y el máximo como límites para un intervalo de predicción: si uno tiene una muestra de variables aleatorias idénticas { X 1 , ..., X n }, entonces la probabilidad de que la siguiente observación X n +1 sea la más grande es 1/( n + 1), ya que todas las observaciones tienen la misma probabilidad de ser la máxima. De la misma manera, la probabilidad de que X n +1 sea la más pequeña es 1/( n + 1). La otra ( n − 1)/( n + 1) de las veces, X n +1 cae entre el máximo y el mínimo de la muestra { X 1 , ..., X n }. Por lo tanto, denotando el máximo y el mínimo de la muestra por M y m, esto produce un intervalo de predicción ( n − 1)/( n + 1) de [ m , M ].

Obsérvese que, si bien esto da la probabilidad de que una observación futura caiga en un rango, no da ninguna estimación de en qué parte de un segmento caerá; en particular, si cae fuera del rango de valores observados, puede estar muy fuera del rango. Véase la teoría del valor extremo para una discusión más detallada. Formalmente, esto se aplica no solo al muestreo de una población, sino a cualquier secuencia intercambiable de variables aleatorias, no necesariamente independientes o distribuidas de manera idéntica .

En la fórmula del intervalo de confianza predictivo no se hace mención de los parámetros no observables μ y σ de la media y la desviación estándar de la población: se utilizan las estadísticas de muestra observadas y la media y la desviación estándar de la muestra, y lo que se estima es el resultado de muestras futuras .

Al considerar los intervalos de predicción, en lugar de utilizar estadísticas de muestra como estimadores de parámetros de población y aplicar intervalos de confianza a estas estimaciones, se considera "la siguiente muestra" como una estadística en sí misma y se calcula su distribución de muestreo .

En los intervalos de confianza de parámetros, se estiman los parámetros de la población; si se desea interpretar esto como una predicción de la siguiente muestra, se modela "la siguiente muestra" como una extracción de esta población estimada, utilizando la distribución de población (estimada) . Por el contrario, en los intervalos de confianza predictivos, se utiliza la distribución de muestreo de (una estadística de) una muestra de n o n + 1 observaciones de dicha población, y la distribución de población no se utiliza directamente, aunque se utiliza el supuesto sobre su forma (aunque no los valores de sus parámetros) al calcular la distribución de muestreo.

Una aplicación común de los intervalos de predicción es el análisis de regresión . Supongamos que los datos se modelan mediante una línea recta ( regresión lineal simple ):

donde es la variable de respuesta , es la variable explicativa , ε i es un término de error aleatorio, y y son parámetros.

Dadas las estimaciones y para los parámetros, como por ejemplo de un mínimo cuadrado ordinario , el valor de respuesta previsto y d para un valor explicativo dado x d es

(el punto en la línea de regresión), mientras que la respuesta real sería

La estimación puntual se denomina respuesta media y es una estimación del valor esperado de y d ,

Un intervalo de predicción, en cambio, proporciona un intervalo en el que se espera que y d caiga; esto no es necesario si se conocen los parámetros reales α y β (junto con el término de error ε i ), pero si se está estimando a partir de una muestra , entonces se puede utilizar el error estándar de las estimaciones para la intersección y la pendiente ( y ), así como su correlación, para calcular un intervalo de predicción.

En regresión, Faraway (2002, p. 39) hace una distinción entre intervalos para predicciones de la respuesta media y para predicciones de la respuesta observada, lo que afecta esencialmente la inclusión o no del término unitario dentro de la raíz cuadrada en los factores de expansión anteriores; para más detalles, véase Faraway (2002).

Seymour Geisser , un defensor de la inferencia predictiva, ofrece aplicaciones predictivas de las estadísticas bayesianas . [7]

En las estadísticas bayesianas, se pueden calcular intervalos de predicción (bayesianos) a partir de la probabilidad posterior de la variable aleatoria, como un intervalo creíble . En el trabajo teórico, los intervalos creíbles no se calculan a menudo para la predicción de eventos futuros, sino para la inferencia de parámetros, es decir, intervalos creíbles de un parámetro, no para los resultados de la variable en sí. Sin embargo, en particular cuando las aplicaciones se refieren a posibles valores extremos de casos aún por observar, los intervalos creíbles para tales valores pueden ser de importancia práctica.

Los intervalos de predicción se utilizan comúnmente como definiciones de rangos de referencia , como los rangos de referencia para análisis de sangre, para dar una idea de si un análisis de sangre es normal o no. Para este propósito, el intervalo de predicción más comúnmente utilizado es el intervalo de predicción del 95%, y un rango de referencia basado en él puede denominarse rango de referencia estándar .