La exactitud y la precisión son dos medidas del error de observación . La exactitud es lo cerca que está un conjunto determinado de mediciones ( observaciones o lecturas) de su valor verdadero . La precisión es lo cerca que están las mediciones entre sí.

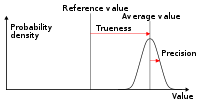

La Organización Internacional de Normalización (ISO) define una medida relacionada: [1] veracidad , "la proximidad de la concordancia entre la media aritmética de un gran número de resultados de pruebas y el valor de referencia verdadero o aceptado".

Mientras que la precisión es una descripción de errores aleatorios (una medida de variabilidad estadística ), la exactitud tiene dos definiciones diferentes:

En términos más simples, dada una muestra estadística o un conjunto de puntos de datos de mediciones repetidas de la misma cantidad, se puede decir que la muestra o el conjunto es preciso si su promedio está cerca del valor real de la cantidad que se está midiendo, mientras que se puede decir que el conjunto es preciso si su desviación estándar es relativamente pequeña.

En los campos de la ciencia y la ingeniería , la precisión de un sistema de medición es el grado de proximidad de las mediciones de una cantidad al valor verdadero de esa cantidad . [3] La precisión de un sistema de medición, relacionada con la reproducibilidad y repetibilidad , es el grado en el que mediciones repetidas en condiciones inalteradas muestran los mismos resultados . [3] [4] Aunque las dos palabras precisión y exactitud pueden ser sinónimas en el uso coloquial , se contrastan deliberadamente en el contexto del método científico .

El campo de la estadística , donde la interpretación de las mediciones juega un papel central, prefiere utilizar los términos sesgo y variabilidad en lugar de exactitud y precisión: el sesgo es la cantidad de inexactitud y la variabilidad es la cantidad de imprecisión.

Un sistema de medición puede ser exacto pero no preciso, preciso pero no exacto, ni lo uno ni lo otro, o ambos. Por ejemplo, si un experimento contiene un error sistemático , entonces aumentar el tamaño de la muestra generalmente aumenta la precisión pero no mejora la exactitud. El resultado sería una cadena consistente pero inexacta de resultados del experimento defectuoso. Eliminar el error sistemático mejora la exactitud pero no cambia la precisión.

Un sistema de medición se considera válido si es preciso y exacto . Los términos relacionados incluyen sesgo ( efectos no aleatorios o dirigidos causados por un factor o factores no relacionados con la variable independiente ) y error (variabilidad aleatoria).

La terminología también se aplica a mediciones indirectas, es decir, valores obtenidos mediante un procedimiento computacional a partir de datos observados.

Además de la precisión y exactitud, las mediciones también pueden tener una resolución de medición , que es el cambio más pequeño en la cantidad física subyacente que produce una respuesta en la medición.

En el análisis numérico , la exactitud también es la proximidad de un cálculo al valor verdadero; mientras que la precisión es la resolución de la representación, normalmente definida por el número de dígitos decimales o binarios.

En términos militares, la precisión se refiere principalmente a la exactitud del fuego ( justesse de tir ), la precisión del fuego expresada por la proximidad de un grupo de disparos al centro del objetivo y sus alrededores. [5]

Un cambio en el significado de estos términos apareció con la publicación de la serie de normas ISO 5725 en 1994, que también se refleja en la edición de 2008 del Vocabulario Internacional de Metrología (VIM) del BIPM, ítems 2.13 y 2.14. [3]

Según la norma ISO 5725-1, [1] el término general "exactitud" se utiliza para describir la proximidad de una medición al valor verdadero. Cuando el término se aplica a conjuntos de mediciones del mismo mensurando , implica un componente de error aleatorio y un componente de error sistemático. En este caso, la veracidad es la proximidad de la media de un conjunto de resultados de medición al valor real (verdadero), es decir, el error sistemático, y la precisión es la proximidad de la concordancia entre un conjunto de resultados, es decir, el error aleatorio.

La ISO 5725-1 y VIM también evitan el uso del término " sesgo ", previamente especificado en la BS 5497-1, [6] porque tiene connotaciones diferentes fuera de los campos de la ciencia y la ingeniería, como en la medicina y el derecho.

En instrumentación industrial, la precisión es la tolerancia de medición, o transmisión del instrumento, y define los límites de los errores cometidos cuando el instrumento se utiliza en condiciones normales de funcionamiento. [7]

Lo ideal es que un dispositivo de medición sea preciso y exacto, con mediciones cercanas y agrupadas estrechamente en torno al valor real. La exactitud y precisión de un proceso de medición se suele establecer midiendo repetidamente algún patrón de referencia trazable . Dichos patrones se definen en el Sistema Internacional de Unidades (SI, abreviado del francés: Système international d'unités ) y son mantenidos por organizaciones nacionales de normalización como el Instituto Nacional de Normas y Tecnología de los Estados Unidos.

Esto también se aplica cuando las mediciones se repiten y se promedian. En ese caso, el término error estándar se aplica correctamente: la precisión del promedio es igual a la desviación estándar conocida del proceso dividida por la raíz cuadrada del número de mediciones promediadas. Además, el teorema del límite central muestra que la distribución de probabilidad de las mediciones promediadas será más cercana a una distribución normal que la de las mediciones individuales.

En cuanto a la precisión podemos distinguir:

Una convención común en ciencia e ingeniería es expresar la exactitud y/o precisión implícitamente por medio de cifras significativas . Cuando no se indique explícitamente, se entiende que el margen de error es la mitad del valor del último lugar significativo. Por ejemplo, un registro de 843,6 m, o 843,0 m, o 800,0 m implicaría un margen de 0,05 m (el último lugar significativo es el lugar de las décimas), mientras que un registro de 843 m implicaría un margen de error de 0,5 m (los últimos dígitos significativos son las unidades).

Una lectura de 8000 m, con ceros finales y sin punto decimal, es ambigua; los ceros finales pueden o no ser cifras significativas. Para evitar esta ambigüedad, el número podría representarse en notación científica: 8,0 × 10 3 m indica que el primer cero es significativo (de ahí un margen de 50 m), mientras que 8,000 × 10 3 m indica que los tres ceros son significativos, lo que da un margen de 0,5 m. De manera similar, se puede utilizar un múltiplo de la unidad de medida básica: 8,0 km es equivalente a 8,0 × 10 3 m. Indica un margen de 0,05 km (50 m). Sin embargo, confiar en esta convención puede conducir a errores de precisión falsos al aceptar datos de fuentes que no la obedecen. Por ejemplo, una fuente que informa un número como 153 753 con una precisión de +/- 5000 parece que tiene una precisión de +/- 0,5. Según la convención, la cifra se habría redondeado a 150.000.

Alternativamente, en un contexto científico, si se desea indicar el margen de error con más precisión, se puede utilizar una notación como 7,54398(23) × 10 −10 m, lo que significa un rango de entre 7,54375 y 7,54421 × 10 −10 m.

La precisión incluye:

En ingeniería, la precisión se suele tomar como tres veces la desviación estándar de las mediciones tomadas, lo que representa el rango en el que pueden ocurrir el 99,73 % de las mediciones. [8] Por ejemplo, un ergonomista que mide el cuerpo humano puede estar seguro de que el 99,73 % de sus mediciones extraídas caen dentro de ± 0,7 cm (si utiliza el sistema de procesamiento GRYPHON) o ± 13 cm (si utiliza datos sin procesar). [9]

La precisión también se utiliza como una medida estadística de qué tan bien una prueba de clasificación binaria identifica o excluye correctamente una condición. Es decir, la precisión es la proporción de predicciones correctas (tanto verdaderos positivos como verdaderos negativos ) entre el número total de casos examinados. [10] Como tal, compara estimaciones de probabilidad previa y posterior a la prueba . Para aclarar el contexto mediante la semántica, a menudo se la denomina "precisión de Rand" o " índice de Rand ". [11] [12] [13] Es un parámetro de la prueba. La fórmula para cuantificar la precisión binaria es: donde TP = Verdadero positivo ; FP = Falso positivo ; TN = Verdadero negativo ; FN = Falso negativo

En este contexto, los conceptos de veracidad y precisión definidos en la norma ISO 5725-1 no son aplicables. Una de las razones es que no existe un único “valor verdadero” de una cantidad, sino dos posibles valores verdaderos para cada caso, mientras que la exactitud es un promedio de todos los casos y, por lo tanto, tiene en cuenta ambos valores. Sin embargo, el término precisión se utiliza en este contexto para referirse a una métrica diferente que se origina en el campo de la recuperación de información (véase más adelante).

Al calcular la precisión en la clasificación multiclase, la precisión es simplemente la fracción de clasificaciones correctas: [14] [15] Esto suele expresarse como un porcentaje. Por ejemplo, si un clasificador hace diez predicciones y nueve de ellas son correctas, la precisión es del 90%.

La precisión a veces también se considera una micrométrica , para subrayar que tiende a verse muy afectada por la prevalencia de clase particular en un conjunto de datos y los sesgos del clasificador. [14]

Además, también se denomina precisión top-1 para distinguirla de la precisión top-5, común en la evaluación de redes neuronales convolucionales . Para evaluar la precisión top-5, el clasificador debe proporcionar probabilidades relativas para cada clase. Cuando se ordenan, una clasificación se considera correcta si la clasificación correcta cae en cualquier lugar dentro de las 5 predicciones principales realizadas por la red. La precisión top-5 se popularizó por el desafío ImageNet . Por lo general, es más alta que la precisión top-1, ya que cualquier predicción correcta en las posiciones 2 a 5 no mejorará la puntuación top-1, pero sí mejorará la puntuación top-5.

En psicometría y psicofísica , el término exactitud se utiliza indistintamente con validez y error constante . Precisión es sinónimo de confiabilidad y error variable . La validez de un instrumento de medición o prueba psicológica se establece a través de experimentos o correlación con el comportamiento. La confiabilidad se establece con una variedad de técnicas estadísticas, clásicamente a través de una prueba de consistencia interna como el alfa de Cronbach para asegurar que los conjuntos de preguntas relacionadas tengan respuestas relacionadas, y luego la comparación de esas preguntas relacionadas entre la población de referencia y la población objetivo. [ cita requerida ]

En la simulación lógica , un error común en la evaluación de modelos precisos es comparar un modelo de simulación lógica con un modelo de simulación de circuito de transistores . Se trata de una comparación de diferencias en precisión, no en exactitud. La precisión se mide con respecto al detalle y la exactitud se mide con respecto a la realidad. [16] [17]

Los sistemas de recuperación de información, como las bases de datos y los motores de búsqueda web , se evalúan mediante muchas métricas diferentes , algunas de las cuales se derivan de la matriz de confusión , que divide los resultados en verdaderos positivos (documentos recuperados correctamente), verdaderos negativos (documentos no recuperados correctamente), falsos positivos (documentos recuperados incorrectamente) y falsos negativos (documentos no recuperados incorrectamente). Las métricas comúnmente utilizadas incluyen las nociones de precisión y recuperación . En este contexto, la precisión se define como la fracción de documentos recuperados correctamente en comparación con los documentos recuperados (verdaderos positivos divididos por verdaderos positivos más falsos positivos), utilizando un conjunto de resultados relevantes de verdad fundamental seleccionados por humanos. La recuperación se define como la fracción de documentos recuperados correctamente en comparación con los documentos relevantes (verdaderos positivos divididos por verdaderos positivos más falsos negativos). Con menos frecuencia, se utiliza la métrica de precisión, que se define como la fracción de documentos clasificados correctamente en comparación con los documentos (verdaderos positivos más verdaderos negativos divididos por verdaderos positivos más verdaderos negativos más falsos positivos más falsos negativos).

Ninguna de estas métricas tiene en cuenta la clasificación de los resultados. La clasificación es muy importante para los motores de búsqueda web porque los lectores rara vez pasan de la primera página de resultados y hay demasiados documentos en la web para clasificarlos manualmente todos para determinar si deben incluirse o excluirse de una búsqueda determinada. Añadir un límite en un número determinado de resultados tiene en cuenta la clasificación hasta cierto punto. La medida de precisión en k , por ejemplo, es una medida de precisión que solo tiene en cuenta los diez primeros resultados de búsqueda (k=10). Métricas más sofisticadas, como la ganancia acumulada descontada , tienen en cuenta cada clasificación individual y se utilizan con más frecuencia cuando esto es importante.

En los sistemas cognitivos, la exactitud y precisión se utilizan para caracterizar y medir los resultados de un proceso cognitivo realizado por entidades biológicas o artificiales, donde un proceso cognitivo es una transformación de datos, información, conocimiento o sabiduría a una forma de mayor valor. ( Pirámide DIKW ) A veces, un proceso cognitivo produce exactamente el resultado previsto o deseado, pero a veces produce un resultado muy alejado del previsto o deseado. Además, las repeticiones de un proceso cognitivo no siempre producen el mismo resultado. La exactitud cognitiva (C A ) es la propensión de un proceso cognitivo a producir el resultado previsto o deseado. La precisión cognitiva (C P ) es la propensión de un proceso cognitivo a producir el mismo resultado. [18] [19] [20] Para medir la cognición aumentada en conjuntos humanos/cog, donde uno o más humanos trabajan en colaboración con uno o más sistemas cognitivos (cogs), los aumentos en la exactitud cognitiva y la precisión cognitiva ayudan a medir el grado de aumento cognitivo .

{{cite web}}: CS1 maint: copia archivada como título ( enlace )