En el reconocimiento de patrones , la recuperación de información , la detección y clasificación de objetos (aprendizaje automático) , la precisión y la recuperación son métricas de rendimiento que se aplican a los datos recuperados de una colección , corpus o espacio muestral .

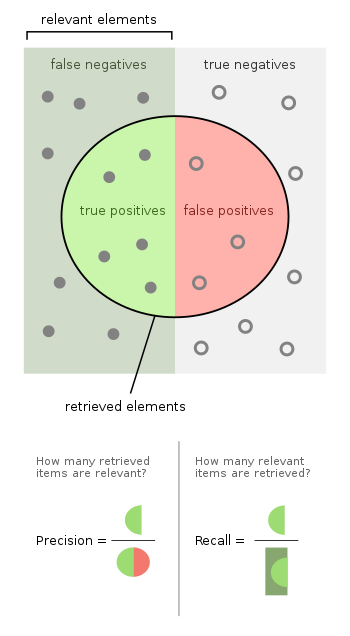

La precisión (también llamada valor predictivo positivo ) es la fracción de instancias relevantes entre las instancias recuperadas. Escrito como una fórmula:

La recuperación (también conocida como sensibilidad ) es la fracción de instancias relevantes que se recuperaron. Escrito como una fórmula:

Por lo tanto, tanto la precisión como la recuperación se basan en la relevancia .

Consideremos un programa informático para reconocer perros (el elemento relevante ) en una fotografía digital. Al procesar una imagen que contiene diez gatos y doce perros, el programa identifica ocho perros. De los ocho elementos identificados como perros, sólo cinco son realmente perros (verdaderos positivos), mientras que los otros tres son gatos (falsos positivos). Se omitieron siete perros (falsos negativos) y siete gatos se excluyeron correctamente (verdaderos negativos). La precisión del programa es entonces 5/8 (verdaderos positivos/elementos seleccionados) mientras que su recuperación es 5/12 (verdaderos positivos/elementos relevantes).

Adoptar un enfoque de prueba de hipótesis a partir de la estadística, en el que, en este caso, la hipótesis nula es que un elemento determinado es irrelevante (es decir, no un perro), ausencia de errores de tipo I y tipo II (es decir, especificidad y sensibilidad perfectas de 100% cada uno) corresponde respectivamente a una precisión perfecta (sin falsos positivos) y una recuperación perfecta (sin falsos negativos).

De manera más general, la recuperación es simplemente el complemento de la tasa de error de tipo II (es decir, uno menos la tasa de error de tipo II). La precisión está relacionada con la tasa de error tipo I, pero de una manera un poco más complicada, ya que también depende de la distribución previa de ver un elemento relevante frente a uno irrelevante.

El ejemplo anterior de gatos y perros contenía 8 − 5 = 3 errores de tipo I (falsos positivos) de un total de 10 gatos (verdaderos negativos), para una tasa de error de tipo I de 3/10, y 12 − 5 = 7 errores de tipo II ( falsos negativos), para una tasa de error tipo II de 7/12. La precisión puede verse como una medida de calidad y la recuperación como una medida de cantidad. Una mayor precisión significa que un algoritmo devuelve resultados más relevantes que los irrelevantes, y una alta recuperación significa que un algoritmo devuelve la mayoría de los resultados relevantes (también se devuelven los irrelevantes o no).

En una tarea de clasificación , la precisión de una clase es el número de verdaderos positivos (es decir, el número de elementos correctamente etiquetados como pertenecientes a la clase positiva) dividido por el número total de elementos etiquetados como pertenecientes a la clase positiva (es decir, la suma de verdaderos positivos y falsos positivos , que son elementos incorrectamente etiquetados como pertenecientes a la clase). La recuperación en este contexto se define como el número de verdaderos positivos dividido por el número total de elementos que realmente pertenecen a la clase positiva (es decir, la suma de verdaderos positivos y falsos negativos , que son elementos que no fueron etiquetados como pertenecientes a la clase positiva). pero debería haber sido).

La precisión y la recuperación no son métricas particularmente útiles cuando se usan de forma aislada. Por ejemplo, es posible tener una recuperación perfecta simplemente recuperando cada elemento. Asimismo, es posible obtener una precisión casi perfecta seleccionando sólo un número muy pequeño de elementos extremadamente probables.

En una tarea de clasificación, una puntuación de precisión de 1,0 para una clase C significa que cada elemento etiquetado como perteneciente a la clase C pertenece de hecho a la clase C (pero no dice nada sobre el número de elementos de la clase C que no fueron etiquetados correctamente), mientras que una El recuerdo de 1.0 significa que cada elemento de la clase C fue etiquetado como perteneciente a la clase C (pero no dice nada sobre cuántos elementos de otras clases también fueron etiquetados incorrectamente como pertenecientes a la clase C).

A menudo, existe una relación inversa entre precisión y recuperación, donde es posible aumentar una a costa de reducir la otra. La cirugía cerebral proporciona un ejemplo ilustrativo de esta compensación. Considere un neurocirujano que extirpa un tumor canceroso del cerebro de un paciente. El cirujano debe extirpar todas las células tumorales, ya que las células cancerosas restantes regenerarán el tumor. Por el contrario, el cirujano no debe extirpar células cerebrales sanas, ya que eso dejaría al paciente con una función cerebral deteriorada. El cirujano puede ser más liberal en el área del cerebro que extirpa para asegurarse de haber extraído todas las células cancerosas. Esta decisión aumenta la recuperación pero reduce la precisión. Por otro lado, el cirujano puede ser más conservador en las células cerebrales que extrae para asegurarse de extraer sólo células cancerosas. Esta decisión aumenta la precisión pero reduce la recuperación. Es decir, una mayor recuperación aumenta las posibilidades de eliminar células sanas (resultado negativo) y aumenta las posibilidades de eliminar todas las células cancerosas (resultado positivo). Una mayor precisión disminuye las posibilidades de eliminar células sanas (resultado positivo), pero también disminuye las posibilidades de eliminar todas las células cancerosas (resultado negativo).

Por lo general, las puntuaciones de precisión y recuperación no se analizan de forma aislada. Una curva de recuperación de precisión traza la precisión en función de la recuperación; Por lo general, la precisión disminuirá a medida que aumente la recuperación. Alternativamente, los valores de una medida se pueden comparar para un nivel fijo en la otra medida (por ejemplo, precisión en un nivel de recuperación de 0,75 ) o se combinan ambas en una sola medida. Ejemplos de medidas que son una combinación de precisión y recuperación son la medida F (la media armónica ponderada de precisión y recuperación), o el coeficiente de correlación de Matthews , que es una media geométrica de las variantes corregidas por azar: los coeficientes de regresión Información ( DeltaP') y Marcado (DeltaP). [1] [2] La precisión es una media aritmética ponderada de precisión y precisión inversa (ponderada por sesgo), así como una media aritmética ponderada de recuperación y recuperación inversa (ponderada por prevalencia). [1] La precisión inversa y la recuperación inversa son simplemente la precisión y la recuperación del problema inverso donde se intercambian etiquetas positivas y negativas (tanto para clases reales como para etiquetas de predicción). La tasa de verdaderos positivos y la tasa de falsos positivos , o equivalentemente la recuperación y la recuperación inversa 1, se trazan con frecuencia entre sí como curvas ROC y proporcionan un mecanismo basado en principios para explorar las compensaciones de los puntos operativos. Fuera de la recuperación de información, se argumenta que la aplicación de recuperación, precisión y medida F es defectuosa ya que ignoran la celda negativa verdadera de la tabla de contingencia y se manipulan fácilmente sesgando las predicciones. [1] El primer problema se "resuelve" usando Precisión y el segundo problema se "resuelve" descontando el componente de probabilidad y renormalizando al kappa de Cohen , pero esto ya no brinda la oportunidad de explorar las compensaciones gráficamente. Sin embargo, la información y la marcación son renormalizaciones similares a Kappa de la recuperación y la precisión, [3] y su coeficiente de correlación de Matthews medio geométrico actúa, por lo tanto, como una medida F desesgada.

Para las tareas de clasificación, los términos verdaderos positivos , verdaderos negativos , falsos positivos y falsos negativos (consulte las definiciones de errores de tipo I y tipo II ) comparan los resultados del clasificador bajo prueba con juicios externos confiables. Los términos positivo y negativo se refieren a la predicción del clasificador (a veces conocida como expectativa ), y los términos verdadero y falso se refieren a si esa predicción corresponde al juicio externo (a veces conocido como observación ) .

Definamos un experimento a partir de P casos positivos y N casos negativos para alguna condición. Los cuatro resultados se pueden formular en una tabla de contingencia o matriz de confusión de 2×2 , de la siguiente manera:

La precisión y la recuperación se definen entonces como: [13]

El recuerdo en este contexto también se conoce como tasa o sensibilidad positiva verdadera , y la precisión también se conoce como valor predictivo positivo (VPP); otras medidas relacionadas utilizadas en la clasificación incluyen la tasa de verdaderos negativos y la precisión . [13] La tasa de verdaderos negativos también se denomina especificidad .

Tanto la precisión como la recuperación pueden resultar útiles en los casos en que hay datos desequilibrados. Sin embargo, puede resultar valioso priorizar uno sobre el otro en los casos en que el resultado de un falso positivo o falso negativo sea costoso. Por ejemplo, en el diagnóstico médico, una prueba falsa positiva puede generar tratamientos y gastos innecesarios. En esta situación, es útil valorar la precisión sobre la recuperación. En otros casos, el coste de un falso negativo es elevado. Por ejemplo, el coste de un falso negativo en la detección de fraude es elevado, ya que no detectar una transacción fraudulenta puede provocar pérdidas financieras importantes. [14]

La precisión y la recuperación pueden interpretarse como probabilidades condicionales (estimadas) : [15] La precisión viene dada por mientras que la recuperación está dada por , [16] donde es la clase predicha y es la clase real (es decir, significa que la clase real es positiva). Por tanto, ambas cantidades están relacionadas por el teorema de Bayes .

La interpretación probabilística permite derivar fácilmente cómo se comportaría un clasificador sin habilidades. Un clasificador sin habilidad se define por la propiedad de que la probabilidad condicional es solo el producto de las probabilidades incondicionales ya que la clasificación y la presencia de la clase son independientes .

Por ejemplo, la precisión de un clasificador sin habilidades es simplemente una constante, es decir, determinada por la probabilidad/frecuencia con la que ocurre la clase P.

Se puede presentar un argumento similar para el retiro: que es justamente la probabilidad (típicamente dependiente del umbral) de una clasificación positiva.

Algunos clasificadores muy específicos sin habilidades se implementan en sklearn y allí se denominan clasificadores ficticios. [17]

La precisión puede ser una métrica engañosa para conjuntos de datos desequilibrados. Considere una muestra con 95 valores negativos y 5 positivos. Clasificar todos los valores como negativos en este caso da una puntuación de precisión de 0,95. Hay muchas métricas que no sufren este problema. Por ejemplo, la precisión equilibrada [18] (bACC) normaliza las predicciones verdaderas positivas y verdaderas negativas por el número de muestras positivas y negativas, respectivamente, y divide su suma por dos:

Para el ejemplo anterior (95 muestras negativas y 5 positivas), clasificar todas como negativas da una puntuación de precisión equilibrada de 0,5 (la puntuación bACC máxima es uno), que equivale al valor esperado de una suposición aleatoria en un conjunto de datos equilibrado. La precisión equilibrada puede servir como una métrica de rendimiento general para un modelo, independientemente de si las etiquetas verdaderas están desequilibradas en los datos, suponiendo que el costo de FN es el mismo que el de FP.

El TPR y el FPR son una propiedad de un clasificador determinado que opera en un umbral específico. Sin embargo, el número total de TP, FP, etc. depende del desequilibrio de clases en los datos a través de la proporción de clases . Como el retiro (o TPR) depende solo de casos positivos, no se ve afectado por , pero sí la precisión. tenemos eso

Por tanto, la precisión tiene una dependencia explícita de . [19] Comenzando con clases balanceadas en y disminuyendo gradualmente , la precisión correspondiente disminuirá, porque el denominador aumenta.

Otra métrica es la tasa prevista de condiciones positivas (PPCR), que identifica el porcentaje de la población total que está marcada. Por ejemplo, para un motor de búsqueda que arroja 30 resultados (documentos recuperados) de 1.000.000 de documentos, el PPCR es del 0,003%.

Según Saito y Rehmsmeier, los gráficos de recuperación de precisión son más informativos que los gráficos ROC cuando se evalúan clasificadores binarios en datos desequilibrados. En tales escenarios, los gráficos ROC pueden ser visualmente engañosos con respecto a las conclusiones sobre la confiabilidad del desempeño de la clasificación. [20]

A diferencia de los enfoques anteriores, si se aplica una escala de desequilibrio directamente ponderando los elementos de la matriz de confusión, las definiciones de métricas estándar aún se aplican incluso en el caso de conjuntos de datos desequilibrados. [21] El procedimiento de ponderación relaciona los elementos de la matriz de confusión con el conjunto de soporte de cada clase considerada.

Una medida que combina precisión y recuperación es la media armónica de precisión y recuperación, la medida F tradicional o puntuación F equilibrada:

Esta medida es aproximadamente el promedio de las dos cuando están próximas, y de manera más general es la media armónica , que, para el caso de dos números, coincide con el cuadrado de la media geométrica dividido por la media aritmética . Hay varias razones por las que el puntaje F puede ser criticado, en circunstancias particulares, debido a su sesgo como métrica de evaluación. [1] Esto también se conoce como medida, porque la recuperación y la precisión se ponderan de manera uniforme.

Es un caso especial de la medida general (para valores reales no negativos de ):

Otras dos medidas comúnmente utilizadas son la medida, cuyo peso recuerda más que la precisión, y la medida, que pone más énfasis en la precisión que en el recuerdo.

La medida F fue derivada por van Rijsbergen (1979) de modo que "mide la eficacia de la recuperación con respecto a un usuario que concede tanta importancia al recuerdo como a la precisión". Se basa en la medida de efectividad de van Rijsbergen , siendo el segundo término la media armónica ponderada de precisión y recuperación con pesos . Su relación es donde .

Existen otros parámetros y estrategias para la métrica de rendimiento del sistema de recuperación de información, como el área bajo la curva ROC (AUC) [22] o pseudo-R-cuadrado .