En la visión artificial , el reconocimiento de objetos en 3D implica reconocer y determinar información en 3D, como la pose , el volumen o la forma, de objetos en 3D elegidos por el usuario en una fotografía o un escaneo de rango . Normalmente, se presenta un ejemplo del objeto que se va a reconocer a un sistema de visión en un entorno controlado y, luego, para una entrada arbitraria, como una transmisión de video , el sistema ubica el objeto presentado anteriormente. Esto se puede hacer fuera de línea o en tiempo real . Los algoritmos para resolver este problema están especializados en la ubicación de un solo objeto identificado previamente y se pueden contrastar con algoritmos que operan en clases generales de objetos, como sistemas de reconocimiento facial o reconocimiento de objetos genéricos en 3D. Debido al bajo costo y la facilidad de adquisición de fotografías, se ha dedicado una cantidad significativa de investigación al reconocimiento de objetos en 3D en fotografías.

El método de reconocimiento de un objeto 3D depende de las propiedades de un objeto. Para simplificar, muchos algoritmos existentes se han centrado en reconocer objetos rígidos que constan de una sola parte, es decir, objetos cuya transformación espacial es un movimiento euclidiano . Se han adoptado dos enfoques generales para abordar el problema: los enfoques de reconocimiento de patrones utilizan información de apariencia de imagen de bajo nivel para localizar un objeto, mientras que los enfoques geométricos basados en características construyen un modelo para el objeto que se va a reconocer y hacen coincidir el modelo con la fotografía.

Estos métodos utilizan información sobre la apariencia obtenida a partir de proyecciones precapturadas o precalculadas de un objeto para hacer coincidir el objeto en la escena potencialmente desordenada. Sin embargo, no tienen en cuenta las restricciones geométricas 3D del objeto durante la comparación y, por lo general, tampoco manejan la oclusión tan bien como los enfoques basados en características. Consulte [Murase y Nayar 1995] y [Selinger y Nelson 1999].

Los enfoques basados en características funcionan bien para objetos que tienen características distintivas . Hasta ahora, se han reconocido con éxito objetos que tienen buenas características de borde o características de mancha ; por ejemplo, algoritmos de detección, consulte el detector de región afín de Harris y SIFT , respectivamente. Debido a la falta de detectores de características adecuados, los objetos sin superficies lisas y texturizadas no se pueden manejar actualmente con este enfoque.

Los reconocedores de objetos basados en características generalmente funcionan capturando previamente una serie de vistas fijas del objeto a reconocer, extrayendo características de estas vistas y luego, en el proceso de reconocimiento, haciendo coincidir estas características con la escena y aplicando restricciones geométricas.

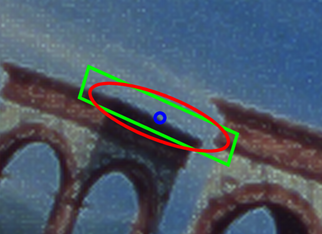

Como ejemplo de un sistema prototípico que adopta este enfoque, presentaremos un esquema del método utilizado por [Rothganger et al. 2004], con algunos detalles omitido. El método comienza suponiendo que los objetos sufren transformaciones rígidas globales. Debido a que las superficies lisas son localmente planas, las características invariantes afines son apropiadas para la comparación: el artículo detecta regiones de interés con forma de elipse utilizando características similares a bordes y a manchas y, como en [Lowe 2004], encuentra la dirección de gradiente dominante de la elipse, convierte la elipse en un paralelogramo y toma un descriptor SIFT en el paralelogramo resultante. La información de color también se utiliza para mejorar la discriminación sobre las características SIFT solas.

A continuación, dada una serie de vistas de cámara del objeto (24 en el artículo), el método construye un modelo 3D para el objeto, que contiene la posición espacial 3D y la orientación de cada característica. Debido a que la cantidad de vistas del objeto es grande, típicamente cada característica está presente en varias vistas adyacentes. Los puntos centrales de dichas características coincidentes se corresponden, y las características detectadas se alinean a lo largo de la dirección del gradiente dominante, por lo que los puntos en (1, 0) en el sistema de coordenadas local del paralelogramo de características también se corresponden, al igual que los puntos (0, 1) en las coordenadas locales del paralelogramo. Por lo tanto, para cada par de características coincidentes en vistas cercanas, se conocen tres correspondencias de pares de puntos. Dados al menos dos características coincidentes, se puede utilizar una estructura afín de múltiples vistas a partir del algoritmo de movimiento (ver [Tomasi y Kanade 1992]) para construir una estimación de las posiciones de los puntos (hasta una transformación afín arbitraria). El artículo de Rothganger et al. Por lo tanto, selecciona dos vistas adyacentes, utiliza un método similar a RANSAC para seleccionar dos pares de características correspondientes y agrega nuevas características al modelo parcial creado por RANSAC siempre que se encuentren bajo un término de error. Por lo tanto, para cualquier par de vistas adyacentes, el algoritmo crea un modelo parcial de todas las características visibles en ambas vistas.

Para producir un modelo unificado, el artículo toma el modelo parcial más grande y alinea de manera incremental todos los modelos parciales más pequeños con él. Se utiliza la minimización global para reducir el error y luego se utiliza una actualización euclidiana para cambiar las posiciones de las características del modelo de coordenadas 3D únicas hasta la transformación afín a coordenadas 3D que son únicas hasta el movimiento euclidiano . Al final de este paso, se tiene un modelo del objeto de destino, que consta de características proyectadas en un espacio 3D común.

Para reconocer un objeto en una imagen de entrada arbitraria, el artículo detecta características y luego utiliza RANSAC para encontrar la matriz de proyección afín que mejor se ajusta al modelo de objeto unificado para la escena 2D. Si este enfoque RANSAC tiene un error suficientemente bajo, entonces, en caso de éxito, el algoritmo reconoce el objeto y proporciona la pose del objeto en términos de una proyección afín. En las condiciones supuestas, el método normalmente logra tasas de reconocimiento de alrededor del 95%.