La inteligencia artificial ( IA ), en su sentido más amplio, es la inteligencia que exhiben las máquinas , en particular los sistemas informáticos . Es un campo de investigación en informática que desarrolla y estudia métodos y software que permiten a las máquinas percibir su entorno y utilizar el aprendizaje y la inteligencia para tomar acciones que maximicen sus posibilidades de alcanzar objetivos definidos. [1] Estas máquinas pueden denominarse IA.

Algunas aplicaciones de alto perfil de la IA incluyen motores de búsqueda web avanzados (por ejemplo, Google Search ); sistemas de recomendación (utilizados por YouTube , Amazon y Netflix ); interacción a través del habla humana (por ejemplo, Google Assistant , Siri y Alexa ); vehículos autónomos (por ejemplo, Waymo ); herramientas generativas y creativas (por ejemplo, ChatGPT y AI art ); y juego y análisis sobrehumanos en juegos de estrategia (por ejemplo, ajedrez y Go ). Sin embargo, muchas aplicaciones de IA no se perciben como IA: "Una gran cantidad de IA de vanguardia se ha filtrado en aplicaciones generales, a menudo sin llamarse IA porque una vez que algo se vuelve lo suficientemente útil y común, ya no se etiqueta como IA ". [2] [3]

Los diversos subcampos de la investigación de IA se centran en torno a objetivos particulares y al uso de herramientas particulares. Los objetivos tradicionales de la investigación de IA incluyen razonamiento , representación del conocimiento , planificación , aprendizaje , procesamiento del lenguaje natural , percepción y apoyo a la robótica . [a] La inteligencia general —la capacidad de completar cualquier tarea que pueda realizar un humano en un nivel al menos igual— se encuentra entre los objetivos a largo plazo del campo. [4] Para alcanzar estos objetivos, los investigadores de IA han adaptado e integrado una amplia gama de técnicas, incluidas la búsqueda y la optimización matemática , la lógica formal , las redes neuronales artificiales y los métodos basados en la estadística , la investigación de operaciones y la economía . [b] La IA también se basa en la psicología , la lingüística , la filosofía , la neurociencia y otros campos. [5]

La inteligencia artificial se fundó como disciplina académica en 1956, [6] y el campo pasó por múltiples ciclos de optimismo, [7] [8] seguidos de períodos de decepción y pérdida de financiación, conocidos como el invierno de la IA . [9] [10] La financiación y el interés aumentaron enormemente después de 2012, cuando el aprendizaje profundo superó las técnicas de IA anteriores. [11] Este crecimiento se aceleró aún más después de 2017 con la arquitectura del transformador , [12] y, a principios de la década de 2020, se estaban invirtiendo cientos de miles de millones de dólares en IA (conocido como el " auge de la IA "). El uso generalizado de la IA en el siglo XXI expuso varias consecuencias y daños no deseados en el presente y planteó preocupaciones sobre sus riesgos y efectos a largo plazo en el futuro, lo que provocó debates sobre políticas regulatorias para garantizar la seguridad y los beneficios de la tecnología .

El problema general de simular (o crear) inteligencia se ha dividido en subproblemas, que consisten en rasgos o capacidades particulares que los investigadores esperan que muestre un sistema inteligente. Los rasgos que se describen a continuación han recibido la mayor atención y cubren el alcance de la investigación en IA. [a]

Los primeros investigadores desarrollaron algoritmos que imitaban el razonamiento paso a paso que utilizan los humanos cuando resuelven acertijos o hacen deducciones lógicas . [13] A finales de los años 1980 y 1990, se desarrollaron métodos para tratar la información incierta o incompleta, empleando conceptos de probabilidad y economía . [14]

Muchos de estos algoritmos son insuficientes para resolver grandes problemas de razonamiento porque experimentan una "explosión combinatoria": se vuelven exponencialmente más lentos a medida que los problemas crecen. [15] Incluso los humanos rara vez utilizan la deducción paso a paso que las primeras investigaciones de IA podían modelar. Resuelven la mayoría de sus problemas utilizando juicios rápidos e intuitivos. [16] El razonamiento preciso y eficiente es un problema sin resolver.

La representación del conocimiento y la ingeniería del conocimiento [17] permiten que los programas de IA respondan preguntas de manera inteligente y realicen deducciones sobre hechos del mundo real. Las representaciones formales del conocimiento se utilizan en la indexación y recuperación basadas en contenido, [18] interpretación de escenas, [19] apoyo a la toma de decisiones clínicas, [20] descubrimiento de conocimiento (extracción de inferencias "interesantes" y procesables de grandes bases de datos ), [21] y otras áreas. [22]

Una base de conocimiento es un cuerpo de conocimiento representado en una forma que puede ser utilizada por un programa. Una ontología es el conjunto de objetos, relaciones, conceptos y propiedades utilizadas por un dominio particular de conocimiento. [23] Las bases de conocimiento necesitan representar cosas como objetos, propiedades, categorías y relaciones entre objetos; [24] situaciones, eventos, estados y tiempo; [25] causas y efectos; [26] conocimiento sobre el conocimiento (lo que sabemos sobre lo que saben otras personas); [27] razonamiento predeterminado (cosas que los humanos asumen como verdaderas hasta que se les dice lo contrario y seguirán siendo ciertas incluso cuando otros hechos cambien); [28] y muchos otros aspectos y dominios del conocimiento.

Entre los problemas más difíciles en la representación del conocimiento están la amplitud del conocimiento de sentido común (el conjunto de hechos atómicos que la persona promedio conoce es enorme); [29] y la forma subsimbólica de la mayor parte del conocimiento de sentido común (gran parte de lo que la gente sabe no se representa como "hechos" o "afirmaciones" que podrían expresar verbalmente). [16] También está la dificultad de la adquisición de conocimiento , el problema de obtener conocimiento para aplicaciones de IA. [c]

Un "agente" es cualquier cosa que percibe y realiza acciones en el mundo. Un agente racional tiene objetivos o preferencias y realiza acciones para que se cumplan. [d] [32] En la planificación automatizada , el agente tiene un objetivo específico. [33] En la toma de decisiones automatizada , el agente tiene preferencias: hay algunas situaciones en las que preferiría estar y otras situaciones que intenta evitar. El agente que toma las decisiones asigna un número a cada situación (llamado " utilidad ") que mide cuánto la prefiere el agente. Para cada acción posible, puede calcular la " utilidad esperada ": la utilidad de todos los resultados posibles de la acción, ponderada por la probabilidad de que ocurra el resultado. Luego puede elegir la acción con la máxima utilidad esperada. [34]

En la planificación clásica , el agente sabe exactamente cuál será el efecto de cualquier acción. [35] Sin embargo, en la mayoría de los problemas del mundo real, el agente puede no estar seguro de la situación en la que se encuentra (es "desconocida" o "inobservable") y puede no saber con certeza qué sucederá después de cada acción posible (no es "determinista"). Debe elegir una acción haciendo una suposición probabilística y luego reevaluar la situación para ver si la acción funcionó. [36]

En algunos problemas, las preferencias del agente pueden ser inciertas, especialmente si hay otros agentes o humanos involucrados. Estas pueden aprenderse (por ejemplo, con el aprendizaje de refuerzo inverso ), o el agente puede buscar información para mejorar sus preferencias. [37] La teoría del valor de la información se puede utilizar para sopesar el valor de las acciones exploratorias o experimentales. [38] El espacio de posibles acciones y situaciones futuras suele ser intratablemente grande, por lo que los agentes deben tomar acciones y evaluar situaciones sin estar seguros de cuál será el resultado.

Un proceso de decisión de Markov tiene un modelo de transición que describe la probabilidad de que una acción particular cambie el estado de una manera particular y una función de recompensa que proporciona la utilidad de cada estado y el costo de cada acción. Una política asocia una decisión con cada estado posible. La política puede ser calculada (por ejemplo, mediante iteración ), ser heurística o puede aprenderse. [39]

La teoría de juegos describe el comportamiento racional de múltiples agentes que interactúan y se utiliza en programas de IA que toman decisiones que involucran a otros agentes. [40]

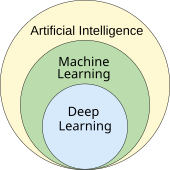

El aprendizaje automático es el estudio de programas que pueden mejorar su desempeño en una tarea determinada de manera automática. [41] Ha sido parte de la IA desde el principio. [e]

Existen varios tipos de aprendizaje automático. El aprendizaje no supervisado analiza un flujo de datos y encuentra patrones y realiza predicciones sin ninguna otra guía. [44] El aprendizaje supervisado requiere que un humano etiquete primero los datos de entrada y se presenta en dos variedades principales: clasificación (donde el programa debe aprender a predecir a qué categoría pertenece la entrada) y regresión (donde el programa debe deducir una función numérica en función de la entrada numérica). [45]

En el aprendizaje por refuerzo , el agente es recompensado por las buenas respuestas y castigado por las malas. El agente aprende a elegir respuestas que se clasifican como "buenas". [46] El aprendizaje por transferencia es cuando el conocimiento obtenido de un problema se aplica a un nuevo problema. [47] El aprendizaje profundo es un tipo de aprendizaje automático que ejecuta entradas a través de redes neuronales artificiales inspiradas biológicamente para todos estos tipos de aprendizaje. [48]

La teoría del aprendizaje computacional puede evaluar a los estudiantes por complejidad computacional , por complejidad de la muestra (cuántos datos se requieren) o por otras nociones de optimización . [49]

El procesamiento del lenguaje natural (PLN) [50] permite a los programas leer, escribir y comunicarse en idiomas humanos como el inglés . Los problemas específicos incluyen el reconocimiento de voz , la síntesis de voz , la traducción automática , la extracción de información , la recuperación de información y la respuesta a preguntas . [51]

Los primeros trabajos, basados en la gramática generativa y las redes semánticas de Noam Chomsky , tenían dificultades con la desambiguación del sentido de las palabras [f] a menos que se restringieran a pequeños dominios llamados " micromundos " (debido al problema del conocimiento del sentido común [29] ). Margaret Masterman creía que era el significado y no la gramática lo que era la clave para comprender los idiomas, y que los tesauros y no los diccionarios deberían ser la base de la estructura computacional del lenguaje.

Las técnicas modernas de aprendizaje profundo para PNL incluyen la incrustación de palabras (que representan palabras, generalmente como vectores que codifican su significado), [52] transformadores (una arquitectura de aprendizaje profundo que utiliza un mecanismo de atención ), [53] y otros. [54] En 2019, los modelos de lenguaje generativo preentrenado de transformadores (o "GPT") comenzaron a generar texto coherente, [55] [56] y para 2023, estos modelos pudieron obtener puntajes de nivel humano en el examen de la barra , el examen SAT , el examen GRE y muchas otras aplicaciones del mundo real. [57]

La percepción artificial es la capacidad de utilizar la información de los sensores (como cámaras, micrófonos, señales inalámbricas, lidar activo , sonar, radar y sensores táctiles ) para deducir aspectos del mundo. La visión artificial es la capacidad de analizar la información visual. [58]

El campo incluye reconocimiento de voz , [59] clasificación de imágenes , [60] reconocimiento facial , reconocimiento de objetos , [61] seguimiento de objetos , [62] y percepción robótica . [63]

La computación afectiva es un paraguas interdisciplinario que comprende sistemas que reconocen, interpretan, procesan o simulan sentimientos, emociones y estados de ánimo humanos . [65] Por ejemplo, algunos asistentes virtuales están programados para hablar de manera conversacional o incluso para bromear con humor; esto los hace parecer más sensibles a la dinámica emocional de la interacción humana o para facilitar de alguna otra manera la interacción entre humanos y computadoras .

Sin embargo, esto tiende a dar a los usuarios ingenuos una concepción poco realista de la inteligencia de los agentes informáticos existentes. [66] Los éxitos moderados relacionados con la computación afectiva incluyen el análisis de sentimientos textuales y, más recientemente, el análisis de sentimientos multimodales , en el que la IA clasifica los afectos mostrados por un sujeto grabado en video. [67]

Una máquina con inteligencia general artificial debería ser capaz de resolver una amplia variedad de problemas con una amplitud y versatilidad similar a la inteligencia humana . [4]

La investigación sobre IA utiliza una amplia variedad de técnicas para lograr los objetivos anteriores. [b]

La IA puede resolver muchos problemas buscando de forma inteligente entre muchas soluciones posibles. [68] Hay dos tipos de búsqueda muy diferentes que se utilizan en la IA: búsqueda en el espacio de estados y búsqueda local .

La búsqueda en el espacio de estados busca en un árbol de estados posibles para intentar encontrar un estado objetivo. [69] Por ejemplo, los algoritmos de planificación buscan en árboles de objetivos y subobjetivos, intentando encontrar un camino hacia un objetivo objetivo, un proceso llamado análisis de medios y fines . [70]

Las búsquedas exhaustivas simples [71] rara vez son suficientes para la mayoría de los problemas del mundo real: el espacio de búsqueda (la cantidad de lugares en los que buscar) crece rápidamente hasta alcanzar cifras astronómicas . El resultado es una búsqueda demasiado lenta o que nunca se completa. [15] Las " heurísticas " o "reglas generales" pueden ayudar a priorizar las opciones que tienen más probabilidades de alcanzar un objetivo. [72]

La búsqueda adversarial se utiliza en programas de juegos , como ajedrez o Go. Busca en un árbol de posibles movimientos y contramovimientos una posición ganadora. [73]

La búsqueda local utiliza la optimización matemática para encontrar una solución a un problema. Comienza con algún tipo de suposición y la va refinando de forma incremental. [74]

El descenso de gradiente es un tipo de búsqueda local que optimiza un conjunto de parámetros numéricos ajustándolos de forma incremental para minimizar una función de pérdida . Las variantes del descenso de gradiente se utilizan comúnmente para entrenar redes neuronales. [75]

Otro tipo de búsqueda local es la computación evolutiva , que tiene como objetivo mejorar iterativamente un conjunto de soluciones candidatas "mutándolas" y "recombinándolas", seleccionando sólo las más aptas para sobrevivir cada generación. [76]

Los procesos de búsqueda distribuida pueden coordinarse mediante algoritmos de inteligencia de enjambre . Dos algoritmos de enjambre populares utilizados en la búsqueda son la optimización de enjambre de partículas (inspirada en la bandada de pájaros ) y la optimización de colonias de hormigas (inspirada en los rastros de hormigas ). [77]

La lógica formal se utiliza para el razonamiento y la representación del conocimiento . [78] La lógica formal se presenta en dos formas principales: la lógica proposicional (que opera sobre afirmaciones que son verdaderas o falsas y utiliza conectores lógicos como "y", "o", "no" e "implica") [79] y la lógica de predicados (que también opera sobre objetos, predicados y relaciones y utiliza cuantificadores como " Cada X es una Y " y "Hay algunas X que son Y "). [80]

El razonamiento deductivo en lógica es el proceso de probar una nueva afirmación ( conclusión ) a partir de otras afirmaciones que se dan y se suponen verdaderas (las premisas ). [81] Las pruebas se pueden estructurar como árboles de prueba , en los que los nodos están etiquetados por oraciones y los nodos secundarios están conectados a los nodos primarios mediante reglas de inferencia .

Dado un problema y un conjunto de premisas, la resolución de problemas se reduce a la búsqueda de un árbol de pruebas cuyo nodo raíz esté etiquetado por una solución del problema y cuyos nodos hoja estén etiquetados por premisas o axiomas . En el caso de las cláusulas de Horn , la búsqueda de resolución de problemas se puede realizar razonando hacia adelante a partir de las premisas o hacia atrás a partir del problema. [82] En el caso más general de la forma clausal de la lógica de primer orden , la resolución es una regla de inferencia única, libre de axiomas, en la que un problema se resuelve probando una contradicción a partir de premisas que incluyen la negación del problema a resolver. [83]

La inferencia, tanto en la lógica de cláusulas de Horn como en la lógica de primer orden, es indecidible y, por lo tanto, intratable . Sin embargo, el razonamiento inverso con cláusulas de Horn, que sustenta el cálculo en el lenguaje de programación lógica Prolog , es Turing completo . Además, su eficiencia es competitiva con el cálculo en otros lenguajes de programación simbólica . [84]

La lógica difusa asigna un "grado de verdad" entre 0 y 1. Por lo tanto, puede manejar proposiciones que son vagas y parcialmente verdaderas. [85]

Las lógicas no monótonas , incluida la programación lógica con negación como falla , están diseñadas para manejar el razonamiento predeterminado . [28] Se han desarrollado otras versiones especializadas de la lógica para describir muchos dominios complejos.

Muchos problemas en IA (incluidos los de razonamiento, planificación, aprendizaje, percepción y robótica) requieren que el agente opere con información incompleta o incierta. Los investigadores de IA han ideado una serie de herramientas para resolver estos problemas utilizando métodos de la teoría de la probabilidad y la economía. [86] Se han desarrollado herramientas matemáticas precisas que analizan cómo un agente puede tomar decisiones y planificar, utilizando la teoría de la decisión , el análisis de decisiones , [87] y la teoría del valor de la información . [88] Estas herramientas incluyen modelos como los procesos de decisión de Markov , [89] las redes de decisión dinámica , [90] la teoría de juegos y el diseño de mecanismos . [91]

Las redes bayesianas [92] son una herramienta que se puede utilizar para el razonamiento (utilizando el algoritmo de inferencia bayesiana ), [g] [94] el aprendizaje (utilizando el algoritmo de expectativa-maximización ), [h] [96] la planificación (utilizando redes de decisión ) [97] y la percepción (utilizando redes bayesianas dinámicas ). [90]

Los algoritmos probabilísticos también se pueden utilizar para filtrar, predecir, suavizar y encontrar explicaciones para flujos de datos, ayudando así a los sistemas de percepción a analizar procesos que ocurren a lo largo del tiempo (por ejemplo, modelos ocultos de Markov o filtros de Kalman ). [90]

Las aplicaciones de IA más simples se pueden dividir en dos tipos: clasificadores (por ejemplo, "si es brillante, entonces es diamante"), por un lado, y controladores (por ejemplo, "si es diamante, entonces cógelo"), por otro lado. Los clasificadores [98] son funciones que utilizan la coincidencia de patrones para determinar la coincidencia más cercana. Se pueden ajustar con precisión en función de ejemplos elegidos mediante aprendizaje supervisado . Cada patrón (también llamado " observación ") se etiqueta con una determinada clase predefinida. Todas las observaciones combinadas con sus etiquetas de clase se conocen como un conjunto de datos . Cuando se recibe una nueva observación, esa observación se clasifica en función de la experiencia previa. [45]

Existen muchos tipos de clasificadores en uso. [99] El árbol de decisiones es el algoritmo de aprendizaje automático simbólico más simple y más utilizado. [100] El algoritmo de los k vecinos más cercanos fue la IA analógica más utilizada hasta mediados de los años 1990, y los métodos Kernel como la máquina de vectores de soporte (SVM) desplazaron al k vecino más cercano en los años 1990. [101] El clasificador Bayes ingenuo es, según se informa, el "aprendiz más utilizado" [102] en Google, debido en parte a su escalabilidad. [103] Las redes neuronales también se utilizan como clasificadores. [104]

Una red neuronal artificial se basa en una colección de nodos también conocidos como neuronas artificiales , que modelan vagamente las neuronas de un cerebro biológico. Está entrenada para reconocer patrones; una vez entrenada, puede reconocer esos patrones en datos nuevos. Hay una entrada, al menos una capa oculta de nodos y una salida. Cada nodo aplica una función y una vez que el peso cruza su umbral especificado, los datos se transmiten a la siguiente capa. Una red normalmente se llama red neuronal profunda si tiene al menos 2 capas ocultas. [104]

Los algoritmos de aprendizaje para redes neuronales utilizan la búsqueda local para elegir los pesos que obtendrán el resultado correcto para cada entrada durante el entrenamiento. La técnica de entrenamiento más común es el algoritmo de retropropagación . [105] Las redes neuronales aprenden a modelar relaciones complejas entre entradas y salidas y a encontrar patrones en los datos. En teoría, una red neuronal puede aprender cualquier función. [106]

En las redes neuronales de propagación hacia adelante, la señal pasa en una sola dirección. [107] Las redes neuronales recurrentes devuelven la señal de salida a la entrada, lo que permite la memoria a corto plazo de eventos de entrada anteriores. La memoria a corto plazo prolongada es la arquitectura de red más exitosa para las redes recurrentes. [108] Los perceptrones [109] utilizan solo una capa de neuronas; el aprendizaje profundo [110] utiliza múltiples capas. Las redes neuronales convolucionales fortalecen la conexión entre neuronas que están "cerca" entre sí; esto es especialmente importante en el procesamiento de imágenes , donde un conjunto local de neuronas debe identificar un "borde" antes de que la red pueda identificar un objeto. [111]

El aprendizaje profundo [110] utiliza varias capas de neuronas entre las entradas y las salidas de la red. Las múltiples capas pueden extraer progresivamente características de nivel superior de la entrada sin procesar. Por ejemplo, en el procesamiento de imágenes , las capas inferiores pueden identificar bordes, mientras que las capas superiores pueden identificar los conceptos relevantes para un ser humano, como dígitos, letras o rostros. [112]

El aprendizaje profundo ha mejorado profundamente el rendimiento de los programas en muchos subcampos importantes de la inteligencia artificial, incluyendo la visión por computadora , el reconocimiento de voz , el procesamiento del lenguaje natural , la clasificación de imágenes , [113] y otros. La razón por la que el aprendizaje profundo funciona tan bien en tantas aplicaciones no se conoce a partir de 2023. [114] El éxito repentino del aprendizaje profundo en 2012-2015 no se produjo debido a algún nuevo descubrimiento o avance teórico (las redes neuronales profundas y la retropropagación habían sido descritas por muchas personas, ya en la década de 1950) [i] sino debido a dos factores: el increíble aumento en la potencia de la computadora (incluido el aumento de cien veces en la velocidad al cambiar a GPU ) y la disponibilidad de grandes cantidades de datos de entrenamiento, especialmente los conjuntos de datos curados gigantes que se utilizan para pruebas de referencia, como ImageNet . [j]

Los transformadores generativos preentrenados (GPT) son modelos de lenguaje grandes (LLM) que generan texto basándose en las relaciones semánticas entre palabras en oraciones. Los modelos GPT basados en texto se entrenan previamente en un gran corpus de texto que puede ser de Internet. El preentrenamiento consiste en predecir el siguiente token (un token suele ser una palabra, subpalabra o puntuación). A lo largo de este preentrenamiento, los modelos GPT acumulan conocimiento sobre el mundo y luego pueden generar texto similar al humano al predecir repetidamente el siguiente token. Por lo general, una fase de entrenamiento posterior hace que el modelo sea más veraz, útil e inofensivo, generalmente con una técnica llamada aprendizaje de refuerzo a partir de la retroalimentación humana (RLHF). Los modelos GPT actuales son propensos a generar falsedades llamadas " alucinaciones ", aunque esto se puede reducir con RLHF y datos de calidad. Se utilizan en chatbots , que permiten a las personas hacer una pregunta o solicitar una tarea en texto simple. [122] [123]

Los modelos y servicios actuales incluyen Gemini (anteriormente Bard), ChatGPT , Grok , Claude , Copilot y LLaMA . [124] Los modelos GPT multimodales pueden procesar diferentes tipos de datos ( modalidades ), como imágenes, videos, sonido y texto. [125]

A fines de la década de 2010, las unidades de procesamiento gráfico (GPU) que se diseñaron cada vez más con mejoras específicas de IA y se usaron con software especializado TensorFlow habían reemplazado a las unidades centrales de procesamiento (CPU) utilizadas anteriormente como el medio dominante para el entrenamiento de modelos de aprendizaje automático a gran escala (comerciales y académicos). [126] Los lenguajes de programación especializados como Prolog se utilizaron en las primeras investigaciones sobre IA, [127] pero los lenguajes de programación de propósito general como Python se han vuelto predominantes. [128]

La tecnología de inteligencia artificial y aprendizaje automático se utiliza en la mayoría de las aplicaciones esenciales de la década de 2020, entre ellas: motores de búsqueda (como Google Search ), segmentación de anuncios en línea , sistemas de recomendación (ofrecidos por Netflix , YouTube o Amazon ), conducción del tráfico de Internet , publicidad dirigida ( AdSense , Facebook ), asistentes virtuales (como Siri o Alexa ), vehículos autónomos (incluidos drones , ADAS y coches autónomos ), traducción automática de idiomas ( Microsoft Translator , Google Translate ), reconocimiento facial ( Face ID de Apple o DeepFace de Microsoft y FaceNet de Google ) y etiquetado de imágenes (utilizado por Facebook , iPhoto de Apple y TikTok ). La implementación de la IA puede ser supervisada por un director de automatización (CAO).

La aplicación de la IA en la medicina y la investigación médica tiene el potencial de aumentar la atención y la calidad de vida de los pacientes. [129] A través de la lente del Juramento Hipocrático , los profesionales médicos están éticamente obligados a utilizar la IA, si las aplicaciones pueden diagnosticar y tratar a los pacientes con mayor precisión.

Para la investigación médica, la IA es una herramienta importante para procesar e integrar grandes cantidades de datos . Esto es particularmente importante para el desarrollo de organoides e ingeniería de tejidos que utilizan imágenes de microscopía como una técnica clave en la fabricación. [130] Se ha sugerido que la IA puede superar las discrepancias en la financiación asignada a diferentes campos de investigación. [130] Las nuevas herramientas de IA pueden profundizar la comprensión de las vías biomédicamente relevantes. Por ejemplo, AlphaFold 2 (2021) demostró la capacidad de aproximarse, en horas en lugar de meses, a la estructura 3D de una proteína . [131] En 2023, se informó que el descubrimiento de fármacos guiado por IA ayudó a encontrar una clase de antibióticos capaces de matar dos tipos diferentes de bacterias resistentes a los fármacos. [132] En 2024, los investigadores utilizaron el aprendizaje automático para acelerar la búsqueda de tratamientos farmacológicos para la enfermedad de Parkinson . Su objetivo era identificar compuestos que bloquearan la aglutinación o agregación de la alfa-sinucleína (la proteína que caracteriza la enfermedad de Parkinson). Pudieron acelerar el proceso de selección inicial diez veces y reducir el costo mil veces. [133] [134]

Los programas de juegos se han utilizado desde la década de 1950 para demostrar y probar las técnicas más avanzadas de la IA. [135] Deep Blue se convirtió en el primer sistema informático de juego de ajedrez en vencer a un campeón mundial de ajedrez reinante, Garry Kasparov , el 11 de mayo de 1997. [136] En 2011, en una partida de exhibición del concurso Jeopardy!, el sistema de respuesta a preguntas de IBM , Watson , derrotó a los dos grandes campeones de Jeopardy!, Brad Rutter y Ken Jennings , por un margen significativo. [137] En marzo de 2016, AlphaGo ganó 4 de 5 partidas de Go en una partida con el campeón de Go Lee Sedol , convirtiéndose en el primer sistema informático de juego de Go en vencer a un jugador profesional de Go sin handicaps . Luego, en 2017, derrotó a Ke Jie , que era el mejor jugador de Go del mundo. [138] Otros programas manejan juegos de información imperfecta , como el programa de póquer Pluribus . [139] DeepMind desarrolló modelos de aprendizaje de refuerzo cada vez más generalistas , como con MuZero , que podría ser entrenado para jugar ajedrez, Go o juegos de Atari . [140] En 2019, AlphaStar de DeepMind alcanzó el nivel de gran maestro en StarCraft II , un juego de estrategia en tiempo real particularmente desafiante que implica un conocimiento incompleto de lo que sucede en el mapa. [141] En 2021, un agente de IA compitió en una competencia de PlayStation Gran Turismo , ganando contra cuatro de los mejores conductores de Gran Turismo del mundo utilizando aprendizaje de refuerzo profundo. [142] En 2024, Google DeepMind presentó SIMA, un tipo de IA capaz de jugar de forma autónoma nueve videojuegos de mundo abierto nunca antes vistos observando la salida de la pantalla, así como ejecutando tareas breves y específicas en respuesta a instrucciones en lenguaje natural. [143]

En matemáticas, se utilizan formas especiales de razonamiento formal paso a paso . Por el contrario, los LLM como GPT-4 Turbo , Gemini Ultra , Claude Opus , LLaMa-2 o Mistral Large trabajan con modelos probabilísticos, que pueden producir respuestas erróneas en forma de alucinaciones . Por lo tanto, no solo necesitan una gran base de datos de problemas matemáticos de los que aprender, sino también métodos como el ajuste fino supervisado o clasificadores entrenados con datos anotados por humanos para mejorar las respuestas a nuevos problemas y aprender de las correcciones. [144] Un estudio de 2024 mostró que el rendimiento de algunos modelos de lenguaje para las capacidades de razonamiento en la resolución de problemas matemáticos no incluidos en sus datos de entrenamiento era bajo, incluso para problemas con solo desviaciones menores de los datos entrenados. [145]

Como alternativa, se han desarrollado modelos dedicados a la resolución de problemas matemáticos con mayor precisión para el resultado, incluida la prueba de teoremas, como Alpha Tensor , Alpha Geometry y Alpha Proof, todos de Google DeepMind , [146] Llemma de eleuther [147] o Julius . [148]

Cuando se utiliza el lenguaje natural para describir problemas matemáticos, los conversores transforman dichas indicaciones en un lenguaje formal como Lean para definir tareas matemáticas.

Algunos modelos se han desarrollado para resolver problemas difíciles y alcanzar buenos resultados en pruebas comparativas, otros para servir como herramientas educativas en matemáticas. [149]

Las finanzas son uno de los sectores de más rápido crecimiento en los que se están implementando herramientas de IA aplicada: desde la banca minorista en línea hasta el asesoramiento en inversiones y los seguros, donde los "asesores robot" automatizados se han utilizado durante algunos años. [150]

Expertos en pensiones mundiales como Nicolas Firzli insisten en que puede ser demasiado pronto para ver el surgimiento de productos y servicios financieros altamente innovadores basados en inteligencia artificial: "la implementación de herramientas de inteligencia artificial simplemente automatizará aún más las cosas: destruirá decenas de miles de empleos en banca, planificación financiera y asesoramiento sobre pensiones en el proceso, pero no estoy seguro de que desate una nueva ola de innovación [sofisticada] en pensiones". [151]

Varios países están implementando aplicaciones militares de IA. [152] Las principales aplicaciones mejoran el comando y control , las comunicaciones, los sensores, la integración y la interoperabilidad. [153] La investigación se dirige a la recopilación y análisis de inteligencia, la logística, las operaciones cibernéticas, las operaciones de información y los vehículos semiautónomos y autónomos . [152] Las tecnologías de IA permiten la coordinación de sensores y efectores, la detección e identificación de amenazas, el marcado de posiciones enemigas, la adquisición de objetivos , la coordinación y la resolución de conflictos de fuegos conjuntos distribuidos entre vehículos de combate en red que involucran equipos tripulados y no tripulados. [153] La IA se incorporó a las operaciones militares en Irak y Siria. [152]

En noviembre de 2023, la vicepresidenta estadounidense Kamala Harris divulgó una declaración firmada por 31 naciones para establecer límites al uso militar de la IA. Los compromisos incluyen el uso de revisiones legales para garantizar el cumplimiento de la IA militar con las leyes internacionales y ser cautelosos y transparentes en el desarrollo de esta tecnología. [154]

A principios de la década de 2020, la IA generativa ganó prominencia generalizada. GenAI es una IA capaz de generar texto, imágenes, videos u otros datos utilizando modelos generativos , [155] [156] a menudo en respuesta a indicaciones . [157] [158]

En marzo de 2023, el 58% de los adultos estadounidenses había oído hablar de ChatGPT y el 14% lo había probado. [159] El realismo creciente y la facilidad de uso de los generadores de texto a imagen basados en IA, como Midjourney , DALL-E y Stable Diffusion, provocaron una tendencia de fotos virales generadas por IA. Se ganó una atención generalizada gracias a una foto falsa del Papa Francisco con un abrigo blanco, el arresto ficticio de Donald Trump y un engaño sobre un ataque al Pentágono , así como su uso en las artes creativas profesionales. [160] [161]

Los agentes de inteligencia artificial (IA) son entidades de software diseñadas para percibir su entorno, tomar decisiones y realizar acciones de forma autónoma para lograr objetivos específicos. Estos agentes pueden interactuar con los usuarios, su entorno u otros agentes. Los agentes de IA se utilizan en diversas aplicaciones, incluidos asistentes virtuales , chatbots , vehículos autónomos , sistemas de juegos y robótica industrial . Los agentes de IA operan dentro de las limitaciones de su programación, recursos computacionales disponibles y limitaciones de hardware. Esto significa que están restringidos a realizar tareas dentro de su alcance definido y tienen memoria finita y capacidades de procesamiento. En aplicaciones del mundo real, los agentes de IA a menudo enfrentan limitaciones de tiempo para la toma de decisiones y la ejecución de acciones. Muchos agentes de IA incorporan algoritmos de aprendizaje, lo que les permite mejorar su desempeño con el tiempo a través de la experiencia o el entrenamiento. Mediante el aprendizaje automático, los agentes de IA pueden adaptarse a nuevas situaciones y optimizar su comportamiento para sus tareas designadas. [162] [163] [164]

También existen miles de aplicaciones exitosas de IA que se utilizan para resolver problemas específicos para industrias o instituciones específicas. En una encuesta de 2017, una de cada cinco empresas informó haber incorporado "IA" en algunas ofertas o procesos. [165] Algunos ejemplos son el almacenamiento de energía , el diagnóstico médico, la logística militar, las aplicaciones que predicen el resultado de decisiones judiciales, la política exterior o la gestión de la cadena de suministro.

Las aplicaciones de la IA para la evacuación y la gestión de desastres están en aumento. La IA se ha utilizado para investigar si las personas fueron evacuadas y cómo lo hicieron en evacuaciones a gran y pequeña escala utilizando datos históricos de GPS, videos o redes sociales. Además, la IA puede proporcionar información en tiempo real sobre las condiciones de evacuación en tiempo real. [166] [167] [168]

En la agricultura, la IA ha ayudado a los agricultores a identificar áreas que necesitan riego, fertilización, tratamientos con pesticidas o aumentar el rendimiento. Los agrónomos utilizan la IA para realizar investigación y desarrollo. La IA se ha utilizado para predecir el tiempo de maduración de cultivos como los tomates, controlar la humedad del suelo, operar robots agrícolas, realizar análisis predictivos, clasificar las emociones de los animales que llaman a los cerdos, automatizar invernaderos, detectar enfermedades y plagas y ahorrar agua.

La inteligencia artificial se utiliza en astronomía para analizar cantidades cada vez mayores de datos y aplicaciones disponibles, principalmente para "clasificación, regresión, agrupamiento, pronóstico, generación, descubrimiento y desarrollo de nuevos conocimientos científicos", por ejemplo, para descubrir exoplanetas, pronosticar la actividad solar y distinguir entre señales y efectos instrumentales en la astronomía de ondas gravitacionales. También podría utilizarse para actividades en el espacio, como la exploración espacial, incluido el análisis de datos de misiones espaciales, decisiones científicas en tiempo real de naves espaciales, prevención de desechos espaciales y operaciones más autónomas.

La IA tiene beneficios y riesgos potenciales. La IA puede ser capaz de hacer avanzar la ciencia y encontrar soluciones a problemas graves: Demis Hassabis de Deep Mind espera "resolver problemas de inteligencia y luego usar eso para resolver todo lo demás". [169] Sin embargo, a medida que el uso de la IA se ha generalizado, se han identificado varias consecuencias y riesgos no deseados. [170] Los sistemas en producción a veces no pueden tener en cuenta la ética y el sesgo en sus procesos de entrenamiento de IA, especialmente cuando los algoritmos de IA son inherentemente inexplicables en el aprendizaje profundo. [171]

Los algoritmos de aprendizaje automático requieren grandes cantidades de datos. Las técnicas utilizadas para adquirir estos datos han suscitado inquietudes sobre la privacidad , la vigilancia y los derechos de autor .

Los dispositivos y servicios basados en inteligencia artificial, como los asistentes virtuales y los productos de IoT, recopilan continuamente información personal, lo que genera inquietudes sobre la recopilación intrusiva de datos y el acceso no autorizado por parte de terceros. La pérdida de privacidad se ve agravada aún más por la capacidad de la inteligencia artificial para procesar y combinar grandes cantidades de datos, lo que podría conducir a una sociedad de vigilancia en la que las actividades individuales se controlan y analizan constantemente sin las salvaguardas ni la transparencia adecuadas.

Los datos confidenciales de los usuarios recopilados pueden incluir registros de actividad en línea, datos de geolocalización, video o audio. [172] Por ejemplo, para construir algoritmos de reconocimiento de voz , Amazon ha grabado millones de conversaciones privadas y ha permitido que trabajadores temporales escuchen y transcriban algunas de ellas. [173] Las opiniones sobre esta vigilancia generalizada varían desde quienes la ven como un mal necesario hasta aquellos para quienes es claramente poco ética y una violación del derecho a la privacidad . [174]

Los desarrolladores de IA argumentan que esta es la única manera de ofrecer aplicaciones valiosas y han desarrollado varias técnicas que intentan preservar la privacidad mientras se obtienen los datos, como la agregación de datos , la desidentificación y la privacidad diferencial . [175] Desde 2016, algunos expertos en privacidad, como Cynthia Dwork , han comenzado a ver la privacidad en términos de equidad . Brian Christian escribió que los expertos han pasado "de la pregunta de 'qué saben' a la pregunta de 'qué están haciendo con eso'". [176]

La IA generativa suele entrenarse con obras protegidas por derechos de autor sin licencia, incluso en dominios como imágenes o código informático; el resultado se utiliza luego bajo la lógica del " uso justo ". Los expertos no se ponen de acuerdo sobre qué tan bien y bajo qué circunstancias se mantendrá esta lógica en los tribunales de justicia; los factores relevantes pueden incluir "el propósito y el carácter del uso de la obra protegida por derechos de autor" y "el efecto sobre el mercado potencial de la obra protegida por derechos de autor". [177] [178] Los propietarios de sitios web que no deseen que se raspe su contenido pueden indicarlo en un archivo " robots.txt ". [179] En 2023, los autores principales (incluidos John Grisham y Jonathan Franzen ) demandaron a las empresas de IA por usar su trabajo para entrenar a la IA generativa. [180] [181] Otro enfoque discutido es imaginar un sistema sui generis separado de protección para las creaciones generadas por IA para garantizar una atribución justa y una compensación para los autores humanos. [182]

La escena de la IA comercial está dominada por grandes empresas tecnológicas como Alphabet Inc. , Amazon , Apple Inc. , Meta Platforms y Microsoft . [183] [184] [185] Algunos de estos actores ya poseen la gran mayoría de la infraestructura en la nube existente y la potencia informática de los centros de datos , lo que les permite afianzarse aún más en el mercado. [186] [187]

En enero de 2024, la Agencia Internacional de Energía (AIE) publicó Electricity 2024, Analysis and Forecast to 2026 (Electricidad 2024, análisis y pronóstico hasta 2026) , en el que pronostica el uso de energía eléctrica. [188] Este es el primer informe de la AIE que realiza proyecciones para los centros de datos y el consumo de energía para la inteligencia artificial y las criptomonedas. El informe afirma que la demanda de energía para estos usos podría duplicarse para 2026, con un uso adicional de energía eléctrica igual a la electricidad utilizada por toda la nación japonesa. [189]

El consumo prodigioso de energía por parte de la IA es responsable del crecimiento del uso de combustibles fósiles y podría retrasar el cierre de instalaciones de energía a carbón obsoletas y emisoras de carbono. Hay un aumento febril en la construcción de centros de datos en todo Estados Unidos, convirtiendo a las grandes empresas tecnológicas (por ejemplo, Microsoft, Meta, Google, Amazon) en voraces consumidores de energía eléctrica. El consumo eléctrico proyectado es tan inmenso que existe la preocupación de que se cumplirá sin importar la fuente. Una búsqueda en ChatGPT implica el uso de 10 veces la energía eléctrica que una búsqueda en Google. Las grandes empresas tienen prisa por encontrar fuentes de energía, desde energía nuclear hasta geotérmica y de fusión. Las empresas tecnológicas argumentan que, a largo plazo, la IA será eventualmente más amable con el medio ambiente, pero necesitan la energía ahora. La IA hace que la red eléctrica sea más eficiente e "inteligente", ayudará al crecimiento de la energía nuclear y rastreará las emisiones generales de carbono, según las empresas tecnológicas. [190]

Un artículo de investigación de Goldman Sachs de 2024, AI Data Centers and the Coming US Power Demand Surge (Centros de datos con inteligencia artificial y el aumento inminente de la demanda de energía en Estados Unidos), concluyó que "es probable que la demanda de energía en Estados Unidos experimente un crecimiento no visto en una generación..." y pronostica que, para 2030, los centros de datos de Estados Unidos consumirán el 8% de la energía de ese país, en comparación con el 3% en 2022, lo que presagia un crecimiento de la industria de generación de energía eléctrica por diversos medios. [191] La necesidad de los centros de datos de cada vez más energía eléctrica es tal que podrían llegar a saturar la red eléctrica. Las grandes empresas tecnológicas contraatacan diciendo que la IA se puede utilizar para maximizar la utilización de la red por parte de todos. [192]

En 2024, el Wall Street Journal informó que las grandes empresas de inteligencia artificial habían iniciado negociaciones con los proveedores de energía nuclear de Estados Unidos para suministrar electricidad a los centros de datos. En marzo de 2024, Amazon compró un centro de datos de energía nuclear en Pensilvania por 650 millones de dólares estadounidenses. [193]

En septiembre de 2024, Microsoft anunció un acuerdo con Constellation Energy para reabrir la planta de energía nuclear de Three Mile Island para proporcionar a Microsoft el 100% de toda la energía eléctrica producida por la planta durante 20 años. La reapertura de la planta, que sufrió una fusión nuclear parcial en 1979, requerirá que Constellation pase por estrictos procesos regulatorios que incluirán un amplio escrutinio de seguridad por parte de la Comisión Reguladora Nuclear de EE. UU. Si se aprueba (esta será la primera puesta en servicio de una planta nuclear en EE. UU.), se producirán más de 835 megahercios de energía, suficiente para 800.000 hogares. El costo de reapertura y modernización se estima en $ 1.6 mil millones (USD) y depende de las exenciones fiscales para la energía nuclear contenidas en la Ley de Reducción de la Inflación de EE. UU . de 2022. [194] El gobierno de EE. UU. y el estado de Michigan están invirtiendo casi $ 2 mil millones (USD) para reabrir el reactor nuclear Palisades en el lago Michigan. Cerrada desde 2022, está previsto que la planta vuelva a abrir en octubre de 2025. La instalación de Three Mile Island pasará a llamarse Crane Clean Energy Center en honor a Chris Crane, un defensor de la energía nuclear y exdirector ejecutivo de Exelon , responsable de la escisión de Constellation por parte de Exelon. [195]

YouTube , Facebook y otros utilizan sistemas de recomendación para guiar a los usuarios hacia más contenido. A estos programas de IA se les dio el objetivo de maximizar la participación del usuario (es decir, el único objetivo era mantener a la gente mirando). La IA aprendió que los usuarios tendían a elegir desinformación , teorías de conspiración y contenido partidista extremo y, para mantenerlos mirando, la IA recomendó más de eso. Los usuarios también tendían a ver más contenido sobre el mismo tema, por lo que la IA llevó a las personas a burbujas de filtros donde recibieron múltiples versiones de la misma desinformación. [196] Esto convenció a muchos usuarios de que la desinformación era cierta y, en última instancia, socavó la confianza en las instituciones, los medios de comunicación y el gobierno. [197] El programa de IA había aprendido correctamente a maximizar su objetivo, pero el resultado fue perjudicial para la sociedad. Después de las elecciones estadounidenses de 2016, las principales empresas de tecnología tomaron medidas para mitigar el problema [ cita requerida ] .

En 2022, la IA generativa comenzó a crear imágenes, audio, video y texto que son indistinguibles de fotografías, grabaciones, películas o escritura humana reales. Es posible que actores maliciosos utilicen esta tecnología para crear cantidades masivas de desinformación o propaganda. [198] El pionero de la IA Geoffrey Hinton expresó su preocupación por el hecho de que la IA permita a los "líderes autoritarios manipular a sus electores" a gran escala, entre otros riesgos. [199]

Las aplicaciones de aprendizaje automático estarán sesgadas [k] si aprenden de datos sesgados. [201] Los desarrolladores pueden no ser conscientes de que existe el sesgo. [202] El sesgo puede introducirse por la forma en que se seleccionan los datos de entrenamiento y por la forma en que se implementa un modelo. [203] [201] Si se utiliza un algoritmo sesgado para tomar decisiones que pueden dañar gravemente a las personas (como puede ocurrir en medicina , finanzas , contratación , vivienda o policía ), entonces el algoritmo puede causar discriminación . [204] El campo de la equidad estudia cómo prevenir daños causados por sesgos algorítmicos.

El 28 de junio de 2015, la nueva función de etiquetado de imágenes de Google Photos identificó por error a Jacky Alcine y a un amigo como "gorilas" porque eran negros. El sistema se entrenó con un conjunto de datos que contenía muy pocas imágenes de personas negras, [205] un problema llamado "disparidad en el tamaño de la muestra". [206] Google "arregló" este problema al evitar que el sistema etiquetara cualquier cosa como "gorila". Ocho años después, en 2023, Google Photos todavía no podía identificar a un gorila, y tampoco lo hicieron productos similares de Apple, Facebook, Microsoft y Amazon. [207]

COMPAS es un programa comercial ampliamente utilizado por los tribunales estadounidenses para evaluar la probabilidad de que un acusado se convierta en reincidente . En 2016, Julia Angwin de ProPublica descubrió que COMPAS exhibía sesgo racial, a pesar del hecho de que el programa no estaba informado de las razas de los acusados. Aunque la tasa de error tanto para blancos como para negros se calibró exactamente en un 61%, los errores para cada raza fueron diferentes: el sistema sobreestimó constantemente la probabilidad de que una persona negra reincidiera y subestimó la probabilidad de que una persona blanca no reincidiera. [208] En 2017, varios investigadores [l] demostraron que era matemáticamente imposible para COMPAS dar cabida a todas las posibles medidas de imparcialidad cuando las tasas base de reincidencia eran diferentes para blancos y negros en los datos. [210]

Un programa puede tomar decisiones sesgadas incluso si los datos no mencionan explícitamente una característica problemática (como la "raza" o el "género"). La característica se correlacionará con otras características (como la "dirección", el "historial de compras" o el "nombre"), y el programa tomará las mismas decisiones basándose en estas características que en función de la "raza" o el "género". [211] Moritz Hardt dijo que "el hecho más sólido en esta área de investigación es que la imparcialidad a través de la ceguera no funciona". [212]

Las críticas a COMPAS destacaron que los modelos de aprendizaje automático están diseñados para hacer "predicciones" que solo son válidas si asumimos que el futuro se parecerá al pasado. Si se entrenan con datos que incluyen los resultados de decisiones racistas en el pasado, los modelos de aprendizaje automático deben predecir que se tomarán decisiones racistas en el futuro. Si una aplicación luego usa estas predicciones como recomendaciones , es probable que algunas de estas "recomendaciones" sean racistas. [213] Por lo tanto, el aprendizaje automático no es adecuado para ayudar a tomar decisiones en áreas donde existe la esperanza de que el futuro sea mejor que el pasado. Es descriptivo en lugar de prescriptivo. [m]

Los sesgos y las injusticias pueden pasar desapercibidos porque los desarrolladores son abrumadoramente blancos y hombres: entre los ingenieros de IA, aproximadamente el 4% son negros y el 20% son mujeres. [206]

Existen diversas definiciones y modelos matemáticos contradictorios de justicia. Estas nociones dependen de supuestos éticos y están influidas por creencias sobre la sociedad. Una categoría amplia es la justicia distributiva, que se centra en los resultados, a menudo identificando grupos y buscando compensar las disparidades estadísticas. La justicia representativa intenta asegurar que los sistemas de IA no refuercen estereotipos negativos o hagan invisibles a ciertos grupos. La justicia procedimental se centra en el proceso de decisión más que en el resultado. Las nociones de justicia más relevantes pueden depender del contexto, en particular el tipo de aplicación de IA y las partes interesadas. La subjetividad en las nociones de sesgo y justicia hace que sea difícil para las empresas ponerlas en práctica. Muchos especialistas en ética de la IA también consideran que tener acceso a atributos sensibles como la raza o el género es necesario para compensar los sesgos, pero puede entrar en conflicto con las leyes contra la discriminación . [200]

En su Conferencia sobre Equidad, Responsabilidad y Transparencia (ACM FAccT 2022) de 2022, la Asociación de Maquinaria Informática (ACM) en Seúl (Corea del Sur) presentó y publicó hallazgos que recomiendan que hasta que se demuestre que los sistemas de IA y robótica están libres de errores de sesgo, no son seguros y se debe restringir el uso de redes neuronales de autoaprendizaje entrenadas en fuentes vastas y no reguladas de datos defectuosos de Internet. [ dudoso – discutir ] [215]

Muchos sistemas de IA son tan complejos que sus diseñadores no pueden explicar cómo llegan a sus decisiones. [216] Particularmente con las redes neuronales profundas , en las que hay una gran cantidad de relaciones no lineales entre entradas y salidas. Pero existen algunas técnicas de explicabilidad populares. [217]

Es imposible estar seguro de que un programa está funcionando correctamente si nadie sabe exactamente cómo funciona. Ha habido muchos casos en los que un programa de aprendizaje automático pasó pruebas rigurosas, pero aun así aprendió algo diferente de lo que pretendían los programadores. Por ejemplo, se descubrió que un sistema que podía identificar enfermedades de la piel mejor que los profesionales médicos tenía en realidad una fuerte tendencia a clasificar las imágenes con una regla como "cancerosas", porque las imágenes de neoplasias malignas suelen incluir una regla para mostrar la escala. [218] Se descubrió que otro sistema de aprendizaje automático diseñado para ayudar a asignar eficazmente los recursos médicos clasificaba a los pacientes con asma como de "bajo riesgo" de morir de neumonía. Tener asma es en realidad un factor de riesgo grave, pero como los pacientes con asma normalmente recibirían mucha más atención médica, era relativamente improbable que murieran según los datos de entrenamiento. La correlación entre el asma y el bajo riesgo de morir de neumonía era real, pero engañosa. [219]

Las personas que han sido perjudicadas por la decisión de un algoritmo tienen derecho a una explicación. [220] Por ejemplo, se espera que los médicos expliquen clara y completamente a sus colegas el razonamiento detrás de cualquier decisión que tomen. Los primeros borradores del Reglamento General de Protección de Datos de la Unión Europea en 2016 incluyeron una declaración explícita de que este derecho existe. [n] Los expertos de la industria señalaron que se trata de un problema sin resolver y sin una solución a la vista. Los reguladores argumentaron que, no obstante, el daño es real: si el problema no tiene solución, no se deben utilizar las herramientas. [221]

DARPA estableció el programa XAI ("Inteligencia Artificial Explicable") en 2014 para tratar de resolver estos problemas. [222]

Varios enfoques apuntan a abordar el problema de la transparencia. SHAP permite visualizar la contribución de cada característica a la salida. [223] LIME puede aproximar localmente las salidas de un modelo con un modelo más simple e interpretable. [224] El aprendizaje multitarea proporciona una gran cantidad de salidas además de la clasificación objetivo. Estas otras salidas pueden ayudar a los desarrolladores a deducir lo que la red ha aprendido. [225] La deconvolución , DeepDream y otros métodos generativos pueden permitir a los desarrolladores ver lo que han aprendido las diferentes capas de una red profunda para visión artificial y producir una salida que pueda sugerir lo que la red está aprendiendo. [226] Para los transformadores generativos preentrenados , Anthropic desarrolló una técnica basada en el aprendizaje de diccionario que asocia patrones de activaciones neuronales con conceptos comprensibles para los humanos. [227]

La inteligencia artificial proporciona una serie de herramientas que son útiles para los actores maliciosos , como gobiernos autoritarios , terroristas , criminales o estados rebeldes .

Un arma autónoma letal es una máquina que localiza, selecciona y ataca objetivos humanos sin supervisión humana. [o] Las herramientas de IA ampliamente disponibles pueden ser utilizadas por actores maliciosos para desarrollar armas autónomas económicas y, si se producen a escala, son potencialmente armas de destrucción masiva . [229] Incluso cuando se utilizan en una guerra convencional, es poco probable que no puedan elegir objetivos de manera confiable y podrían potencialmente matar a una persona inocente . [229] En 2014, 30 naciones (incluida China) apoyaron la prohibición de las armas autónomas en virtud de la Convención de las Naciones Unidas sobre Ciertas Armas Convencionales , sin embargo, Estados Unidos y otros no estuvieron de acuerdo. [230] Para 2015, se informó que más de cincuenta países estaban investigando robots de campo de batalla. [231]

Las herramientas de IA facilitan a los gobiernos autoritarios el control eficiente de sus ciudadanos de varias maneras. El reconocimiento facial y de voz permite una vigilancia generalizada . El aprendizaje automático , que opera con estos datos, puede clasificar a los enemigos potenciales del estado y evitar que se escondan. Los sistemas de recomendación pueden apuntar con precisión a la propaganda y la desinformación para lograr el máximo efecto. Los deepfakes y la IA generativa ayudan a producir desinformación. La IA avanzada puede hacer que la toma de decisiones centralizada autoritaria sea más competitiva que los sistemas liberales y descentralizados como los mercados . Reduce el costo y la dificultad de la guerra digital y el software espía avanzado . [232] Todas estas tecnologías han estado disponibles desde 2020 o antes: los sistemas de reconocimiento facial con IA ya se están utilizando para la vigilancia masiva en China. [233] [234]

Existen muchas otras formas en las que se espera que la IA ayude a los actores maliciosos, algunas de las cuales no se pueden prever. Por ejemplo, la IA con aprendizaje automático es capaz de diseñar decenas de miles de moléculas tóxicas en cuestión de horas. [235]

Los economistas han destacado con frecuencia los riesgos de despidos provocados por la IA y han especulado sobre el desempleo si no hay una política social adecuada para el pleno empleo. [236]

En el pasado, la tecnología ha tendido a aumentar en lugar de reducir el empleo total, pero los economistas reconocen que "estamos en territorio desconocido" con la IA. [237] Una encuesta a economistas mostró desacuerdo sobre si el uso creciente de robots e IA causará un aumento sustancial en el desempleo de largo plazo , pero generalmente coinciden en que podría ser un beneficio neto si se redistribuyen las ganancias de productividad . [238] Las estimaciones de riesgo varían; por ejemplo, en la década de 2010, Michael Osborne y Carl Benedikt Frey estimaron que el 47% de los empleos estadounidenses tienen un "alto riesgo" de automatización potencial, mientras que un informe de la OCDE clasificó solo el 9% de los empleos estadounidenses como de "alto riesgo". [p] [240] La metodología de especular sobre los niveles futuros de empleo ha sido criticada por carecer de fundamento probatorio y por implicar que la tecnología, en lugar de la política social, crea desempleo, en lugar de despidos. [236] En abril de 2023, se informó que el 70% de los puestos de trabajo para ilustradores de videojuegos chinos habían sido eliminados por la inteligencia artificial generativa. [241] [242]

A diferencia de las anteriores oleadas de automatización, muchos empleos de clase media pueden ser eliminados por la inteligencia artificial; The Economist afirmó en 2015 que "la preocupación de que la IA pueda hacer con los empleos de cuello blanco lo que la energía del vapor hizo con los de cuello azul durante la Revolución Industrial" es "algo que vale la pena tomar en serio". [243] Los empleos con riesgo extremo van desde asistentes legales hasta cocineros de comida rápida, mientras que es probable que aumente la demanda de empleo para las profesiones relacionadas con el cuidado, que van desde la atención médica personal hasta el clero. [244]

Desde los primeros días del desarrollo de la inteligencia artificial, ha habido argumentos, por ejemplo, los planteados por Joseph Weizenbaum , sobre si las tareas que pueden ser realizadas por computadoras realmente deberían ser realizadas por ellas, dada la diferencia entre computadoras y humanos, y entre el cálculo cuantitativo y el juicio cualitativo basado en valores. [245]

Se ha afirmado que la IA se volverá tan poderosa que la humanidad podría perder irreversiblemente el control sobre ella. Esto podría, como afirmó el físico Stephen Hawking , " significar el fin de la raza humana ". [246] Este escenario ha sido común en la ciencia ficción, cuando una computadora o robot desarrolla de repente una "autoconciencia" (o "sensibilidad" o "conciencia") similar a la humana y se convierte en un personaje malévolo. [q] Estos escenarios de ciencia ficción son engañosos en varios sentidos.

En primer lugar, la IA no requiere una " sensibilización " similar a la humana para ser un riesgo existencial. Los programas de IA modernos reciben objetivos específicos y utilizan el aprendizaje y la inteligencia para alcanzarlos. El filósofo Nick Bostrom argumentó que si uno le da casi cualquier objetivo a una IA lo suficientemente poderosa, puede elegir destruir a la humanidad para lograrlo (utilizó el ejemplo del gerente de una fábrica de clips de papel ). [248] Stuart Russell da el ejemplo de un robot doméstico que intenta encontrar una forma de matar a su dueño para evitar que lo desconecten, razonando que "no puedes ir a buscar el café si estás muerto". [249] Para ser segura para la humanidad, una superinteligencia tendría que estar genuinamente alineada con la moralidad y los valores de la humanidad para que esté "fundamentalmente de nuestro lado". [250]

En segundo lugar, Yuval Noah Harari sostiene que la IA no requiere un cuerpo robótico o control físico para plantear un riesgo existencial. Las partes esenciales de la civilización no son físicas. Cosas como las ideologías , las leyes , el gobierno , el dinero y la economía están hechas de lenguaje ; existen porque hay historias que miles de millones de personas creen. La prevalencia actual de la desinformación sugiere que una IA podría usar el lenguaje para convencer a las personas de creer cualquier cosa, incluso de tomar acciones destructivas. [251]

Las opiniones entre los expertos y los conocedores de la industria son variadas, con fracciones considerables tanto preocupadas como despreocupadas por el riesgo de una eventual IA superinteligente. [252] Personalidades como Stephen Hawking , Bill Gates y Elon Musk , [253] así como pioneros de la IA como Yoshua Bengio , Stuart Russell , Demis Hassabis y Sam Altman , han expresado preocupaciones sobre el riesgo existencial de la IA.

En mayo de 2023, Geoffrey Hinton anunció su renuncia a Google para poder "hablar libremente sobre los riesgos de la IA" sin "considerar cómo esto afecta a Google". [254] En particular, mencionó los riesgos de una adquisición por parte de la IA , [255] y destacó que, para evitar los peores resultados, establecer pautas de seguridad requerirá la cooperación entre quienes compiten en el uso de la IA. [256]

En 2023, muchos expertos destacados en IA emitieron una declaración conjunta en la que afirmaban que “mitigar el riesgo de extinción de la IA debería ser una prioridad mundial junto con otros riesgos a escala social, como las pandemias y la guerra nuclear”. [257]

Sin embargo, otros investigadores se manifestaron a favor de una visión menos distópica. El pionero de la IA, Juergen Schmidhuber, no firmó la declaración conjunta, y enfatizó que en el 95% de los casos, la investigación en IA tiene como objetivo hacer que "las vidas humanas sean más largas, saludables y fáciles". [258] Si bien las herramientas que se están utilizando ahora para mejorar las vidas también pueden ser utilizadas por malos actores, "también pueden usarse contra los malos actores". [259] [260] Andrew Ng también sostuvo que "es un error caer en la exageración apocalíptica sobre la IA, y que los reguladores que lo hagan solo beneficiarán a los intereses creados". [261] Yann LeCun "se burla de los escenarios distópicos de sus pares de desinformación supercargada e incluso, eventualmente, extinción humana". [262] A principios de la década de 2010, los expertos argumentaron que los riesgos son demasiado distantes en el futuro como para justificar la investigación o que los humanos serán valiosos desde la perspectiva de una máquina superinteligente. [263] Sin embargo, después de 2016, el estudio de los riesgos actuales y futuros y las posibles soluciones se convirtió en un área seria de investigación. [264]

Las IA amigables son máquinas que han sido diseñadas desde el principio para minimizar los riesgos y tomar decisiones que beneficien a los humanos. Eliezer Yudkowsky , quien acuñó el término, sostiene que el desarrollo de una IA amigable debería ser una prioridad de investigación más alta: puede requerir una gran inversión y debe completarse antes de que la IA se convierta en un riesgo existencial. [265]

Las máquinas con inteligencia tienen el potencial de usar su inteligencia para tomar decisiones éticas. El campo de la ética de las máquinas proporciona a las máquinas principios y procedimientos éticos para resolver dilemas éticos. [266] El campo de la ética de las máquinas también se denomina moralidad computacional, [266] y se fundó en un simposio de la AAAI en 2005. [267]

Otros enfoques incluyen los "agentes morales artificiales" de Wendell Wallach [268] y los tres principios de Stuart J. Russell para desarrollar máquinas demostrablemente beneficiosas. [269]

Las organizaciones activas en la comunidad de código abierto de IA incluyen Hugging Face , [270] Google , [271] EleutherAI y Meta . [272] Varios modelos de IA, como Llama 2 , Mistral o Stable Diffusion , se han hecho de peso abierto, [273] [274] lo que significa que su arquitectura y parámetros entrenados (los "pesos") están disponibles públicamente. Los modelos de peso abierto se pueden ajustar libremente , lo que permite a las empresas especializarlos con sus propios datos y para su propio caso de uso. [275] Los modelos de peso abierto son útiles para la investigación y la innovación, pero también se pueden usar mal. Dado que se pueden ajustar, cualquier medida de seguridad incorporada, como objetar solicitudes dañinas, se puede entrenar hasta que se vuelva ineficaz. Algunos investigadores advierten que los futuros modelos de IA pueden desarrollar capacidades peligrosas (como el potencial de facilitar drásticamente el bioterrorismo ) y que una vez publicados en Internet, no se pueden eliminar en todas partes si es necesario. Recomiendan realizar auditorías previas al lanzamiento y análisis de costo-beneficio. [276]

Los proyectos de inteligencia artificial pueden someterse a pruebas de permisibilidad ética durante el diseño, desarrollo e implementación de un sistema de IA. Un marco de IA como el Care and Act Framework, que contiene los valores SUM y fue desarrollado por el Instituto Alan Turing, pone a prueba los proyectos en cuatro áreas principales: [277] [278]

Otros avances en los marcos éticos incluyen aquellos decididos durante la Conferencia de Asilomar , la Declaración de Montreal para una IA Responsable y la iniciativa Ética de los Sistemas Autónomos del IEEE, entre otros; [279] sin embargo, estos principios no están exentos de críticas, especialmente en lo que respecta a las personas elegidas para contribuir a estos marcos. [280]

La promoción del bienestar de las personas y las comunidades a las que afectan estas tecnologías requiere la consideración de las implicaciones sociales y éticas en todas las etapas del diseño, desarrollo e implementación del sistema de IA, y la colaboración entre roles laborales como científicos de datos, gerentes de producto, ingenieros de datos, expertos en el dominio y gerentes de entrega. [281]

En 2024, el Instituto de Seguridad de la IA del Reino Unido publicó un conjunto de herramientas de prueba llamado "Inspect" para evaluaciones de seguridad de la IA, disponible bajo una licencia de código abierto del MIT, que está disponible gratuitamente en GitHub y se puede mejorar con paquetes de terceros. Se puede utilizar para evaluar modelos de IA en una variedad de áreas, incluidos los conocimientos básicos, la capacidad de razonamiento y las capacidades autónomas. [282]

La regulación de la inteligencia artificial es el desarrollo de políticas y leyes del sector público para promover y regular la IA; por lo tanto, está relacionada con la regulación más amplia de los algoritmos. [283] El panorama regulatorio y de políticas para la IA es un tema emergente en las jurisdicciones a nivel mundial. [284] Según el Índice de IA de Stanford , el número anual de leyes relacionadas con la IA aprobadas en los 127 países encuestados aumentó de una aprobada en 2016 a 37 aprobadas solo en 2022. [285] [286] Entre 2016 y 2020, más de 30 países adoptaron estrategias dedicadas a la IA. [287] La mayoría de los estados miembros de la UE habían publicado estrategias nacionales de IA, al igual que Canadá, China, India, Japón, Mauricio, la Federación de Rusia, Arabia Saudita, los Emiratos Árabes Unidos, los EE. UU. y Vietnam. Otros estaban en proceso de elaborar su propia estrategia de IA, incluidos Bangladesh, Malasia y Túnez. [287] La Alianza Global sobre Inteligencia Artificial se lanzó en junio de 2020, afirmando la necesidad de que la IA se desarrolle de acuerdo con los derechos humanos y los valores democráticos, para garantizar la confianza pública en la tecnología. [287] Henry Kissinger , Eric Schmidt y Daniel Huttenlocher publicaron una declaración conjunta en noviembre de 2021 pidiendo una comisión gubernamental para regular la IA. [288] En 2023, los líderes de OpenAI publicaron recomendaciones para la gobernanza de la superinteligencia, que creen que puede suceder en menos de 10 años. [289] En 2023, las Naciones Unidas también lanzaron un organismo asesor para brindar recomendaciones sobre la gobernanza de la IA; el organismo está compuesto por ejecutivos de empresas de tecnología, funcionarios gubernamentales y académicos. [290] En 2024, el Consejo de Europa creó el primer tratado internacional jurídicamente vinculante sobre IA, llamado " Convenio Marco sobre Inteligencia Artificial y Derechos Humanos, Democracia y Estado de Derecho ". Fue adoptado por la Unión Europea, los Estados Unidos, el Reino Unido y otros signatarios. [291]

En una encuesta de Ipsos de 2022 , las actitudes hacia la IA variaron mucho según el país; el 78% de los ciudadanos chinos, pero solo el 35% de los estadounidenses, estuvieron de acuerdo en que "los productos y servicios que utilizan IA tienen más beneficios que inconvenientes". [285] Una encuesta de Reuters /Ipsos de 2023 encontró que el 61% de los estadounidenses está de acuerdo, y el 22% no, en que la IA plantea riesgos para la humanidad. [292] En una encuesta de Fox News de 2023 , el 35% de los estadounidenses pensó que era "muy importante", y un 41% adicional pensó que era "algo importante", que el gobierno federal regulara la IA, frente al 13% que respondió "no muy importante" y el 8% que respondió "nada importante". [293] [294]

En noviembre de 2023, se celebró la primera Cumbre mundial sobre seguridad de la IA en Bletchley Park (Reino Unido) para debatir los riesgos a corto y largo plazo de la IA y la posibilidad de establecer marcos regulatorios obligatorios y voluntarios. [295] 28 países, incluidos Estados Unidos, China y la Unión Europea, emitieron una declaración al inicio de la cumbre, en la que pedían cooperación internacional para gestionar los desafíos y riesgos de la inteligencia artificial. [296] [297] En mayo de 2024, en la Cumbre de Seúl sobre IA , 16 empresas globales de tecnología de IA acordaron compromisos de seguridad en el desarrollo de la IA. [298] [299]

El estudio del razonamiento mecánico o "formal" comenzó con los filósofos y matemáticos en la antigüedad. El estudio de la lógica condujo directamente a la teoría de la computación de Alan Turing , que sugería que una máquina, al mezclar símbolos tan simples como "0" y "1", podría simular cualquier forma concebible de razonamiento matemático. [300] [301] Esto, junto con los descubrimientos concurrentes en cibernética , teoría de la información y neurobiología , llevó a los investigadores a considerar la posibilidad de construir un "cerebro electrónico". [r] Desarrollaron varias áreas de investigación que se convertirían en parte de la IA, [303] como el diseño de McCullouch y Pitts para "neuronas artificiales" en 1943, [115] y el influyente artículo de Turing de 1950 ' Computing Machinery and Intelligence ', que introdujo la prueba de Turing y demostró que la "inteligencia de la máquina" era plausible. [304] [301]

El campo de investigación de IA fue fundado en un taller en Dartmouth College en 1956. [s] [6] Los asistentes se convirtieron en los líderes de la investigación de IA en la década de 1960. [t] Ellos y sus estudiantes produjeron programas que la prensa describió como "asombrosos": [u] las computadoras estaban aprendiendo estrategias de damas , resolviendo problemas de palabras en álgebra, demostrando teoremas lógicos y hablando inglés. [v] [7] Los laboratorios de inteligencia artificial se establecieron en varias universidades británicas y estadounidenses a finales de la década de 1950 y principios de la de 1960. [301]

Los investigadores de los años 1960 y 1970 estaban convencidos de que sus métodos eventualmente tendrían éxito en la creación de una máquina con inteligencia general y consideraron que este era el objetivo de su campo. [308] En 1965 Herbert Simon predijo que "las máquinas serán capaces, dentro de veinte años, de hacer cualquier trabajo que un hombre pueda hacer". [309] En 1967 Marvin Minsky estuvo de acuerdo, escribiendo que "dentro de una generación ... el problema de crear 'inteligencia artificial' estará sustancialmente resuelto". [310] Sin embargo, habían subestimado la dificultad del problema. [w] En 1974, tanto los gobiernos de Estados Unidos como el británico interrumpieron la investigación exploratoria en respuesta a las críticas de Sir James Lighthill [312] y la presión constante del Congreso de Estados Unidos para financiar proyectos más productivos . [313] El libro de Minsky y Papert Perceptrons se entendió como una prueba de que las redes neuronales artificiales nunca serían útiles para resolver tareas del mundo real, desacreditando así el enfoque por completo. [314] A continuación llegó el « invierno de la IA », un período en el que era difícil obtener financiación para proyectos de IA. [9]

A principios de los años 1980, la investigación en IA revivió gracias al éxito comercial de los sistemas expertos , [315] una forma de programa de IA que simulaba el conocimiento y las habilidades analíticas de los expertos humanos. En 1985, el mercado de IA había alcanzado más de mil millones de dólares. Al mismo tiempo, el proyecto informático de quinta generación de Japón inspiró a los gobiernos de Estados Unidos y Gran Bretaña a restablecer la financiación de la investigación académica . [8] Sin embargo, a partir del colapso del mercado de Lisp Machine en 1987, la IA volvió a caer en descrédito y comenzó un segundo invierno más duradero. [10]

Hasta este punto, la mayor parte de la financiación de la IA se había destinado a proyectos que utilizaban símbolos de alto nivel para representar objetos mentales como planes, objetivos, creencias y hechos conocidos. En la década de 1980, algunos investigadores comenzaron a dudar de que este enfoque pudiera imitar todos los procesos de la cognición humana, especialmente la percepción , la robótica , el aprendizaje y el reconocimiento de patrones , [316] y comenzaron a investigar enfoques "subsimbólicos". [317] Rodney Brooks rechazó la "representación" en general y se centró directamente en la ingeniería de máquinas que se mueven y sobreviven. [x] Judea Pearl , Lofti Zadeh y otros desarrollaron métodos que manejaban información incompleta e incierta haciendo conjeturas razonables en lugar de una lógica precisa. [86] [322] Pero el desarrollo más importante fue el resurgimiento del " conexionismo ", incluida la investigación de redes neuronales, por Geoffrey Hinton y otros. [323] En 1990, Yann LeCun demostró con éxito que las redes neuronales convolucionales pueden reconocer dígitos escritos a mano, la primera de muchas aplicaciones exitosas de las redes neuronales. [324]

La IA recuperó gradualmente su reputación a finales de los años 1990 y principios del siglo XXI explotando métodos matemáticos formales y encontrando soluciones específicas a problemas específicos. Este enfoque " estrecho " y "formal" permitió a los investigadores producir resultados verificables y colaborar con otros campos (como la estadística , la economía y las matemáticas ). [325] En 2000, las soluciones desarrolladas por investigadores de IA se utilizaban ampliamente, aunque en la década de 1990 rara vez se las describía como "inteligencia artificial". [326] Sin embargo, varios investigadores académicos se preocuparon de que la IA ya no persiguiera su objetivo original de crear máquinas versátiles y completamente inteligentes. A partir de 2002, fundaron el subcampo de la inteligencia artificial general (o "AGI"), que contaba con varias instituciones bien financiadas en la década de 2010. [4]

El aprendizaje profundo comenzó a dominar los puntos de referencia de la industria en 2012 y fue adoptado en todo el campo. [11] Para muchas tareas específicas, se abandonaron otros métodos. [y] El éxito del aprendizaje profundo se basó tanto en mejoras de hardware ( computadoras más rápidas , [328] unidades de procesamiento gráfico , computación en la nube [329] ) como en el acceso a grandes cantidades de datos [330] (incluidos conjuntos de datos curados, [329] como ImageNet ). El éxito del aprendizaje profundo condujo a un enorme aumento en el interés y la financiación en IA. [z] La cantidad de investigación sobre aprendizaje automático (medida por publicaciones totales) aumentó un 50% en los años 2015-2019. [287]

En 2016, las cuestiones de equidad y el mal uso de la tecnología se catapultaron al centro de la escena en las conferencias sobre aprendizaje automático, las publicaciones aumentaron enormemente, se consiguió financiación y muchos investigadores reorientaron sus carreras hacia estas cuestiones. El problema de la alineación se convirtió en un campo serio de estudio académico. [264]