Una red de Hopfield ( memoria asociativa o modelo de Ising-Lenz-Little o red Nakano-Amari-Hopfield ) es un sistema de vidrio giratorio utilizado para modelar redes neuronales , basado en el trabajo de Ernst Ising con Wilhelm Lenz sobre el modelo de Ising de materiales magnéticos. [1] Las redes de Hopfield fueron descritas por primera vez con respecto a las redes neuronales recurrentes de forma independiente por Kaoru Nakano en 1971 [2] [3] y Shun'ichi Amari en 1972, [4] [5] y con respecto a las redes neuronales biológicas por William Little. en 1974, [6] y fueron popularizadas por John Hopfield en 1982. [7] Las redes Hopfield sirven como sistemas de memoria direccionables por contenido ("asociativos") con nodos de umbral binarios o con variables continuas. [8] Las redes de Hopfield también proporcionan un modelo para comprender la memoria humana. [9] [10]

El modelo de Ising en sí fue publicado en la década de 1920 como modelo de magnetismo, sin embargo, estudió el equilibrio térmico, que no cambia con el tiempo. Glauber en 1963 estudió el modelo de Ising evolucionando en el tiempo, como un proceso hacia el equilibrio térmico ( dinámica de Glauber ), añadiendo la componente de tiempo. [11]

El segundo componente que se añadió fue la adaptación al estímulo. Shun'ichi Amari en 1972 propuso modificar los pesos de un modelo de Ising mediante la regla de aprendizaje de Hebbian como modelo de memoria asociativa. [4] La misma idea fue publicada por William A. Little en 1974, [6] quien fue reconocido por Hopfield en su artículo de 1982. El modelo Sherrington-Kirkpatrick de spin glass, publicado en 1975, es la red Hopfield con inicialización aleatoria. Sherrington y Kirkpatrick descubrieron que es muy probable que la función energética del modelo SK tenga muchos mínimos locales. [7]

Hopfield desarrolló redes con dinámica continua en su artículo de 1984. [8] Krotov y Hopfield desarrollaron un avance importante en la capacidad de almacenamiento de memoria en 2016 [12] a través de un cambio en la dinámica de la red y la función energética. Esta idea fue ampliada por Demircigil y sus colaboradores en 2017. [13] La dinámica continua de los modelos de gran capacidad de memoria se desarrolló en una serie de artículos entre 2016 y 2020. [12] [14] [15] Gran capacidad de almacenamiento de memoria Hopfield Networks Ahora se denominan Memorias Asociativas Densas o modernas redes de Hopfield .

Las unidades en las redes Hopfield son unidades de umbral binario, es decir, las unidades solo toman dos valores diferentes para sus estados, y el valor se determina en función de si la entrada de la unidad excede o no su umbral . Las redes de Hopfield discretas describen las relaciones entre neuronas binarias (que se activan o no) . [7] En un momento determinado, el estado de la red neuronal se describe mediante un vector , que registra qué neuronas se activan en una palabra binaria de bits.

Las interacciones entre neuronas tienen unidades que normalmente toman valores de 1 o −1, y esta convención se utilizará a lo largo de este artículo. Sin embargo, otra literatura podría usar unidades que tomen valores de 0 y 1. Estas interacciones se "aprenden" mediante la ley de asociación de Hebb , de modo que, para un cierto estado y nodos distintos

pero .

(Tenga en cuenta que la regla de aprendizaje hebbiana toma la forma cuando las unidades asumen valores en .)

Una vez que la red esté entrenada, ya no evolucione. Si se introduce un nuevo estado de neuronas en la red neuronal, la red actúa sobre las neuronas de tal manera que

¿Dónde está el valor umbral de la i-ésima neurona (a menudo se considera 0)? [16] De esta manera, las redes de Hopfield tienen la capacidad de "recordar" estados almacenados en la matriz de interacción, porque si un nuevo estado es sometido a la matriz de interacción, cada neurona cambiará hasta coincidir con el estado original (ver la sección Actualizaciones abajo).

Las conexiones en una red Hopfield suelen tener las siguientes restricciones:

La restricción de que los pesos sean simétricos garantiza que la función de energía disminuya monótonamente mientras se siguen las reglas de activación. [17] Una red con pesos asimétricos puede exhibir algún comportamiento periódico o caótico; sin embargo, Hopfield descubrió que este comportamiento se limita a partes relativamente pequeñas del espacio de fase y no afecta la capacidad de la red para actuar como un sistema de memoria asociativa direccionable por contenido.

Hopfield también modeló redes neuronales para valores continuos, en las que la salida eléctrica de cada neurona no es binaria sino un valor entre 0 y 1. [8] Descubrió que este tipo de red también era capaz de almacenar y reproducir estados memorizados.

Observe que cada par de unidades i y j en una red Hopfield tiene una conexión que se describe mediante el peso de conectividad . En este sentido, la red de Hopfield puede describirse formalmente como un grafo completo no dirigido , donde es un conjunto de neuronas de McCulloch-Pitts y es una función que vincula pares de unidades a un valor real, el peso de conectividad.

La actualización de una unidad (nodo en el gráfico que simula la neurona artificial) en la red Hopfield se realiza mediante la siguiente regla:

dónde:

Las actualizaciones en la red Hopfield se pueden realizar de dos formas diferentes:

El peso entre dos unidades tiene un poderoso impacto sobre los valores de las neuronas. Considere el peso de la conexión entre dos neuronas i y j. Si , la regla de actualización implica que:

Por tanto, los valores de las neuronas i y j convergerán si el peso entre ellas es positivo. De manera similar, divergirán si el peso es negativo.

Bruck arrojó luz sobre el comportamiento de una neurona en la red discreta de Hopfield al demostrar su convergencia en su artículo de 1990. [18] Un artículo posterior [19] investigó más a fondo el comportamiento de cualquier neurona en Hopfield tanto en tiempo discreto como en tiempo continuo. redes cuando la función energética correspondiente se minimiza durante un proceso de optimización. Bruck muestra [18] que la neurona j cambia su estado si y sólo si disminuye aún más el siguiente pseudocorte sesgado. La red de Hopfield discreta minimiza el siguiente pseudocorte sesgado [19] para la matriz de peso sináptico de la red de Hopfield.

donde y representa el conjunto de neuronas que son −1 y +1, respectivamente, en el momento . Para obtener más detalles, consulte el artículo reciente. [19]

La red Hopfield en tiempo discreto siempre minimiza exactamente el siguiente pseudocorte [18] [19]

La red Hopfield de tiempo continuo siempre minimiza un límite superior para el siguiente corte ponderado [19]

donde es una función sigmoidea centrada en cero.

La compleja red de Hopfield, por otro lado, generalmente tiende a minimizar el llamado corte de sombra de la compleja matriz de peso de la red. [20]

Las redes de Hopfield tienen un valor escalar asociado con cada estado de la red, denominado "energía", E , de la red, donde:

Esta cantidad se llama "energía" porque disminuye o permanece igual cuando se actualizan las unidades de la red. Además, bajo actualizaciones repetidas, la red eventualmente convergerá a un estado que es un mínimo local en la función de energía (que se considera una función de Lyapunov ). [7] Por lo tanto, si un estado es un mínimo local en la función de energía, es un estado estable para la red. Nótese que esta función energética pertenece a una clase general de modelos en física bajo el nombre de modelos de Ising ; éstos a su vez son un caso especial de redes de Markov , ya que la medida de probabilidad asociada , la medida de Gibbs , tiene la propiedad de Markov .

Hopfield y Tank presentaron la aplicación de la red Hopfield para resolver el clásico problema del viajante en 1985. [21] Desde entonces, la red Hopfield se ha utilizado ampliamente para la optimización. La idea de utilizar la red de Hopfield en problemas de optimización es sencilla: si una función de costo restringida/no restringida se puede escribir en la forma de la función de energía E de Hopfield, entonces existe una red de Hopfield cuyos puntos de equilibrio representan soluciones a la optimización restringida/no restringida. problema. Minimizar la función de energía de Hopfield minimiza la función objetivo y satisface las restricciones también, ya que las restricciones están "incrustadas" en los pesos sinápticos de la red. Aunque incluir las restricciones de optimización en los pesos sinápticos de la mejor manera posible es una tarea desafiante, muchos problemas de optimización difíciles con restricciones en diferentes disciplinas se han convertido a la función de energía de Hopfield: sistemas de memoria asociativa, conversión de analógico a digital, problema de programación de tiendas, asignación cuadrática y otros problemas NP-completos relacionados, problema de asignación de canales en redes inalámbricas, problema de enrutamiento de redes móviles ad-hoc, restauración de imágenes, identificación de sistemas, optimización combinatoria, etc., solo por nombrar algunos. Se pueden encontrar más detalles, por ejemplo, en el artículo. [19]

La inicialización de las redes Hopfield se realiza estableciendo los valores de las unidades en el patrón de inicio deseado. Luego se realizan actualizaciones repetidas hasta que la red converge a un patrón atractor. La convergencia generalmente está asegurada, ya que Hopfield demostró que los atractores de este sistema dinámico no lineal son estables, no periódicos ni caóticos como en otros sistemas [ cita requerida ] . Por lo tanto, en el contexto de las redes de Hopfield, un patrón atractor es un estado estable final, un patrón que no puede cambiar ningún valor dentro de él al actualizarse [ cita necesaria ] .

Entrenar una red Hopfield implica reducir la energía de los estados que la red debería "recordar". Esto permite que la red sirva como un sistema de memoria direccionable de contenido, es decir, la red convergerá a un estado "recordado" si se le proporciona sólo una parte del estado. La red se puede utilizar para recuperarse de una entrada distorsionada al estado entrenado que sea más similar a esa entrada. A esto se le llama memoria asociativa porque recupera recuerdos en base a la similitud. Por ejemplo, si entrenamos una red de Hopfield con cinco unidades para que el estado (1, −1, 1, −1, 1) sea un mínimo de energía y le damos a la red el estado (1, −1, −1, −1, 1) convergerá a (1, −1, 1, −1, 1). Por lo tanto, la red está adecuadamente entrenada cuando la energía de los estados que la red debe recordar son mínimos locales. Tenga en cuenta que, a diferencia del entrenamiento con Perceptrón , los umbrales de las neuronas nunca se actualizan.

Existen varias reglas de aprendizaje diferentes que se pueden utilizar para almacenar información en la memoria de la red Hopfield. Es deseable que una regla de aprendizaje tenga las dos propiedades siguientes:

Estas propiedades son deseables, ya que una regla de aprendizaje que las satisfaga es biológicamente más plausible. Por ejemplo, dado que el cerebro humano siempre está aprendiendo nuevos conceptos, se puede razonar que el aprendizaje humano es incremental. Un sistema de aprendizaje que no fuera incremental generalmente se entrenaría solo una vez, con una gran cantidad de datos de entrenamiento.

La teoría de Hebb fue introducida por Donald Hebb en 1949 para explicar el "aprendizaje asociativo", en el que la activación simultánea de células neuronales conduce a aumentos pronunciados en la fuerza sináptica entre esas células. [23] A menudo se resume como "Las neuronas que se activan juntas se conectan entre sí. Las neuronas que se activan fuera de sincronización no se conectan".

La regla hebbiana es a la vez local e incremental. Para las redes Hopfield, se implementa de la siguiente manera al aprender patrones binarios:

donde representa el bit i del patrón .

Si los bits correspondientes a las neuronas i y j tienen el mismo patrón , entonces el producto será positivo. Esto, a su vez, tendría un efecto positivo sobre el peso y los valores de i y j tenderán a igualarse. Sucede lo contrario si los bits correspondientes a las neuronas i y j son diferentes.

Esta regla fue introducida por Amos Storkey en 1997 y es tanto local como incremental. Storkey también demostró que una red de Hopfield entrenada con esta regla tiene una mayor capacidad que una red correspondiente entrenada con la regla de Hebbian. [24] Se dice que la matriz de pesos de una red neuronal atractora [ se necesita aclaración ] sigue la regla de aprendizaje de Storkey si obedece:

donde es una forma de campo local [22] en la neurona i.

Esta regla de aprendizaje es local, ya que las sinapsis sólo tienen en cuenta las neuronas que se encuentran a sus lados. La regla utiliza más información de los patrones y pesos que la regla hebbiana generalizada, debido al efecto del campo local.

Los patrones que la red utiliza para el entrenamiento (llamados estados de recuperación ) se convierten en atractores del sistema. Las actualizaciones repetidas eventualmente conducirían a la convergencia a uno de los estados de recuperación. Sin embargo, a veces la red convergerá en patrones espurios (diferentes de los patrones de entrenamiento). [25] La energía en estos patrones espurios también es un mínimo local. Para cada patrón x almacenado, la negación -x también es un patrón espurio.

Un estado espurio también puede ser una combinación lineal de un número impar de estados de recuperación. Por ejemplo, cuando se utilizan 3 patrones , se puede obtener el siguiente estado espurio:

Los patrones espurios que tienen un número par de estados no pueden existir, ya que podrían sumar cero [25]

La capacidad de la red del modelo de red Hopfield está determinada por la cantidad de neuronas y las conexiones dentro de una red determinada. Por tanto, la cantidad de recuerdos que se pueden almacenar depende de las neuronas y las conexiones. Además, se demostró que la precisión de recuperación entre vectores y nodos era de 0,138 (aproximadamente 138 vectores se pueden recuperar del almacenamiento por cada 1000 nodos) (Hertz et al., 1991). Por lo tanto, es evidente que se producirán muchos errores si se intenta almacenar una gran cantidad de vectores. Cuando el modelo de Hopfield no recuerda el patrón correcto, es posible que se haya producido una intrusión, ya que los elementos relacionados semánticamente tienden a confundir al individuo y se produce el recuerdo del patrón incorrecto. Por lo tanto, se ha demostrado que el modelo de red de Hopfield confunde un elemento almacenado con el de otro al recuperarlo. Se pueden cargar en la red recuperaciones perfectas y alta capacidad, >0,14, mediante el método de aprendizaje Storkey; ETAM, [26] [27] Experimentos ETAM también en. [28] Posteriormente se idearon modelos posteriores inspirados en la red Hopfield para aumentar el límite de almacenamiento y reducir la tasa de error de recuperación, y algunos eran capaces de aprender de una sola vez . [29]

La capacidad de almacenamiento se puede dar como dónde está el número de neuronas en la red.

El modelo de Hopfield explica la memoria asociativa mediante la incorporación de vectores de memoria. Los vectores de memoria se pueden utilizar ligeramente, lo que provocaría la recuperación del vector más similar en la red. Sin embargo, descubriremos que debido a este proceso pueden producirse intrusiones. En la memoria asociativa de la red Hopfield, existen dos tipos de operaciones: autoasociación y heteroasociación. El primero es cuando un vector está asociado consigo mismo y el segundo cuando dos vectores diferentes están asociados en el almacenamiento. Además, ambos tipos de operaciones son posibles de almacenar dentro de una única matriz de memoria, pero sólo si esa matriz de representación dada no es una u otra de las operaciones, sino más bien la combinación (autoasociativa y heteroasociativa) de las dos.

El modelo de red de Hopfield utiliza la misma regla de aprendizaje que la regla de aprendizaje de Hebb (1949) , que caracterizaba el aprendizaje como resultado del fortalecimiento de los pesos en casos de actividad neuronal.

Rizzuto y Kahana (2001) pudieron demostrar que el modelo de red neuronal puede tener en cuenta la repetición en la precisión del recuerdo incorporando un algoritmo de aprendizaje probabilístico. Durante el proceso de recuperación no se produce ningún aprendizaje. Como resultado, los pesos de la red permanecen fijos, lo que demuestra que el modelo puede pasar de una etapa de aprendizaje a una etapa de recuperación. Al agregar una deriva contextual, pudieron mostrar el rápido olvido que ocurre en un modelo de Hopfield durante una tarea de recuerdo con señales. Toda la red contribuye al cambio en la activación de cualquier nodo.

La regla dinámica de McCulloch y Pitts (1943), que describe el comportamiento de las neuronas, lo hace de una manera que muestra cómo las activaciones de múltiples neuronas se corresponden con la activación de la velocidad de activación de una nueva neurona, y cómo los pesos de las neuronas fortalecen la velocidad de activación de una nueva neurona. conexiones sinápticas entre la nueva neurona activada (y las que la activaron). Hopfield usaría la regla dinámica de McCulloch-Pitts para mostrar cómo es posible la recuperación en la red de Hopfield. Sin embargo, Hopfield lo haría de forma repetitiva. Hopfield usaría una función de activación no lineal, en lugar de una función lineal. Por lo tanto, esto crearía la regla dinámica de Hopfield y con esto, Hopfield pudo demostrar que con la función de activación no lineal, la regla dinámica siempre modificará los valores del vector de estado en la dirección de uno de los patrones almacenados.

Las redes de Hopfield [7] [8] son redes neuronales recurrentes con trayectorias dinámicas que convergen a estados de atractor de punto fijo y se describen mediante una función de energía. El estado de cada neurona modelo está definido por una variable dependiente del tiempo , que puede elegirse como discreta o continua. Un modelo completo describe las matemáticas de cómo el estado futuro de actividad de cada neurona depende de la actividad presente o anterior conocida de todas las neuronas.

En el modelo original de memoria asociativa de Hopfield, [7] las variables eran binarias y la dinámica se describía mediante una actualización del estado de las neuronas una a la vez. Se definió una función energética cuadrática y la dinámica consistía en cambiar la actividad de cada neurona solo si al hacerlo se reducía la energía total del sistema. Esta misma idea se extendió al caso de ser una variable continua que representa la salida de una neurona y ser una función monótona de una corriente de entrada. La dinámica quedó expresada como un conjunto de ecuaciones diferenciales de primer orden para las cuales la "energía" del sistema siempre disminuía. [8] La energía en el caso continuo tiene un término que es cuadrático en (como en el modelo binario) y un segundo término que depende de la función de ganancia (función de activación de la neurona). Si bien tienen muchas propiedades deseables de la memoria asociativa, ambos sistemas clásicos adolecen de una pequeña capacidad de almacenamiento de memoria, que aumenta linealmente con el número de características de entrada. [7] Por el contrario, al aumentar el número de parámetros en el modelo de modo que no haya solo interacciones por pares sino también de orden superior entre las neuronas, se puede aumentar la capacidad de almacenamiento de memoria. [30] [31]

Las memorias asociativas densas [12] (también conocidas como redes de Hopfield modernas [14] ) son generalizaciones de las redes de Hopfield clásicas que rompen la relación de escala lineal entre el número de características de entrada y el número de recuerdos almacenados. Esto se logra mediante la introducción de no linealidades más fuertes (ya sea en la función de energía o en las funciones de activación de las neuronas) que conducen a una capacidad de almacenamiento de memoria superlineal [12] (incluso exponencial [13] ) en función del número de neuronas características. de hecho, aumenta el orden de las interacciones entre las neuronas. [30] [31] La red todavía requiere un número suficiente de neuronas ocultas. [15]

La idea teórica clave detrás de las redes densas de memoria asociativa es utilizar una función de energía y una regla de actualización que tiene un pico más agudo alrededor de los recuerdos almacenados en el espacio de las configuraciones de las neuronas en comparación con el modelo clásico, [12] como se demostró cuando el orden superior Las interacciones y los paisajes energéticos posteriores se modelan explícitamente. [31]

Un ejemplo simple [12] de la red Hopfield moderna se puede escribir en términos de variables binarias que representan el estado activo e inactivo de la neurona modelo . En esta fórmula, los pesos representan la matriz de vectores de memoria (el índice enumera diferentes recuerdos y el índice enumera el contenido de cada memoria correspondiente a la -ésima neurona característica), y la función es una función no lineal de rápido crecimiento. La regla de actualización para neuronas individuales (en el caso asíncrono) se puede escribir de la siguiente forma, que establece que para calcular el estado actualizado de la -ésima neurona, la red compara dos energías: la energía de la red con la -ésima neurona en el estado ON y la energía de la red con la -ésima neurona en el estado OFF, dados los estados de la neurona restante. El estado actualizado de la -ésima neurona selecciona el estado que tiene la más baja de las dos energías. [12]

En el caso límite cuando la función de energía no lineal es cuadrática, estas ecuaciones se reducen a la función de energía familiar y la regla de actualización para la red de Hopfield binaria clásica. [7]

La capacidad de almacenamiento de memoria de estas redes se puede calcular para patrones binarios aleatorios. Para la función de energía de potencia, el número máximo de recuerdos que se pueden almacenar y recuperar de esta red sin errores viene dado por [12] Para una función de energía exponencial, la capacidad de almacenamiento de memoria es exponencial en el número de neuronas características [13]

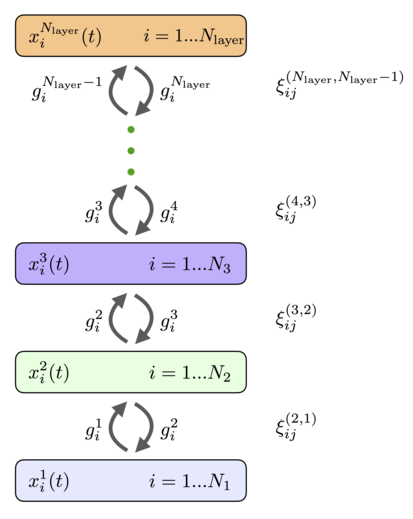

Las redes Hopfield modernas o las memorias asociativas densas se pueden entender mejor en variables continuas y en tiempo continuo. [14] [15] Considere la arquitectura de la red, que se muestra en la Fig.1, y las ecuaciones para la evolución de los estados de las neuronas [15]

donde las corrientes de las neuronas características se indican con y las corrientes de las neuronas de la memoria se indican con ( significa neuronas ocultas). No existen conexiones sinápticas entre las neuronas características o las neuronas de la memoria. Una matriz denota la fuerza de las sinapsis desde una neurona característica hasta la neurona de la memoria . Se supone que las sinapsis son simétricas, de modo que el mismo valor caracteriza una sinapsis física diferente desde la neurona de la memoria hasta la neurona característica . Las salidas de las neuronas de la memoria y las neuronas características se indican con y , que son funciones no lineales de las corrientes correspondientes. En general, estas salidas pueden depender de las corrientes de todas las neuronas de esa capa, de modo que y . Es conveniente definir estas funciones de activación como derivadas de las funciones lagrangianas para los dos grupos de neuronas.

De esta manera la forma específica de las ecuaciones para los estados de las neuronas queda completamente definida una vez especificadas las funciones lagrangianas. Finalmente, las constantes de tiempo para los dos grupos de neuronas se denotan por y , es la corriente de entrada a la red que puede ser impulsada por los datos presentados.

Los sistemas generales de ecuaciones diferenciales no lineales pueden tener muchos comportamientos complicados que pueden depender de la elección de las no linealidades y las condiciones iniciales. Para Hopfield Networks, sin embargo, este no es el caso: las trayectorias dinámicas siempre convergen a un estado de atractor de punto fijo. Esta propiedad se logra porque estas ecuaciones están diseñadas específicamente para que tengan una función de energía subyacente [15]

Los términos agrupados entre corchetes representan una transformada de Legendre de la función lagrangiana con respecto a los estados de las neuronas. Si las matrices de Hesse de las funciones lagrangianas son semidefinidas positivas, se garantiza que la función de energía disminuirá en la trayectoria dinámica [15]

Esta propiedad permite demostrar que el sistema de ecuaciones dinámicas que describe la evolución temporal de la actividad de las neuronas eventualmente alcanzará un estado de atractor de punto fijo.

En determinadas situaciones, se puede suponer que la dinámica de las neuronas ocultas se equilibra en una escala de tiempo mucho más rápida en comparación con las neuronas características . En este caso, la solución en estado estacionario de la segunda ecuación del sistema ( 1 ) se puede utilizar para expresar las corrientes de las unidades ocultas a través de las salidas de las neuronas características. Esto hace posible reducir la teoría general ( 1 ) a una teoría eficaz únicamente para las neuronas características. Las reglas de actualización efectivas resultantes y las energías para varias elecciones comunes de las funciones lagrangianas se muestran en la Fig.2. En el caso de la función lagrangiana exponencial de suma logarítmica, la regla de actualización (si se aplica una vez) para los estados de las neuronas características es el mecanismo de atención [14] comúnmente utilizado en muchos sistemas de IA modernos (ver Ref. [15] para la derivación de este resultado de la formulación de tiempo continuo).

La formulación clásica de redes Hopfield continuas [8] puede entenderse [15] como un caso límite especial de las redes Hopfield modernas con una capa oculta. Las redes de Hopfield continuas para neuronas con respuesta gradual se describen típicamente [8] mediante las ecuaciones dinámicas

y la función de energía

donde , y es la inversa de la función de activación . Este modelo es un límite especial de la clase de modelos que se denomina modelos A, [15] con la siguiente elección de las funciones lagrangianas

que, según la definición ( 2 ), conduce a las funciones de activación

Si integramos las neuronas ocultas, el sistema de ecuaciones ( 1 ) se reduce a las ecuaciones de las neuronas características ( 5 ) con , y la expresión general para la energía ( 3 ) se reduce a la energía efectiva.

Si bien los dos primeros términos de la ecuación ( 6 ) son iguales a los de la ecuación ( 9 ), los terceros términos parecen superficialmente diferentes. En la ecuación ( 9 ) es una transformada de Legendre del Lagrangiano para las neuronas características, mientras que en ( 6 ) el tercer término es una integral de la función de activación inversa. Sin embargo, estas dos expresiones son equivalentes, ya que las derivadas de una función y su transformada de Legendre son funciones inversas entre sí. La forma más sencilla de ver que estos dos términos son iguales explícitamente es diferenciar cada uno con respecto a . Los resultados de estas diferenciaciones para ambas expresiones son iguales a . Por tanto, las dos expresiones son iguales hasta una constante aditiva. Esto completa la prueba [15] de que la red Hopfield clásica con estados continuos [8] es un caso límite especial de la red Hopfield moderna ( 1 ) con energía ( 3 ).

Las redes neuronales biológicas tienen un alto grado de heterogeneidad en términos de diferentes tipos de células. Esta sección describe un modelo matemático de una red Hopfield moderna totalmente conectada asumiendo el grado extremo de heterogeneidad: cada neurona es diferente. [32] Específicamente, se describe una función de energía y las ecuaciones dinámicas correspondientes suponiendo que cada neurona tiene su propia función de activación y escala de tiempo cinética. Se supone que la red está completamente conectada, de modo que cada neurona está conectada a todas las demás mediante una matriz simétrica de pesos , índices y enumera diferentes neuronas en la red, consulte la figura 3. La forma más sencilla de formular matemáticamente este problema es definir la arquitectura mediante una función lagrangiana que depende de las actividades de todas las neuronas de la red. La función de activación de cada neurona se define como una derivada parcial del lagrangiano con respecto a la actividad de esa neurona.

Desde la perspectiva biológica, se puede considerar como una salida axonal de la neurona . En el caso más simple, cuando el lagrangiano es aditivo para diferentes neuronas, esta definición da como resultado una activación que es una función no lineal de la actividad de esa neurona. Para los lagrangianos no aditivos, esta función de activación puede depender de las actividades de un grupo de neuronas. Por ejemplo, puede contener normalización contrastiva (softmax) o divisiva. Las ecuaciones dinámicas que describen la evolución temporal de una neurona determinada vienen dadas por [32]

Esta ecuación pertenece a la clase de modelos llamados modelos de tasa de disparo en neurociencia. Cada neurona recoge las salidas axonales de todas las neuronas, las pondera con los coeficientes sinápticos y produce su propia actividad dependiente del tiempo . La evolución temporal tiene una constante de tiempo , que por lo general puede ser diferente para cada neurona. Esta red tiene una función energética global [32]

donde los dos primeros términos representan la transformada de Legendre de la función lagrangiana con respecto a las corrientes de las neuronas . La derivada temporal de esta función de energía se puede calcular en las trayectorias dinámicas que conducen a (ver [32] para más detalles)

El último signo de desigualdad se cumple siempre que la matriz (o su parte simétrica) sea semidefinida positiva. Si, además de esto, la función de energía está acotada desde abajo, se garantiza que las ecuaciones dinámicas no lineales convergerán a un estado de atractor de punto fijo. La ventaja de formular esta red en términos de funciones lagrangianas es que permite experimentar fácilmente con diferentes opciones de funciones de activación y diferentes disposiciones arquitectónicas de las neuronas. Para todas esas elecciones flexibles, las condiciones de convergencia están determinadas por las propiedades de la matriz y la existencia del límite inferior de la función de energía.

Las neuronas se pueden organizar en capas de modo que cada neurona de una capa determinada tenga la misma función de activación y la misma escala de tiempo dinámica. Si asumimos que no hay conexiones horizontales entre las neuronas dentro de la capa (conexiones laterales) y no hay conexiones de capa de salto, la red general completamente conectada ( 11 ), ( 12 ) se reduce a la arquitectura que se muestra en la Fig.4. Tiene capas de neuronas conectadas de forma recurrente con los estados descritos por variables continuas y las funciones de activación , el índice enumera las capas de la red y el índice enumera las neuronas individuales en esa capa. Las funciones de activación pueden depender de las actividades de todas las neuronas de la capa. Cada capa puede tener un número diferente de neuronas . Estas neuronas están conectadas de forma recurrente con las neuronas de las capas anterior y posterior. Las matrices de pesos que conectan neuronas en capas y se denotan por (el orden de los índices superiores para los pesos es el mismo que el orden de los índices inferiores, en el ejemplo anterior esto significa que el índice enumera las neuronas en la capa y el índice enumera neuronas en la capa ). Los pesos de avance y los pesos de retroalimentación son iguales. Las ecuaciones dinámicas para los estados de las neuronas se pueden escribir como [32]

con condiciones de contorno

La principal diferencia entre estas ecuaciones y las de las redes de retroalimentación convencionales es la presencia del segundo término, que es responsable de la retroalimentación de las capas superiores. Estas señales de arriba hacia abajo ayudan a las neuronas de las capas inferiores a decidir su respuesta a los estímulos presentados. Siguiendo la receta general es conveniente introducir una función lagrangiana para la -ésima capa oculta, que depende de las actividades de todas las neuronas de esa capa. [32] Las funciones de activación en esa capa se pueden definir como derivadas parciales del lagrangiano

Con estas definiciones la función de energía (Lyapunov) viene dada por [32]

Si las funciones lagrangianas, o equivalentemente las funciones de activación, se eligen de tal manera que las hessianas para cada capa sean semidefinidas positivas y la energía general esté limitada desde abajo, se garantiza que este sistema convergerá a un estado de atractor de punto fijo. La derivada temporal de esta función de energía viene dada por [32]

Por lo tanto, la red jerárquica en capas es de hecho una red atractora con la función de energía global. Esta red se describe mediante un conjunto jerárquico de pesos sinápticos que se pueden aprender para cada problema específico.

Esta prueba de convergencia depende crucialmente del hecho de que las conexiones de la red Hopfield sean simétricas . También depende de que las actualizaciones se realicen de forma asincrónica.