En estadística , el máximo de muestra y el mínimo de muestra, también llamados observación más grande y observación más pequeña, son los valores de los elementos mayor y menor de una muestra . [1] Son estadísticas de resumen básicas , utilizadas en estadísticas descriptivas como el resumen de cinco números y el resumen de siete cifras de Bowley y el diagrama de caja asociado .

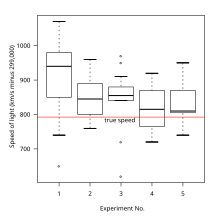

El valor mínimo y máximo son las estadísticas de primer y último orden (a menudo denominadas X (1) y X ( n ) respectivamente, para un tamaño de muestra de n ).

Si la muestra tiene valores atípicos , estos necesariamente incluyen el máximo o el mínimo de la muestra, o ambos, dependiendo de si son extremadamente altos o bajos. Sin embargo, el máximo y el mínimo de la muestra no necesariamente deben ser valores atípicos, si no están inusualmente alejados de otras observaciones.

El máximo y el mínimo de la muestra son las estadísticas menos robustas : son máximamente sensibles a los valores atípicos.

Esto puede ser una ventaja o una desventaja: si los valores extremos son reales (no errores de medición) y de consecuencias reales, como en aplicaciones de la teoría de valores extremos como la construcción de diques o pérdidas financieras, entonces los valores atípicos (como se refleja en los extremos de la muestra) son importantes. Por otro lado, si los valores atípicos tienen poco o ningún impacto en los resultados reales, entonces el uso de estadísticas no robustas como los extremos de la muestra simplemente oscurece las estadísticas y se deben usar alternativas robustas, como otros cuantiles : los percentiles 10 y 90 (primer y último decil ) son alternativas más robustas.

Además de ser un componente de cada estadística que utiliza todos los elementos de la muestra, los extremos de la muestra son partes importantes del rango , una medida de dispersión, y del rango medio , una medida de ubicación. También representan la desviación absoluta máxima : una de ellas es el punto más alejado de cualquier punto dado, en particular una medida de centro como la mediana o la media.

Para un conjunto de muestras, la función máxima no es uniforme y, por lo tanto, no es diferenciable. Para los problemas de optimización que se presentan en estadística, a menudo es necesario aproximarla mediante una función uniforme que esté cerca del máximo del conjunto.

Un máximo suave , por ejemplo,

es una buena aproximación del máximo de la muestra.

El máximo y el mínimo de la muestra son estadísticas de resumen básicas que muestran las observaciones más extremas y se utilizan en el resumen de cinco números y en una versión del resumen de siete números y el diagrama de caja asociado .

El máximo y el mínimo de la muestra proporcionan un intervalo de predicción no paramétrico : en una muestra de una población, o más generalmente una secuencia intercambiable de variables aleatorias, cada observación tiene la misma probabilidad de ser el máximo o el mínimo.

Por lo tanto, si uno tiene una muestra y elige otra observación , entonces esta tiene probabilidad de ser el valor más grande visto hasta ahora, probabilidad de ser el valor más pequeño visto hasta ahora, y por lo tanto la otra del tiempo, cae entre el máximo de la muestra y el mínimo de la muestra de Por lo tanto, denotando el máximo y mínimo de la muestra por M y m, esto produce un intervalo de predicción de [ m , M ].

Por ejemplo, si n = 19, entonces [ m , M ] da un intervalo de predicción de 18/20 = 90 % – el 90 % de las veces, la observación número 20 cae entre la observación más pequeña y la más grande observadas hasta ahora. De la misma manera, n = 39 da un intervalo de predicción del 95 %, y n = 199 da un intervalo de predicción del 99 %.

Debido a su sensibilidad a los valores atípicos, los extremos de la muestra no se pueden usar de manera confiable como estimadores a menos que los datos estén limpios; las alternativas robustas incluyen el primer y el último decil .

Sin embargo, con datos limpios o en entornos teóricos, a veces pueden resultar muy buenos estimadores, en particular para distribuciones platicúrticas , donde para conjuntos de datos pequeños el rango medio es el estimador más eficiente .

Sin embargo , son estimadores ineficientes de la ubicación para distribuciones mesocúrticas, como la distribución normal y las distribuciones leptocúrticas.

Para el muestreo sin reemplazo de una distribución uniforme con uno o dos puntos finales desconocidos (es decir, con N desconocido, o con M y N desconocidos), el máximo de la muestra, o respectivamente el máximo de la muestra y el mínimo de la muestra, son estadísticas suficientes y completas para los puntos finales desconocidos; por lo tanto, un estimador insesgado derivado de estos será el estimador UMVU .

Si solo se desconoce el punto final superior, el máximo de la muestra es un estimador sesgado para el máximo de la población, pero el estimador insesgado (donde m es el máximo de la muestra y k es el tamaño de la muestra) es el estimador UMVU; consulte el problema del tanque alemán para obtener más detalles.

Si ambos puntos finales son desconocidos, entonces el rango de muestra es un estimador sesgado para el rango de población, pero al corregir como para el máximo mencionado anteriormente se obtiene el estimador UMVU.

Si ambos puntos finales son desconocidos, entonces el rango medio es un estimador imparcial (y por lo tanto UMVU) del punto medio del intervalo (aquí, equivalentemente, la mediana, el promedio o el rango medio de la población).

La razón por la que los extremos de la muestra son estadísticas suficientes es que la distribución condicional de las muestras no extremas es simplemente la distribución para el intervalo uniforme entre el máximo y el mínimo de la muestra; una vez que se fijan los puntos finales, los valores de los puntos interiores no agregan información adicional.

Los extremos de la muestra se pueden utilizar para una prueba de normalidad simple , específicamente de curtosis: se calcula la estadística t del máximo y mínimo de la muestra (se resta la media de la muestra y se divide por la desviación estándar de la muestra ), y si son inusualmente grandes para el tamaño de la muestra (según la regla de tres sigma y la tabla incluida allí, o más precisamente una distribución t de Student ), entonces la curtosis de la distribución de la muestra se desvía significativamente de la de la distribución normal.

Por ejemplo, un proceso diario debería esperar un evento 3σ una vez al año (de días calendario; una vez cada año y medio de días hábiles), mientras que un evento 4σ ocurre en promedio cada 40 años de días calendario, 60 años de días hábiles (una vez en la vida), eventos 5σ ocurren cada 5000 años (una vez en la historia registrada) y eventos 6σ ocurren cada 1,5 millones de años (esencialmente nunca). Por lo tanto, si los extremos de la muestra están a 6 sigmas de la media, se tiene una falla significativa de normalidad.

Además, esta prueba es muy fácil de comunicar sin necesidad de utilizar estadísticas complejas.

Estas pruebas de normalidad se pueden aplicar si uno enfrenta un riesgo de curtosis , por ejemplo.

Los extremos de muestra desempeñan dos papeles principales en la teoría de valores extremos :

Sin embargo, se debe tener cuidado al utilizar los extremos de muestra como pautas: en distribuciones de cola pesada o en procesos no estacionarios , los eventos extremos pueden ser significativamente más extremos que cualquier evento observado previamente. Esto se explica en detalle en la teoría del cisne negro .