El gigabyte ( / ˈ ɡ ɪ ɡ ə b aɪ t , ˈ dʒ ɪ ɡ ə b aɪ t / ) [ 1] es un múltiplo de la unidad byte para información digital. El prefijo giga significa 10 9 en el Sistema Internacional de Unidades (SI). Por lo tanto, un gigabyte son mil millones de bytes. El símbolo de unidad para el gigabyte es GB .

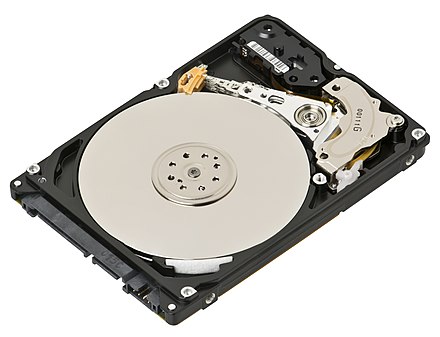

Esta definición se utiliza en todos los contextos de la ciencia (especialmente la ciencia de datos ), la ingeniería , los negocios y muchas áreas de la informática , incluidas las capacidades de almacenamiento de los discos duros , las unidades de estado sólido y las cintas , así como las velocidades de transmisión de datos . El término también se utiliza en algunos campos de la informática y la tecnología de la información para denotar 1 073 741 824 (1024 3 o 2 30 ) bytes, sin embargo, particularmente para tamaños de RAM . Por lo tanto, algunos usos de gigabyte han sido ambiguos. Para resolver esta dificultad, IEC 80000-13 aclara que un gigabyte (GB) es 10 9 bytes y especifica el término gibibyte (GiB) para denotar 2 30 bytes. Estas diferencias aún se ven fácilmente, por ejemplo, cuando Microsoft Windows muestra la capacidad de una unidad de 400 GB como 372 GB en lugar de 372 GiB. De manera análoga, un módulo de memoria etiquetado como de tamaño " 1 GB " tiene un gibibyte ( 1 GiB ) de capacidad de almacenamiento.

En respuesta a un litigio sobre si los fabricantes de dispositivos de almacenamiento electrónico deben ajustarse al uso de Microsoft Windows de una definición binaria de "GB" en lugar de la definición métrica/decimal, el Tribunal de Distrito de los Estados Unidos para el Distrito Norte de California rechazó ese argumento, dictaminando que "el Congreso de los Estados Unidos ha considerado que la definición decimal de gigabyte es la 'preferida' para los fines del 'comercio y comercio de los Estados Unidos ' " . [2] [3]

El término gigabyte tiene una definición estándar de 1000 3 bytes, así como un significado desaconsejado [2] de 1024 3 bytes. El último uso binario se originó como jerga técnica de compromiso para múltiplos de bytes que debían expresarse en una potencia de 2, pero carecían de un nombre conveniente. Como 1024 (2 10 ) es aproximadamente 1000 (10 3 ), que corresponde aproximadamente a múltiplos del SI, también se usó para múltiplos binarios.

En 1998, la Comisión Electrotécnica Internacional (IEC) publicó estándares para prefijos binarios , requiriendo que el gigabyte denote estrictamente 1000 3 bytes y el gibibyte denote 1024 3 bytes. A fines de 2007, el estándar IEC había sido adoptado por el IEEE , la UE y el NIST , y en 2009 se incorporó al Sistema Internacional de Cantidades . Sin embargo, el término gigabyte continúa siendo ampliamente utilizado con los siguientes dos significados diferentes:

Basándose en potencias de 10, esta definición utiliza el prefijo giga- tal como se define en el Sistema Internacional de Unidades (SI). Esta es la definición recomendada por la Comisión Electrotécnica Internacional (IEC). [4] Esta definición se utiliza en contextos de redes y en la mayoría de los medios de almacenamiento , en particular discos duros , almacenamiento basado en flash , [5] [6] y DVD , y también es coherente con los otros usos del prefijo SI en informática, como las velocidades de reloj de la CPU o las medidas de rendimiento . El administrador de archivos de Mac OS X versión 10.6 y versiones posteriores son un ejemplo notable de este uso en el software, que informa los tamaños de los archivos en unidades decimales. [7]

La definición binaria utiliza potencias de la base 2, al igual que el principio arquitectónico de las computadoras binarias . Este uso es ampliamente promulgado por algunos sistemas operativos , como Microsoft Windows en referencia a la memoria de la computadora (por ejemplo, RAM ). Esta definición es sinónima de la unidad inequívoca gibibyte .

Desde la primera unidad de disco, la IBM 350 , los fabricantes de unidades de disco expresaron las capacidades del disco duro utilizando prefijos decimales. Con la llegada de las capacidades de las unidades en el rango de los gigabytes, los fabricantes etiquetaron muchas capacidades de discos duros de consumo , unidades de estado sólido y unidades flash USB en ciertas clases de tamaño expresadas en gigabytes decimales, como "500 GB". La capacidad exacta de un modelo de unidad determinado suele ser ligeramente mayor que la designación de clase. Prácticamente todos los fabricantes de unidades de disco duro y dispositivos de disco de memoria flash [5] [6] siguen definiendo un gigabyte como 1 000 000 000 bytes , que se muestra en el paquete. Algunos sistemas operativos como Mac OS X [8] y Ubuntu [9] y Debian [ 10] expresan la capacidad del disco duro o el tamaño del archivo utilizando multiplicadores decimales, mientras que otros como Microsoft Windows informan el tamaño utilizando multiplicadores binarios. Esta discrepancia genera confusión, ya que un disco con una capacidad anunciada de, por ejemplo, 400 GB (es decir, 400 000 000 000 bytes , equivalentes a 372 GiB) podría ser informado por el sistema operativo como " 372 GB ".

Para la RAM , los estándares de memoria JEDEC utilizan la nomenclatura IEEE 100 , que indica que el gigabyte equivale a 1 073 741 824 bytes (2 30 bytes). [11]

La diferencia entre las unidades basadas en prefijos decimales y binarios aumenta como una función semilogarítmica (logaritmo lineal); por ejemplo, el valor decimal de un kilobyte es casi el 98 % del valor de un kibibyte, un megabyte es menos del 96 % del valor de un mebibyte y un gigabyte es un poco más del 93 % del valor de un gibibyte. Esto significa que un disco duro de 300 GB (279 GiB) puede indicarse de diversas formas como "300 GB", "279 GB" o "279 GiB", según el sistema operativo. A medida que aumentan los tamaños de almacenamiento y se utilizan unidades más grandes, estas diferencias se vuelven más pronunciadas.

En 2019, una demanda judicial que surgió a raíz de un supuesto incumplimiento de contrato y otras reclamaciones sobre las definiciones binarias y decimales utilizadas para "gigabyte" terminó a favor de los fabricantes, y los tribunales dictaminaron que la definición legal de gigabyte o GB es 1 GB = 1 000 000 000 (10 9 ) bytes (la definición decimal). En concreto, los tribunales dictaminaron que "el Congreso de los Estados Unidos ha considerado que la definición decimal de gigabyte es la 'preferida' a los efectos del 'comercio y comercio de los Estados Unidos' ... La Legislatura de California también ha adoptado el sistema decimal para todas las 'transacciones en este estado'". [2]

Demandas anteriores habían terminado en un acuerdo sin que el tribunal se pronunciara sobre la cuestión, como una demanda contra el fabricante de unidades Western Digital . [12] [13] Western Digital resolvió el desafío y agregó exenciones de responsabilidad explícitas a los productos de que la capacidad utilizable puede diferir de la capacidad publicitada. [12] Seagate fue demandada por motivos similares y también llegó a un acuerdo. [12] [14]

Debido a su diseño físico, la capacidad de los dispositivos de memoria de acceso aleatorio de las computadoras modernas, como los módulos DIMM , es siempre un múltiplo de una potencia de 1024. Por lo tanto, es conveniente utilizar prefijos que denotan potencias de 1024, conocidos como prefijos binarios , para describirlos. Por ejemplo, una capacidad de memoria de 1 073 741 824 bytes (1024 3 B) se expresa convenientemente como 1 GiB en lugar de 1,074 GB. Sin embargo, la primera especificación se cita a menudo como "1 GB" cuando se aplica a la memoria de acceso aleatorio. [15]

El software asigna memoria en distintos grados de granularidad según sea necesario para cumplir con los requisitos de la estructura de datos y, por lo general, no se requieren múltiplos binarios. Otras capacidades y velocidades de la computadora, como el tamaño del hardware de almacenamiento , las velocidades de transferencia de datos , las velocidades de reloj , las operaciones por segundo , etc., no dependen de una base inherente y, por lo general, se presentan en unidades decimales. Por ejemplo, el fabricante de un disco duro de "300 GB" afirma una capacidad de 300 000 000 000 bytes , no 300 × 1024 3 (que serían 322 122 547 200 ) bytes.

El símbolo "gigabyte" está codificado por Unicode en el punto de código U+3387 ㎇ SQUARE GB . [16]