El método grupal de manejo de datos ( GMDH ) es una familia de algoritmos inductivos para el modelado matemático basado en computadora de conjuntos de datos multiparamétricos que incluye optimización estructural y paramétrica completamente automática de los modelos.

GMDH se utiliza en campos como la minería de datos , el descubrimiento de conocimiento , la predicción , el modelado de sistemas complejos , la optimización y el reconocimiento de patrones . [1] Los algoritmos GMDH se caracterizan por un procedimiento inductivo que realiza la clasificación de modelos polinomiales gradualmente complicados y selecciona la mejor solución por medio del criterio externo . La última sección de [2] contiene un resumen de las aplicaciones de GMDH en la década de 1970.

Otros nombres incluyen "red neuronal de propagación progresiva polinómica" [3] o "autoorganización de modelos". Fue uno de los primeros métodos de aprendizaje profundo , utilizado para entrenar una red neuronal de ocho capas en 1971. [4] [5]

Esta sección se basa en. [2]

Este es el problema general del modelado estadístico de datos: considere un conjunto de datos con puntos. Cada punto contiene observaciones y un objetivo a predecir. ¿Cuál es la mejor manera de predecir el objetivo en función de las observaciones?

En primer lugar, dividimos el conjunto de datos completo en dos partes: un conjunto de entrenamiento y un conjunto de validación. El conjunto de entrenamiento se utilizaría para ajustar cada vez más parámetros del modelo, y el conjunto de validación se utilizaría para decidir qué parámetros incluir y cuándo dejar de ajustar por completo.

El GMDH comienza considerando polinomios de grado 2 en 2 variables. Supongamos que queremos predecir el objetivo utilizando solo las partes de la observación y utilizando solo polinomios de grado 2, entonces lo máximo que podemos hacer es esto: donde los parámetros se calculan mediante regresión lineal . Ahora, los parámetros dependen de lo que hayamos elegido, y no sabemos cuál deberíamos elegir, por lo que los elegimos todos. Es decir, realizamos todas esas regresiones polinómicas: obteniendo modelos polinómicos del conjunto de datos.

No queremos aceptar todos los modelos polinómicos, ya que contendría demasiados modelos. Para seleccionar solo el mejor subconjunto de estos modelos, ejecutamos cada modelo en el conjunto de datos de validación y seleccionamos los modelos cuyo error cuadrático medio está por debajo de un umbral. También escribimos el error cuadrático medio más pequeño obtenido como .

Supongamos que después de este proceso hemos obtenido un conjunto de modelos. Ahora ejecutamos los modelos en el conjunto de datos de entrenamiento para obtener una secuencia de observaciones transformadas: . Ahora podemos ejecutar nuevamente el mismo algoritmo.

El algoritmo continúa, dándonos . Mientras cada uno sea más pequeño que el anterior, el proceso continúa, dándonos modelos cada vez más profundos. Tan pronto como algunos , el algoritmo termina. La última capa ajustada (capa ) se descarta, ya que se ha ajustado en exceso al conjunto de entrenamiento. Se muestran las capas anteriores.

Existen métodos más sofisticados para decidir cuándo finalizar. Por ejemplo, se podría seguir ejecutando el algoritmo durante varios pasos más, con la esperanza de pasar un aumento temporal de .

En lugar de un polinomio de grado 2 en 2 variables, cada unidad puede utilizar polinomios de grado superior en más variables: [1]

Y de manera más general, un modelo GMDH con múltiples entradas y una salida es un subconjunto de componentes de la función base (1):

donde f i son funciones elementales que dependen de diferentes conjuntos de entradas, a i son coeficientes y m es el número de componentes de la función base.

Los criterios externos son objetivos de optimización del modelo, como minimizar el error cuadrático medio en el conjunto de validación, como se indicó anteriormente. Los criterios más comunes son:

Al igual que la regresión lineal, que ajusta una ecuación lineal sobre los datos, GMDH ajusta órdenes arbitrariamente altos de ecuaciones polinómicas sobre los datos. [6] [7]

Para elegir entre modelos, se utilizan dos o más subconjuntos de una muestra de datos, similar a la división entrenamiento-validación-prueba .

GMDH combinó ideas de: [8] modelado de caja negra , selección genética sucesiva de características por pares , [9] el principio de Gabor de "libertad de elección de decisiones", [10] y el principio de Beer de adiciones externas. [11]

Inspirados por una analogía entre construir un modelo a partir de datos ruidosos y enviar mensajes a través de un canal ruidoso , [12] propusieron un "modelado inmune al ruido": [6] cuanto mayor sea el ruido, menos parámetros debe tener el modelo óptimo, ya que el canal ruidoso no permite enviar más bits.

El modelo está estructurado como una red neuronal feedforward, pero sin restricciones en la profundidad, tenían un procedimiento para la generación automática de estructuras de modelos, que imita el proceso de selección biológica con características genéticas por pares.

El método fue ideado en 1968 por el profesor Alexey G. Ivakhnenko en el Instituto de Cibernética de Kiev .

El período 1968-1971 se caracteriza por la aplicación de un único criterio de regularidad para la solución de los problemas de identificación, reconocimiento de patrones y previsión a corto plazo. Como funciones de referencia se utilizaron polinomios, redes lógicas, conjuntos difusos de Zadeh y fórmulas de probabilidad de Bayes. Los autores se sintieron estimulados por la altísima precisión de las previsiones con el nuevo enfoque. No se investigó la inmunidad al ruido.

Período 1972-1975 . Se resolvió el problema de modelado de datos con ruido y de información incompleta. Se propuso la selección multicriterio y la utilización de información a priori adicional para aumentar la inmunidad al ruido. Los mejores experimentos demostraron que con la definición ampliada del modelo óptimo mediante un criterio adicional, el nivel de ruido puede ser diez veces mayor que la señal. Luego se mejoró utilizando la teoría del Teorema de Shannon de la Comunicación General.

Período 1976-1979 . Se investigó la convergencia de algoritmos GMDH multicapa. Se demostró que algunos algoritmos multicapa tienen un "error de multicapa", análogo al error estático de los sistemas de control. En 1977 se propuso una solución de problemas de análisis de sistemas objetivos mediante algoritmos GMDH multicapa. Resultó que la clasificación por conjunto de criterios encuentra el único sistema óptimo de ecuaciones y, por lo tanto, muestra los elementos de un objeto complejo, sus principales variables de entrada y salida.

Período 1980-1988 . Se obtuvieron muchos resultados teóricos importantes. Se hizo evidente que los modelos físicos completos no se pueden utilizar para la previsión a largo plazo. Se demostró que los modelos no físicos de GMDH son más precisos para la aproximación y la previsión que los modelos físicos de análisis de regresión. Se desarrollaron algoritmos de dos niveles que utilizan dos escalas de tiempo diferentes para el modelado.

Desde 1989 se han desarrollado e investigado nuevos algoritmos (AC, OCC, PF) para el modelado no paramétrico de objetos difusos y SLP para sistemas expertos. [13] La etapa actual del desarrollo de GMDH puede describirse como el florecimiento de las redes neuronales de aprendizaje profundo y los algoritmos inductivos paralelos para computadoras multiprocesador. Dicho procedimiento se utiliza actualmente en redes de aprendizaje profundo . [14]

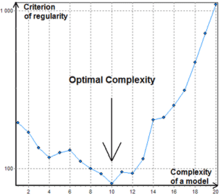

Existen muchas formas diferentes de elegir un orden para la consideración de modelos parciales. El primer orden de consideración utilizado en GMDH y originalmente llamado procedimiento inductivo multicapa es el más popular. Es una clasificación de modelos gradualmente complicados generados a partir de la función base . El mejor modelo está indicado por el mínimo de la característica del criterio externo. El procedimiento multicapa es equivalente a la red neuronal artificial con función de activación polinomial de neuronas. Por lo tanto, el algoritmo con este enfoque generalmente se conoce como red neuronal de tipo GMDH o red neuronal polinomial. Li demostró que la red neuronal de tipo GMDH funcionó mejor que los algoritmos de pronóstico clásicos como Single Exponential Smooth, Double Exponential Smooth, ARIMA y la red neuronal de retropropagación. [15]

Otro enfoque importante para la consideración de modelos parciales que se está volviendo cada vez más popular es una búsqueda combinatoria que puede ser limitada o completa. Este enfoque tiene algunas ventajas frente a las redes neuronales polinómicas, pero requiere una considerable potencia computacional y, por lo tanto, no es eficaz para objetos con una gran cantidad de entradas. Un logro importante de la GMDH combinatoria es que supera por completo el enfoque de regresión lineal si el nivel de ruido en los datos de entrada es mayor que cero. Garantiza que se encontrará el modelo más óptimo durante una clasificación exhaustiva.

El algoritmo combinatorio básico consta de los siguientes pasos:

A diferencia de las redes neuronales de tipo GMDH, el algoritmo combinatorio normalmente no se detiene en un determinado nivel de complejidad porque un punto de aumento del valor del criterio puede ser simplemente un mínimo local, ver Figura 1.