En visión artificial , la cosegmentación de objetos es un caso especial de segmentación de imágenes , que se define como la segmentación conjunta de objetos semánticamente similares en múltiples imágenes o fotogramas de vídeo. [2] [3]

A menudo resulta complicado extraer máscaras de segmentación de un objetivo/objeto de una colección ruidosa de imágenes o fotogramas de vídeo, lo que implica el descubrimiento de objetos junto con la segmentación . Una colección ruidosa implica que el objeto/objetivo está presente esporádicamente en un conjunto de imágenes o que el objeto/objetivo desaparece de forma intermitente a lo largo del vídeo de interés. Los primeros métodos [4] [5] suelen implicar representaciones de nivel medio, como propuestas de objetos .

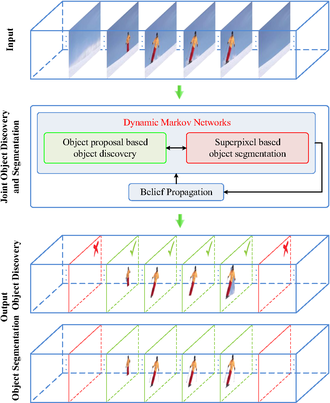

Recientemente se ha propuesto un método conjunto de descubrimiento de objetos y cosegmentación basado en redes de Markov dinámicas acopladas [1] , que promete mejoras significativas en robustez frente a fotogramas de vídeo irrelevantes o ruidosos.

A diferencia de los esfuerzos anteriores que asumen convenientemente la presencia consistente de los objetos objetivo a lo largo del video de entrada, este algoritmo basado en red dinámica dual acoplada de Markov lleva a cabo simultáneamente las tareas de detección y segmentación con dos redes de Markov respectivas actualizadas conjuntamente a través de la propagación de creencias.

En concreto, la red de Markov responsable de la segmentación se inicializa con superpíxeles y proporciona información a su homóloga de Markov responsable de la tarea de detección de objetos. Por el contrario, la red de Markov responsable de la detección construye el gráfico de propuesta de objetos con entradas que incluyen los tubos de segmentación espaciotemporal.

La optimización de cortes de gráficos es una herramienta popular en la visión artificial, especialmente en las primeras aplicaciones de segmentación de imágenes . Como una extensión de los cortes de gráficos regulares, se propone el corte de hipergráficos de múltiples niveles [6] para dar cuenta de correspondencias de orden superior más complejas entre grupos de videos más allá de las correlaciones típicas por pares.

Con esta extensión del hipergrafo, se podrían incorporar sin problemas múltiples modalidades de correspondencias, incluidas la apariencia de bajo nivel, la prominencia, el movimiento coherente y las características de alto nivel, como las regiones de objetos, en el cálculo del hiperarista. Además, como ventaja fundamental sobre el enfoque basado en la coocurrencia , el hipergrafo retiene implícitamente correspondencias más complejas entre sus vértices, y los pesos del hiperarista se calculan convenientemente mediante la descomposición de valores propios de matrices laplacianas .

En las aplicaciones de localización de acciones , la cosegmentación de objetos también se implementa como el detector espacio-temporal de tubo de segmento . [7] Inspirados por los recientes esfuerzos de localización de acciones espacio-temporales con tubos (secuencias de cuadros delimitadores), Le et al. presentan un nuevo detector de localización de acciones espacio-temporales, Segment-tube, que consiste en secuencias de máscaras de segmentación por cuadro. Este detector Segment-tube puede señalar temporalmente el cuadro inicial/final de cada categoría de acción en presencia de acciones de interferencia anteriores/posteriores en videos sin recortar. Simultáneamente, el detector Segment-tube produce máscaras de segmentación por cuadro en lugar de cuadros delimitadores, lo que ofrece una precisión espacial superior a los tubos. Esto se logra alternando la optimización iterativa entre la localización de acciones temporales y la segmentación de acciones espaciales.

El detector de tubo de segmento propuesto se ilustra en el diagrama de flujo de la derecha. La entrada de muestra es un video sin recortar que contiene todos los fotogramas de un video de patinaje artístico en pareja, y solo una parte de estos fotogramas pertenece a una categoría relevante (por ejemplo, DeathSpirals). Inicializado con segmentación de imágenes basada en la prominencia en fotogramas individuales, este método primero realiza el paso de localización de acción temporal con una CNN 3D en cascada y LSTM , y señala el fotograma inicial y el fotograma final de una acción objetivo con una estrategia de grueso a fino. Posteriormente, el detector de tubo de segmento refina la segmentación espacial por fotograma con corte de gráfico centrándose en fotogramas relevantes identificados por el paso de localización de acción temporal. La optimización alterna entre la localización de acción temporal y la segmentación de acción espacial de manera iterativa. Tras la convergencia práctica, los resultados finales de localización de acción espacio-temporal se obtienen en el formato de una secuencia de máscaras de segmentación por fotograma (fila inferior en el diagrama de flujo) con fotogramas iniciales/finales precisos.