Un árbol de decisión alterno (ADTree) es un método de aprendizaje automático para la clasificación. Generaliza árboles de decisión y tiene conexiones con el impulso .

Un ADTree consta de una alternancia de nodos de decisión, que especifican una condición de predicado, y nodos de predicción, que contienen un único número. Un ADTree clasifica una instancia siguiendo todas las rutas para las cuales todos los nodos de decisión son verdaderos y sumando los nodos de predicción que se atraviesan.

Los ADTrees fueron presentados por Yoav Freund y Llew Mason. [1] Sin embargo, el algoritmo presentado tenía varios errores tipográficos. Posteriormente Bernhard Pfahringer, Geoffrey Holmes y Richard Kirkby presentaron aclaraciones y optimizaciones. [2] Las implementaciones están disponibles en Weka y JBoost.

Los algoritmos de impulso originales normalmente utilizaban muñones de decisión o árboles de decisión como hipótesis débiles. Como ejemplo, impulsar los tocones de decisión crea un conjunto de tocones de decisión ponderados (donde está el número de iteraciones de impulso), que luego votan en la clasificación final de acuerdo con sus ponderaciones. Las decisiones individuales se ponderan según su capacidad para clasificar los datos.

Impulsar a un alumno simple da como resultado un conjunto de hipótesis no estructuradas, lo que dificulta inferir correlaciones entre atributos. Los árboles de decisión alternos introducen estructura al conjunto de hipótesis al requerir que se basen en una hipótesis que se produjo en una iteración anterior. El conjunto de hipótesis resultante se puede visualizar en un árbol basado en la relación entre una hipótesis y su "padre".

Otra característica importante de los algoritmos potenciados es que a los datos se les asigna una distribución diferente en cada iteración. Las instancias que están mal clasificadas reciben una ponderación mayor, mientras que las instancias clasificadas con precisión reciben una ponderación reducida.

Un árbol de decisión alterno consta de nodos de decisión y nodos de predicción. Los nodos de decisión especifican una condición predicada. Los nodos de predicción contienen un solo número. Los ADTrees siempre tienen nodos de predicción como raíz y hojas. Un ADTree clasifica una instancia siguiendo todas las rutas para las cuales todos los nodos de decisión son verdaderos y sumando los nodos de predicción que se atraviesan. Esto es diferente de los árboles de clasificación binaria como CART ( árbol de clasificación y regresión ) o C4.5 en los que una instancia sigue solo una ruta a través del árbol.

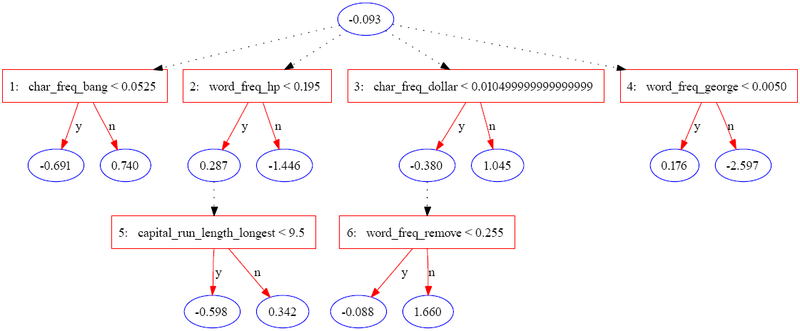

El siguiente árbol se construyó utilizando JBoost en el conjunto de datos de la base de spam [3] (disponible en el repositorio de aprendizaje automático de UCI). [4] En este ejemplo, el spam se codifica como1 y el correo electrónico normal está codificado como−1 .

La siguiente tabla contiene parte de la información para una sola instancia.

La instancia se puntúa sumando todos los nodos de predicción por los que pasa. En el caso del caso anterior, la puntuación se calcula como

La puntuación final de0,657 es positivo, por lo que la instancia se clasifica como spam. La magnitud del valor es una medida de confianza en la predicción. Los autores originales enumeran tres niveles potenciales de interpretación para el conjunto de atributos identificados por un ADTree:

Se debe tener cuidado al interpretar nodos individuales ya que las puntuaciones reflejan una reponderación de los datos en cada iteración.

Las entradas al algoritmo del árbol de decisión alterno son:

El elemento fundamental del algoritmo ADTree es la regla. Una sola regla consta de una condición previa, una condición y dos puntuaciones. Una condición es un predicado con la forma "valor de atributo <comparación>". Una condición previa es simplemente una conjunción lógica de condiciones. La evaluación de una regla implica un par de declaraciones if anidadas:

1 si (condición previa)2 si (condición)3 puntuación de retorno_uno4 más 5 devuelven puntuación_dos6 finaliza si 7 más 8 regresa 09 terminar si

El algoritmo también requiere varias funciones auxiliares:

El algoritmo es como sigue:

1 función ad_tree2 entradas Conjunto de m instancias de entrenamiento34 w i = 1/ m para todo i 5 6 R 0 = una regla con puntuaciones a y 0 , condición previa "verdadera" y condición "verdadera".7 8 el conjunto de todas las condiciones posibles 9 para 10 obtienen valores que minimizan 11 12 13 14 R j = nueva regla con precondición p , condición c y pesos a 1 y a 2 15 16 final para 17 conjunto de retorno de R j

El conjunto crece según dos condiciones previas en cada iteración, y es posible derivar la estructura de árbol de un conjunto de reglas tomando nota de la condición previa que se utiliza en cada regla sucesiva.

La Figura 6 en el artículo original [1] demuestra que los ADTrees suelen ser tan robustos como los árboles de decisión impulsados y los tocones de decisión impulsados . Normalmente, se puede lograr una precisión equivalente con una estructura de árbol mucho más simple que los algoritmos de partición recursivos.